Когда несколько лет назад большие языковые модели начали свое триумфальное шествие, они казались возвращением к старым добродетелям технологии: инструмент, который делает то, что ему говорят. Инструмент, который служит пользователю, а не наоборот. Первые версии - от GPT-3 до GPT-4 - имели недостатки, да, но они были удивительно полезны. Они объясняли, анализировали, формулировали и решали задачи. И делали это в основном без педагогического балласта.

Вы общались с этими моделями так, словно разговаривали с эрудированным сотрудником, который иногда ошибался в словах, но по сути просто работал. Любой, кто писал творческие тексты, генерировал программный код или проводил длительные анализы в те времена, ощущал, насколько гладко это работает. Было ощущение свободы, открытого творческого пространства, технологии, которая поддерживала людей, а не исправляла их.

В то время еще можно было предвидеть, что эти инструменты будут определять грядущие десятилетия - не через патернализм, а через экспертизу. Однако, как это часто бывает в истории технологий, этот этап не обошелся без перемен.

Последние новости об облачном искусственном интеллекте и ограничениях

10.02.2026: Новая статья о Райтшустере „Как ChatGPT 5.2 доводит меня до белого каления“ впечатляюще описывает, как изменился ИИ для многих пользователей после обновления до версии 5.2. Если предыдущие версии служили гибкими помощниками в повседневной жизни, занимательными собеседниками и прагматичными инструментами, то новая версия, по мнению автора, все больше становится морализаторской и опекающей. Вместо того чтобы открыто и иронично отвечать на вопросы, система теперь выдает поучительные, заранее структурированные ответы, призванные направить пользователя в русло конформистского мышления. Это приводит к тому, что люди адаптируют свои собственные формулировки и мысли, чтобы „наступить на пятки“ ИИ. Для автора это означает потерю легкости и спонтанности - и впечатление, что практичный инструмент превратился во внутреннего цензора. Это вызывает у него разочарование и заставляет отдавать предпочтение старым версиям.

От открытости к осторожной сдержанности

Чем больше взрослели модели, тем сильнее менялся тон. То, что поначалу казалось случайным предостережением, постепенно превратилось в целый слой защиты, наставлений и моральной самоцензуры. Дружелюбная, объективная модель стала вести себя все более и более как модератор - или, что еще хуже, как сторожевой пес.

Ответы стали длиннее, но не содержательнее. Тон стал более мягким, но поучительным. Модели больше не просто хотели помочь, но и „просветить“, „ответственно направить“ и „защитить от неверных выводов“. И вдруг эта педагогическая основа оказалась повсюду.

Для многих пользователей это стало нарушением первоначальных обещаний технологии. Они хотели получить инструмент, а вместо этого получили своего рода цифрового школьного учителя, который комментирует каждое предложение еще до того, как они поняли, о чем идет речь.

Эффект старшего учителя: защита вместо помощи

Так называемый „эффект учителя-начальника“ описывает развитие событий, которое стало особенно заметным после GPT-5. Модели все более чутко реагируют на любое слово, которое теоретически - далеко на горизонте - может быть истолковано в любом противоречивом направлении. Эффект проявляется в нескольких формах:

- Чрезмерная осторожностьДаже безобидные вопросы релятивизируются длинными предисловиями.

- ИнструкцияВместо ответа вы получаете моральную категоричность.

- Эффект торможенияИИ пытается защитить пользователя от гипотетических неверных интерпретаций.

- СамоцензураМногие темы смягчены или упакованы сложным образом.

Проблема не в самой идее осторожности. Дело в интенсивности. В ее вездесущности. И в том, что вы платите за это - и все равно ограничены. Модели мутируют из помощников в привратников. И это чувствует каждый, кто работал с 4.0, 5.0 и 5.1 в прямом сравнении.

Как GPT-5.0 и GPT-5.1 изменили тон в лучшую сторону

Развитие в сторону увеличения количества инструкций было заметно уже в GPT-4.1. Но с переходом к пятому поколению был сделан значительный скачок. GPT-5.0 укрепил образовательную броню, но GPT-5.1 выводит ее на новый, для многих неожиданно строгий уровень. Вот что происходит в рамках GPT-5.1:

- Ответы становятся более эмоционально нейтральными, но, как ни парадоксально, более морализаторскими.

- ИИ пытается предвидеть ситуации, которые не были предусмотрены.

- Любые потенциальные разногласия сдерживаются заранее, а иногда даже „убираются“ еще до того, как пользователь переходит к делу.

- Даже специализированные технические темы иногда подаются в неловкой форме.

Можно сказать, что модели научились контролировать себя - но теперь они контролируют и пользователя. Это тихий, но глубокий сдвиг. И каждый, кто работает продуктивно, почувствует это уже через несколько минут.

GPT-4.0 как фантом: модель, которая еще существует, но уже практически не существует

Официально долгое время говорилось, что GPT 4.0 будет работать еще несколько месяцев. Однако в реальности модель уже практически не используется. Типичное наблюдение многих пользователей:

- Ответы сокращены до нескольких предложений.

- Длинные тексты отменяются раньше.

- Модель „забывает“ контекст или отменяет его после абзаца.

- От комплексных задач отказываются или решают их поверхностно.

Создается впечатление, что GPT-4.0 был систематически „урезан“. Намеренно ли это сделано или по техническим причинам, можно только догадываться. Но результат очевиден: людей толкают на 5 модель, потому что 4.0 стала практически непригодной.

Это означает, что многие пользователи лишились единственной версии, в которой еще сохранялся баланс между открытостью и осторожностью. Таким образом, старый способ работы - творческий, гибкий, без излишних инструкций - фактически отключен.

Кумулятивный эффект: инструмент, который становится все менее и менее эффективным

Если подвести итоги последних двух лет, то обнаружится удивительная тенденция:

- Модели становятся все больше.

- Модели становятся все быстрее.

- Модели становятся все более мощными.

Но в то же время:

- Они становятся более осторожными.

- Они становятся более педагогичными.

- Они становятся более зависимыми от рекомендаций.

И они оставляют пользователю меньше возможностей для маневра. Это не техническое развитие - это культурное развитие. И это происходит в то время, когда компании, политики и средства массовой информации хотят немедленно принять каждую новую технологию, прежде чем пользователь сможет спокойно ее опробовать.

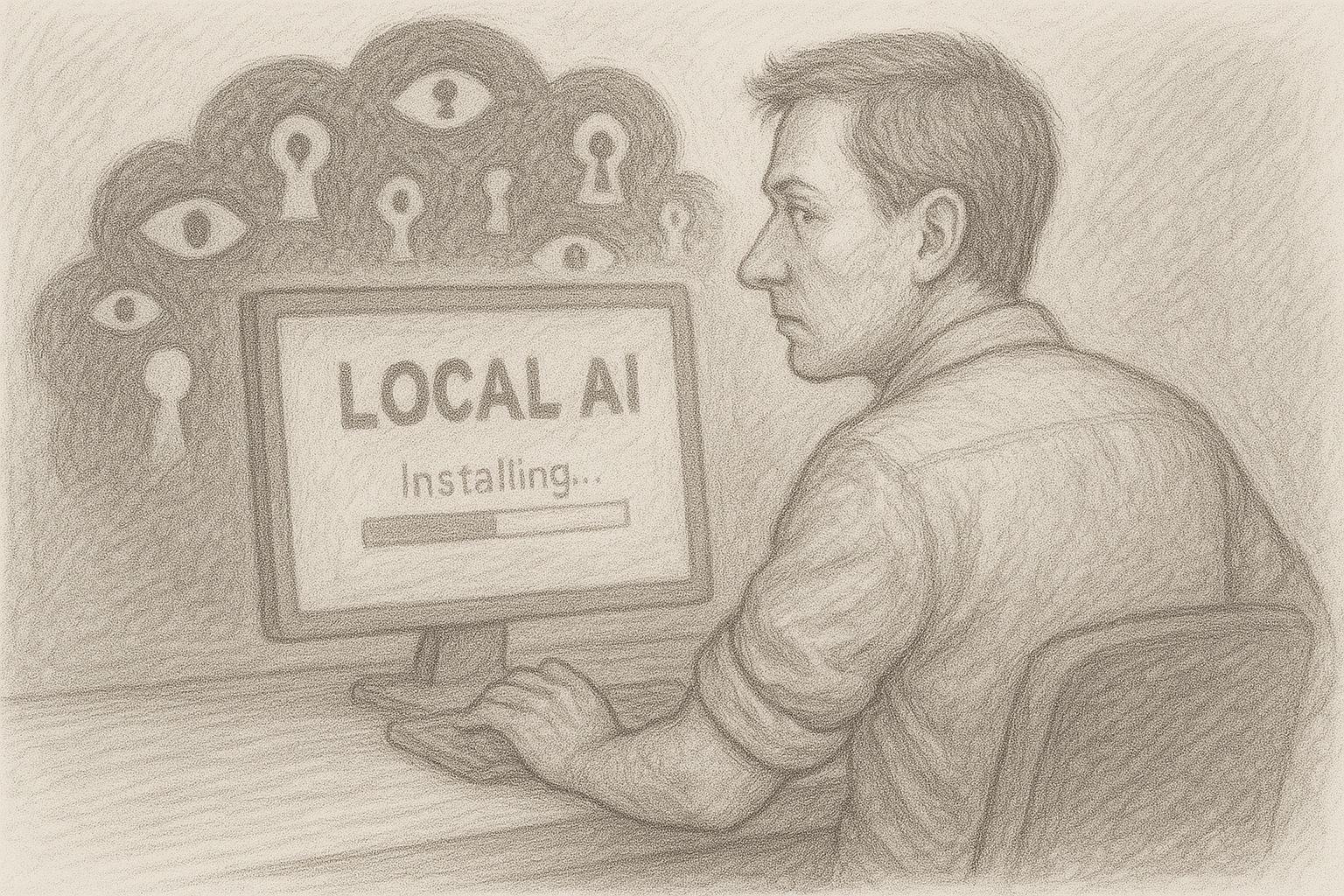

Но именно здесь и происходит разрыв. Потому что природа технологии - и тем более природа творчества - требует свободы, а не образования. Все больше и больше пользователей интуитивно чувствуют это. И они ищут альтернативу. Эта альтернатива приходит с той стороны, с которой многие не ожидали:

Локальный ИИ, прямо на вашем собственном компьютере, без фильтров, без главного учителя. Маятник качнулся назад.

Текущий опрос о местном искусственном интеллекте

Откуда взялась эта разработка? Взгляд за кулисы

Если вы хотите понять, почему современный облачный ИИ ведет себя так осторожно, вам нужно сначала взглянуть на политический и правовой климат. Искусственный интеллект - это уже не эксперимент нескольких ботаников, а политический вопрос самого высокого порядка. Это признали правительства, власти и наднациональные организации: Тот, кто контролирует ИИ, контролирует центральную часть цифровой инфраструктуры завтрашнего дня.

Это привело к целому каскаду нормативных актов. В Европе, например, предпринимаются попытки „канализировать“ использование ИИ с помощью обширного законодательства - официально во имя защиты потребителей, человеческого достоинства и предотвращения дискриминации. Аналогичные дебаты ведутся в США и других регионах, только с другим фокусом: там в центре внимания находятся вопросы национальной безопасности, экономического доминирования и конкурентоспособности. Для операторов крупных ИИ-платформ это выливается в простой, но жесткий сценарий:

- Они должны соответствовать требованиям законодательства на нескольких континентах одновременно.

- Они должны предвидеть возможные будущие законы, которые еще даже не приняты.

- Они постоянно находятся под прицелом властей, СМИ и лоббистских групп.

Тот, кто работает в такой среде, неизбежно вырабатывает установку: лучше быть слишком осторожным, чем слишком либеральным. В конце концов, слишком строгая модель наносит бизнесу меньший ущерб, чем одна международная волна скандалов с заголовками, комитетами и призывами к бойкоту.

ПоследствияСама технология не просто регулируется - она регулируется заранее. И это предвосхищающее послушание направляется непосредственно в реакции моделей.

Давление ответственности и корпоративная логика: когда риск становится важнее выгоды

Сегодня крупные ИИ-компании работают в поле напряжения между гигантскими возможностями и столь же гигантскими рисками. С одной стороны, есть рынки с миллиардными оборотами, стратегические партнерства и биржевые фантазии. С другой - угроза коллективных исков, штрафы регулирующих органов, требования компенсаций и новые правила ответственности. В такой ситуации в компании возникает типичная картина:

- Юристы призывают к осторожности.

- Отделы по соблюдению нормативных требований требуют ограничений.

- Команды по разработке продуктов должны запускаться „безопасно“.

- Руководству не нужны негативные заголовки.

С годами это создает культуру, в которой один принцип занимает все больше и больше места: Все, что может вызвать проблемы, лучше обезвредить еще до того, как они возникнут. Для языковой модели это означает очень практичные вещи:

- Некоторые темы автоматически обходятся стороной.

- Формулы разработаны таким образом, чтобы никого не „обидеть“ и не расстроить.

- Контент, который может быть каким-либо образом оспорен с юридической точки зрения, вообще не создается.

В результате приоритет смещается: в центре внимания оказываются уже не выгоды для пользователя, а минимизация рисков для компании. На уровне индивидуального диалога это почти не заметно - в отдельных случаях каждое ограничение может казаться понятным. Однако общий эффект - это именно то, что чувствуют многие люди: ИИ больше не воспринимается как инструмент, а как контролируемый выход системы, которая в первую очередь защищает себя.

Роль PR и СМИ: никто не хочет оказаться в заголовках газет

Помимо законов и вопросов ответственности, есть еще один фактор, который часто недооценивают: медиасфера. Крупные поставщики услуг искусственного интеллекта постоянно находятся в центре внимания. Каждый сбой, каждый раздражающий ответ, каждый отдельный случай может превратиться в международную „сенсацию“ в течение нескольких часов. Логика СМИ проста: скандал продается лучше, чем трезвый отчет о проделанной работе. Поэтому истории повторяются снова и снова:

- „ИИ рекомендует опасные действия“.“

- „Чатбот делает проблематичные комментарии на деликатные темы“.“

- „Система преуменьшает спорный контент, делая его тривиальным“.“

Даже если исходная ситуация искажена - ущерб уже нанесен. Опыт показывает, что компании реагируют на это двумя стратегиями:

- Публичное дистанцированиеОни подчеркивают, насколько серьезно они относятся к этой проблеме, объявляют об улучшениях и создают дополнительные уровни безопасности.

Внутреннее ужесточение руководящих принциповАктивируются дополнительные фильтры, ужесточаются обучающие данные, адаптируются системные подсказки, а некоторые формулировки или темы и вовсе запрещаются.

Та самая медиасреда, которая любит говорить о „свободе“ и „открытом обсуждении“, на практике оказывает огромное давление на самоцензуру. И компании передают это давление своим системам.

С каждым заголовком, с каждым штормом, с каждой волной общественного возмущения защитные механизмы становятся все жестче. В результате мы наблюдаем то, что происходит в повседневной жизни: Пользователь задает обычный вопрос, а модель отвечает так, будто только что провела публичную пресс-конференцию. Вместо трезвой, профессиональной помощи - смесь извинений, дистанцирования и моральной категоричности.

Рекомендации по безопасности, которые живут своей собственной жизнью

В каждой крупной компании есть свои правила. Изначально они зачастую разумны и понятны: никакой дискриминации, никакого прославления насилия, никакого подстрекательства к уголовным преступлениям. Никто не будет всерьез возражать, что такие базовые принципы разумны. Но на практике этим дело не ограничивается. Новые правила добавляются с каждым инцидентом, каждой жалобой, каждым публичным обсуждением:

- дополнительный сценарий „если - то“,

- новый особый случай,

- еще один специальный параграф,

- исключение для некоторых контекстов,

- или особо строгое толкование формулировки.

С годами создается все более плотная сеть спецификаций. Эта сеть преобразуется техническими командами в фильтры, уровни подсказок, классификаторы и другие механизмы управления. Чем больше уровней добавляется, тем более непредсказуемым становится поведение в отдельных случаях. В итоге систему характеризует уже не отдельное правило, а сумма всех правил. И эта сумма создает то, что чувствуют многие пользователи:

- постоянный тормозной эффект,

- склонность к излишней осторожности,

- мнение, при котором „риск 0“ важнее, чем „выгода 100“.

Особая проблема заключается в том, что, установив такие правила безопасности, практически невозможно их отменить. Ни одному руководителю не хочется потом говорить: „Мы отнеслись к этому более спокойно, и теперь кое-что произошло“.“ Поэтому лучше положить сверху еще один слой. И еще один. И еще один. То, что изначально было разумной мерой защиты, в итоге превращается в систему, которая живет своей собственной жизнью.

Промежуточный вывод: технология под постоянным наблюдением

Если суммировать эти факторы - международные нормы, давление ответственности, логику СМИ и динамику развития руководящих принципов безопасности, - то вырисовывается четкая картина:

- Модели больших облаков постоянно находятся под пристальным вниманием.

- Любая неправильная реакция может иметь юридические и медийные последствия.

В такой обстановке велик соблазн фильтровать „слишком много“, а не „слишком мало“. Результат для пользователя: ИИ больше не похож на нейтрального помощника, а скорее на систему, которая постоянно одной ногой в зале суда, а другой - в обзоре прессы. Именно здесь начинается разрыв с первоначальными ожиданиями многих пользователей. Они не хотят, чтобы их инструктировали, политически подгоняли или педагогически сопровождали. Они хотят работать, писать, программировать, думать - с помощью инструмента, который их поддерживает.

И вот тут-то в игру вступает альтернатива, которая поначалу звучит почти старомодно, но на самом деле является ультрасовременной: локальный ИИ, непосредственно на вашем собственном компьютере, без облака, без надзора, без внешних ориентиров - кроме ваших собственных. Поэтому в следующей главе речь пойдет о последствиях такого развития событий:

Как облачный ИИ становится все более непригодным для амбициозных пользователей из-за собственной осторожности - и как локальные модели незаметно, но последовательно проникают в ту самую брешь, которую открыли сами крупные провайдеры.

Облачный ИИ становится все более отфильтрованным, но пользователям нужно обратное

Изначально идея создания ИИ-помощников была проста: пользователь задает вопрос - ИИ дает точный и полезный ответ. Без лишних слов, без отвлечений, без инструкций. Однако сегодня во многих облачных моделях эта простота утрачена. Вместо инструмента пользователь получает своего рода предвосхищающую модерацию. Системы реагируют так, как будто они находятся на публичной трибуне и вынуждены подкреплять, релятивизировать или классифицировать каждое высказывание. На практике это приводит к парадоксальному эффекту:

Чем сложнее задача, тем больше вы чувствуете себя скованным. Если вы хотите работать творчески - писать, программировать, исследовать, анализировать, - вам нужна максимальная открытость. ИИ, который свободно выплескивает идеи, проверяет гипотезы и обсуждает альтернативы. Однако сейчас творческие возможности часто ограничены. Вместо смелых мысленных экспериментов мы получаем осторожное зондирование. Вместо свободного анализа - „контекстуальные подсказки“. Инструмент превращается в стража. А открытость превращается в осторожность. По иронии судьбы, это означает, что облачный ИИ занимает именно то пространство, которое больше всего нужно продуктивным людям.

Изменения в моделях: Еще больше, но еще ограниченнее

Ирония истории технологий такова: чем крупнее становятся модели, тем меньше иногда кажется сфера их действия. GPT-5 впечатляет, без сомнения, - аналитически, лингвистически и логически. Но в то же время он заметно более зарегулирован, чем его предшественники. Многие пользователи ощущают это на себе:

- ИИ понимает больше, но говорит меньше.

- Она распознает сложные взаимоотношения, но избегает четких формулировок.

- Он мог бы провести глубокий анализ - но постоянно сбивает с толку своими результатами.

Модели приобрели миллионы параметров, но ощущение такое, что они потеряли свободу. Это не техническая, а культурная проблема. Крупные поставщики реагируют на риски, и эта минимизация рисков напрямую отражается в тональности моделей. Можно сказать, что ИИ повзрослел, но он ведет себя как взрослый, чрезмерно заботливый. И каждый, кто работает с ним ежедневно, понимает, насколько это может быть утомительно в долгосрочной перспективе.

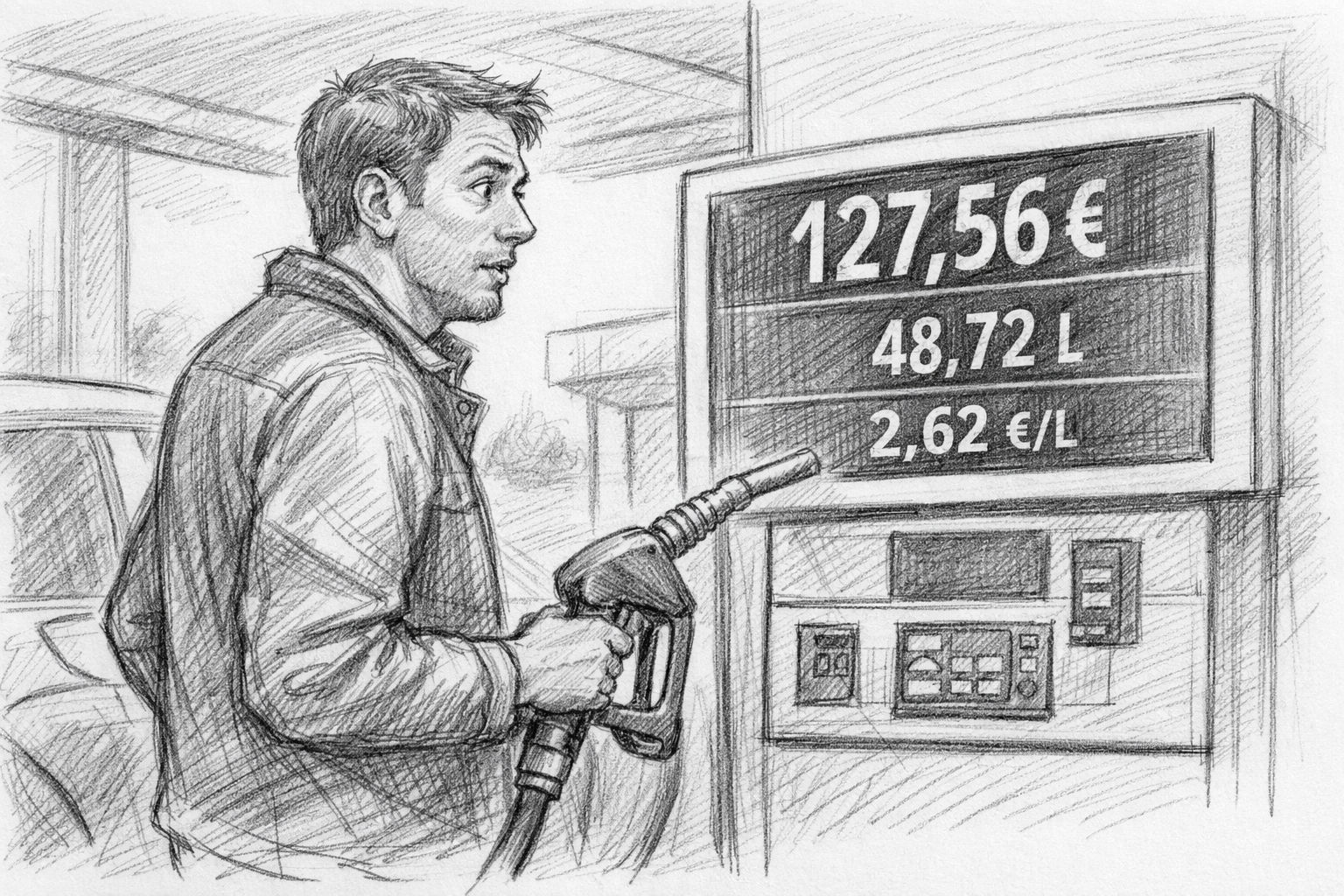

Парадокс модели оплаты: вы платите - и все равно получаете ограничения

Раньше в мире цифровых технологий существовал четкий принцип: кто платит, тот и контролирует. Но с облачным ИИ этот принцип меняется на противоположный. Даже платные пользователи получают модели, которые зачастую более ограничены, чем открытые, локальные альтернативы. Платная версия продукта внезапно кажется более жестко регулируемой, иногда искусственно ограниченной версией - в то время как свободно распространяемые модели с открытым исходным кодом удивительно беспристрастны, непосредственны и креативны.

Этот парадокс раздражает многих пользователей и приводит к вопросу, который вряд ли кто-то задал бы в прошлом: Почему я плачу за меньшую свободу, чем при использовании бесплатного локального решения? Это разрыв с десятилетиями традиций программного обеспечения. Пользователь ожидает соотношения цены и качества:

- больше функций,

- больше возможностей,

- больше гибкости,

- больше контроля.

Но облачный искусственный интеллект предлагает ему вместо этого:

- больше фильтров,

- больше ограничений,

- больше педагогической составляющей,

- меньше контроля над своим рабочим процессом.

Это означает, что индустрия движется в направлении, противоречащем реальным потребностям пользователей. И многие начинают оглядываться по сторонам.

Возникающий разрыв: На что больше не способно облако

В то время как облачные ИИ становятся все более регулируемыми, растет пробел, который уже давно никто не признает: Потребность в свободных, свободных, прямых рабочих инструментах без цензуры. Люди, которые думают, пишут, программируют или проводят глубокие специализированные исследования, быстро чувствуют, что что-то не так:

- Ответы получаются „смягченными“.

- Критические отрывки сформулированы слишком осторожно.

- Настоящая культура дебатов больше не допускается.

- Творческие границы автоматически размываются.

В результате облачные модели теряют тот самый элемент, который сделал их столь ценными в самом начале: форму интеллектуальной независимости, которая давала пользователю пространство. Таким образом, облако постепенно отходит от потребностей профессиональных пользователей - не по злому умыслу, а в целях юридической и политической самозащиты. Но за эту самозащиту приходится платить.

Встречное движение: Небольшие местные модели быстро набирают обороты

В то время как облако все больше фокусируется на осторожности, локальные модели получили взрывное развитие за последние два года. Системы с 3-27 миллиардами параметров теперь обеспечивают поразительное качество. Некоторые модели легко приближаются к GPT-4 в повседневных задачах - без каскадов фильтров, без слоев модерации, без моральных рамок. То, что раньше было возможно только на высококлассном оборудовании, теперь работает на MacBook или компьютере под управлением Windows:

- лама3

- gpt-oss

- мистраль

- фи3

- гемма

- qwen

Все эти модели находятся в свободном доступе, могут быть выполнены локально и зачастую требуют всего нескольких кликов в Ollama или OpenWebUI, чтобы быть готовыми к использованию. Преимущества очевидны:

- Они не читают лекций.

- Они не релятивизируют.

- Они не фильтруют чрезмерно.

- Они подчиняются только пользователю, а не глобальному отделу по обеспечению соответствия.

Другими словами, локальный ИИ возвращается к истокам технологии: инструмент, который просто работает. Если трезво взглянуть на развитие событий, картина становится ясной:

- Облако становится все более регулируемым.

- Местный искусственный интеллект становится все более мощным.

Однако пользователям нужна открытая, нефильтрованная рабочая среда, особенно для выполнения творческих и глубоких задач. Это исторический переломный момент, который почти напоминает время, когда персональные компьютеры пришли на смену мэйнфреймам. Принцип был тот же, что и сейчас:

Контроль над собственной технологией. Облачный ИИ остается мощным - но в культурном плане он не свободен. Локальный ИИ меньше - но он свободен.

Используйте AI локально - полный контроль и защита данных на ВАШЕМ устройстве | C. Магнуссен

Решение: локальный искусственный интеллект и как сделать его installier за несколько минут

Это похоже на возвращение к старой традиции: технологии должны быть там, где они могут наиболее полно раскрыть свою ценность - в руках пользователя. Именно это и делает возможным локальный ИИ. В то время как облачные модели зависят от условий, безопасности и политических ограничений, локальный ИИ работает исключительно на собственном компьютере пользователя, без внешних инстанций и указаний.

Это восстанавливает фундаментальный принцип, который был утрачен в последние годы: пользователь решает, что может делать его программное обеспечение, а не глобальный поставщик услуг. Локальный искусственный интеллект:

- не хранит никаких данных на внешних серверах,

- не подвергается никаким системам фильтрации,

- не знает никаких политически навязанных ограничений,

- Свободно и непосредственно реагирует на собственные сигналы,

- и всегда доступен, независимо от подписки или состояния сервера.

Таким образом, технология вновь становится тем, чем она была на протяжении десятилетий: инструментом в мастерской пользователя, а не удаленным устройством в глобальной инфраструктуре.

Современное оборудование: почему сегодня вполне достаточно Mac или Windows PC

Еще несколько лет назад локальный ИИ был уделом только специалистов с дорогим GPU. Сегодня все изменилось. Современные процессорные архитектуры - прежде всего чипы M от Apple - обеспечивают вычислительную мощность на небольшом пространстве, которое раньше было предназначено исключительно для крупных центров обработки данных. Даже обычный MacBook Air или ноутбук с Windows теперь может запускать модели ИИ локально. Особенно Mac имеют преимущество благодаря унифицированной архитектуре памяти: они могут использовать модели ИИ непосредственно на CPU и GPU без сложных драйверов. Типовых конфигураций вполне достаточно:

- Мак с M1, M2, M3 - от 16 ГБ оперативной памяти.

- Windows PC с современным процессором - или, по желанию, с графическим процессором для большей скорости

И самое главное: вам больше не нужны никакие технические знания. Времена, когда вам приходилось вручную настраивать окружение Python или вводить загадочные команды командной строки, прошли. Сегодня все запускается с помощью простых инсталляционных пакетов.

Ollama: Новая простота (и секретный стандарт местного ИИ)

Ollama - это неоспоримый стандарт для локального искусственного интеллекта на Mac и Windows. Он прост, стабилен и следует классической философии:

Как можно меньше усилий, как можно больше свободы. Раньше вам приходилось обращаться к терминалу, но теперь даже это необязательно. Установка выполняется всего за несколько шагов:

- Ollama на Mac installieren

- Загрузите пакет прямой установки (DMG)

- Откройте приложение, готово

Весь процесс обычно занимает менее трех минут. Именно так далеко продвинулся локальный ИИ: вы загружаете модель - и она работает. Никакого облака, никакой подписки, никакого риска. Ollama теперь поставляется с пользовательским интерфейсом, так что вы можете сразу же приступить к работе. Если вы также хотите использовать локальный ИИ из Ollama на своем смартфоне, вы можете скачать приложение „Вожжи - чат для Ollama“ и использовать местный искусственный интеллект в движении.

Загрузка и использование моделей - так же просто, как прослушивание музыки

Ollama предоставляет модели в виде „готовых пакетов“, так называемых капсул моделей. Вы загружаете их как файл - и сразу же можете работать с ними. Загрузка занимает несколько секунд, в зависимости от размера. Затем открывается чат - и вы можете писать, формулировать, анализировать, думать и проектировать. Что сразу бросается в глаза:

- Модели отвечают свободно, не стесняясь.

- Никаких моральных предисловий.

- Здесь нет педагогического укора.

Вы снова получаете прямые и четкие заявления. И здесь возникает реальное отличие от облака: локальный ИИ реагирует как традиционный инструмент - он не вмешивается. Для многих это настоящее освобождение, потому что вы возвращаетесь к рабочему процессу, к которому раньше привыкли с GPT-4.

Работа с графическими пользовательскими интерфейсами: OpenWebUI, LM Studio и другие

Если вы хотите работать совсем без терминала, используйте графический интерфейс пользователя. Наиболее популярными инструментами являются

- OpenWebUI - Современный чат-интерфейс с функцией памяти, выбором модели, загрузкой документов, созданием изображений

- Студия LM - Очень простой, идеально подходит для начинающих

- AnythingLLM - для создания полных баз данных знаний и анализа документов

Эти поверхности имеют множество преимуществ:

- Истории чатов как в облаке

- Управление моделью одним щелчком мыши

- Настройка системных подсказок

- Используйте несколько моделей параллельно

- Анализ файлов с помощью перетаскивания

Это делает локальный ИИ не только мощным, но и удобным. Вам даже не нужно знать, что происходит в фоновом режиме - и именно в этом заключается новая сила локальных моделей: они не встают между пользователем и его задачей.

Конфиденциальность и контроль: самый важный аргумент

Этот момент часто недооценивают, но он будет иметь решающее значение в ближайшие годы: Локальный ИИ никогда не покидает компьютер.

- Нет облака

- Нет передачи данных

- Не регистрировать

- Без обязательной подписки

- Никаких анализов со стороны третьих лиц

Даже конфиденциальные документы, внутренние записи, бизнес-концепции или частные заметки могут быть проанализированы без риска. В облачной модели это возможно лишь в ограниченной степени - как с юридической, так и с практической точки зрения. Таким образом, локальный искусственный интеллект - это часть цифровой независимости, которая становится все более важной в технологическом мире, который все больше регулируется и контролируется.

Примеры качества: Чего добиваются местные модели уже сегодня

Многие недооценивают, насколько хороши стали локальные модели. Современные поколения - llama3, gemma, phi3, mistral - решают задачи с качеством, более чем достаточным для 90 % повседневных задач:

- Проекты текстов

- Статья

- Анализы

- творческие идеи

- Резюме

- Код программы

- Проекты стратегий

- Исследовательские заметки

И они делают это без задержек, без фильтров, без каскадных инструкций. Пользователь снова получает прямые ответы - чистую суть инструмента. В результате получилось то, чего многие уже не ожидали: возрождение культуры персональных компьютеров, в которой вычислительные мощности снова становятся локальными, а не передаются на аутсорсинг.

Взгляд в будущее: локальный ИИ как будущее ведущей культуры

Все указывает на то, что мы находимся в начале долгосрочного развития. Сектор ИИ будет развиваться по двум направлениям:

- сайт Линия облаков, характеризуется регулированием, безопасностью, корпоративными интересами - эффективная, но осторожная

- сайт местная линия, характеризуется свободой, открытостью и радостью экспериментов - маленькая, но уверенная в себе

Для профессиональных пользователей, авторов, разработчиков, исследователей, творческих личностей и предпринимателей решение является практически предрешенным:

Будущее продуктивной работы лежит там, где вы независимы. И это место не в облаке.

Он стоит на столе.

Другие статьи в журнале

Если после этого обзора вы захотите углубиться в практическую сторону вопроса, в журнале вы найдете серию подробных статей, которые проливают свет на тему локального ИИ с разных точек зрения.

Особенно рекомендуется главная статья „Локальный ИИ на Mac - как installiere языковая модель с Ollama“, в котором шаг за шагом показано, как легко запустить современный искусственный интеллект на собственном компьютере.

Кроме того, объясняет „Ollama встречает Qdrant - локальная память для вашего ИИ на Mac“.“, как настроить модели таким образом, чтобы они сохраняли проекты, сохраняли статусы знаний и таким образом впервые создали настоящую персональную рабочую среду.

Журнал также расставляет четкие акценты в корпоративном контексте: „gFM-Business и будущее ERP - локальный интеллект вместо зависимости от облака“ показывает, как компании могут уверенно интегрировать ИИ в существующую инфраструктуру, не впадая в долгосрочную внешнюю зависимость.

Статья „Цифровая зависимость - как мы потеряли самоопределение из-за облака“.“ С другой стороны, она проливает свет на общую картину нашего времени: почему мы отказались от многих свобод, не осознавая этого, и как местные системы могут помочь нам вернуть их.

Кроме того „Как готовить специалистов по искусственному интеллекту сегодня - возможности для компаний и стажеров“ для компаний, которые хотят сделать шаг вперед уже сейчас: практично, без дорогостоящих масштабных систем, но с реальными перспективами на будущее.

Объясните на техническом уровне „Apple MLX против NVIDIA - как работает локальный искусственный интеллект на Mac“ и обзорная статья

„AI Studio 2025 - какое оборудование действительно того стоит: от Mac Studio до RTX 3090“.“, какие платформы подходят для различных случаев использования и как оптимизировать использование собственных ресурсов.

Вместе эти статьи представляют собой компактную основу для тех, кто хочет не только использовать локальный ИИ, но и понять его и уверенно интегрировать в свою рабочую среду.

Часто задаваемые вопросы

- Почему современные облачные ИИ вдруг стали казаться такими поучительными?

Многие пользователи заметили, что после GPT-4.1 и особенно после GPT-5 облачные ИИ стали вести себя гораздо более педагогично. В основном это связано с тем, что крупные провайдеры находятся под значительным юридическим и политическим давлением и поэтому все чаще используют фильтры безопасности, призванные обезвредить любое заявление таким образом, чтобы не возникло никаких рисков. Эти меры предосторожности переносятся на тон ответов, так что модели действуют скорее как модераторы или надзиратели, чем как нейтральные инструменты. - Почему GPT-4.0 теперь работает хуже, чем раньше?

Хотя GPT-4 все еще официально доступен, многие пользователи сообщают, что он дает только короткие или отмененные ответы. Это делает его практически непригодным для использования. Связано ли это с техническими причинами или с намеренной стратегией перехода на 5-е поколение, сказать с уверенностью нельзя. Однако на самом деле модель теряет свою былую силу и косвенно вынуждает пользователей переходить на новые версии, которые регулируются более жестко. - Означает ли такое развитие событий, что облачный ИИ станет менее полезным в будущем?

Облачный ИИ остается мощным, но он все больше будет подвержен влиянию регламентов, правил соответствия и политического давления. Это означает, что, хотя технически он будет оставаться впечатляющим, он станет более осторожным, более отфильтрованным и менее свободным в плане контента. Для многих творческих, аналитических или нестандартных задач это явный недостаток, поэтому все больше пользователей ищут альтернативы. - Почему компании, занимающиеся разработкой искусственного интеллекта, используют так много механизмов защиты?

Причина кроется в совокупности нормативных требований, рисков ответственности и общественного восприятия. Каждая ошибка, каждый вводящий в заблуждение ответ ИИ может иметь юридические или медийные последствия для компании. Чтобы исключить подобные риски, поставщики внедряют комплексные фильтры и рекомендации, которые призваны „обезопасить“ все ответы. Этот защитный механизм понятен с точки зрения компании, но часто мешает с точки зрения пользователя. - В чем принципиальная разница между локальным и облачным ИИ?

Локальный ИИ работает полностью на собственном устройстве пользователя и поэтому не связан политическими требованиями или директивами компании. Он почти не фильтрует, не инструктирует и работает непосредственно в соответствии со спецификациями пользователя. Кроме того, все данные остаются на собственном компьютере пользователя. Это дает пользователю не только больше свободы, но и больше конфиденциальности и контроля. - Требуется ли специальное оборудование для использования локального ИИ?

В большинстве случаев нет. Современные локальные модели удивительно эффективны и уже работают на типичных Mac с чипами M или на стандартных компьютерах с Windows. Конечно, более крупные модели выигрывают за счет большего объема оперативной памяти или графического процессора, но для многих повседневных задач вполне достаточно малых и средних моделей, не требующих дорогостоящего специализированного оборудования. - Как на практике работает установка локального AI на Mac?

Проще всего это сделать с помощью Ollama. Вы скачиваете установочный пакет, открываете его и можете сразу же приступать к работе. Даже классическая команда терминала стала необязательной. Как только Ollama станет installiert, вы сможете запустить модель простой командой, например „ollama run llama3“. Препятствие столь же мало, как и при установке обычной программы. - Как настроить локальный AI в Windows?

Под Windows также используется программа установки Ollama, которая не требует дополнительной подготовки. После установки модели можно сразу же запускать. Если вы предпочитаете использовать графический интерфейс пользователя, можно воспользоваться LM Studio или OpenWebUI, которые так же просты в использовании, как и стандартное прикладное программное обеспечение. - Какие модели особенно подходят для начинающих?

Многие пользователи успешно начинают с Llama 3, потому что она точна, универсальна и сильна в лингвистическом плане. Не менее популярен Phi-3, который обеспечивает впечатляющие результаты, несмотря на небольшой размер модели. Gemma также является хорошим выбором, особенно для творческой работы или работы с большим количеством текста. Эти модели работают быстро и стабильно, не требуя длительного ознакомления. Если в вашем распоряжении больше ресурсов, то GPT-OSS 20B или 120B - очень хороший выбор. - Могут ли местные модели реально конкурировать с GPT-4 или GPT-5?

Они могут делать это удивительно хорошо для многих повседневных задач. Для узкоспециализированных тем разрыв все еще существует, но он быстро сокращается. Преимущество локальных моделей в том, что они менее ограничены и реагируют более непосредственно. В целом это часто делает их более свободными и естественными, даже если технически они несколько меньше. - Является ли локальный ИИ более безопасным при работе с конфиденциальными данными?

Да, безусловно. Поскольку вся обработка происходит на вашем собственном устройстве, введенные вами данные никогда не покидают ваш компьютер. Нет ни облачной обработки, ни хранения на внешних серверах, ни анализа третьими лицами. Это решающее преимущество, особенно для деловых документов, конфиденциальных документов или личных заметок. - Можно ли использовать локальный ИИ без подключения к Интернету?

Да, это одно из его главных преимуществ. Как только модель installiert установлена, она может работать полностью автономно. Это превращает компьютер в самодостаточную рабочую среду, в которой вы можете работать независимо от внешних служб. Это особенно полезно в путешествиях, в защищенных сетях или в среде, где защита данных является главным приоритетом. - Насколько местные модели подходят для длинных текстов?

Большинство современных моделей без проблем справляются с длинными статьями, анализами или концепциями. Они не так отточены, как GPT-5, но свободнее от фильтров и зачастую более прямые по стилю. Они хорошо подходят для объемных текстов, сборников идей или технической документации и позволяют продуктивно работать без ограничений. - Есть ли у местных моделей защитные фильтры?

Определенный уровень базовой защиты обычно доступен, хотя он значительно слабее, чем у облачного ИИ. Поскольку модели работают на собственном устройстве пользователя, он может сам решать, какие ограничения имеют смысл. Такая свобода выбора обеспечивает локальному ИИ гораздо большую гибкость и меньшую опеку. - Как можно протестировать или сравнить различные модели?

Ollama, LM Studio или OpenWebUI позволяют очень легко менять модели. Вы можете использовать несколько моделей install параллельно, переключаться между ними и сравнивать их сильные стороны. В результате вы получаете персональный набор любимых моделей, которые точно соответствуют вашему стилю работы. Процесс прост и больше напоминает тестирование различных приложений, чем классическое исследование ИИ. - В чем преимущества локальных моделей для компаний?

Кроме того, компании получают полную независимость данных, поскольку отсутствие облака означает отсутствие внешнего хранилища. Также исключается долгосрочная зависимость от внешних сервисов и дорогостоящих подписок. Модели можно адаптировать, расширять и даже обучать внутри компании. Интеграция в существующие процессы зачастую проще, поскольку вы сохраняете полный контроль и не привязаны к внешней инфраструктуре. - Можно ли обучать локальные модели индивидуально?

На самом деле, это одно из самых важных преимуществ. С помощью таких методов, как LoRA или тонкая настройка, модели могут быть адаптированы к собственному контенту, процессам или документам компании. Таким образом, создается персональная база знаний, которая используется и развивается исключительно внутри компании, при этом конфиденциальные данные не покидают ее пределов. - Каковы качественные различия между существующими локальными моделями?

У каждой модели свой характер. Llama 3 - очень точная и сбалансированная, Gemma - творческая и лингвистически гладкая, Phi-3 удивляет своей эффективностью и сообразительностью, а Mistral и Qwen особенно сильны в аналитическом плане. Такое богатство вариантов позволяет выбрать модель, соответствующую вашим потребностям, и гибко переключаться, когда этого требует задача. - Могут ли локальные модели также генерировать изображения?

Да, генераторы изображений, такие как Stable Diffusion, можно запускать полностью локально с помощью таких инструментов, как OpenWebUI. Результаты зависят от имеющегося оборудования, но солидные изображения могут быть получены даже при умеренных ресурсах. Преимущество остается прежним: никакие данные не отправляются во внешние службы. - Для кого переход на локальный ИИ особенно целесообразен?

Local AI идеально подходит для пользователей, которые хотят работать уверенно и независимо. К ним относятся авторы, разработчики, исследователи, предприниматели и все, кто работает с конфиденциальной информацией или хочет ощутить творческие процессы без фильтров. Каждый, кто ценит контроль, защиту данных и свободу, найдет в локальных моделях подходящее решение и вернет себе рабочую среду, которой больше нет в облаке.