Хотя MLX изначально был запущен в качестве экспериментального фреймворка компанией Apple Research, в последние месяцы произошло тихое, но значительное развитие: С выходом FileMaker 2025 компания Claris прочно интегрировала MLX в сервер в качестве встроенной инфраструктуры искусственного интеллекта для Apple Silicon. Это означает, что любой человек, работающий с Mac и использующий Apple Silicon, может не только запускать модели MLX локально, но и использовать их непосредственно в FileMaker - с родными функциями, без каких-либо промежуточных слоев.

Границы между локальным экспериментом MLX и профессиональным применением FileMaker начинают стираться - в пользу полностью интегрированного, отслеживаемого и контролируемого рабочего процесса ИИ.

Новая область AI на сервере FileMaker: „AI Services“.“

Центральным элементом новой архитектуры является область „AI Services“ в консоли администратора FileMaker Server 2025, где разработчики и администраторы могут:

- активируйте сервер моделей AI,

- Управление моделями (загрузка, предоставление, настройка),

- Назначение ключей API для авторизованных клиентов,

- и целенаправленно контролировать текущие операции ИИ.

Если сервер FileMaker работает на Mac с Apple Silicon, интегрированный AI Model Server автоматически использует MLX в качестве бэкенда для вычислений. Это дает все преимущества, которые MLX предлагает на устройствах Apple: высокую эффективность использования памяти, использование встроенного GPU через Metal, а также четкое разделение модели и инфраструктуры - как в мире Apple.

Предоставление моделей MLX непосредственно через консоль сервера

Развернуть модель MLX проще, чем ожидалось: В консоли администрирования AI поддерживаемые модели можно выбрать непосредственно из растущего списка совместимых с Claris языковых моделей и развернуть их на сервере installier. Это модели с открытым исходным кодом (например, варианты Mistral, LLaMA или Phi), которые доступны в формате .npz и были специально преобразованы для MLX. В настоящее время (по состоянию на сентябрь 2025 года), однако, количество доступных моделей все еще довольно ограничено.

Кроме того, вы можете подготовить собственные модели - например, конвертировать модели обнимающихся лиц с помощью инструмента mlx-lm. С помощью одной команды вы можете загрузить модель, оценить ее количественно и преобразовать в соответствующий формат. Затем ее можно сделать доступной в каталоге сервера - по той же схеме, которая используется в Claris внутри компании. После загрузки в installiert эти модели сразу же становятся доступны для всех поддерживаемых функций искусственного интеллекта в FileMaker.

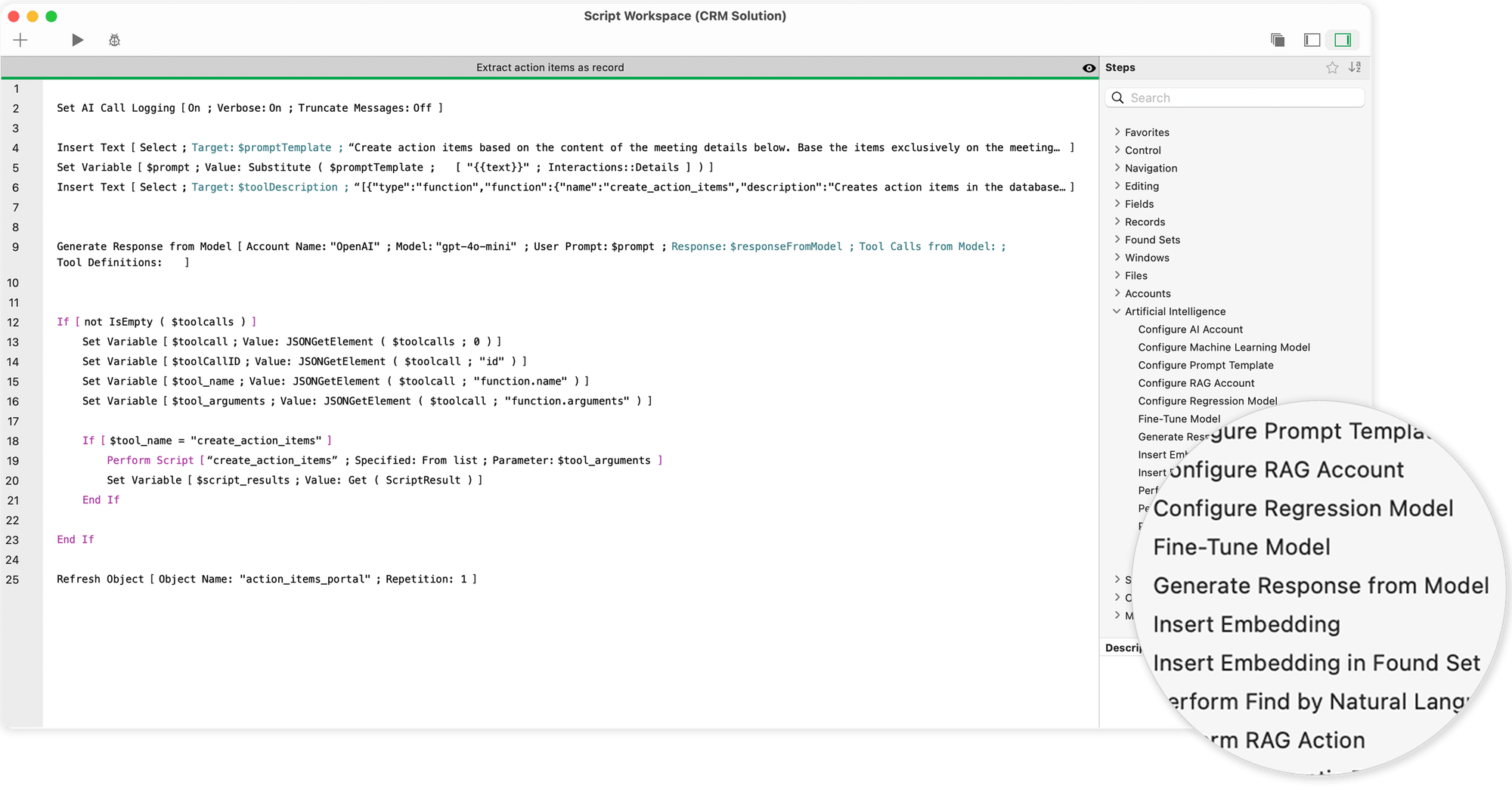

Родные функции ИИ в FileMaker Pro: скрипты вместо обходных путей

То, что раньше выполнялось через внешние API, REST-вызовы и вручную созданные JSON-рутины, теперь доступно в FileMaker 2025 в виде специальных команд сценария. После настройки учетной записи ИИ - с именем модели и подключением к серверу - задачи ИИ могут быть легко интегрированы в пользовательский интерфейс и бизнес-логику.

Самые важные команды включают

- „Генерировать ответ от модели“, которые можно использовать для создания текстовых ответов - например, для автоматических текстовых предложений, функций чата или черновиков электронной почты.

- „Выполнить поиск на естественном языке“, который преобразует простую формулировку („Покажите мне всех клиентов из Берлина с неоплаченными счетами“) в точный запрос к базе данных.

- „Выполнение SQL-запроса на естественном языке“, который также можно использовать для создания и обработки сложных структур SQL, включая соединения и подзапросы.

- „Встраивание“ и связанные с ними функции, позволяющие проводить семантический векторный анализ - например, для поиска текстов с похожим содержанием или запросов клиентов.

Все эти команды обращаются к выбранной в данный момент модели MLX, работающей на сервере AI Model Server в фоновом режиме. Ответы немедленно доступны и могут быть обработаны напрямую - в виде текста, JSON или встроенного вектора.

Шаги сценария и возможности искусственного интеллекта в FileMaker

Шаги сценария для искусственного интеллекта позволяют напрямую интегрировать мощные модели ИИ - такие как большие языковые модели (LLM) или Core ML - в рабочие процессы FileMaker. Они создают техническую основу для объединения естественного языка, знаний баз данных и машинного обучения. Доступны следующие функции:

- Конфигурация именованной учетной записи AI

Вы можете создать и назвать конкретную учетную запись AI, которая затем будет использоваться во всех дальнейших шагах и функциях сценария. Это позволяет сохранить контроль над аутентификацией и доступом к внешним моделям или сервисам. - Получение текстового ответа на основе подсказки

Модель искусственного интеллекта может реагировать на подсказку, введенную пользователем, и генерировать соответствующий текстовый ответ. Это позволяет автоматически генерировать текст, делать предложения или вести диалог. - Запрос к базе данных на основе запроса и схемы базы данных

Передав запрос на естественном языке вместе со структурной схемой вашей базы данных, модель может определить релевантный контент и вернуть целевой результат. - Создание SQL-запросов

Модель также может генерировать SQL-запросы на основе запроса и схемы базы данных. Это позволяет автоматически генерировать сложные запросы, которые затем можно использовать для работы с базой данных. - FileMaker поисковые запросы на основе полей макета

Передав модели поля текущей раскладки вместе с подсказкой на естественном языке, можно автоматически формулировать поисковые запросы и получать подходящие наборы результатов. - Вставка векторов встраивания в записи данных

У вас есть возможность вставлять семантические вкрапления - т. е. числовые векторы, отражающие значения, - в поля отдельных записей данных или целых наборов результатов. Это создает основу для последующих семантических сравнений или анализов ИИ. - Выполните семантический поиск

Основываясь на смысле поискового запроса, система может выявить записи данных, поля которых имеют схожий смысл - даже если слова не совпадают в точности. Это открывает новые возможности для интеллектуального поиска данных. - Настройка шаблонов подсказок

Вы можете определить многократно используемые шаблоны подсказок, которые можно использовать в других шагах сценария или функциях. Это обеспечивает согласованность и экономит время при создании структурированных подсказок. - Настройте регрессионную модель

Для решения таких задач, как прогнозирование, оценка или анализ тенденций, можно создать регрессионную модель, которая будет оперировать наборами числовых данных. Она подходит, например, для анализа динамики продаж или оценки рисков. - Настройка и управление учетной записью RAG

Можно создать именованную учетную запись RAG (Retrieval Augmented Generation). Это позволит вам добавлять или удалять данные и отправлять определенные запросы в пространство RAG. Системы RAG сочетают классический поиск с ответами, генерируемыми искусственным интеллектом. - Тонкая настройка модели с помощью обучающих данных

Вы можете переобучить существующую модель с помощью собственного набора данных, чтобы лучше адаптировать ее к конкретным требованиям, языковым стилям или областям задач. Тонкая настройка повышает релевантность и качество результатов. - Ведите журнал вызовов искусственного интеллекта

Для отслеживания и анализа можно активировать запись всех вызовов ИИ. Это полезно для оптимизации подсказок, устранения неполадок и документирования - Настройка моделей Core ML

В дополнение к облачным LLM можно настроить локально выполняемые модели Core ML. Это особенно удобно для автономных приложений или для использования на устройствах Apple с интегрированной поддержкой ML.

Текущий опрос о будущем Claris FileMaker и искусственного интеллекта

Тонкая настройка прямо с FileMaker: LoRA как новый стандарт

Одной из самых интересных новых функций является возможность точной настройки собственных моделей прямо в FileMaker - полностью в рамках привычного интерфейса. Все, что вам нужно, - это команда скрипта: „Fine-Tune Model“.

В качестве обучающих данных можно использовать записи из таблиц FileMaker (например, истории обращений в службу поддержки, диалоги с клиентами, образцы текстов). Метод тонкой настройки основан на LoRA (Low-Rank Adaptation) - ресурсосберегающей процедуре, которая изменяет лишь небольшую часть параметров модели и тем самым обеспечивает быструю настройку даже на устройствах с ограниченной памятью.

Данные для обучения берутся из текущего найденного набора или импортируются через JSONL-файл. После обучения модели присваивается новое имя - например, „fm-mlx-support-v1“ - и результат сразу же становится доступным для дальнейших функций ИИ. Это позволяет создавать индивидуальные языковые модели, которые точно соответствуют требованиям конкретного приложения с точки зрения тональности, словарного запаса и поведения.

Защита данных и производительность - две стороны одной медали

Тот факт, что FileMaker 2025 делает ставку на локальные модели с MLX, не случаен. В то время, когда суверенитет данных, соответствие GDPR и внутренние рекомендации по безопасности приобретают все большее значение, такой подход дает ряд преимуществ:

- Никакого облака, никаких внешних серверов, никаких затрат на APIВсе запросы остаются в вашей собственной сети.

- Более быстрое время отклика благодаря локальной обработке - особенно для повторяющихся процессов.

- Высокая прозрачность и управляемостьКаждый ответ можно проверить, каждое изменение отследить, каждый шаг обучения задокументировать.

- Тонкая настройка под собственные данныеСпецифические знания компании больше не передаются через внешних поставщиков, а полностью остаются в собственной системе.

В то же время важно реалистично оценивать ресурсы: Большие модели также требуют солидной локальной инфраструктуры - например, Apple Silicon Mac с 32 или 64 ГБ ОЗУ, возможно, с SSD-кэшированием и выделенным профилем сервера. Но те, кто пойдет по этому пути, в долгосрочной перспективе получат максимальный контроль и полную гибкость.

MLX и FileMaker - новый альянс для профессионалов

То, что изначально выглядело как параллельные пути - с одной стороны, MLX как исследовательская структура Apple, с другой стороны, FileMaker как классическая платформа баз данных - теперь превратилось в замкнутую систему.

Компания Claris осознала, что современные бизнес-приложения нуждаются не только в формах, таблицах и отчетах. Им нужен адаптивный, понимающий ИИ - интегрированный, а не дополнительный. Благодаря встроенной поддержке MLX, новых команд ИИ и возможности локальной тонкой настройки FileMaker 2025 впервые предлагает полную платформу для создания, контроля и продуктивного использования собственных процессов ИИ - без необходимости полагаться на внешних поставщиков или внешние облака.

Для таких разработчиков, как вы, которые ценят четкую, консервативно продуманную и безопасную для данных архитектуру, это не просто прогресс - это начало нового способа работы.

В другой статье я представляю Сравнение между Apple Silicon и NVIDIA и объясните, какое оборудование подходит для запуска локальных языковых моделей на Mac.

Часто задаваемые вопросы

- Что именно означает, что FileMaker 2025 „поддерживает MLX“?

FileMaker Server 2025 впервые содержит интегрированный сервер моделей AI, который - при установке на Apple Silicon Mac install - использует модели MLX нативно. Это означает, что вы можете развернуть MLX-совместимую модель (например, Mistral или Phi-2) непосредственно через консоль администратора и использовать ее в своем решении FileMaker - без использования внешних служб или вызовов REST. - Какое оборудование и программное обеспечение мне для этого нужно?

- Mac с Apple Silicon (M1, M2, M3, M4), в идеале с 32-64 ГБ оперативной памяти,

- FileMaker Server 2025, на этом Mac installiert,

- FileMaker Pro 2025 для актуального решения,

- и одна или несколько MLX-совместимых моделей - либо предоставленных Claris, либо сконвертированных самостоятельно (например, с помощью mlx-lm). - Как интегрировать такую модель в решение FileMaker?

Вы можете использовать новую функцию „Настроить учетную запись AI“ в сценариях FileMaker, чтобы указать, какая модель используется. Задаются имя сервера, имя модели и ключ аутентификации. После этого можно сразу же использовать другие функции ИИ - например, для генерации текста, вставки или семантического поиска. Все выполняется с помощью собственных шагов сценария, больше не требуется веб-просмотр или „Вставка из URL“. - Какие функции искусственного интеллекта можно использовать в FileMaker?

Доступны следующие функции (в зависимости от типа модели):

- Генерация текста („Генерировать ответ из модели“)

- Естественный поиск („Выполнить поиск на естественном языке“)

- SQL на повседневном языке („Выполнение SQL-запроса на естественном языке“)

- Семантические векторы („Получить вкрапление“, „Косинусное сходство“)

- Управление шаблонами подсказок („Настроить шаблон подсказки“)

- Тонкая настройка LoRA по собственным данным („Тонкая настройка модели“)

Все функции основаны на сценариях и могут быть легко интегрированы в существующие решения. - Как работает тонкая настройка непосредственно в FileMaker?

В FileMaker 2025 вы можете доработать существующую модель MLX непосредственно через LoRA - то есть настроить ее с помощью собственных данных. Для этого используются либо записи данных в таблице (например, вопросы + ответы), либо JSONL-файл. Достаточно одной команды сценария („Уточнить модель“), чтобы создать новую, настроенную модель - и она сразу же становится доступной в решении. - Нужно ли мне по-прежнему знать Python, JSON, API или форматы моделей?

Нет, не обязательно. Claris намеренно позаботилась о том, чтобы многие из этих технических деталей отошли на второй план. Вы можете работать с родными командами скриптов, самостоятельно управлять данными в FileMaker и просто обрабатывать возвраты как текст или вектор. При желании можно углубиться - но теперь это можно сделать и без знаний программирования. - В чем преимущества использования MLX через FileMaker по сравнению с внешними API?

Преимущества заключаются в безопасности данных, контроле затрат и производительности:

- Подключение к облаку не требуется, все данные остаются в вашей собственной сети.

- Никаких затрат на API или ограничений на токены - один раз installiert можно использовать бесплатно.

- Очень короткое время отклика, поскольку между ними нет сетевых задержек.

- Полный контроль над обучающими данными, тонкая настройка и создание версий моделей.

Это настоящее изменение в игре, особенно для внутренних приложений, промышленных решений или чувствительных процессов. - Есть ли какие-нибудь ограничения или вещи, которых следует остерегаться?

Да - MLX работает только на Apple Silicon, т.е. сервер Intel исключен. Вам также потребуется достаточно оперативной памяти, чтобы большие модели могли работать надежно. Не все модели сразу совместимы - некоторые нужно конвертировать. И наконец: несмотря на то, что многие вещи работают „автоматически“, для продуктивного использования всегда следует проводить специальное тестирование - например, с небольшим объемом данных, четким определением целей и хорошей стратегией протоколирования.

Материал изображения (c) Claris Inc. и Kohji Asakawa на Pixabay