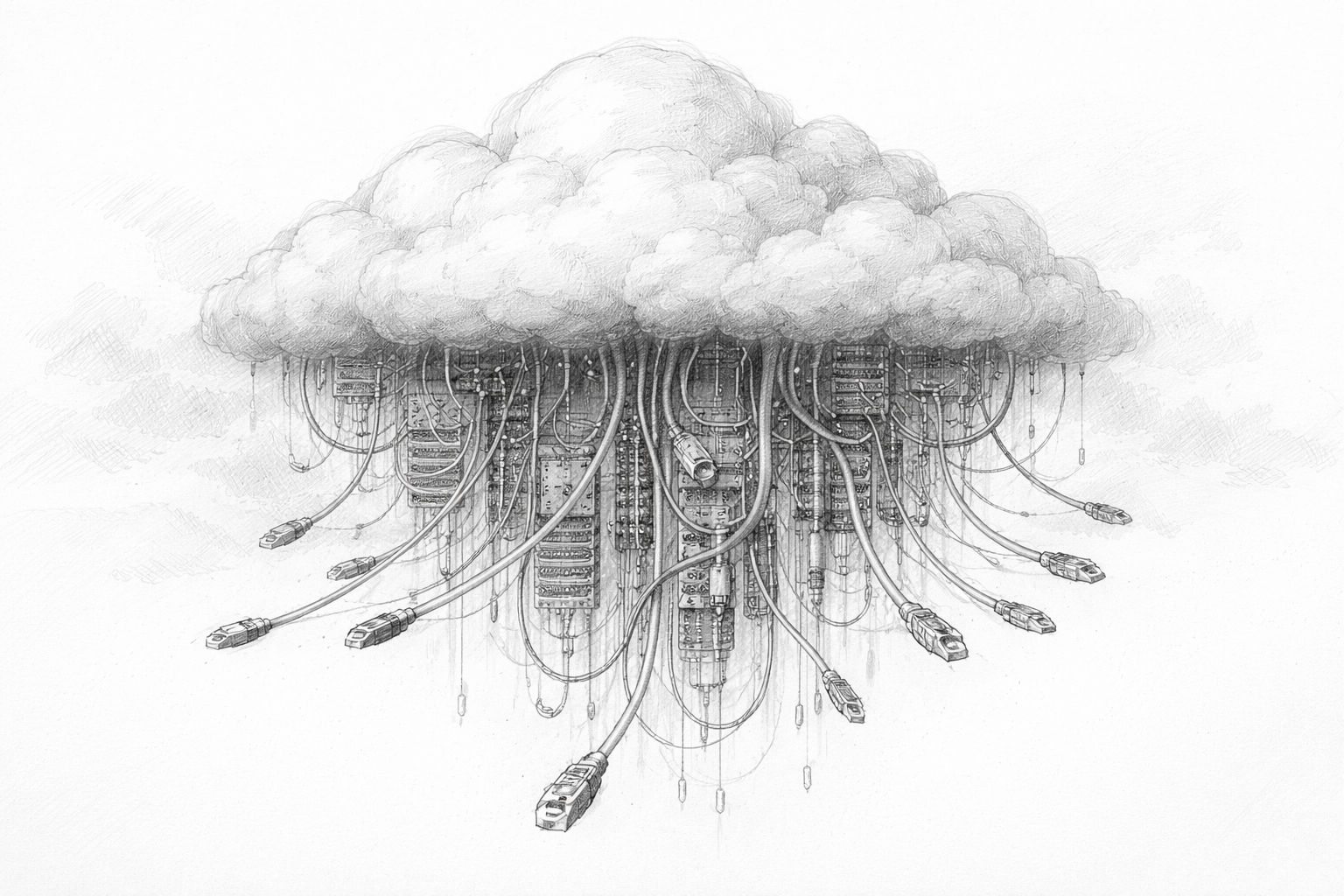

Au premier abord, l'intelligence artificielle semble presque en apesanteur. On tape une question, quelques secondes plus tard, une réponse apparaît. Pas de bruit, pas de fumée, pas de mouvement visible. Tout semble se passer „dans le nuage“. C'est précisément là que réside l'erreur de raisonnement. L'IA n'est pas une magie abstraite, mais le résultat de processus physiques très concrets. Derrière chaque réponse se trouvent des centres de calcul, des lignes électriques, des systèmes de refroidissement, des puces et des infrastructures entières. Plus l'IA s'impose dans notre quotidien, plus cette réalité devient visible. Et c'est là que commence la question de la durabilité.

Parler d'IA sans parler d'énergie, de ressources et d'infrastructure, c'est ne décrire que la surface. Cet article va plus loin. Non pas en étant alarmiste, mais en jetant un regard lucide sur ce dont l'IA a réellement besoin pour fonctionner - aujourd'hui et à l'avenir.

L'erreur commune : l'IA comme „cloud immatériel“

Beaucoup de gens se représentent l'IA comme un logiciel d'autrefois : un programme qui tourne quelque part, est mis à jour et c'est tout. Cette conception date d'une époque où la puissance de calcul était relativement bon marché, limitée localement et peu énergivore. L'IA sort de ce cadre.

Le terme „cloud“ renforce encore cette impression. Il sonne doux, presque naturel. Les nuages flottent, ils ne pèsent rien. En réalité, il cache l'une des industries les plus énergivores de notre époque. De grands halls remplis d'ordinateurs ultraperformants qui fonctionnent 24 heures sur 24. Des milliers de kilomètres de câbles. Des installations de refroidissement massives. Maintenance permanente.

La différence avec les logiciels classiques ne réside pas dans le principe, mais dans l'ordre de grandeur. L'IA n'évolue pas de manière linéaire. Plus elle devient performante, plus ses besoins en ressources augmentent. Et ceux-ci n'augmentent pas quelque part de manière abstraite, mais très concrètement sur place.

Ce dont l'IA moderne a vraiment besoin

Pour comprendre pourquoi l'IA n'est plus un sujet purement logiciel, il est utile de jeter un coup d'œil sur ses besoins fondamentaux. Les systèmes d'IA modernes ont principalement besoin de trois choses : de puissance de calcul, d'énergie et de refroidissement.

La puissance de calcul n'est pas créée ex nihilo. Elle est fournie par des puces spécialisées, optimisées pour l'apprentissage automatique. Ces puces travaillent en parallèle, extrêmement rapidement - et consomment d'énormes quantités d'énergie. Plus le modèle d'IA est grand, plus ces puces doivent travailler simultanément. Un seul modèle peut comporter des dizaines de milliers d'unités de calcul de ce type.

La consommation d'énergie n'est pas un effet secondaire, mais une donnée centrale. L'IA ne calcule pas ponctuellement, mais en permanence. Les demandes arrivent 24 heures sur 24. Les entraînements durent des jours, voire des semaines. L'immobilisation n'est pas une option économique. Le système doit fonctionner, que ce soit la nuit, le week-end ou les jours fériés.

Cela pose immédiatement le problème suivant : la chaleur. L'énergie électrique n'est pas entièrement convertie en puissance de calcul. Une partie considérable se transforme en chaleur perdue. Sans un refroidissement coûteux, les ordinateurs IA modernes tomberaient rapidement en panne. Le refroidissement nécessite lui-même de l'énergie - et souvent de l'eau.

C'est là qu'il devient clair que l'IA est physique. Elle est liée à des lieux, à des réseaux, à des ressources. Et elle devient donc inévitablement une question de durabilité, même si l'on souhaite éviter ce mot.

Entraînement et utilisation : deux charges totalement différentes

Un autre point qui passe souvent inaperçu dans le débat public est la différence entre l'apprentissage d'une IA et son utilisation ultérieure. On a tendance à mettre les deux dans le même sac, alors que les contraintes sont très différentes.

Lors de l'entraînement, de grandes quantités de données sont traitées. Le système apprend les relations, les modèles, le langage, les images. Cette phase est extrêmement intensive en termes de calcul. Elle est généralement concentrée dans de grands centres de calcul et peut consommer d'énormes quantités d'énergie. Un seul entraînement d'un grand modèle peut consommer autant d'électricité qu'une petite ville sur une longue période.

Après la formation vient l'utilisation. Ici, le modèle n'est plus fondamentalement modifié, mais appliqué. Chaque requête déclenche des processus de calcul, mais à plus petite échelle. Le problème réside dans la masse. Lorsque des millions ou des milliards de personnes utilisent quotidiennement l'IA, cet effort apparemment minime s'accumule et devient une charge de base permanente.

Les deux phases sont pertinentes. L'entraînement assure des pics d'activité, l'utilisation une consommation permanente. La durabilité doit prendre en compte les deux niveaux, sinon l'analyse reste incomplète.

Pourquoi l'IA est différente de la numérisation précédente

On pourrait argumenter que toute nouvelle technologie consomme de l'énergie. C'est vrai. Mais l'IA se distingue des étapes précédentes de la numérisation sur un point crucial : elle ne se contente pas de remplacer les processus existants, elle en crée de nouveaux.

Internet a rendu la communication plus efficace. Les e-mails ont remplacé les lettres, les vidéoconférences ont remplacé les voyages d'affaires. L'IA, en revanche, est souvent utilisée en complément. Les textes ne sont pas seulement écrits, mais aussi modifiés plusieurs fois. Les images ne sont pas seulement créées, mais aussi produites en série. Les décisions ne sont pas automatisées et finalisées, mais simulées, évaluées, recalculées.

Les gains d'efficacité ne se traduisent souvent pas par des économies, mais par une utilisation accrue. Ce qui est bon marché et rapidement disponible est plus souvent utilisé. Ce phénomène n'est pas nouveau, mais il est particulièrement prononcé dans le cas de l'IA. Plus elle s'améliore, plus le désir de l'utiliser partout augmente. C'est précisément pour cette raison qu'il est insuffisant d'espérer que la seule efficacité technique résoudra le problème de la durabilité. Même des systèmes plus efficaces peuvent finir par entraîner une augmentation de la consommation globale.

Lorsque l'on parle aujourd'hui d'IA durable, on entend souvent un sous-entendu moral. C'est compréhensible, mais pas toujours utile. Avant de parler du bien et du mal, il vaut la peine de jeter un coup d'œil sur les bases physiques.

L'électricité doit être produite. La chaleur doit être évacuée. L'eau est limitée. Les réseaux ont des limites de capacité. Ces faits ne peuvent pas être écartés, aussi avancés que soient les logiciels. La durabilité ne commence donc pas par de bonnes intentions, mais par une question :

Qu'est-ce qui est techniquement et infrastructurellement réalisable ?

Ce n'est que lorsque cette base est comprise que des décisions judicieuses peuvent être prises. Des décisions sur l'endroit où l'IA doit être utilisée, dans quelle mesure, et à quel prix - économique et social.

La vraie question derrière le débat

A la fin de ce premier chapitre, il n'y a pas encore d'évaluation, mais un déplacement de la perspective. La question décisive n'est pas : „L'IA est-elle durable ?“ Cette question est trop générale et invite à des réponses rapides.

La question plus précise est la suivante : quelle forme d'IA voulons-nous et que sommes-nous prêts à dépenser pour cela ? L'énergie, les ressources, l'infrastructure, les décisions politiques - tout cela fait partie de ce calcul. Ceux qui considèrent l'IA comme un simple produit logiciel ne tiennent pas compte de ces interactions.

Dans les prochains chapitres, il ne sera donc pas question de battage médiatique ou de peur, mais de structures. De la politique énergétique, du design des puces, des questions de localisation et des scénarios d'avenir. Car ce n'est que lorsque l'on voit la machine derrière la magie que l'on peut parler de son avenir de manière pertinente.

Le tournant politique - quand l'IA demande ses propres centrales électriques

Parfois, une seule phrase en dit plus sur l'état d'un développement que des pages d'études. Lorsque Donald Trump a déclaré au Forum économique mondial de Davos que les entreprises d'IA devaient construire elles-mêmes leurs centrales électriques ou qu'elles devaient s'approvisionner en énergie auprès d'autres entreprises, il a fait preuve d'une grande prudence. participer au financement, Ce n'était pas un plan directeur de politique énergétique. Mais c'était un moment d'une honnêteté remarquable. Car il y a dans cette phrase une prise de conscience qui ne dit pas son nom :

L'intelligence artificielle n'est plus simplement une branche logicielle de plus, mais un complexe industriel aux besoins énergétiques massifs.

Indépendamment de l'évaluation politique de Trump, cette déclaration touche une corde sensible. Les grandes entreprises d'IA font désormais clairement savoir qu'à long terme, elles ne peuvent plus compter sur les réseaux électriques existants pour „répondre“ à leurs besoins. Elles ont besoin de quantités d'énergie planifiables, durables et importantes. Et c'est là que commence la dimension politique de la durabilité de l'IA.

Les centres de données, une nouvelle industrie lourde

Pendant longtemps, les centres de données ont été considérés comme une infrastructure relativement discrète. Ils se trouvaient quelque part à la périphérie des villes, consommaient de l'électricité, produisaient de la chaleur - et ne faisaient guère l'objet de débats publics. Cela est en train de changer radicalement.

Les centres de données modernes de l'IA évoluent dans un ordre de grandeur que l'on ne connaissait autrefois que dans l'industrie classique. Leurs besoins en électricité peuvent correspondre à ceux d'un parc industriel de taille moyenne. Leurs exigences en matière de refroidissement sont complexes. Leur besoin en surface est croissant. Et surtout, ils ne fonctionnent pas seulement pendant la journée, mais 24 heures sur 24, sept jours sur sept.

Elles se retrouvent ainsi automatiquement dans la même catégorie que les aciéries, les usines chimiques ou les raffineries. Auparavant, de telles installations étaient implantées de manière ciblée, accompagnées politiquement et planifiées dans le cadre de la politique énergétique. Ce sont exactement les mêmes questions qui se posent désormais pour les infrastructures d'IA - mais beaucoup plus rapidement et souvent sans que les responsabilités soient clairement définies.

Pourquoi la politique ne peut pas éviter ce problème

L'énergie n'est pas un marché libre dans le vide. Les réseaux électriques, les centrales électriques et les procédures d'autorisation sont réglementés politiquement, planifiés à long terme et sensibles à la société. Si un seul centre de données a soudainement besoin d'autant d'électricité qu'une ville entière, cela n'est pas sans conséquences.

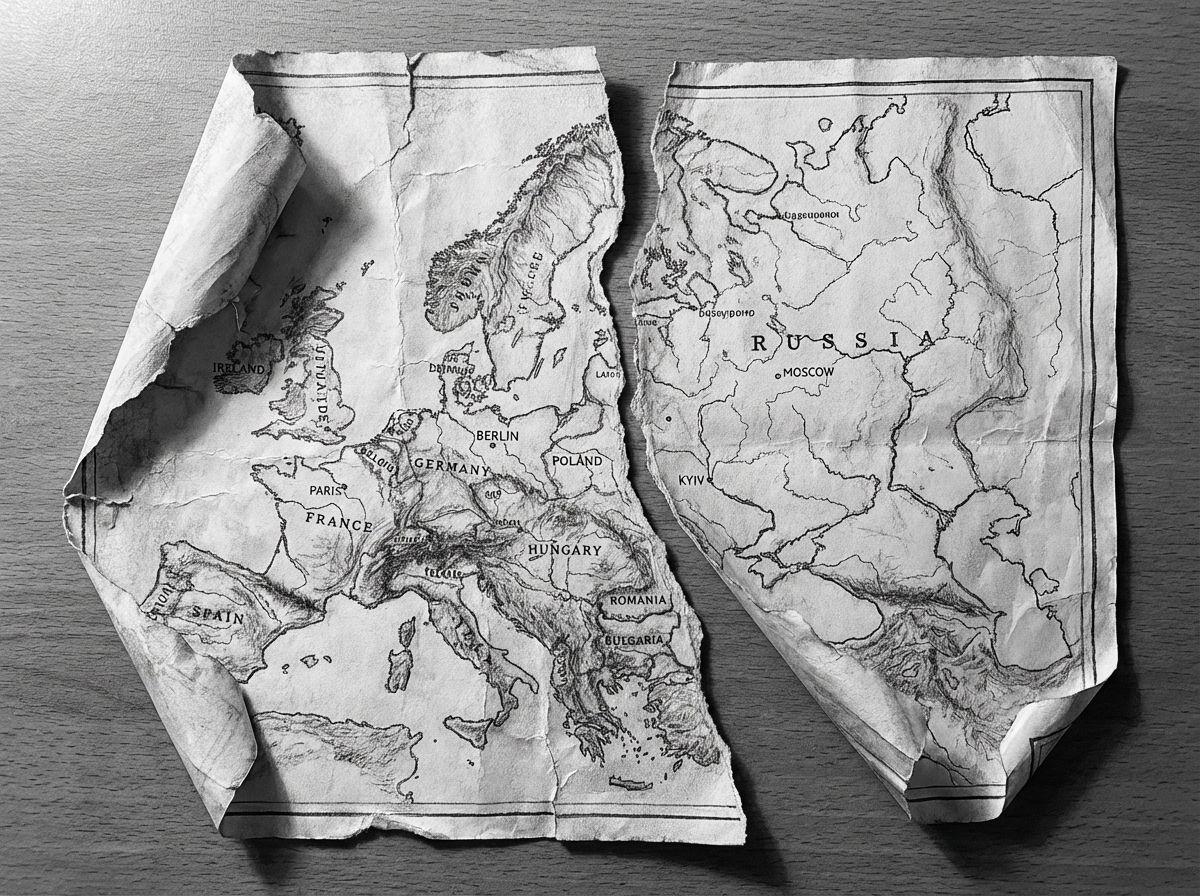

La politique est ici confrontée à un dilemme. D'une part, l'IA est considérée comme une technologie clé pour la compétitivité économique, l'innovation et la sécurité nationale. D'autre part, ses besoins en énergie sont en concurrence directe avec les ménages, les PME et l'industrie existante. L'augmentation des prix de l'électricité, les coûts d'extension du réseau et les goulets d'étranglement locaux deviennent rapidement des conflits politiques.

L'idée que les entreprises d'IA devraient organiser elles-mêmes leur approvisionnement en énergie n'est donc pas seulement pragmatique, mais aussi politiquement déculpabilisante. Elle déplace les responsabilités. Au lieu de développer les réseaux publics et de les subventionner, les acteurs privés doivent créer leurs propres solutions. Cela semble conforme à l'économie de marché - mais les conséquences sont importantes.

Trump et la question de l'énergie tech - un tournant politique

Aux États-Unis, un événement inhabituel proposition de politique énergétique pour discussion : le président Donald Trump et plusieurs gouverneurs font pression pour que les grandes entreprises technologiques cofinancent de facto la construction de nouvelles centrales électriques afin de limiter la hausse des coûts de l'électricité pour les ménages.

La raison en est le besoin massif en électricité des centres de calcul, qui sont entre autres exploités pour des services d'intelligence artificielle et qui chargent sensiblement le réseau. Il est prévu de mettre en place une vente aux enchères dite de fiabilité, dans le cadre de laquelle les groupes tech devraient conclure des contrats d'électricité à long terme garantissant la construction de centrales électriques - indépendamment du fait qu'ils achètent effectivement ou non l'électricité. Cela pourrait déclencher des investissements de plusieurs milliards dans de nouvelles centrales électriques et réduire la pression sur les réseaux publics. Les critiques mettent toutefois en garde contre les effets secondaires possibles, comme l'augmentation des coûts pour les petits fournisseurs et une privatisation accrue des infrastructures énergétiques.

La logique derrière „construisez vos propres centrales électriques“.“

Au premier abord, l'idée semble radicale. Mais en y regardant de plus près, elle suit une logique claire. Celui qui a besoin durablement de grandes quantités d'énergie devrait également participer à leur production. C'est ce qui s'est passé pendant longtemps dans l'industrie. Les usines exploitaient leurs propres centrales électriques ou concluaient des contrats de fourniture à long terme.

Pour les groupes d'IA, cela signifie concrètement : leurs propres centrales électriques, leur propre stockage d'électricité, des liens directs avec les producteurs ou des contrats de livraison exclusifs. Cela peut concerner le gaz, l'énergie nucléaire, les énergies renouvelables ou des formes mixtes. Ce qui est décisif, ce n'est pas la technologie, mais la possibilité de planifier.

Mais cela donne naissance à une nouvelle forme d'infrastructure : les îlots d'énergie privés. Des centres de calcul haute performance avec leur propre approvisionnement, leur propre priorisation et leur propre protection. Ils sont moins dépendants du réseau public - et donc moins impliqués dans les mécanismes de compensation classiques.

Quand la politique d'implantation devient une politique énergétique

C'est au plus tard à ce moment-là que l'on comprend pourquoi l'infrastructure d'IA est politiquement explosive. L'emplacement d'un centre de données n'est plus seulement choisi en fonction de la législation fiscale ou de la main-d'œuvre, mais aussi en fonction de la disponibilité de l'énergie, de la situation en matière de permis et de la prévisibilité politique.

Les régions disposant de réseaux stables, de sources d'énergie bon marché et d'une autorisation rapide deviennent plus attrayantes. D'autres prennent du retard. Cela peut renforcer les déséquilibres existants - entre les pays, au sein des États et même entre les municipalités.

Pour les décideurs locaux, il s'agit d'une situation inédite. D'un côté, les centres de données promettent des investissements et du prestige. De l'autre, ils ne génèrent guère d'emplois, mais des coûts d'infrastructure élevés. Les routes, les réseaux, les raccordements à l'eau et les mesures de sécurité doivent être mis à disposition, alors que les avantages directs restent limités.

Ce qui semble abstrait dans les stratégies nationales devient très concret sur le terrain. Les citoyens demandent pourquoi de nouvelles conduites sont construites. Pourquoi l'eau se fait plus rare. Pourquoi les prix de l'électricité augmentent. Et pourquoi tout cela se produit pour que des textes soient générés ou des images calculées quelque part.

Cette question d'acceptation est souvent sous-estimée. Alors que les produits industriels classiques sont tangibles, l'utilité de l'IA reste diffuse pour de nombreuses personnes. Cela complique la communication politique. La durabilité n'est ici pas seulement une catégorie technique, mais aussi sociale. Plus l'infrastructure devient visible, plus la pression pour la justifier augmente. L'IA ne peut pas être considérée durablement comme un service invisible alors que ses traces physiques sont de plus en plus évidentes.

Déplacement du pouvoir grâce à l'autosuffisance énergétique

Un autre aspect est rarement discuté ouvertement : L'autosuffisance énergétique crée du pouvoir. Celui qui contrôle son propre approvisionnement est moins dépendant des décisions politiques, des pannes de réseau ou des interventions réglementaires.

Pour les grands groupes technologiques, c'est attrayant. Pour les États, cela peut être problématique. Car les instruments classiques de contrôle - rémunération du réseau, priorisation, coupures - sont moins efficaces lorsque l'infrastructure critique est organisée de manière privée.

Un nouveau niveau de négociation entre la politique et les entreprises technologiques voit ainsi le jour. Il ne s'agit plus seulement de données ou de réglementation, mais d'énergie, de surfaces et de ressources à long terme.

Le point d'inflexion est atteint

Le premier chapitre a montré que l'IA est physique. Ce chapitre montre que ce physique devient politique. La déclaration selon laquelle les entreprises d'IA devraient construire elles-mêmes leurs centrales électriques ne marque pas un dérapage, mais un tournant. Elle rend visible ce qui a souvent été occulté jusqu'à présent : L'IA n'est pas seulement une question d'algorithmes, mais aussi d'infrastructure, de pouvoir et de responsabilité.

Les prochains chapitres seront donc plus concrets. Il sera question de quantités d'électricité, de refroidissement, d'eau et de limites techniques. Car ce n'est que lorsque ces bases seront comprises qu'il sera possible de parler de durabilité de manière réaliste - au-delà des slogans et des déclarations d'intention bien senties.

Faim d'électricité, refroidissement, eau - la réalité physique de l'IA

Tant que l'IA sera considérée comme un phénomène logiciel, les chiffres resteront abstraits. Quelques pour cent de puissance de calcul en plus par-ci, un nouveau modèle par-là. Mais dès que l'on commence à penser aux besoins énergétiques en kilowattheures, mégawatts ou même térawattheures, la perspective change. Il ne s'agit alors plus de gadgets techniques, mais de ressources réelles, de réseaux, de centrales électriques et de conflits de distribution.

Ce chapitre est précisément consacré à ce niveau. Non pas pour susciter la peur, mais pour dresser un tableau réaliste. Car la durabilité commence là où les concepts abstraits sont traduits en limites physiques.

Combien d'électricité l'IA consomme-t-elle réellement ?

L'une des questions les plus fréquemment posées est la suivante : „Combien d'énergie l'IA consomme-t-elle réellement ?“ La réponse honnête est la suivante : cela dépend. En fonction du modèle, de l'utilisation, de l'emplacement, du matériel. Il est néanmoins possible de donner des ordres de grandeur - et ils sont révélateurs.

Les grands centres de calcul IA évoluent aujourd'hui dans des plages de puissance qui étaient autrefois typiques de sites industriels entiers. Les installations individuelles nécessitent plusieurs centaines de mégawatts de puissance connectée. Cela correspond aux besoins en électricité de dizaines de milliers de foyers. Et il ne s'agit pas d'un pic ponctuel, mais d'une charge permanente.

Ce qui est important ici, c'est que l'IA ne génère pas de consommation saisonnière comme les chauffages ou les climatiseurs. Elle fonctionne en continu. C'est ce qu'on appelle une charge de base. C'est précisément ce type de consommation qui est particulièrement exigeant pour les réseaux électriques, car elle doit être protégée en permanence.

Le point crucial n'est pas de savoir si cette demande en électricité est „trop élevée“, mais de savoir à quelle vitesse elle croît. Alors que les industries classiques se sont souvent développées pendant des décennies, l'infrastructure de l'IA se développe en quelques années. Les réseaux, les centrales électriques et les procédures d'autorisation ne sont pas conçus pour fonctionner à ce rythme.

Pourquoi les prévisions sont souvent mal comprises

Dans le débat public, on cite volontiers de grands chiffres. Doublement de la consommation d'électricité, explosion de la demande, charges massives. De telles affirmations ne sont pas fausses, mais elles sont souvent mal comprises.

Elles ne signifient pas que la lumière s'éteindra demain. Elles signifient que les planifications à long terme sont mises sous pression. Les réseaux électriques sont construits pour des profils de charge spécifiques. Si ces profils changent radicalement, des goulets d'étranglement apparaissent - au niveau local, régional ou national.

Le problème n'est pas tant la consommation absolue que la concentration. Les centres de données de l'IA ne sont pas répartis uniformément. Ils se concentrent là où les réseaux, le refroidissement et les conditions politiques sont adaptés. C'est précisément là que des conflits apparaissent.

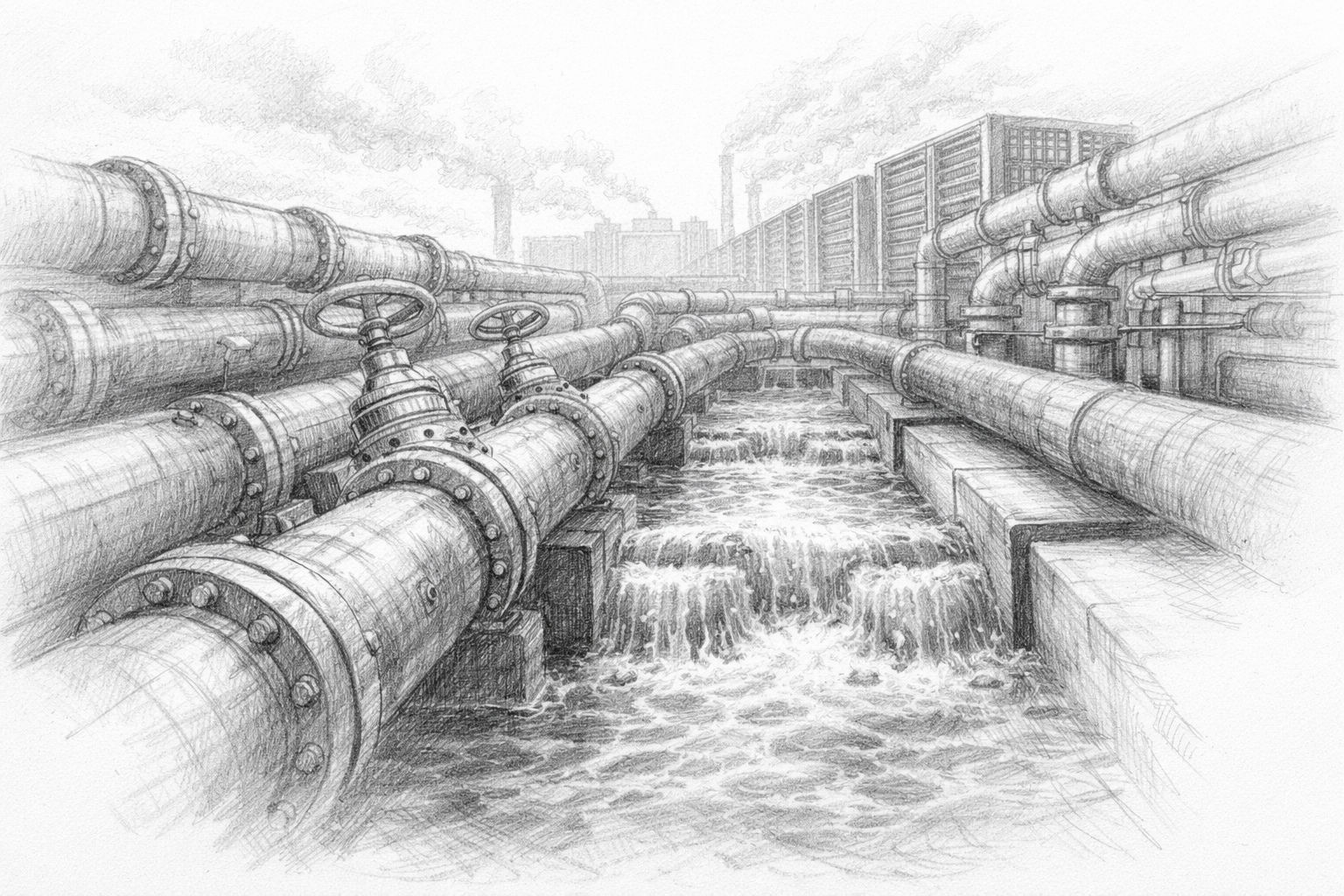

Refroidissement : le deuxième système invisible

L'électricité n'est qu'une moitié de la vérité. Chaque kilowattheure consommé par un centre de données se transforme tôt ou tard en chaleur. Cette chaleur doit être évacuée, sinon l'exploitation s'effondre. Le refroidissement n'est donc pas un supplément, mais un système d'exploitation central de l'infrastructure moderne de l'IA.

Autrefois, le refroidissement par air suffisait. Des ventilateurs, des climatiseurs, de l'air chaud évacué. Avec la densité de puissance croissante des puces modernes, ce principe a atteint ses limites. Aujourd'hui, on utilise de plus en plus de systèmes de refroidissement liquide, dans lesquels les fluides de refroidissement sont directement acheminés vers les processeurs. Ces systèmes sont plus efficaces, mais plus complexes. Ils nécessitent des pompes, des échangeurs de chaleur, des mécanismes d'urgence. Et ils génèrent de nouvelles dépendances : à l'eau, aux liquides de refroidissement chimiques, à des températures stables.

Le refroidissement n'est pas un problème de détail. Il détermine l'endroit où les centres de données peuvent être exploités. Les régions où les températures extérieures sont élevées, où les ressources en eau sont limitées ou où les réseaux sont instables sont reléguées au second plan.

L'eau : un goulet d'étranglement souvent refoulé

Alors que l'on parle beaucoup d'électricité, l'eau est étonnamment souvent laissée de côté. Pourtant, elle est indispensable dans de nombreux concepts de refroidissement. Le refroidissement par évaporation, les centrales de refroidissement, les échangeurs de chaleur - tout cela nécessite de l'eau en quantités importantes. Dans les régions riches en eau, cela passe presque inaperçu. En revanche, dans les régions sèches, l'eau devient rapidement un sujet politique. Lorsque les centres de calcul sont en concurrence avec l'agriculture, l'industrie et les ménages, des conflits de répartition apparaissent. Et ceux-ci ne peuvent pas être résolus simplement avec de l'argent.

De plus, la consommation d'eau est locale. L'électricité peut être transportée par des réseaux, l'eau seulement de manière limitée. Cela rend le facteur de localisation encore plus critique. Un centre de données ne peut pas être construit là où les terrains sont favorables si l'eau fait défaut.

Le débat sur la durabilité de l'IA deviendra donc inévitablement plus régional. Ce qui semble judicieux à l'échelle mondiale peut s'avérer problématique au niveau local.

L'argument souvent avancé est que les nouvelles technologies vont atténuer le problème. Des puces plus efficaces, un meilleur refroidissement, des logiciels optimisés. Ce n'est pas faux - mais incomplet. Les gains d'efficacité réduisent la consommation par unité de calcul. Dans le même temps, les coûts et les obstacles à l'utilisation diminuent. Cela conduit souvent à une utilisation plus fréquente de l'IA et dans de nouveaux domaines. L'effet global peut alors même être une consommation plus élevée.

Ce modèle est connu dans d'autres domaines. Des moteurs plus efficaces n'ont pas entraîné une diminution du trafic, mais une augmentation. Un éclairage plus efficace n'a pas automatiquement réduit la consommation d'électricité, mais a augmenté l'utilisation. L'IA suit le même principe.

La durabilité ne peut donc pas être résolue uniquement par des moyens techniques. Elle est toujours une question de limites, de priorités et de choix conscients.

Les réseaux électriques, un goulot d'étranglement

Un autre aspect est souvent sous-estimé : le réseau électrique lui-même. Construire des centrales électriques est coûteux, mais développer des réseaux est souvent encore plus compliqué. Les autorisations, les tracés, l'acceptation - tout cela prend du temps.

Les centres de données IA ont non seulement besoin de beaucoup d'électricité, mais aussi de réseaux stables. Les fluctuations de tension, les pannes ou les goulets d'étranglement peuvent entraîner des dommages coûteux. C'est pourquoi les exploitants préfèrent les sites où la qualité du réseau est élevée. Cela conduit à une situation paradoxale. C'est précisément là où les réseaux sont bien développés que la pression augmente le plus. Les nouveaux gros consommateurs aggravent les goulets d'étranglement existants. L'extension est à la traîne.

Cela montre une fois de plus que l'IA n'est pas un système isolé. Elle agit en retour sur les infrastructures existantes et modifie leurs exigences.

C'est au plus tard à ce stade qu'il devient évident que la réalité physique de l'IA ne peut être dissociée des questions sociétales. L'électricité, l'eau et les réseaux sont des biens communs. Leur utilisation est politiquement réglementée et socialement sensible.

Plus l'IA sollicite ces ressources, plus la question des priorités se pose :

- À quoi sert l'énergie ?

- Quelles applications justifient quel effort ?

- Et qui décide ?

Les techniciens ne sont pas les seuls à pouvoir répondre à ces questions. Elles concernent à la fois la politique, l'économie et la société.

La prise de conscience inconfortable

Ce chapitre mène à une conclusion inconfortable, mais nécessaire : l'IA n'est pas un produit numérique „propre“. Elle est intégrée dans un monde matériel aux ressources limitées. Toute utilisation a un coût, même si celui-ci n'est pas immédiatement visible.

Dans ce contexte, durabilité ne signifie pas renoncement, mais prise de conscience. Conscience des ordres de grandeur, des relations et des conséquences. Ce n'est que lorsque cette réalité est reconnue que des solutions viables peuvent être développées.

Dans le chapitre suivant, l'attention se porte sur la technique elle-même - sur les puces, les promesses d'efficacité et la question de savoir si le progrès technique suffit à lui seul pour relever ces défis.

IA et crise de l'eau : pourquoi les centres de données consomment-ils trop d'eau ? | DW Français

Les puces, l'efficacité et l'illusion du processus technique d'autoréparation

Lorsque l'on évoque les énormes besoins en énergie de l'IA, une phrase rassurante suit presque par réflexe : la technique devient plus efficace. De nouvelles puces, de meilleurs logiciels, un refroidissement plus intelligent - le problème sera réglé avec la prochaine génération. Cet espoir est compréhensible. Il se nourrit de décennies d'expérience. Les ordinateurs sont devenus plus petits, plus rapides, plus économiques. Pourquoi en serait-il autrement pour l'IA ?

La réponse est courte : les gains d'efficacité sont réels, mais ils ne résolvent pas automatiquement le problème de fond. Au contraire, ils peuvent même l'aggraver. Pour comprendre cela, il vaut la peine de regarder de plus près la technologie derrière l'IA et les dynamiques que l'efficacité déclenche.

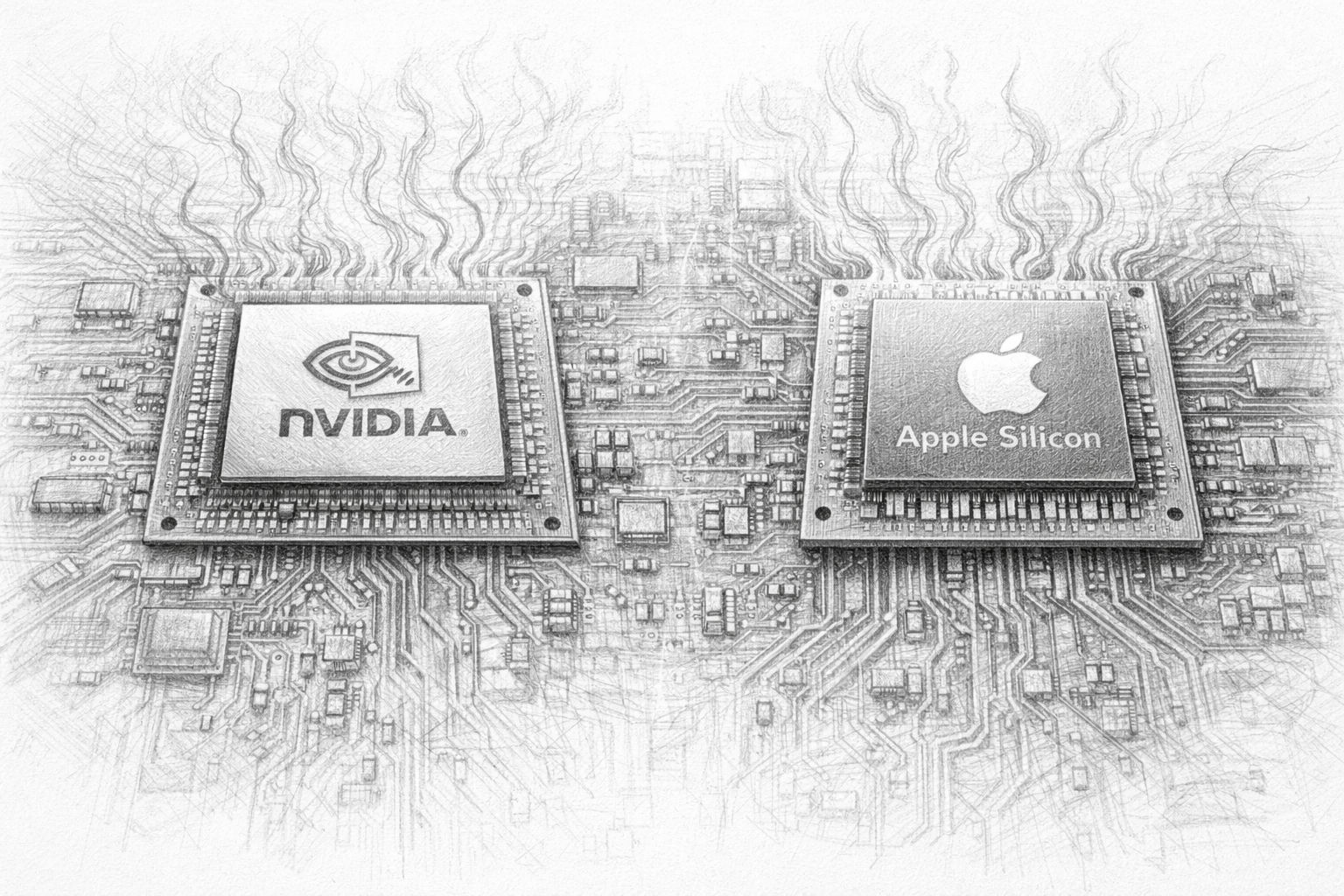

Pourquoi les puces spécialisées sont-elles si performantes - et si gourmandes ?

L'IA moderne ne fonctionne plus sur des processeurs universels classiques. Elle a besoin d'unités de calcul spécialisées, capables d'effectuer de nombreux calculs simples en parallèle. C'est précisément là que résident leurs forces - et leurs faiblesses. Ces puces sont conçues pour traiter simultanément d'énormes quantités de données. Elles ne calculent pas pas à pas, mais par grands blocs. Cela les rend extrêmement performantes, mais aussi très gourmandes en énergie. Plus la puissance de calcul est comprimée, plus la chaleur dégagée est importante et plus le refroidissement est complexe.

Le point crucial est le suivant : ces puces ne sont pas construites pour être économes, mais pour fournir un débit maximal. L'efficacité joue un rôle, mais la performance est au premier plan. Car dans la compétition pour les capacités d'IA, la vitesse compte. Celui qui s'entraîne plus rapidement, qui exploite des modèles plus grands, se procure des avantages.

Il en résulte un conflit d'objectifs structurel. L'efficacité est améliorée, mais pas au détriment de l'augmentation des performances. La consommation globale ne diminue pas nécessairement, mais se déplace.

Performance par watt - un indicateur important mais limité

Ces dernières années, un nouvel indicateur s'est imposé : Performance par watt. Il décrit la puissance de calcul obtenue avec une certaine quantité d'énergie. Cet indicateur est utile parce qu'il rend l'efficacité visible. Mais il ne s'agit pas d'une panacée.

Un système deux fois plus efficace consomme deux fois moins d'énergie pour la même tâche. Mais si, de ce fait, il est utilisé quatre fois plus souvent, la consommation totale augmente. C'est exactement le schéma que l'on observe régulièrement.

La performance par watt est une optimisation technique. La durabilité, en revanche, est une question de système. Elle dépend de la manière dont la technique est utilisée, et pas seulement de la qualité de sa construction.

Pourquoi l'efficacité entraîne souvent une utilisation accrue

Ce phénomène n'est pas nouveau. Il était déjà décrit au 19e siècle, bien avant l'apparition des ordinateurs. L'efficacité réduit les coûts et les obstacles. Ce qui devient moins cher et plus rapide est utilisé plus souvent. Les exceptions sont rares.

Cet effet est particulièrement fort dans le cas de l'IA. Plus les modèles deviennent efficaces, plus il est facile de les intégrer dans de nouvelles applications. Textes, images, vidéos, simulations - tout devient soudain possible, là où c'était auparavant trop cher ou trop lent.

Cela ne conduit pas à des économies, mais à une expansion. L'IA ne se contente pas de remplacer les processus existants, elle en crée de nouveaux. L'efficacité devient un moteur de croissance.

Ceux qui pensent la durabilité uniquement en termes d'optimisation technique ne voient pas cette dynamique. C'est comme si l'on espérait que des voitures plus efficaces réduisent le trafic.

Le mythe de la „prochaine grande percée“

Un autre argument répandu est que la prochaine génération de puces va tout changer. Des sauts quantiques, de nouveaux matériaux, des architectures révolutionnaires. De telles percées ne sont pas exclues, mais elles sont rares - et elles résolvent rarement tous les problèmes en même temps.

Même si une puce devient deux ou trois fois plus efficace, le schéma de base reste le même. L'IA croît, évolue et s'étend. Chaque percée est immédiatement traduite en nouvelles applications. Le progrès technique est absorbé, pas utilisé pour limiter.

De plus, de nombreux gains d'efficacité sont déjà pris en compte. L'optimisation simple est faite. Les progrès ultérieurs seront plus complexes, plus coûteux et plus lents. Parallèlement, la demande augmente plus vite que l'efficacité.

L'IA locale comme contre-modèle - avec des limites

L'IA locale est un contre-modèle souvent évoqué. Des modèles plus petits, moins de puissance de calcul, moins de besoins en énergie. Ce modèle est attrayant parce qu'il freine la mise à l'échelle et réduit les dépendances.

Mais là encore, l'IA locale ne remplace pas toutes les applications. Les grands modèles, les analyses complexes et les services mondiaux ne peuvent pas être facilement décentralisés. L'efficacité locale allège le système, mais elle n'annule pas la dynamique de base.

La durabilité ne résulte pas automatiquement de la décentralisation. Elle résulte d'un choix conscient de ce qui est utile au niveau local - et de ce qu'il ne faut peut-être pas faire.

Pourquoi la technique seule n'assume pas de responsabilité

La technique optimise ce qu'on lui donne. Elle ne connaît pas d'objectifs au-delà de cette optimisation. La durabilité, en revanche, est un objectif normatif. Il suppose que quelqu'un fixe des limites, établisse des priorités et prenne des décisions. Ceux qui espèrent que la technique assumera cette responsabilité confondent les moyens et les fins. Les puces efficaces sont des outils. C'est leur utilisation qui détermine si elles conduisent à une consommation plus ou moins importante.

Sur ce point, l'IA ne diffère pas des technologies précédentes. La différence réside uniquement dans la vitesse et l'ampleur.

Le rôle inconfortable de la limitation

Limitation n'est pas un mot populaire. Il évoque le renoncement, l'immobilisme. En réalité, la limitation est une forme de contrôle. Elle permet de décider où la technique est utile et où elle ne l'est pas.

L'IA durable ne naîtra pas du fait que tout devient plus efficace. Elle naîtra lorsqu'on décidera quelles applications sont prioritaires et lesquelles peuvent être abandonnées. Cette décision n'est pas technique, mais politique et sociale. L'efficacité peut aider. Elle peut soulager. Mais elle ne remplace pas une décision.

Ce chapitre aboutit à une conclusion intermédiaire claire : le progrès technique est indispensable, mais il ne résout pas le problème de la durabilité par lui-même. Des puces plus efficaces, de meilleurs logiciels et un refroidissement optimisé font partie de la solution - mais ce n'est qu'une partie. Si l'on prend la durabilité au sérieux, il faut parler d'utilisation, de mise à l'échelle et de limitation. Sur les objectifs, pas seulement sur les moyens.

Dans le chapitre suivant, nous nous éloignons donc de la technique pure pour nous intéresser à la question de l'énergie elle-même. D'où doit provenir l'électricité dont l'IA a besoin en permanence ? Et quelles sont les options réalistes, au-delà de l'idéologie et des vœux pieux ?

Les besoins énergétiques de l'IA : un défi croissant | DW Français

D'où doit venir l'électricité ? - Des options énergétiques sans idéologie

C'est au plus tard à ce stade que la question de la durabilité ne peut plus être abordée de manière abstraite. Si l'IA nécessite durablement de grandes quantités d'électricité, une question simple mais inconfortable se pose inévitablement : d'où doit provenir cette électricité ? Pas en théorie, mais en pratique. Pas à un moment donné, mais de manière continue.

Si cette question est si brûlante, c'est parce qu'elle charge d'une nouvelle urgence les vieux conflits en matière de politique énergétique. L'IA n'est pas un consommateur occasionnel, mais une charge permanente. Elle a besoin d'électricité quand elle en a besoin, et pas seulement quand le soleil brille ou quand le vent souffle. Cela fait d'elle une pierre de touche pour tout système énergétique.

Pourquoi l'IA a besoin d'une charge de base

Les systèmes d'IA ne peuvent pas être activés et désactivés à volonté. Les cycles d'entraînement durent souvent des jours ou des semaines. Les services doivent être disponibles 24 heures sur 24. Les interruptions ne sont pas seulement ennuyeuses, elles sont aussi économiquement coûteuses. Les besoins en énergie de l'IA ressemblent donc à ceux des industries classiques qui fonctionnent en continu. Elles ont besoin d'une capacité de charge de base. Cela signifie que l'électricité doit être disponible en quantité suffisante à tout moment, indépendamment de l'heure de la journée, du temps ou de la saison.

C'est précisément là que les difficultés commencent. De nombreuses sources d'énergie ne fournissent pas de l'électricité de manière constante. Elles sont fluctuantes ou saisonnières. Ce n'est pas un problème fondamental tant qu'il y a suffisamment de compensation. Mais cette compensation est coûteuse, techniquement exigeante et souvent politiquement controversée.

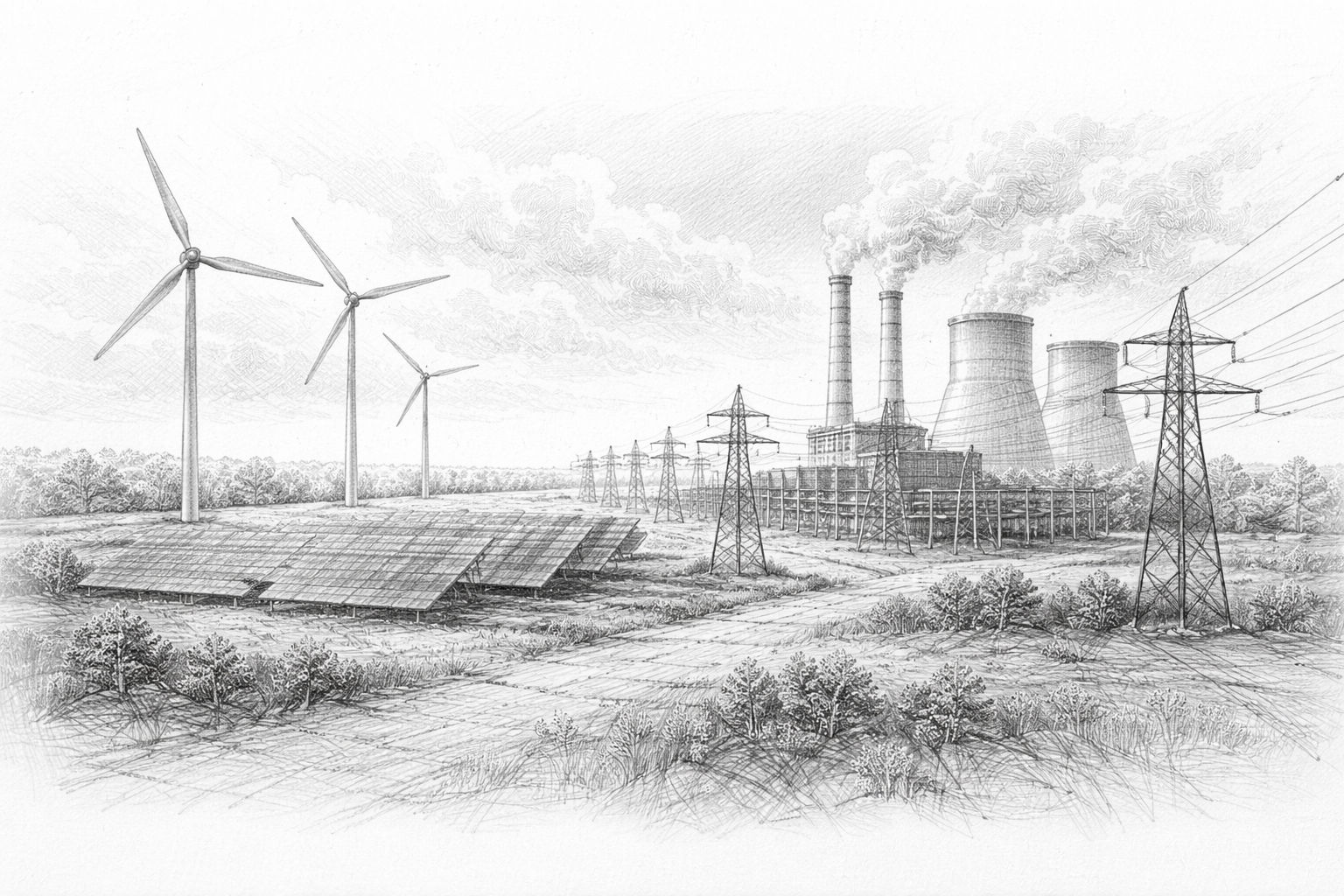

Les énergies renouvelables : indispensables mais pas suffisantes à elles seules

Les énergies renouvelables jouent un rôle central dans tout avenir durable. Il n'y a guère de doute à ce sujet. Elles sont respectueuses du climat, de plus en plus rentables et acceptées par la société. Pourtant, elles se heurtent à des limites lorsqu'il s'agit d'applications gourmandes en charge de base comme l'IA.

Les énergies solaire et éolienne fournissent de l'électricité lorsque les conditions sont favorables. Le stockage peut compenser les fluctuations, mais seulement de manière limitée. Le stockage à grande échelle pendant des jours ou des semaines est techniquement possible, mais il est coûteux et nécessite beaucoup de surface.

Pour les centres de données IA, cela signifie que les énergies renouvelables peuvent apporter une contribution importante, mais qu'elles ne garantissent pas un approvisionnement continu. Sans mesures supplémentaires, il reste une lacune dans l'approvisionnement. Cette lacune doit être comblée - sinon la durabilité reste mathématique, mais pas réelle.

Nucléaire : une renaissance inconfortable

Peu de thèmes énergétiques sont aussi chargés d'émotion que l'énergie nucléaire. Il est donc d'autant plus remarquable qu'il soit soudain à nouveau discuté avec sobriété dans le contexte de l'IA. Pas par enthousiasme, mais par besoin.

L'énergie nucléaire fournit de grandes quantités d'électricité en continu, en utilisant peu de surface et indépendamment des conditions météorologiques. C'est précisément ce qui la rend attractive pour les centres de données gourmands en énergie. Non pas comme une panacée, mais comme une base stable.

Pour les entreprises d'IA, le débat de société compte moins que la réalité technique. La prévisibilité, la sécurité d'approvisionnement et les contrats à long terme sont au premier plan. Le fait que les grands groupes technologiques s'intéressent à nouveau à l'énergie nucléaire est donc moins idéologique que pragmatique.

Parallèlement, les problèmes connus demeurent : longs délais de construction, coûts élevés, questions de stockage final, acceptation politique. L'énergie nucléaire n'est pas une solution rapide, mais une décision à long terme avec des barrières d'entrée élevées.

Gaz : un pont à risques

Le gaz naturel est souvent considéré comme un complément flexible. Il peut être mis en route et arrêté relativement rapidement, les centrales électriques sont relativement rapides à construire, la technique est éprouvée. Pour les centres de données d'intelligence artificielle, le gaz peut constituer une solution de transition.

Mais ce pont est fissuré. Le gaz est d'origine fossile. Il génère des émissions et reste sensible sur le plan géopolitique. Même avec le captage du CO₂, il reste un problème résiduel. De plus, le prix du gaz est volatil. Pour la planification à long terme, c'est un risque.

Malgré tout, le gaz jouera un rôle dans de nombreux scénarios. Non pas parce qu'il est idéal, mais parce que les alternatives manquent. Dans ce cas, la durabilité implique souvent de choisir entre de mauvaises options et des options moins mauvaises.

Stockage, réseaux et dépenses sous-estimées

On argumente souvent que le stockage résoudrait le problème. Les grandes batteries, l'hydrogène, le pompage-turbinage. Toutes ces technologies existent - mais elles ne sont pas modulables à volonté.

Les systèmes de stockage sont coûteux, gourmands en matériaux et eux-mêmes gourmands en énergie. Ils sont utiles pour compenser les fluctuations, mais ils ne remplacent pas une production durable. Plus la consommation est importante, plus le stockage doit l'être également. Ce n'est pas une limite théorique, mais physique.

A cela s'ajoutent les réseaux. L'électricité ne doit pas seulement être produite, mais aussi transportée. Les centres de calcul à haute performance ont besoin de connexions performantes. Le développement de ces réseaux est coûteux, long et conflictuel.

Approvisionnement privé en énergie : Retour aux anciens schémas

Face à ces défis, une vieille idée retrouve une nouvelle actualité : l'approvisionnement privé en énergie. Autrefois, les grandes industries exploitaient leurs propres centrales électriques ou concluaient des contrats de fourniture exclusifs. Les groupes d'IA s'orientent de plus en plus dans cette direction.

Des centrales électriques propres, un stockage propre, des connexions directes - tout cela réduit les dépendances. En même temps, cette infrastructure échappe en partie au contrôle public. L'électricité devient une ressource privée.

Cette évolution est rationnelle, mais elle n'est pas neutre sur le plan social. Elle déplace les rapports de force. Celui qui contrôle l'énergie contrôle la marge de manœuvre. Cela vaut aussi bien pour les États que pour les entreprises.

La durabilité sans illusions

C'est à ce stade que l'on comprend pourquoi les débats idéologiques ne sont guère utiles. Il n'existe pas de solution parfaite. Chaque source d'énergie présente des avantages et des inconvénients. Chaque décision entraîne des conflits d'objectifs.

La durabilité ne consiste pas ici à trouver la „bonne“ technologie, mais à nommer ouvertement les conséquences de chaque option. Quels risques acceptons-nous ? Quelles dépendances acceptons-nous ? Quels sont les coûts que nous supportons - et qui les supporte ?

L'IA nous oblige à nous poser ces questions à nouveau, car elle condense et accélère les besoins en énergie.

Ce chapitre marque un changement de mentalité. La question n'est plus de savoir si l'IA peut être exploitée de manière durable, mais dans quelles conditions. L'énergie est le facteur limitant. Pas la puissance de calcul, pas le logiciel, mais l'électricité.

Le prochain chapitre sera donc consacré aux visions d'avenir qui émergent de ces conditions. Non pas sous forme de prévisions, mais de scénarios. Car la durabilité de l'IA ne se décide pas sur une seule percée, mais sur la somme de nos décisions.

Dernière enquête sur l'utilisation des systèmes d'IA locaux

Trois scénarios d'avenir - à quel point l'IA peut réellement devenir durable

Après cinq chapitres remplis de chiffres, de limites techniques et de tensions politiques, on pourrait facilement avoir l'impression que l'IA se dirige inévitablement vers un problème de durabilité qu'il est difficile d'appréhender. Ce point de vue serait compréhensible - mais il serait trop réducteur.

L'avenir de l'IA n'est pas figé. Il ne résulte pas d'une seule percée technologique, mais de nombreuses décisions prises aujourd'hui et dans les années à venir. Des décisions sur la manière dont l'IA sera utilisée, sur le lieu où elle sera exploitée et sur la place qu'elle occupera par rapport à d'autres objectifs de la société.

Pour rendre cette ouverture tangible, il est utile de ne pas parler d'un avenir unique, mais de voies de développement possibles. Trois scénarios de ce type peuvent déjà être identifiés aujourd'hui. Aucun d'entre eux n'est garanti, aucun n'est totalement irréaliste. La réalité contiendra probablement des éléments des trois.

Scénario 1 : Centralisation et enclaves énergétiques

Dans ce scénario, la logique de la mise à l'échelle se poursuit de manière conséquente. Les grands fournisseurs d'IA concentrent la puissance de calcul dans quelques sites extrêmement performants. Ces sites disposent de leurs propres sources d'énergie, de leurs propres connexions au réseau et parfois de leurs propres solutions de stockage. Ils sont hautement optimisés, cloisonnés et efficaces au sens industriel du terme.

Les avantages de ce modèle sont évidents. L'approvisionnement en énergie devient planifiable, les pannes sont minimisées, les coûts peuvent être calculés à long terme. L'IA devient fiable, performante et disponible à l'échelle mondiale. Pour les entreprises et les États qui misent sur le leadership technologique, ce scénario est attractif.

Le prix est également clair. L'énergie est davantage privatisée. L'infrastructure échappe en partie au contrôle public. Les déséquilibres régionaux augmentent. L'acceptation sur place devient un chantier permanent. La durabilité est ici surtout comprise en termes techniques, moins en termes sociaux.

Ce scénario est réaliste parce qu'il s'inscrit dans la continuité de schémas existants. Il ne s'agit pas d'une rupture radicale, mais d'une poursuite de la logique industrielle avec de nouveaux moyens.

Scénario 2 : efficacité, réglementation et limitation délibérée

Une autre vision de l'avenir mise davantage sur le pilotage. Dans ce scénario, la politique et la société reconnaissent que la mise à l'échelle illimitée n'a pas de sens, ni techniquement ni socialement. L'IA est utilisée de manière ciblée, priorisée et réglementée.

L'efficacité reste importante, mais elle est complétée par des conditions cadres. Certaines applications sont privilégiées, d'autres volontairement restreintes. Les courses d'entraînement à forte consommation d'énergie sont soumises à des conditions. Les décisions d'implantation sont davantage coordonnées. La durabilité n'est pas laissée au seul marché.

L'avantage de ce modèle réside dans l'équilibre. L'IA reste performante, mais intégrée. Les questions d'énergie et d'infrastructure sont pensées conjointement. Les charges sont réparties de manière plus transparente.

L'inconvénient réside dans la complexité. La réglementation coûte du temps, la concertation coûte de la vitesse. La pression de l'innovation entre en conflit avec les processus de planification. Ce scénario exige une capacité d'action politique et un consensus social, deux éléments qui ne vont pas de soi. Pourtant, ce scénario n'est pas utopique. De nombreuses industries ont été intégrées de manière similaire sans perdre leur efficacité. Il présuppose que l'IA ne soit pas considérée comme une fin en soi, mais comme un outil.

Scénario 3 : IA décentralisée et locale

Le troisième scénario déplace l'accent. Au lieu de construire des systèmes centralisés toujours plus grands, l'IA est utilisée de manière plus décentralisée. Des modèles plus petits, une puissance de calcul locale, des applications spécialisées. Toutes les tâches ne nécessitent pas une puissance maximale.

Dans ce modèle, l'IA est rapprochée du lieu d'utilisation. Les entreprises exploitent leurs propres systèmes. Les appareils deviennent plus performants. Les données restent locales. La consommation d'énergie par application diminue, car l'échelle est limitée.

L'avantage réside dans la robustesse. Les dépendances sont réduites. L'infrastructure est soulagée. La durabilité résulte de la modération et non de l'efficacité maximale. Les limites de ce modèle sont également claires. Les grandes applications complexes ne peuvent pas être entièrement décentralisées. La recherche, les services mondiaux et les analyses très complexes continuent à nécessiter des ressources centralisées.

Ce scénario ne remplace pas les autres, mais les complète. Il montre que la durabilité peut aussi résulter de la diversité - tout ne doit pas nécessairement avoir la même taille, la même vitesse et la même capacité.

Pourquoi il n'y a pas de „bon“ scénario

Ces trois visions de l'avenir ne sont pas dans une relation de type "ou bien, ou bien". Elles sont plutôt des réponses différentes au même défi. Selon l'application, la région et l'objectif, différentes solutions seront utiles.

Le point décisif n'est pas de savoir quel scénario s'impose, mais si les décisions sous-jacentes sont prises en connaissance de cause. La durabilité ne découle pas automatiquement de la technique. Elle résulte de priorités.

Si l'IA est utilisée partout et à tout moment, ses besoins en énergie augmentent inévitablement. Si elle est utilisée de manière ciblée, ces besoins peuvent être contrôlés. Il ne s'agit pas d'un jugement moral, mais d'un constat lucide.

La vraie question derrière la durabilité

Il n'y a pas de réponse simple à la fin de cet article. La question „L'IA est-elle durable ?“ induit en erreur. Elle suggère qu'il y a un oui ou un non clair.

La question la plus pertinente est la suivante : pour quoi utilisons-nous l'IA - et que sommes-nous prêts à dépenser pour cela ? Énergie, ressources, infrastructure, attention politique. Cette question ne peut pas être déléguée aux algorithmes.

L'IA est un outil au potentiel énorme. Elle peut rendre les processus plus efficaces, les connaissances plus accessibles et les décisions plus fondées. En même temps, elle sollicite des ressources réelles. Les deux sont vrais.

Une perspective prudemment optimiste

Malgré tous les défis, il y a des raisons d'être prudemment optimiste. Les problèmes sont visibles. Ils sont discutés. Ils peuvent être nommés. C'est plus que ce que l'on pouvait dire de nombreux bouleversements technologiques antérieurs.

Le débat sur l'IA durable ne commence pas par le renoncement, mais par la compréhension. Celui qui connaît la réalité physique de l'IA peut prendre de meilleures décisions. Celui qui reconnaît ses limites peut l'utiliser à bon escient.

Tout ne va pas „s'arranger tout seul“. Mais tout n'est pas perdu non plus. Entre la foi aveugle dans le progrès et le scepticisme paralysant, il y a un vaste espace. C'est dans cet espace que se décidera le rôle que l'IA jouera à l'avenir - et à quel point elle peut effectivement être durable.

Au final, la durabilité n'est pas un état, mais un processus. L'IA fera partie de ce processus. Non pas comme une promesse de salut, mais comme un outil qui doit être utilisé de manière responsable.

Foire aux questions

- Que signifie exactement la „durabilité“ en matière d'intelligence artificielle ?

La durabilité de l'IA ne se limite pas à la protection du climat ou aux économies d'énergie, mais concerne l'ensemble de la consommation de ressources tout au long du cycle de vie. Cela comprend l'énergie pour les centres de données, l'eau pour le refroidissement, les matières premières pour les puces, l'infrastructure de réseau et l'impact social à long terme. L'IA est durable lorsque ses avantages sont proportionnels à ces dépenses. - Pourquoi l'IA consomme-t-elle autant d'énergie alors qu'elle n'est qu'un logiciel ?

L'IA ressemble à un logiciel, mais elle fonctionne sur un matériel très puissant. Ce matériel fonctionne 24 heures sur 24, traite d'énormes quantités de données en parallèle et génère beaucoup de chaleur. L'électricité n'est pas seulement nécessaire pour le calcul, mais aussi pour le refroidissement, la technique de réseau et la sécurité contre les pannes. - La consommation d'énergie de l'IA est-elle vraiment un nouveau problème ?

Pas fondamentalement nouvelle, mais nouvelle par son ampleur et sa vitesse. Alors que les technologies numériques antérieures se développaient lentement, l'IA évolue en quelques années. Les réseaux et l'approvisionnement en énergie ne sont souvent pas préparés à cette évolution. - Est-ce que plus d'IA signifie automatiquement plus de consommation d'énergie ?

Dans la pratique, la plupart du temps, oui. Certes, les systèmes deviennent plus efficaces, mais la baisse des coûts entraîne une augmentation de l'utilisation. De nouvelles applications voient le jour, d'anciens processus sont multipliés. L'efficacité freine l'augmentation, mais l'annule rarement. - Pourquoi les systèmes d'IA ne peuvent-ils pas simplement calculer lorsqu'il y a suffisamment de courant ?

De nombreuses applications d'IA nécessitent une disponibilité continue. Les cycles d'entraînement durent des jours ou des semaines, les services doivent être accessibles à tout moment. L'IA n'est donc pas un consommateur flexible, mais une charge de base permanente. - Quel est le rôle des centres de données dans le débat sur la durabilité ?

Les centres de données sont le cœur physique de l'IA. Ils concentrent la consommation d'énergie, la production de chaleur et le refroidissement en un seul endroit. Plus ils sont grands et denses, plus ils ont un impact sur l'infrastructure locale et l'environnement. - Pourquoi le refroidissement est-il un sujet aussi important pour l'IA ?

Les puces puissantes génèrent une chaleur énorme. Sans un refroidissement efficace, elles tomberaient rapidement en panne. Les systèmes de refroidissement modernes sont complexes, gourmands en énergie et souvent dépendants de l'eau, ce qui crée de nouveaux goulets d'étranglement. - La consommation d'eau est-elle vraiment pertinente pour l'IA ?

Oui, surtout au niveau régional. Dans les régions où l'eau est rare, les centres de données sont en concurrence avec les ménages, l'agriculture et l'industrie. L'eau n'est pas transportable à volonté et devient rapidement un facteur de conflit politique. - Les énergies renouvelables peuvent-elles couvrir entièrement les besoins en électricité de l'IA ?

À long terme, elles peuvent apporter une grande contribution, mais seules, elles ne suffisent pas actuellement. L'IA a besoin d'électricité 24 heures sur 24. Sans stockage, sans extension du réseau et sans sources d'énergie complémentaires, il subsistera un déficit d'approvisionnement. - Pourquoi les entreprises d'IA s'intéressent-elles soudain à nouveau à l'énergie nucléaire ?

Pas par idéologie, mais par besoin. L'énergie nucléaire fournit de l'électricité planifiable et continue avec une faible utilisation de l'espace. Pour les centres de données gourmands en énergie, cette stabilité est attrayante, malgré tous les problèmes connus. - Le gaz naturel est-il une solution durable pour l'IA ?

Le gaz naturel est plutôt une solution transitoire. Il est flexible et disponible, mais provoque des émissions et des dépendances géopolitiques. Il n'est durable qu'au sens relatif du terme, pas en tant que solution permanente. - Pourquoi les entreprises d'IA construisent-elles leurs propres centrales électriques ?

Un propre approvisionnement en énergie offre prévisibilité et indépendance. Les réseaux publics se heurtent à des limites, les autorisations sont longues à obtenir. Les centrales électriques privées assurent l'exploitation, mais transfèrent la responsabilité de l'État à l'entreprise. - L'approvisionnement privé en énergie est-il problématique pour l'IA ?

Elle est efficace, mais n'est pas neutre sur le plan social. Elle peut soulager les réseaux publics, mais échappe en partie au contrôle démocratique. L'énergie devient une ressource privée avec une force explosive politique. - L'IA locale pourrait-elle résoudre le problème de la durabilité ?

L'IA locale peut aider en utilisant des modèles plus petits et en traitant les données sur place. Elle réduit les charges centrales, mais ne remplace pas toutes les applications. Les grands modèles restent gourmands en énergie. - Pourquoi le progrès technique seul ne suffit-il pas ?

Parce que l'efficacité conduit généralement à une utilisation accrue. La technologie optimise les moyens, pas les objectifs. La durabilité exige de prendre des décisions sur l'utilisation de l'IA - et pas seulement sur l'efficacité de ses calculs. - L'IA doit-elle pour autant être davantage réglementée ?

La réglementation peut aider à fixer des priorités et à limiter les évolutions extrêmes. Elle est toutefois complexe et lente. Ce qui est décisif, ce n'est pas un contrôle maximal, mais un encadrement judicieux. - L'IA risque-t-elle de renforcer les inégalités sociales ?

Oui, notamment par des questions de localisation et d'énergie. Les régions dotées d'une bonne infrastructure en profitent, tandis que d'autres sont à la traîne. Les îlots énergétiques privés peuvent accentuer ces déséquilibres. - Malgré tous ces problèmes, y a-t-il des raisons d'être optimiste ?

Oui, les défis sont visibles et peuvent être discutés. L'IA n'est pas un phénomène naturel, mais peut être façonnée. Avec une prise de conscience, de la mesure et des priorités claires, elle peut être utilisée à bon escient - sans se laisser dépasser.