Há apenas alguns anos, a inteligência artificial era um tema para instituições de investigação e grandes empresas. Falava-se de redes neuronais, aprendizagem profunda e reconhecimento de voz - mas dificilmente desempenhava um papel na vida quotidiana. Atualmente, a IA já não é um tema do futuro, mas sim uma realidade: escreve textos, cria imagens, analisa dados e controla processos de produção. Quer seja na administração, no comércio ou na indústria - já se encontra em todo o lado.

Inteligência artificial

A inteligência artificial descreve a tentativa de ensinar as máquinas a pensar - não no sentido de consciência, mas como a capacidade de reconhecer padrões, tomar decisões e executar tarefas complexas. Desde modelos linguísticos e geração de imagens a sistemas autónomos, a IA está a mudar quase todas as indústrias actuais e a abrir possibilidades que eram consideradas ficção científica há apenas alguns anos. Ao mesmo tempo, levanta questões: Até que ponto esses sistemas são fiáveis? Quais são os seus limites? E que impacto têm na sociedade, na economia e na liberdade pessoal? Esta palavra-chave reúne os antecedentes, os desenvolvimentos e as aplicações práticas da inteligência artificial - claramente explicados e categorizados de forma crítica.

gFM-Business e o futuro do ERP: inteligência local em vez de dependência da nuvem

Há mais de uma década que o software gFM-Business representa algo especial no mercado alemão de ERP: não se baseia num sistema pesado e difícil de manter, mas na plataforma FileMaker leve, personalizável e visualmente modelada. Isto tem muitas vantagens: o gFM-Business pode ser expandido individualmente, funciona em Windows, macOS e iOS e pode ser personalizado tanto por programadores como por utilizadores ambiciosos.

Com o advento da inteligência artificial (IA), nomeadamente através dos chamados modelos linguísticos, como o ChatGPT, estão a surgir novas oportunidades que vão muito além da automatização tradicional. O gFM-Business está a preparar-se ativamente para este futuro: com o objetivo não só de gerir dados, mas também de desbloquear conhecimentos.

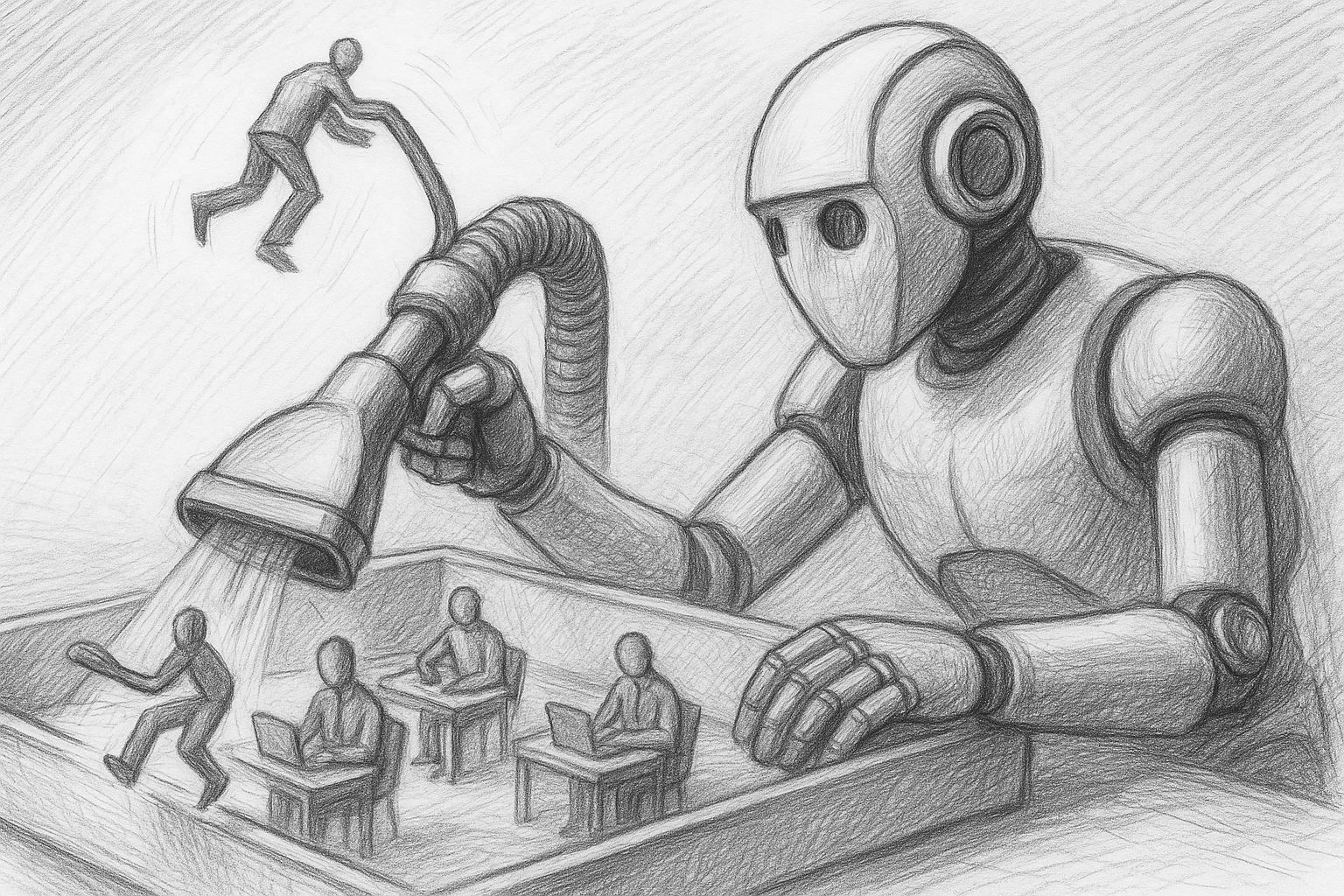

Inteligência artificial: que empregos estão em risco e como nos podemos proteger agora

Quase nenhuma outra mudança tecnológica se introduziu tão rapidamente na nossa vida quotidiana como a inteligência artificial. O que ontem era considerado uma tecnologia visionária do futuro, hoje já é uma realidade - seja no envio de mensagens de texto, na programação, no diagnóstico, na tradução ou até mesmo na criação de música, arte ou dossiers jurídicos.

Conferência FileMaker 2025: IA, comunidade e um incidente inesperado

A Conferência FileMaker 2025 em Hamburgo chegou ao fim - e foi um marco especial em muitos aspectos. Não só porque a conferência deste ano se centrou em muitos temas relacionados com a inteligência artificial, o desempenho e os fluxos de trabalho modernos, mas também porque o intercâmbio pessoal e o "ambiente familiar" da comunidade FileMaker voltaram a ser uma realidade. Para mim, pessoalmente, foi um momento intensivo, inspirador e enriquecedor - desde a primeira noite.

MLX no Apple Silicon como IA local em comparação com o Ollama & Co.

Numa altura em que os serviços centralizados de IA, como o ChatGPT, o Claude ou o Gemini, estão a dominar as manchetes, muitos utilizadores profissionais têm uma necessidade crescente de uma alternativa - uma infraestrutura de IA local e auto-controlável. Especialmente para processos criativos, dados sensíveis ou fluxos de trabalho recorrentes, uma solução local é frequentemente a opção mais sustentável e segura.

Qualquer pessoa que trabalhe com um Mac - especialmente com o Apple Silicon (M1, M2, M3 ou M4) - pode agora encontrar ferramentas incrivelmente poderosas para executar os seus próprios modelos linguísticos diretamente no dispositivo. No centro de tudo isto está um novo componente, em grande parte desconhecido: MLX, uma estrutura de aprendizagem automática desenvolvida pelo Apple que irá provavelmente desempenhar um papel cada vez mais central no ecossistema de IA da empresa nos próximos anos.

RAG com Ollama e Qdrant como motor de pesquisa universal para dados próprios

Num mundo de informação cada vez mais confuso, é cada vez mais importante tornar as suas próprias bases de dados pesquisáveis de forma direcionada - não através de pesquisas clássicas de texto integral, mas através de respostas semanticamente relevantes. É exatamente aqui que entra em jogo o princípio da base de dados RAG - uma solução de pesquisa apoiada por IA que consiste em dois componentes centrais:

Ollama encontra Qdrant: Uma memória local para a sua IA no Mac

IA local com memória - sem nuvem, sem subscrição, sem desvios

Num artigos anteriores Expliquei como configurar o Ollama no Mac install. Se já tiver concluído este passo, tem agora um modelo de língua local poderoso - como o Mistral, LLaMA3 ou outro modelo compatível que pode ser abordado através da API REST.

No entanto, o modelo apenas "sabe" o que está no prompt atual. Não se lembra de conversas anteriores. O que falta é uma memória.

IA local no Mac: Como installerceirizar um modelo de linguagem com o Ollama

A IA local no Mac há muito que é prática - especialmente nos computadores Apple-Silicon (série M). Com o Ollama obtém-se um ambiente de execução simples para muitos modelos de linguagem de código aberto (por exemplo, Llama 3.1/3.2, Mistral, Gemma, Qwen). A versão atual do Ollama vem agora também com uma aplicação de fácil utilização que lhe permite configurar um modelo linguístico local no seu Mac com um simples clique do rato. Neste artigo, encontrará um guia pragmático desde a instalação até ao primeiro aviso - com dicas práticas sobre os pontos onde tradicionalmente as coisas tendem a correr mal.