Il y a quelques années encore, l'intelligence artificielle était un sujet réservé aux instituts de recherche et aux grands groupes. On parlait de réseaux neuronaux, de deep learning ou de reconnaissance vocale - mais au quotidien, cela ne jouait pratiquement aucun rôle. Aujourd'hui, l'IA n'est plus un sujet d'avenir, mais une réalité : elle écrit des textes, crée des images, analyse des données et gère des processus de production. Que ce soit dans l'administration, l'artisanat ou l'industrie, elle apparaît désormais partout.

Modèle linguistique

Articles sur les modèles linguistiques et leurs possibilités d'utilisation. Il y est question de GPT, LLaMA, Mistral et d'autres LLM - des bases aux applications pratiques.

gFM-Business et l'avenir de l'ERP : l'intelligence locale plutôt que la dépendance au cloud

Depuis plus d'une décennie, le logiciel gFM-Business représente une particularité sur le marché allemand des ERP : il n'est pas basé sur un système lourd et difficile à maintenir, mais sur la plateforme FileMaker, légère, adaptable et modélisée visuellement. Cela présente de nombreux avantages : gFM-Business peut être étendu individuellement, fonctionne sur Windows, macOS et iOS, et peut être adapté aussi bien par les développeurs que par les power users ambitieux.

Avec l'avènement de l'intelligence artificielle (IA) - notamment grâce à des modèles dits linguistiques comme ChatGPT - de nouvelles opportunités apparaissent désormais, qui vont bien au-delà de l'automatisation classique. gFM-Business se prépare activement à cet avenir : avec l'objectif de ne pas seulement gérer des données, mais aussi d'exploiter des connaissances.

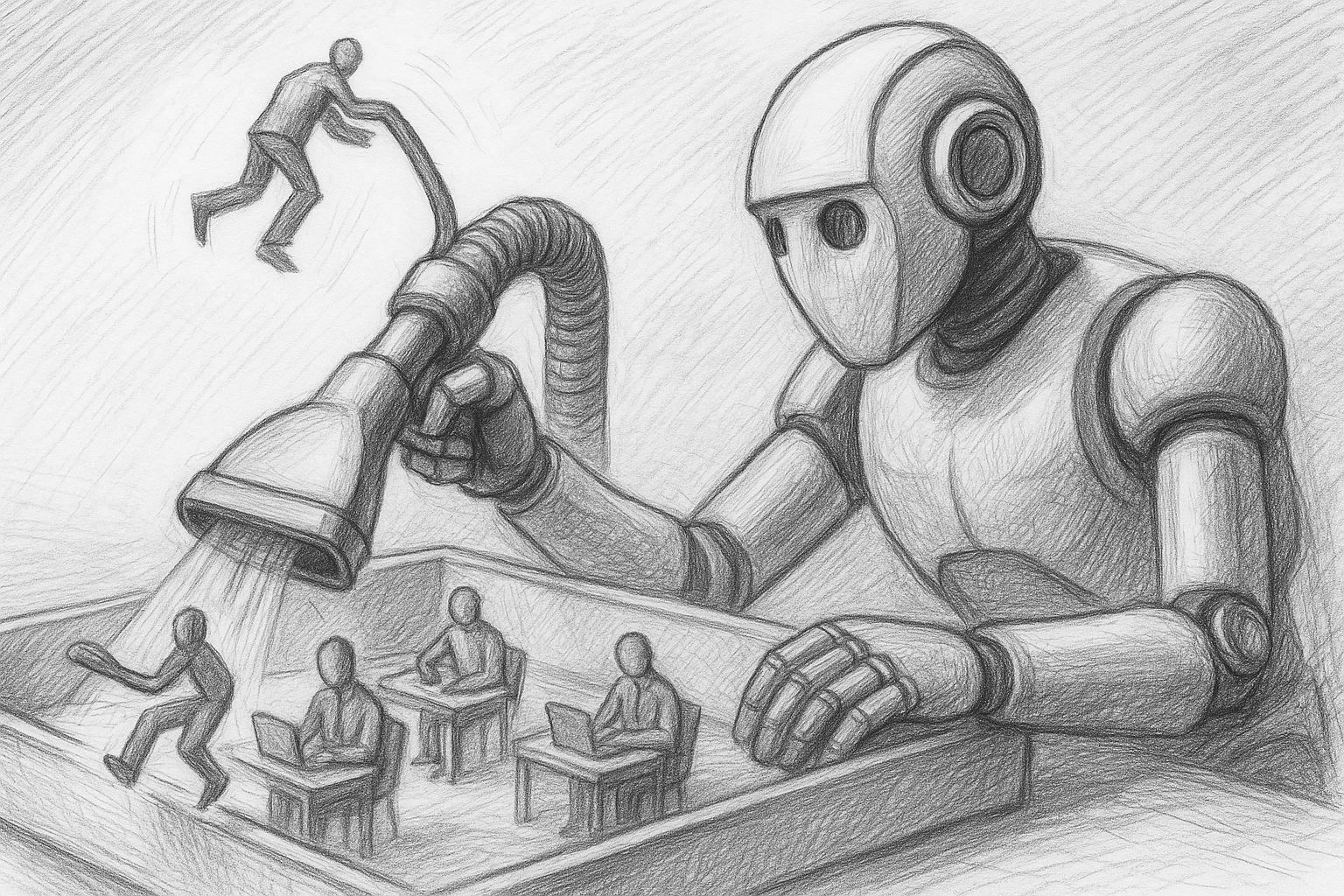

Intelligence artificielle : quels sont les emplois menacés et comment s'armer dès maintenant ?

Peu de changements technologiques se sont insinués aussi rapidement dans notre quotidien que l'intelligence artificielle. Ce qui était hier encore considéré comme une technologie d'avenir visionnaire est aujourd'hui déjà une réalité - qu'il s'agisse de rédiger des textes, de programmer, de diagnostiquer, de traduire ou même de créer de la musique, de l'art ou des documents juridiques.

Intégration de MLX dans FileMaker 2025 : l'IA locale comme nouveau standard

Alors que MLX a été initialement lancé en tant que cadre expérimental par Apple Research, une évolution silencieuse mais significative s'est produite ces derniers mois : Avec la sortie de FileMaker 2025, Claris a intégré MLX en tant qu'infrastructure d'IA native pour Apple Silicon de manière permanente dans le serveur. Cela signifie que ceux qui travaillent avec un Mac et misent sur Apple Silicon peuvent non seulement exécuter des modèles MLX en local, mais aussi les utiliser directement dans FileMaker - avec des fonctions natives, sans aucune couche intermédiaire.

MLX sur Apple Silicon comme IA locale comparée à Ollama & Co.

À une époque où les services d'IA centralisés tels que ChatGPT, Claude ou Gemini font la une des journaux, le besoin d'une contrepartie - une infrastructure d'IA locale et contrôlable par l'utilisateur - se fait de plus en plus sentir chez de nombreux utilisateurs professionnels. Une solution locale est souvent l'option la plus durable et la plus sûre, en particulier pour les processus créatifs, les données sensibles ou les flux de travail répétitifs.

Quiconque travaille avec un Mac - en particulier avec Apple Silicon (M1, M2, M3 ou M4) - trouve aujourd'hui des outils étonnamment performants pour exploiter ses propres modèles de voix directement sur l'appareil. Au centre de ces outils se trouve un nouveau composant largement inconnu : MLX, un framework d'apprentissage automatique développé par Apple, qui devrait jouer un rôle de plus en plus central dans l'écosystème d'IA de l'entreprise au cours des prochaines années.

Ollama rencontre Qdrant : une mémoire locale pour ton IA sur Mac

IA locale avec mémoire - sans cloud, sans abonnement, sans détour

Dans un article précédent j'ai expliqué comment utiliser Ollama sur Mac install. Ceux qui ont déjà franchi cette étape disposent maintenant d'un modèle de langage local performant - par exemple Mistral, LLaMA3 ou un autre modèle compatible auquel il est possible de s'adresser via l'API REST.

Mais de lui-même, le modèle ne "sait" que ce qui est écrit dans le prompt actuel. Il ne se souvient pas des conversations précédentes. Ce qui manque, c'est la mémoire.

IA locale sur Mac : comment 1TP12Créer un modèle linguistique avec Ollama

L'IA locale sur Mac est depuis longtemps une réalité, en particulier sur les ordinateurs Apple-Silicon (série M). Avec Ollama, vous obtenez un environnement d'exécution léger pour de nombreux modèles de langage open source (par ex. Llama 3.1/3.2, Mistral, Gemma, Qwen). La version actuelle de Ollama est désormais accompagnée d'une application conviviale qui vous permet de configurer un modèle de langage local sur votre Mac d'un simple clic de souris. Dans cet article, vous trouverez un guide pragmatique de l'installation jusqu'à la première invite - avec des conseils tirés de la pratique, où les choses ont traditionnellement tendance à mal tourner.