Noch vor wenigen Jahren war Künstliche Intelligenz ein Thema für Forschungseinrichtungen und große Konzerne. Man sprach über neuronale Netze, Deep Learning oder Spracherkennung – aber im Alltag spielte das kaum eine Rolle. Heute ist KI kein Zukunftsthema mehr, sondern Realität: Sie schreibt Texte, erstellt Bilder, analysiert Daten und steuert Produktionsprozesse. Ob in Verwaltung, Handwerk oder Industrie – überall taucht sie inzwischen auf.

Künstliche Intelligenz

Künstliche Intelligenz beschreibt den Versuch, Maschinen das Denken beizubringen – nicht im Sinne eines Bewusstseins, sondern als Fähigkeit, Muster zu erkennen, Entscheidungen zu treffen und komplexe Aufgaben zu bewältigen. Von Sprachmodellen über Bilderzeugung bis hin zu autonomen Systemen verändert KI heute nahezu jede Branche und eröffnet Möglichkeiten, die vor wenigen Jahren noch als Science-Fiction galten. Gleichzeitig wirft sie Fragen auf: Wie zuverlässig sind solche Systeme? Wo liegen ihre Grenzen? Und wie wirken sie sich auf Gesellschaft, Wirtschaft und persönliche Freiheit aus? Dieses Schlagwort bündelt Hintergründe, Entwicklungen und praktische Anwendungen der Künstlichen Intelligenz – verständlich erklärt und kritisch eingeordnet.

gFM-Business und die Zukunft des ERP: Lokale Intelligenz statt Cloud-Abhängigkeit

Seit über einem Jahrzehnt steht die Software gFM-Business für eine Besonderheit im deutschen ERP-Markt: Sie basiert nicht auf einem schwerfälligen, schwer wartbaren System, sondern auf der leichtgewichtigen, anpassbaren und visuell modellierten FileMaker-Plattform. Das hat viele Vorteile: gFM-Business lässt sich individuell erweitern, ist auf Windows, macOS und iOS lauffähig, und kann sowohl von Entwicklern als auch von ambitionierten Power-Usern angepasst werden.

Mit dem Aufkommen der künstlichen Intelligenz (KI) – insbesondere durch sogenannte Sprachmodelle wie ChatGPT – entstehen nun neue Chancen, die weit über klassische Automatisierung hinausgehen. gFM-Business bereitet sich aktiv auf diese Zukunft vor: mit dem Ziel, nicht nur Daten zu verwalten, sondern Wissen zu erschließen.

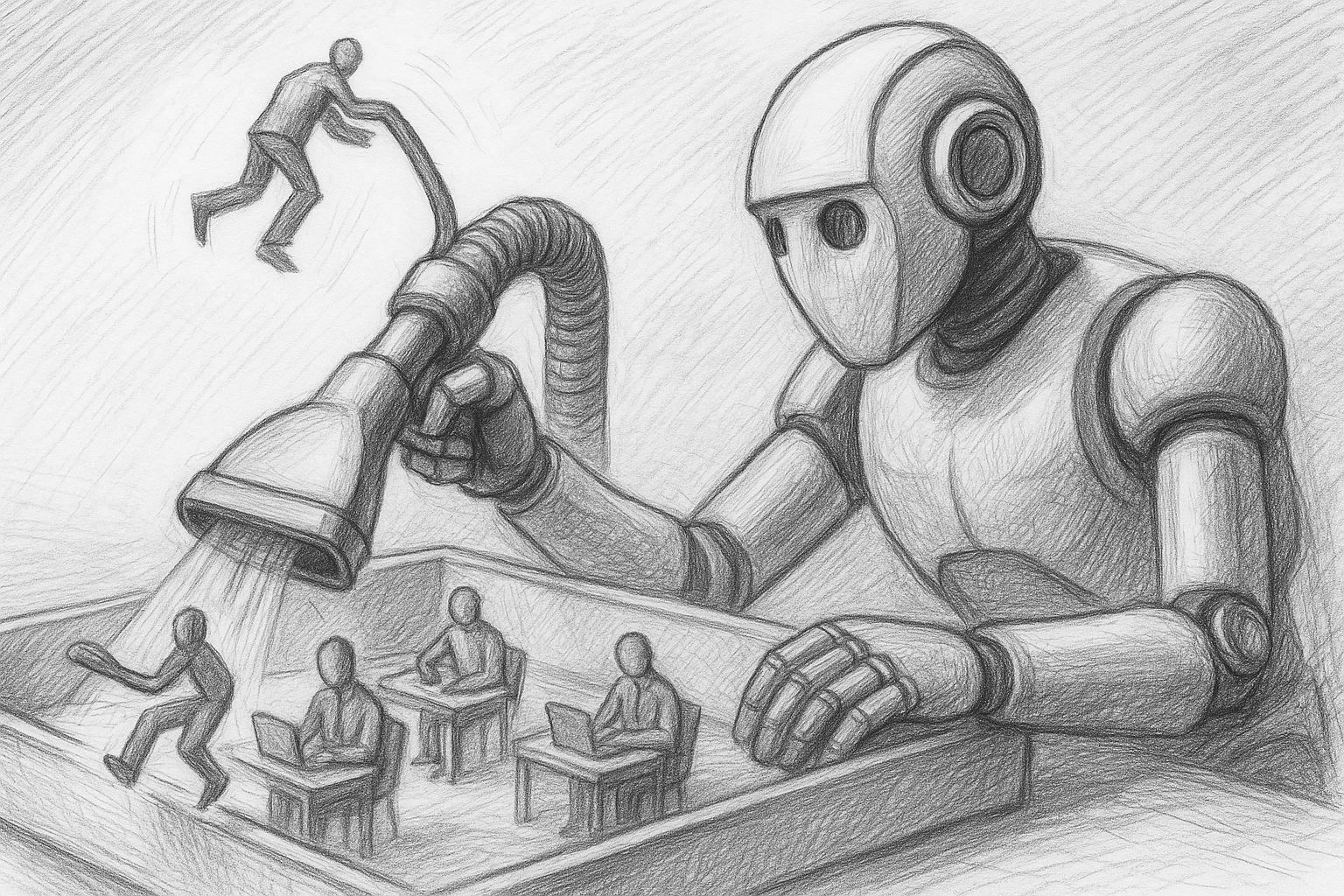

Künstliche Intelligenz: Welche Jobs in Gefahr sind, und wie wir uns jetzt wappnen können

Kaum ein technologischer Wandel hat sich so schnell in unseren Alltag eingeschlichen wie die künstliche Intelligenz. Was gestern noch als visionäre Zukunftstechnologie galt, ist heute bereits Realität – ob beim Texten, Programmieren, Diagnostizieren, Übersetzen oder sogar beim Erstellen von Musik, Kunst oder juristischen Schriftsätzen.

FileMaker-Konferenz 2025: KI, Community und ein unerwarteter Vorfall

Die FileMaker-Konferenz 2025 in Hamburg ist vorbei – und sie war in vielerlei Hinsicht ein besonderer Meilenstein. Nicht nur, weil sich in diesem Jahr viele Themen rund um Künstliche Intelligenz, Performance und moderne Workflows konzentrierten – sondern auch, weil der persönliche Austausch und das „Familiäre“ der FileMaker-Community wieder voll zum Tragen kam. Für mich persönlich war es eine intensive, inspirierende und rundum bereichernde Zeit – und das bereits ab dem ersten Abend.

MLX auf Apple Silicon als lokale KI im Vergleich mit Ollama & Co.

In einer Zeit, in der zentrale KI-Dienste wie ChatGPT, Claude oder Gemini die Schlagzeilen beherrschen, wächst bei vielen professionellen Anwendern das Bedürfnis nach einem Gegenpol – einer lokalen, selbst kontrollierbaren KI-Infrastruktur. Gerade für kreative Prozesse, sensible Daten oder wiederkehrende Arbeitsabläufe ist eine lokale Lösung oft die nachhaltigere und sicherere Option.

Wer mit einem Mac arbeitet – insbesondere mit Apple Silicon (M1, M2, M3 oder M4) – findet mittlerweile erstaunlich leistungsfähige Tools, um eigene Sprachmodelle direkt auf dem Gerät zu betreiben. Im Zentrum steht dabei eine neue, weitgehend unbekannte Komponente: MLX, ein von Apple entwickeltes Machine-Learning-Framework, das in den kommenden Jahren eine zunehmend zentrale Rolle im KI-Ökosystem des Unternehmens spielen dürfte.

RAG mit Ollama und Qdrant als universelle Suchmaschine für eigene Daten

In einer zunehmend unübersichtlichen Informationswelt wird es immer wichtiger, eigene Datenbestände gezielt durchsuchbar zu machen – nicht über klassische Volltextsuche, sondern durch semantisch relevante Antworten. Genau hier kommt das Prinzip der RAG-Datenbank ins Spiel – also einer KI-gestützten Suchlösung, die sich aus zwei zentralen Komponenten zusammensetzt:

Ollama trifft Qdrant: Ein lokales Gedächtnis für Deine KI auf dem Mac

Lokale KI mit Erinnerungsvermögen – ohne Cloud, ohne Abo, ohne Umweg

In einem früheren Artikel habe ich erklärt, wie man Ollama auf dem Mac installiert. Wer diesen Schritt bereits hinter sich hat, verfügt nun über ein leistungsfähiges lokales Sprachmodell – etwa Mistral, LLaMA3 oder ein anderes kompatibles Modell, das per REST-API ansprechbar ist.

Doch von allein „weiß“ das Modell nur das, was im aktuellen Prompt steht. Es erinnert sich nicht an frühere Konversationen. Was fehlt, ist ein Gedächtnis.

Lokale KI auf dem Mac: So installieren Sie ein Sprachmodell mit Ollama

Lokale KI auf dem Mac ist längst praxistauglich – vor allem auf Apple-Silicon-Rechnern (M-Serie). Mit Ollama holen Sie sich eine schlanke Laufzeitumgebung für viele Open-Source-Sprachmodelle (z. B. Llama 3.1/3.2, Mistral, Gemma, Qwen). Mit der aktuellen Ollama-Version wird nun auch eine benutzerfreundliche App geliefert, mit der Sie per Mausklick ein lokales Sprachmodell auf Ihrem Mac einrichten können. In diesem Artikel finden Sie eine pragmatische Anleitung von der Installation bis zum ersten Prompt – mit Hinweisen aus der Praxis, wo Dinge traditionell gern schiefgehen.