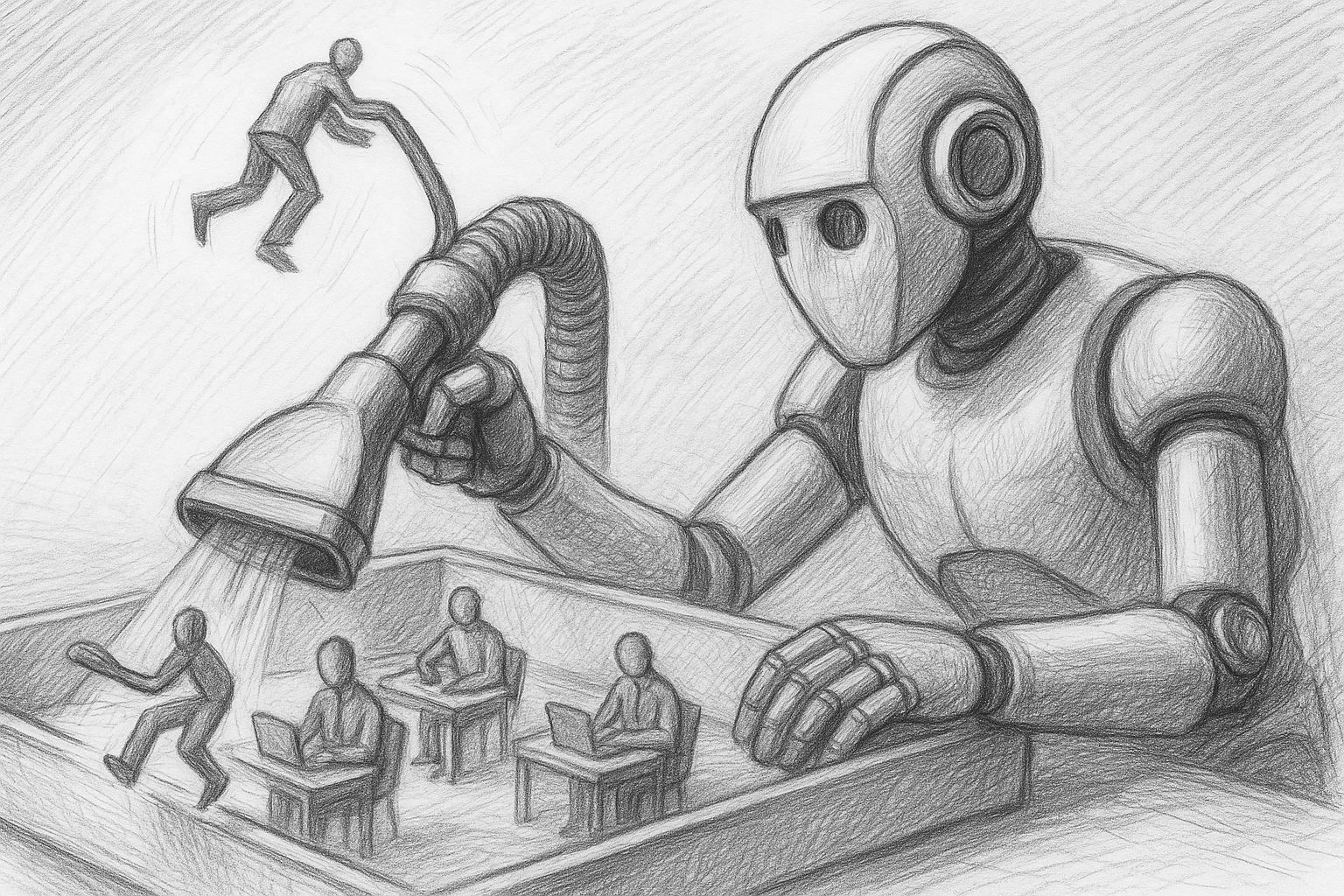

Každý, kdo se dnes zabývá tématem umělé inteligence, se téměř nevyhnutelně setkává se zvláštním pocitem: neustálým neklidem. Sotva si zvyknete na jeden nástroj, objeví se deset dalších. Na YouTube následuje jedno video za druhým: „Tento nástroj AI mění vše“, „Tohle musíte bezpodmínečně použít hned“, „Kdo chybí, zůstává pozadu“. A pokaždé podprahově zazní stejné poselství: Je pozdě. Ostatní jsou dál. Musíte je dohnat.

To se netýká jen lidí z IT. Tlak pociťují i osoby samostatně výdělečně činné, kreativní profesionálové, podnikatelé a běžní zaměstnanci. Mnozí ani přesně nevědí, co tyto nástroje vlastně dělají - ale mají pocit, že by mohli o něco přijít. A to je přesně to, co způsobuje stres.