In einer zunehmend digitalisierten Welt verbringen wir viel Zeit online: Beim Chatten, Einkaufen, Arbeiten, Informieren. Gleichzeitig verändern sich die Regeln dafür, wie Inhalte geteilt, moderiert oder kontrolliert werden. Die Digital Services Act (DSA), der European Media Freedom Act (EMFA), der geplante Regulation to Prevent and Combat Child Sexual Abuse (CSAR, oft „Chatcontrol“ genannt) und der AI Act sind zentrale Gesetzesvorhaben der Europäische Union (EU), mit denen sie das digitale Umfeld regulieren will.

Diese Regelwerke mögen auf den ersten Blick weit entfernt erscheinen – aber sie haben Auswirkungen auf dich als Privatperson und auch auf kleine oder mittlere Unternehmen. Dieser Artikel begleitet Dich Schritt für Schritt: von der Frage „Was ist hier geplant?“ über die Hintergründe und Zeitachsen bis hin zum Perspektivwechsel: Was bedeutet das konkret für Dich im Alltag?

Im ersten Teil schauen wir uns an, was überhaupt geplant ist, welche großen Gesetzesvorhaben derzeit diskutiert oder bereits beschlossen wurden und mit welcher Begründung sie ins Leben gerufen wurden.

Aktuelle News zu geplanten EU-Zensurgesetzen

27.11.2025 – Die EU-Staaten haben sich laut Tagesschau nach langen Auseinandersetzungen darauf geeinigt, keine verpflichtende Chatkontrolle einzuführen. Dienste wie WhatsApp oder Signal müssen ihre Nachrichten vorerst nicht automatisch auf Darstellungen sexualisierter Gewalt an Kindern scannen. Der ursprüngliche Plan scheiterte unter anderem am deutlichen Widerstand Deutschlands. Stattdessen setzt die EU nun auf freiwillige Maßnahmen der Anbieter. Eine bisher befristete Ausnahme, die freiwillige Scans trotz Datenschutzregeln erlaubt, soll dauerhaft verankert werden. Nach drei Jahren will die EU-Kommission prüfen, ob doch eine Pflicht nötig wäre. Die Plattformen sollen laut Entwurf dennoch Risiken für Kinder aktiv reduzieren, etwa durch zuverlässige Altersprüfung. Außerdem ist ein neues EU-Zentrum gegen Kindesmissbrauch geplant, das nationalen Behörden zuarbeiten soll. Bevor die Regelungen in Kraft treten, müssen sich EU-Ministerrat und Europäisches Parlament noch auf eine gemeinsame Fassung des Gesetzes verständigen.

In der Berliner Zeitung ist kurze Zeit später allerdings ein kritischer Bericht dazu erschienen, der die Formulierung der Tagesschau und die „Freiwilligkeit“ der Chatkontrolle in Frage stellt. Patrick Breyer, Digitalfreiheitsaktivist, kritisiert in dem Bericht den freiwilligen Ansatz und warnt die Öffentlichkeit, sich von der Bezeichnung „freiwillig“ täuschen zu lassen.

24.11.2025 – Ein Artikel der Berliner Zeitung berichtet, dass die Regulation to Prevent and Combat Child Sexual Abuse (CSAR)-Initiative – oft als „Chatcontrol“ bezeichnet – in der Europäische Union laut Insider-Angaben ohne öffentliche Debatte durchgewunken werden soll. Obwohl die explizite Pflicht zum Scannen von Chats offiziell gestrichen wurde, enthält der neue Entwurf ein Schlupfloch: Anbieter sollen weiterhin „angemessene Risikominderungsmaßnahmen“ umsetzen, was faktisch automatisiertes Scannen bedeuten könnte. Kritiker warnen, dass damit die Ende-zu-Ende-Verschlüsselung ausgehöhlt und private Kommunikation künftig automatisch durchsuchbar wird.

Was die EU gerade plant: eine einfache Übersicht

In den letzten Jahren hat die EU erkannt: Das Internet verändert sich rasant. Plattformen mit Millionen oder Milliarden Nutzern, Künstliche Intelligenz, neue Formen der Kommunikation – viele Rechtsrahmen stammen noch aus früheren Jahrzehnten. Die EU sieht hier großen Nachholbedarf: sie will den digitalen Raum sicherer machen, die Grundrechte schützen und faire Bedingungen schaffen – sowohl für Nutzer als auch für Unternehmen. Zum Beispiel heißt es zur DSA:

„Ziel ist, einen sichereren digitalen Raum zu schaffen, in dem die Grundrechte aller Nutzer digitaler Dienste geschützt sind.“

Weil mehrere Gesetzesvorhaben parallel aufgesetzt wurden, entsteht der Eindruck: „Jetzt wird vieles zugleich reguliert“ – und das erzeugt Unsicherheit, gerade für Menschen, die sich nicht täglich mit Digital-Recht beschäftigen.

Die großen Ziele laut EU

Die wichtigsten Ziele dieser Gesetzespakete lassen sich folgendermaßen zusammenfassen:

- Schutz vor Missbrauch: Zum Beispiel will die EU mit dem CSAR-Entwurf dafür sorgen, dass Darstellungen sexuellen Missbrauchs von Kindern (CSAM) im Netz schneller erkannt und gelöscht werden.

- Schutz vor Desinformation, Wahlbeeinflussung und gesellschaftlichen Risiken: Bei der DSA heißt es ausdrücklich, dass sie u. a. dazu dienen soll, die Ausbreitung illegaler Inhalte und anderer Risiken zu begrenzen.

- Medienpluralismus, Transparenz und faire Wettbewerbsbedingungen: Mit dem EMFA bemüht sich die EU um eine stärkere Regulierung der Medienlandschaft, um Einflussnahme und Konzentration zu begrenzen.

- Regeln für Künstliche Intelligenz und Kennzeichnungspflichten: Der AI Act soll künftig dafür sorgen, dass KI-Systeme und ihre Inhalte transparent sind – etwa bei Deepfakes oder automatisierten Entscheidungen.

- Faire Bedingungen für Unternehmen: Neben dem Schutz der Nutzer will die EU auch Klarheit und gleiche Spielregeln für Anbieter schaffen (z. B. Plattformen). Bei der DSA ist ein Ziel: „einheitliches Regelwerk und Wettbewerbsbedingungen für Unternehmen“.

Wo stehen wir heute?

Der Stand der Dinge lässt sich wie folgt zusammenfassen:

- Bei der DSA: Das Regelwerk wurde bereits verabschiedet, es gilt in Teilen seit 2022. Anbieter mit sehr vielen Nutzern („Very Large Online Platforms“) unterliegen seit 2023/24 besonders strengen Regeln.

- Beim CSAR („Chatcontrol“): Der Vorschlag wurde von der EU-Kommission im Jahr 2022 vorgelegt. Jedoch: Viele Mitgliedstaaten sowie Datenschutz- und Freiheitsrechtsorganisationen üben starke Kritik. Es ist also noch nicht abgeschlossen.

- Beim EMFA und AI Act: Der EMFA wurde formell beschlossen und soll ab bestimmten Zeitpunkten gelten. Der AI Act ist in Kraft, aber viele Pflichten greifen gestaffelt.

Wichtig: Auch wenn Gesetze beschlossen wurden, bedeutet das nicht, dass alle Vorgaben sofort gelten – oft gibt es Übergangsfristen, Ausnahmen oder technische Umsetzungen, die noch offen sind. In diesem ersten Teil haben wir somit herausgearbeitet, welche Regelwerke im Spiel sind, was die EU damit bezweckt und wo wir aktuell stehen. Im nächsten Kapitel werden wir gezielt auf die einzelnen großen Gesetze eingehen – in einfachen Worten, damit klar wird: „Was ist das genau?“

Aktuelle Umfrage zur geplanten digitalen EU-ID

Chat Control / CSAR – Überwachung privater Kommunikation

Im Jahr 2022 legte die Regulation to Prevent and Combat Child Sexual Abuse (CSAR) der EU‑Kommission den Vorschlag vor, der von vielen als „Chat Control“ bezeichnet wird. Der Kern: Anbieter von Messenger‑Diensten, Chat‑Plattformen oder anderen digitalen Kommunikationsdiensten sollen verpflichtet werden, nach Inhalten sexuellen Missbrauchs von Kindern (CSAM) zu suchen, diese zu melden und zu löschen.

Die Idee dahinter ist nachvollziehbar: Missbrauchsmaterial im Netz ist ein schwerwiegendes Problem, und nationale Gesetze allein greifen nicht immer – die EU sieht hier einen einheitlichen Regelbedarf.

Doch genau hier beginnt die Kontroverse: Denn der Vorschlag sieht in manchen Varianten vor, dass Kommunikation durchsucht wird, auch wenn sie Ende‑zu‑Ende verschlüsselt ist. Das heißt im Alltag: Ihre privaten Chats, Bilder oder Videos könnten technisch analysiert werden – bevor der Nachrichtendienst sie verschlüsselt oder weiterleitet. Kritiker sprechen von einer massenhaften Überwachung.

Die Technik ist anspruchsvoll und risikoreich: Wie erkennt man wirklich sicher Missbrauchsmaterial, ohne Fehldiagnosen zu riskieren? Wie gewährleistet man Datenschutz und Verschlüsselung? Eine Studie zeigt, dass Fehlalarme („false positives“) insbesondere bei client‑side scanning hoch sein können.

Kurz gesagt: Der Vorschlag verbindet legitimen Schutzauftrag mit erheblichen Grundrechtsrisiken. Für den Bürger heißt das: Private Kommunikation könnte künftig stärker kontrolliert werden – auch wenn Sie nichts mit Missbrauch zu tun haben. Für den kleinen Betrieb bedeutet das: Wenn Sie Messenger‑Kanäle oder Kundenkommunikation betreiben, müssten Sie sich darauf einstellen, dass neue gesetzliche Pflichten oder technische Prüfungen anstehen könnten.

| Aspekt | Beschreibung |

|---|---|

| Name | Regulation to Prevent and Combat Child Sexual Abuse (CSAR), umgangssprachlich „Chatcontrol“ |

| Hauptziel laut EU | Online-Verbreitung von Darstellungen sexuellen Missbrauchs von Kindern (CSAM) verhindern, melden und löschen; Aufbau eines EU-Zentrums für Meldungen. |

| Wen betrifft es primär? | Anbieter von Kommunikationsdiensten (Messenger, Chats, Hosting-Plattformen, Cloud-Dienste), teils auch Anbieter verschlüsselter Kommunikation. |

| Zentrale Instrumente | – (Teilweise) Scannen von Inhalten auf bekannte Missbrauchsmuster – Meldepflichten an Behörden/EU-Zentrum – Verpflichtende oder „freiwillige“ Überwachungsmaßnahmen je nach Risikoeinstufung |

| Aktueller Stand | – Verordnungsvorschlag seit 2022 in Verhandlung – Starker Widerstand mehrerer Mitgliedstaaten und Bürgerrechtsorganisationen – Kompromisstexte mit „freiwilligem“ Scannen in Diskussion |

| Argumente der Befürworter | – Ohne einheitliche EU-Regeln könne CSAM nicht wirksam bekämpft werden – Anbieter müssen Verantwortung übernehmen – Technische Mittel seien notwendig, um Täter aufzuspüren |

| Argumente der Kritiker | – Gefahr flächendeckender Überwachung aller Bürger – Schwächung von Ende-zu-Ende-Verschlüsselung („Client-Side-Scanning“) – Hohe Zahl möglicher Fehlalarme und falscher Verdächtigungen – Schaffung einer dauerhaften Überwachungsinfrastruktur, die politisch erweiterbar ist |

| Konsequenzen für Bürger | – Private Kommunikation könnte (teil-)automatisiert geprüft werden – Verunsicherung bei sensiblen Inhalten (Fotos, Dokumente, Chats) – Risiko falscher Verdächtigungen und Datenspeicherung |

| Konsequenzen für KMU | – Kundenkommunikation über gescannte Dienste ist nicht mehr vollständig privat – Mögliche Konflikte mit Datenschutz und Geschäftsgeheimnissen – Anpassungsbedarf bei Auswahl und Nutzung von Kommunikationskanälen |

Digital Services Act (DSA) – Regeln für Plattformen und ihre Löschpflichten

Mit dem Digital Services Act (DSA) hat die EU ein umfassendes Regelwerk geschaffen, das bereits 2022 verabschiedet wurde. Es richtet sich vor allem an digitale Dienste – Hosting‑Anbieter, Plattformen, Suchmaschinen –, mit dem Ziel, das Internet sicherer, transparenter und fairer zu machen. Zu den wichtigsten Pflichten zählen:

- Anbieter müssen Melde‑ und Abhilfesysteme einrichten, mit denen Nutzer illegale Inhalte (z. B. Hassrede, Terrorpropaganda, Betrug) melden können.

- Plattformen müssen darauf reagieren, also Inhalte löschen oder den Zugang sperren, wenn sie Kenntnis von illegalen Inhalten erlangen.

- Für „sehr große“ Plattformen (z. B. über 45 Mio. EU‑Nutzer) gelten entweder stärkere Anforderungen: Risikoanalysen, Auditierung der Empfehlungsalgorithmen, Offenlegung von Moderationspraktiken.

- Transparenzpflichten: Nutzer sollen besser verstehen, warum Inhalte gelöscht oder gesperrt wurden; Plattformen müssen darüber berichten.

Für den Alltag eines Menschen heißt das: Wenn Sie Beiträge auf Plattformen posten – etwa auf sozialen Netzwerken oder Foren – gilt künftig, dass Plattformen strenger entscheiden müssen. Im Zweifel könnten Inhalte schneller entfernt werden.

Für ein kleines Unternehmen heißt das: Wenn Ihre Webseite, Ihr Forum oder Ihre Plattform interaktive Nutzerbeiträge hat, müssen Sie die Nutzungsbedingungen, Meldeverfahren und Löschprozesse genau prüfen. Auch wenn Sie nicht zu den ganz großen Plattformen gehören, kann indirekter Druck entstehen, vor allem durch Vorgaben, wie Nutzer vor schädlichen Inhalten geschützt werden sollen.

| Aspekt | Beschreibung |

|---|---|

| Name | Digital Services Act (DSA) – Verordnung (EU) 2022/2065 |

| Hauptziel laut EU | – Sicherer digitaler Raum für Nutzer – Schutz der Grundrechte online – Einheitliches Regelwerk für digitale Dienste in der EU |

| Wen betrifft es primär? | – Vermittlungsdienste (Access, Caching, Hosting) – Online-Plattformen und Marktplätze – „Very Large Online Platforms“ (VLOPs) und Suchmaschinen ab 45 Mio. EU-Nutzern |

| Zentrale Pflichten | – Meldewege für illegale Inhalte – Pflicht zur schnellen Entfernung nach Kenntnis – Transparenzberichte über Moderation – Risikoanalysen und Audits für sehr große Plattformen – Kooperation mit „trusted flaggers“ |

| Aktueller Stand | – In Kraft, für große Plattformen bereits voll wirksam – Kommission führt Verfahren gegen einzelne Anbieter (z. B. wegen mangelhafter Moderation) |

| Argumente der Befürworter | – Plattformen übernehmen Verantwortung für Risiken ihrer Dienste – Mehr Transparenz über Lösch- und Empfehlungspraktiken – Besserer Schutz vor Hass, Betrug, Desinformation und illegalen Angeboten |

| Argumente der Kritiker | – Gefahr des „Overblocking“ (zu viel wird gelöscht, um Strafen zu vermeiden) – De facto-Privatisierung der Zensur: Plattformen entscheiden, was sichtbar bleibt – Dehnbare Begriffe wie „Systemrisiken“; politisch sensibler Inhalt kann ausgedünnt werden |

| Konsequenzen für Bürger | – Beiträge können schneller gesperrt oder unsichtbar werden – Mehr formale Wege, Entscheidungen anzufechten – aber hoher Aufwand – Filterblasen werden nicht unbedingt kleiner, der Eingriff erfolgt eher „von oben“ |

| Konsequenzen für KMU | – Marketing und Sichtbarkeit hängen noch stärker vom Plattform-Algorithmus ab – Inhalte zu sensiblen Themen (Gesundheit, Politik, Gesellschaft) sind eher löschgefährdet – Eigene Kommentarbereiche erfordern mehr Moderationsaufwand und klare Regeln |

European Media Freedom Act (EMFA) – das neue Mediengesetz

Das European Media Freedom Act (EMFA) trat bereits am 7. Mai 2024 formell in Kraft und gilt vollständig ab dem 8. August 2025. Sein Anliegen: Die EU möchte die Unabhängigkeit und Vielfalt der Medien sichern – also Verlagshäuser, Rundfunkanstalten, Online‑Medien –, und zugleich neue Regeln schaffen für die Zusammenarbeit zwischen Medien und Plattformen. Wichtige Inhalte:

- Schutz der redaktionellen Unabhängigkeit und der journalistischen Quellen.

- Transparenz über Medieneigentümer‑Strukturen, damit klar wird, wer hinter einem Medium steht.

- Regulierung von staatlicher Werbung und wie Regierungen Medien über Anzeigen beeinflussen können.

Ein besonderes Merkmal: Medien‑Dienstleister sollen gegenüber Plattformen geschützt sein, etwa damit ihre Inhalte nicht einfach von großen Plattformen beliebig unterdrückt werden.

Für den Nutzer heißt das: Theoretisch könnte eine stärkere Vielfalt an Meinungen und Medienquellen entstehen, mit klarer Kennzeichnung und besseren Bedingungen für Qualitätsmedien. Allerdings entsteht auch eine neue Prüfungsebene – Plattformen müssen künftig bei «anerkannten Medien» besondere Sorgfalt walten lassen.

Für ein kleines Unternehmen, das Inhalte veröffentlicht (z. B. Blog, Newsletter oder Online‑Magazin), heißt das: Sie geraten in eine veränderte Ordnung, in der Ihre Inhalte anders bewertet werden können – je nachdem, ob Sie als „Medium“ gelten oder nicht, und wie Plattformen mit solchen Inhalten umgehen.

| Aspekt | Beschreibung |

|---|---|

| Name | European Media Freedom Act (EMFA) – Europäisches Medienfreiheitsgesetz |

| Hauptziel laut EU | – Schutz von Medienpluralismus und redaktioneller Unabhängigkeit – Begrenzung politischer Einflussnahme auf Medien – Transparenz über Eigentümerstrukturen und staatliche Werbegelder |

| Wen betrifft es primär? | – Medienunternehmen (Print, Rundfunk, Online) – Öffentlich-rechtliche Anstalten – Plattformen im Umgang mit Medieninhalten |

| Zentrale Instrumente | – Europäisches Gremium für Mediendienste (Kooperation nationaler Regulierer) – Regeln für staatliche Werbung und Förderung – Besondere Behandlung „anerkannter Medien“ durch Plattformen (z. B. privilegierter Umgang bei Moderation) |

| Aktueller Stand | – Verabschiedet, Inkrafttreten 2024 – Geltung der wesentlichen Bestimmungen ab 2025 |

| Argumente der Befürworter | – Besserer Schutz seriöser Medien vor politischem Druck – Transparenz gegen verdeckte Einflussnahme und Medienkonzentration – Schutz redaktioneller Entscheidungen vor Eingriffen von Eigentümern oder Staaten |

| Argumente der Kritiker | – Gefahr eines „Medienprivilegs“ für staatstreue oder etablierte Anbieter – Plattformen geraten in Konflikt zwischen DSA-Löschpflichten und EMFA-Privilegien – Kleinere oder alternative Medien ohne formalen Status könnten benachteiligt werden |

| Konsequenzen für Bürger | – Sichtbare Inhalte könnten stärker von „anerkannten Medien“ geprägt sein – Abgrenzung zwischen etablierten Medien und unabhängigen Angeboten wird schärfer – Kritischere oder neue Stimmen haben es möglicherweise schwerer, Reichweite aufzubauen |

| Konsequenzen für KMU | – Eigene Inhalte (Blogs, Magazine, Newsletter) konkurrieren mit privilegierten Medienumfeldern – Kooperationen mit Medien (Werbung, Sponsored Content) werden stärker reguliert – Unternehmen, die selbst als Medium auftreten wollen, müssen zusätzliche Anforderungen beachten |

AI Act – Regeln für Künstliche Intelligenz, Deepfakes & Co.

Mit dem Artificial Intelligence Act (AI Act) hat die EU eines der weltweit ersten umfassenden Gesetzeswerke zur KI‑Regulierung geschaffen. Es ist technologieneutral konzipiert, also nicht nur für heute bekannte KI‑Systeme, sondern auch für kommende Entwicklungen. Kernmerkmal ist ein risikobasierter Ansatz: Je höher das Risiko für Grundrechte oder Sicherheit, desto strengere Pflichten. Beispiele:

- KI‑Systeme mit inakzeptablem Risiko (z. B. soziale Bewertungssysteme) können verboten werden.

- Hochrisiko‑KI (z. B. Bewerbungs‑ oder Bio‑Metrie‑Systeme) unterliegen strengen Vorgaben.

- Andere KI‑Systeme müssen gekennzeichnet werden, etwa wenn Inhalte automatisiert erzeugt wurden (z. B. Deepfakes).

Für Bürger bedeutet das: Wenn Sie künftig auf Inhalte treffen, etwa ein Video oder Text, der automatisch erstellt wurde, kann es sein, dass solche Inhalte als „KI‑generiert“ gekennzeichnet sind – damit Sie erkennen, wer oder was dahinter steckt. Für Unternehmen heißt das: Wenn Sie KI‑Werkzeuge einsetzen – z. B. im Marketing, für Dokumenten‑Produktion, Kundenservice – müssen Sie prüfen, ob Ihre Anwendung unter eine Risikokategorie fällt, ob Kennzeichnungspflichten gelten oder Auflagen erfüllt werden müssen.

| Aspekt | Beschreibung |

|---|---|

| Name | Artificial Intelligence Act (AI Act) – EU-Verordnung zur Regulierung von KI |

| Hauptziel laut EU | – Sicherstellen, dass KI-Systeme sicher und vertrauenswürdig sind – Schutz von Grundrechten und Verbrauchern – Förderung von Innovation unter klaren Spielregeln |

| Wen betrifft es primär? | – Anbieter und Betreiber von KI-Systemen (vom Start-up bis zum Großkonzern) – Anwender, die KI in Produkten oder Dienstleistungen integrieren – Speziell: Hersteller von „Hochrisiko-KI“ |

| Risikokategorien | – Verbotene KI (z. B. bestimmte Formen sozialer Bewertung) – Hochrisiko-KI (z. B. biometrische Systeme, bestimmte Entscheidungsunterstützung) – KI mit Transparenzpflichten (z. B. Chatbots, Deepfakes) – Minimalrisiko-KI (z. B. einfache Tools ohne tiefen Eingriff in Rechte) |

| Zentrale Pflichten | – Risikobewertung und Dokumentation – Kennzeichnung KI-generierter Inhalte in bestimmten Fällen – Qualitäts- und Datenanforderungen für Hochrisiko-KI – Transparenz gegenüber Nutzern (z. B. „Sie sprechen mit einer KI“) |

| Aktueller Stand | – Verabschiedet, tritt stufenweise in Kraft – Einzelne Pflichten gelten bereits, weitere folgen in Übergangsfristen |

| Argumente der Befürworter | – Schutz vor intransparenten, unfairen oder gefährlichen KI-Systemen – Vertrauensaufbau: Nutzer wissen, wann KI im Spiel ist – Mindeststandards für Qualität und Datensicherheit |

| Argumente der Kritiker | – Komplexität und Bürokratie besonders für kleine Anbieter – Unsicherheit, ob eine Anwendung „Hochrisiko“ ist oder nicht – Gefahr, dass sich Innovation und KI-Entwicklung in weniger regulierte Regionen verlagern – Hemmschwelle für KMU, KI überhaupt einzusetzen |

| Konsequenzen für Bürger | – Mehr Kennzeichnung von KI-Inhalten (Texte, Bilder, Videos) – Besserer Schutz bei automatisierten Entscheidungen, aber auch mehr Formalität – Bewussterer Umgang mit „maschinell erzeugter“ Information |

| Konsequenzen für KMU | – Notwendigkeit, KI-Einsatz (intern und extern) zu dokumentieren – Mögliche Kennzeichnungspflichten im Marketing oder Kundenkontakt – Ggf. Beratungsbedarf, um Risiken und Pflichten korrekt einzuordnen – Wer gut vorbereitet ist, kann KI dennoch als Wettbewerbsvorteil nutzen |

Eine Zeitleiste der wichtigsten Schritte

2022–2023: Die Phase der großen Vorschläge

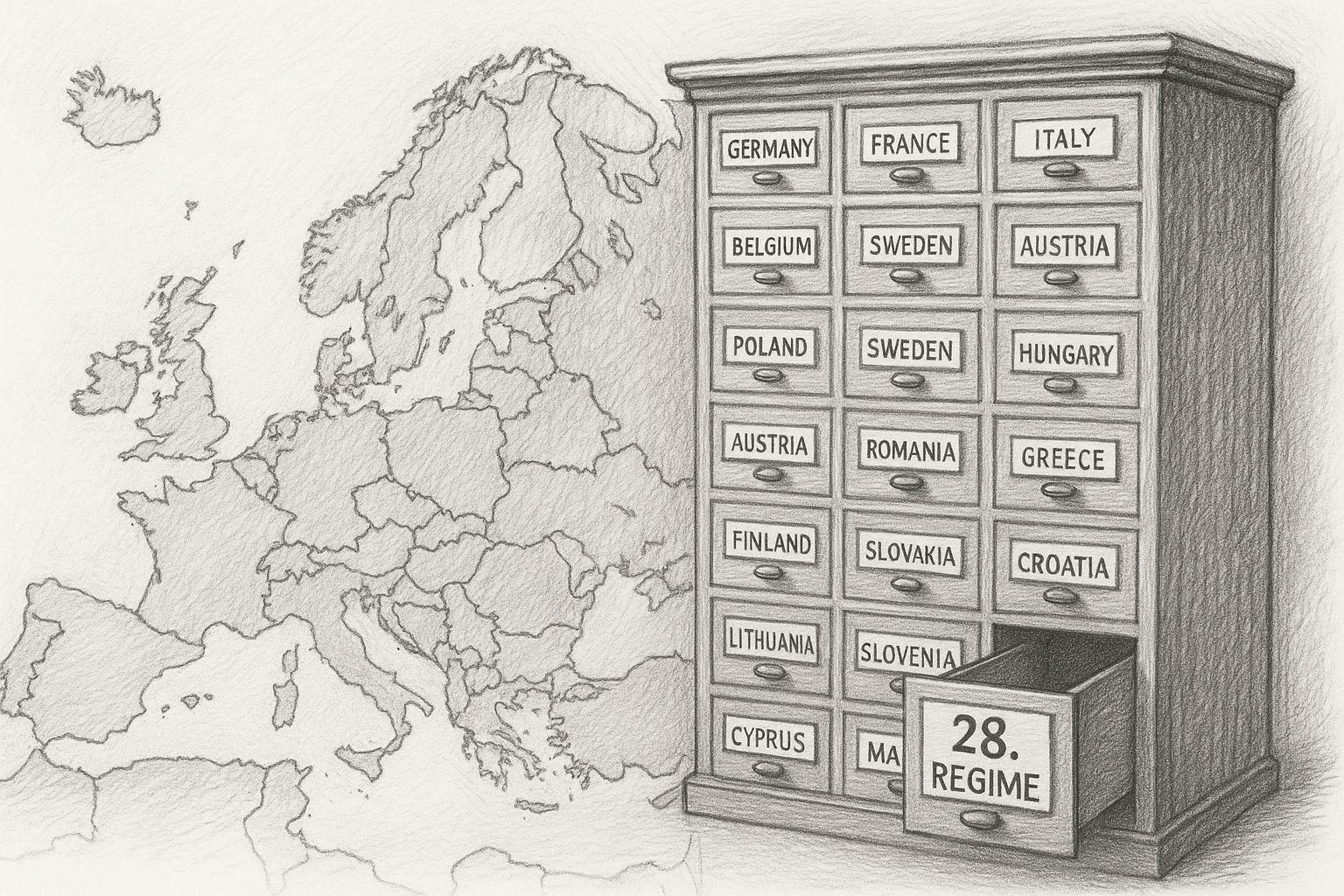

In dieser Phase wurden mehrere zentrale Vorschläge der Digital Services Act (DSA), der Regulation to Prevent and Combat Child Sexual Abuse (CSAR, auch „Chat Control“ genannt) und der European Media Freedom Act (EMFA) offiziell eingebracht.

- Im Mai 2022 legte die EU-Kommission den CSAR-Vorschlag vor, um Online-Darstellungen sexuellen Missbrauchs von Kindern zu bekämpfen.

- Am 23. April 2022 wurde eine politische Einigung zwischen Parlament und Rat über die DSA-Initiative erzielt.

- Im Juni/Dezember 2023 wurden Verhandlungen und Übereinkünfte zum EMFA-Entwurf getroffen.

Europäischer Rat

In dieser Phase wurde also die Spielwiese abgesteckt: die EU entschied, dass umfassendere digitale Regeln nötig sind.

2024: Die ersten Gesetze treten in Kraft

Im Jahr 2024 begann die Umsetzungsphase: Einige Regelungen wurden verabschiedet, andere bereiten ihre Anwendung vor.

- Die DSA trat formal in Kraft (Regulierung (EU) 2022/2065), und viele Dienste mussten sich auf Compliance vorbereiten.

- Der EMFA wurde formell angenommen (z. B. 26 März 2024 durch den Rat) und die Umsetzungsvorgaben wurden gesetzt.

- Beim CSAR hingegen bleibt die Lage unsicher: Die Zeit bis zu einem endgültigen Beschluss wurde mehrfach verlängert. Beispielsweise wurde die Interim-Maßnahme bis 3. April 2026 verlängert.

Diese Phase war geprägt von Übergangsfristen, Vorbereitungen und politischen Auseinandersetzungen – die Uhr tickt, aber noch nicht alles ist aktiv.

2025: Die entscheidende Phase

Im Jahr 2025 stehen wichtige Weichenstellungen an.

- Die DSA-Pflichten für sehr große Plattformen („VLOPs“) greifen zunehmend; Fristen laufen ab.

- Der EMFA kommt voll zur Anwendung – viele Bestimmungen sollen ab einem Stichtag gelten.

- Beim CSAR zeichnet sich eine Entscheidung ab: Einige Mitgliedsstaaten kündigten Widerstand an, Abstimmungen wurden verschoben oder blockiert.

Für Bürger und Unternehmen wird es spürbarer: Nicht mehr nur „Gesetzesentwurf“, sondern „Regelung, auf die man sich einstellen muss“.

2026 und später: Was absehbar kommen wird

Auch über 2025 hinaus gilt: Die weiteren Schritte sind relevant. Für die DSA werden ggf. noch zusätzliche technische Standards gelten: die EU-Kommission beobachtet Umsetzung und Wirkung. Beim CSAR kann eine endgültige Verordnung folgen – oder der Vorschlag wird erheblich verändert oder verschoben. Beim EMFA werden weitere Spezialbestimmungen gelten, etwa zur Medien-Plattform-Zusammenarbeit, Schnittstellen oder Werbung.

Generell gilt: Je komplexer die digitale Infrastruktur wird (KI, Plattformen, Kommunikation), desto mehr Regelungsbedarf wird erwartet. Für den Leser heißt das: Das Thema ist nicht abgeschlossen – es wird Teil unseres digitalen Alltags. Vorbereitung und Aufmerksamkeit sind daher sinnvoll.

MEINUNGSFREIHEIT IN GEFAHR: EU Digital Services Act | WELT Nachrichtensender

Was bedeutet das für kleine und mittelständische Unternehmen?

Für Konzerne wie Meta, Google oder Microsoft gibt es eigene Rechtsabteilungen, Datenschutz-Teams und Compliance-Beauftragte. Kleine und mittelständische Unternehmen (KMU) haben das in der Regel nicht. Trotzdem betreffen die neuen EU-Regelwerke auch sie – manchmal direkt, oft indirekt über die genutzten Plattformen, Tools und Kommunikationswege.

Im Folgenden geht es darum, was diese Entwicklungen konkret für kleinere Betriebe bedeuten können: vom Ein-Mann-Unternehmen bis zum Mittelständler mit 50 oder 200 Mitarbeitenden.

Mehr Regeln im Hintergrund – auch wenn man sie nicht sofort sieht

Viele der neuen Regeln – etwa im Digital Services Act (DSA) oder im AI Act – richten sich offiziell vor allem an „sehr große“ Plattformen oder an bestimmte KI-Anbieter. Trotzdem schlagen die Folgen auf kleinere Unternehmen durch:

- über die Plattformen, auf denen sie werben oder Inhalte veröffentlichen,

- über Tools, die sie nutzen (z. B. KI-Systeme, Newsletter-Software, Chat-Systeme),

- und über kommunikative Pflichten, die sich allmählich auch für kleinere Anbieter ergeben.

Beispiel: Der DSA verpflichtet Online-Plattformen dazu, illegale Inhalte effizient zu entfernen und Transparenz herzustellen. Für kleine Firmen, die Kunden über Facebook, Instagram, YouTube oder Plattform-Marktplätze erreichen, bedeutet das, dass Inhalte schneller als früher gelöscht oder eingeschränkt werden können – auch wenn sie selbst sich an Recht und Gesetz halten.

Konkrete Auswirkungen im Alltag eines KMU

1. Kommentarspalten, Foren und Kundenbewertungen

Viele Unternehmen nutzen heute:

- Blog-Artikel mit Kommentarbereich

- Foren oder Support-Communities

- Bewertungsfunktionen oder Gästebücher

- Social-Media-Kanäle mit Kommentaren

Mit den neuen Regeln steigt der Druck, Nutzerinhalte im Blick zu behalten:

- Beschwerden müssen ernstgenommen und geprüft werden.

- Offensichtlich rechtswidrige Inhalte sollten zügig entfernt werden, um nicht in Haftungsfragen zu geraten.

- Plattformen selbst reagieren empfindlicher: ein Shitstorm mit Grenzinhalten kann schneller zu Sperren, Reichweitenverlust oder Blockaden führen.

- Befürworter sagen: Das ist sinnvoll, weil es klare Verantwortlichkeiten schafft. Wer eine öffentliche Bühne bietet (auch ein kleines Forum), muss Missbrauch unterbinden. Für seriöse Anbieter sei das kein Nachteil, sondern ein Qualitätsmerkmal.

- Kritiker halten dagegen: Kleine Betriebe haben weder Zeit noch Personal, um Kommentare juristisch zu bewerten oder moderationsfähig aufzubereiten. Sie fürchten, aus Angst vor Problemen Kommentarfunktionen ganz abzuschalten – wodurch der offene Austausch im Netz weiter verarmt.

2. Kommunikationskanäle: E-Mail, Messenger und „Chatcontrol“

Die geplante Verordnung zur Bekämpfung von Kindesmissbrauch (CSAR, „Chatcontrol“) zielt formal auf Anbieter von Kommunikationsdiensten, die nach Missbrauchsmaterial suchen und dieses melden sollen. Für den klassischen Mittelständler heißt das zwar nicht, dass er sofort eigene Scanner installieren muss. Aber:

- Viele nutzen Messenger-Dienste (WhatsApp, Signal, Teams, Slack etc.) sowohl intern als auch in der Kundenkommunikation.

- Wenn diese Dienste künftig Inhalte scannen (oder scannen müssen), ist Unternehmenskommunikation potenziell nicht mehr so vertraulich, wie man das bisher gewohnt war.

- Besonders heikel: Dateien, Projektunterlagen, Entwürfe, Vertrauliches, das über solche Kanäle läuft.

- Befürworter argumentieren: Ohne solche Maßnahmen sei die Bekämpfung von Kindesmissbrauch im Netz kaum möglich. Unternehmen, die sauber arbeiten, hätten nichts zu befürchten – im Gegenteil, sie profitieren von einem sichereren digitalen Umfeld.

- Kritiker halten entgegen: Die technische Umsetzung (z. B. „Client-Side-Scanning“) kann Verschlüsselung praktisch aushebeln und eine Infrastruktur schaffen, mit der jede Art von Inhalt überprüft werden könnte – heute Missbrauch, morgen eventuell politische oder wirtschaftliche Themen. Geschäftsgeheimnisse und Kundendaten seien gefährdet, weil zusätzliche Schnittstellen entstehen, über die Daten abgeflossen oder missbraucht werden können. Fehlalarme (falsche Verdächtigungen) können für Unternehmen und Beschäftigte rufschädigend sein, ohne dass man real etwas falsch gemacht hat.

3. KI im Unternehmen: Kennzeichnung, Dokumentation und Haftung

Mit dem AI Act führt die EU einen risikobasierten Rahmen ein: Je nach Einsatzgebiet gelten unterschiedliche Pflichten. Für KMU sind vor allem drei Bereiche relevant:

- Marketing und Kommunikation: Wenn Texte, Bilder oder Videos mit KI erzeugt werden – etwa Blogartikel, Social-Media-Posts oder Produktbilder –, können Kennzeichnungspflichten greifen (z. B. „Dieser Inhalt wurde mit Unterstützung von KI erstellt“), vor allem wenn es um politisch sensible Bereiche oder Deepfakes geht.

- Kundenservice und Entscheidungsprozesse: Chatbots oder automatisierte Entscheidungssysteme (Scoring, Bewerberauswahl, Risikobewertung) können je nach Ausprägung in die Kategorie „Hochrisiko-KI“ fallen, mit strengen Dokumentations- und Transparenzpflichten.

- Interne Tools und Analysen: Auch wenn externe Anbieter KI-Funktionen integrieren (z. B. CRM-Systeme, Buchhaltung, ERP), kann das Unternehmen in die Verantwortung geraten, wenn es Entscheidungen auf Basis von KI-Empfehlungen trifft.

- Befürworter sagen: Der AI Act schützt Kunden und Bürger vor undurchsichtigen oder unfairen Entscheidungen. Er zwingt Anbieter zu Sorgfalt, Qualität und Transparenz – was am Ende auch seriösen KMU zugutekommt, die verantwortungsvoll mit KI umgehen.

- Kritiker weisen darauf hin: Für kleinere Betriebe werden die Regelungen schnell unübersichtlich. Sie wissen oft nicht, ob ihre Nutzung von KI schon in den regulierten Bereich fällt oder nicht. Die Gefahr besteht, dass sich KMU aus Unsicherheit lieber gar nicht an KI herantrauen – und damit einen Innovationsnachteil gegenüber größeren Firmen in Kauf nehmen. Dokumentations- und Kennzeichnungspflichten könnten in der Praxis ein Bürokratie-Monster werden, das man ohne spezialisierte Beratung kaum überblickt.

4. Reputationsrisiken: Sichtbarkeit, Sperrungen und „Algorithmusdruck“

Durch den DSA stehen Plattformen stärker unter Zugzwang: Sie müssen zeigen, dass sie Risiken wie Desinformation, Hassrede oder rechtlich problematische Inhalte ernsthaft bekämpfen. Für Unternehmen bedeutet das:

- Inhalte, die umstrittene Themen berühren (Gesundheit, Politik, Sicherheit, Krisen, Gesellschaft), können schneller heruntergestuft werden – also weniger Sichtbarkeit erhalten.

- Konten können vorübergehend gesperrt, Beiträge entfernt oder Werbekampagnen blockiert werden, wenn Plattformen „Risiken“ sehen – selbst wenn die Inhalte nicht klar illegal sind.

- Die Grenze zwischen legitimer Kritik und „problematischem Content“ wird damit unschärfer – und liegt in der Praxis in der Hand der jeweiligen Plattformmoderation.

- Befürworter argumentieren: Plattformen müssen Verantwortung übernehmen. Ohne wirksame Mechanismen würden Falschinformationen und Hetze ungebremst bleiben. Unternehmen, die seriöse Inhalte liefern, haben langfristig eher etwas zu gewinnen: ein saubereres Umfeld und mehr Vertrauen.

- Kritiker sehen dagegen: Eine starke Tendenz zum Overblocking: Aus Angst vor Bußgeldern löschen Plattformen lieber zu viel als zu wenig.

Das kann gerade kleinere Unternehmen treffen, die auf Sichtbarkeit angewiesen sind, aber keine Lobby haben, um Entscheidungen anzufechten.

Der „Algorithmusdruck“ führt dazu, dass man Inhalte an vermeintliche Richtlinien anpasst, um nicht negativ aufzufallen – was einer schleichenden Selbstzensur gleichkommt.

Aktuelle Umfrage zum geplanten digitalen Euro

Wer entscheidet, was „Information“ und was „Desinformation“ ist?

Wenn man sich die neuen EU-Regulierungen anschaut, fällt ein Wort immer wieder auf: Desinformation. Es soll bekämpft werden — ganz gleich, ob durch Plattformpflichten, Risikobewertungen oder algorithmische Eingriffe. Doch der entscheidende Punkt wird selten ausgesprochen: Wer definiert überhaupt, was Desinformation ist?

Diese Frage ist zentral, denn an ihr entscheidet sich, ob Schutzmaßnahmen wirklich schützen — oder ob sie unbeabsichtigt zu einer Kontrolle öffentlicher Debatten führen. In der Theorie scheint es einfach:

- Falsche Behauptungen = Desinformation,

- korrekte Aussagen = Information.

In der Praxis ist die Welt jedoch selten so klar. Viele Themen sind komplex, unscharf, umstritten oder entwickelt sich laufend weiter. Studien ändern sich, Experten streiten, neue Fakten kommen hinzu. Was an einem Tag als falsch gilt, kann am nächsten Tag plötzlich neu bewertet werden — man denke nur an politische Prognosen, Gesundheitsdebatten oder neue technologische Risiken.

Deshalb warnen viele Kritiker davor, „Desinformation“ als festen Begriff zu behandeln. Sie betonen, dass es sich oft weniger um einen klaren Sachverhalt handelt, sondern um eine Interpretation, die von der jeweiligen politischen oder gesellschaftlichen Lage geprägt ist.

Plattformen entscheiden praktisch – aber unter Druck

Formal sind es Plattformen, die entscheiden müssen, ob etwas möglicherweise Desinformation ist, weil sie aufgrund des Digital Services Act für Risiken verantwortlich gemacht werden. Doch Plattformen handeln nicht im luftleeren Raum. Sie stehen unter mehreren Arten von Druck:

- Gesetzlicher Druck: Hohe Bußgelder, wenn „Risiken“ nicht ausreichend reduziert werden.

- Politischer Druck: Erwartung, bestimmte Narrative stärker oder schwächer zu gewichten.

- Öffentlicher Druck: Kampagnen, Empörungen, Medienberichte, die Moderationsentscheidungen beeinflussen.

- Finanzieller Druck: Unabhängige Moderation kostet Zeit, Geld und Personal — automatisierte Lösungen sind billiger, aber oft fehleranfälliger.

Unter diesen Bedingungen neigen Plattformen dazu, im Zweifel lieber zu viel als zu wenig zu löschen oder einzuschränken. Damit entscheiden sie de facto, was sichtbar bleibt — selbst wenn sie gar nicht der eigentliche Gesetzgeber sind.

Die Rolle von Regierungen und Behörden

Ein weiterer Punkt ist, dass Regierungen oder staatliche Stellen immer stärker in diese Prozesse einbezogen werden — etwa in Form von:

- „Trusted Flaggers“

- Meldestellen

- Beratungsstellen für Plattformen

- Bewertungen von „systemischen Risiken“

Dadurch entsteht ein System, in dem staatliche Institutionen indirekt Einfluss darauf nehmen können, welche Inhalte als problematisch eingestuft werden. Das muss nicht zwingend missbräuchlich sein — aber es schafft eine Struktur, die missbrauchsanfällig ist, wenn später andere politische Mehrheiten herrschen.

Die Gefahr einer „Verschiebung des Sagbaren“

Wenn Plattformen auf Basis vager Begriffe wie „Manipulation“, „gesellschaftliche Risiken“ oder „Desinformation“ Inhalte sortieren, entsteht langfristig eine kulturelle Verschiebung:

- Menschen äußern sich vorsichtiger, Unternehmen vermeiden bestimmte Themen, kritische Stimmen verlieren Sichtbarkeit.

- Es entsteht kein offenes Verbot — sondern eine schleichende Unsichtbarkeit. Inhalte verschwinden nicht, aber sie erreichen kaum noch jemanden.

Viele Kritiker sehen darin nicht gezielte Zensur, sondern eine Nebenwirkung, die aber genauso wirksam ist: Das Sagbare verschiebt sich, schlicht weil jeder Akteur lernen muss, was von den Plattformen „erwünscht“ oder „belastungsfrei“ ist.

Wer über Desinformation spricht, muss auch über Macht sprechen.

Denn die Entscheidung darüber, was wahr, falsch, zulässig oder gefährlich ist, liegt heute nicht mehr nur bei Wissenschaft, Journalismus oder demokratischer Debatte, sondern zunehmend bei einer Mischform aus:

- Plattformen

- Algorithmen

- Regierungsstellen

- Moderations-Teams

- externen Prüfern

- und gesellschaftlichem Druck

Gerade deshalb ist es wichtig, diese Entwicklung nicht nur technisch oder juristisch zu betrachten, sondern auch kulturell. Denn am Ende geht es um etwas sehr Grundsätzliches: Wie frei kann eine Gesellschaft sprechen, wenn niemand mehr klar sagen kann, wer über Wahrheit und Falschheit entscheidet — und nach welchen Maßstäben?

EU-Gesetz zensiert das Internet (DSA – Digital Services Act) | Prof. Dr. Christian Rieck

Befürworter vs. Kritiker – die Gegenüberstellung

Um die Spannungen klar zu machen, lohnt sich eine direkte Gegenüberstellung. Was Befürworter betonen:

- Sicherheit und Schutz: Kinder, Verbraucher, demokratische Prozesse – all das brauche einen modernen gesetzlichen Schutzschirm.

- Rechtsklarheit: Einheitliche Regeln in der EU ersparen Unternehmen das Flickwerk nationaler Sonderwege. Wer sich an klare Vorgaben hält, hat weniger Rechtsunsicherheit.

- Fairness: Große Plattformen und KI-Anbieter sollen nicht „free rider“ sein, die Gewinne einstreichen und Risiken auf die Gesellschaft abladen. Regelungen wie DSA und AI Act würden hier Ordnung schaffen.

- Vertrauen: Längerfristig soll das Vertrauen in digitale Dienste steigen, wenn Nutzer wissen, dass Regeln gelten und überwacht werden.

Was Kritiker hervorheben:

- Grundrechtliche Risiken: Chatcontrol und ähnliche Maßnahmen schaffen eine technische Infrastruktur, mit der in Zukunft jede digitale Kommunikation überwacht werden könnte – auch jenseits des ursprünglichen Zwecks.

- Bürokratische Überlastung: Kleine Unternehmen haben weder Ressourcen noch Know-how, um den wachsenden Katalog an Pflichten (Kennzeichnung, Dokumentation, Moderation, Meldewege) dauerhaft sauber zu erfüllen.

- Privatisierte Zensur: Durch hohe Bußgelder werden Plattformen zu „Hilfssheriffs“, die im Zweifel mehr löschen als nötig – auf Kosten der Meinungsfreiheit und der Vielfalt der Debatte. KMU, die von Reichweite leben, können ohne Vorwarnung verlieren.

- Innovationshemmnis: Statt Experimente zu wagen, bremsen sich viele kleine Betriebe aus, weil sie Angst haben, etwas falsch zu machen. Wer nichts riskiert, verstößt auch nicht – aber bleibt auf der Stelle.

- Machtverschiebung: Am Ende setzen sich diejenigen durch, die das Regelwerk am besten bedienen können – große Konzerne mit Rechtsabteilung und Compliance-Teams. Kleine Betriebe müssen sich nach deren Spielregeln richten, weil sie von deren Infrastruktur abhängig sind.

Fazit aus Sicht eines kleinen oder mittelständischen Unternehmens

Für ein normales KMU ist das Wichtigste:

- Grundlagen kennen, ohne sich in jedem Detail zu verlieren.

- Eigene Kommunikationskanäle prüfen (Kommentare, Social Media, Newsletter, Messenger) und bewusst entscheiden, was man wirklich braucht – und wo man bewusst reduziert.

- KI-Einsatz dokumentieren und im Zweifel lieber offen kommunizieren, statt später in Erklärungsnot zu gelangen.

- Ruhig bleiben, aber aufmerksam sein: Es bringt nichts, vor lauter Gesetzen nichts mehr zu tun. Wichtig ist, Schritt für Schritt zu denken: „Wo betrifft mich das wirklich?“ – und dort solide Lösungen zu finden.

Die zentrale Sorge der Kritiker lässt sich in einem Satz zusammenfassen: Nicht das einzelne Gesetz ist das Problem, sondern das Zusammenwirken vieler Regeln, das Stück für Stück ein digitales Umfeld schafft, in dem Kontrolle und Konformität belohnt werden – und eigenständige, kritische Stimmen es schwerer haben.

Was bleibt für normale Bürger und kleinere Unternehmen?

Wenn man all diese Entwicklungen betrachtet, wird deutlich: Die EU versucht, Ordnung in eine digitale Welt zu bringen, die über viele Jahre weitgehend unreguliert gewachsen ist. Die Ziele klingen auf dem Papier nachvollziehbar – Schutz, Sicherheit, Transparenz. Doch gleichzeitig entsteht ein dichtes Netz aus Vorschriften, Prüfmechanismen und technischen Anforderungen, das sich langsam, aber spürbar um unseren digitalen Alltag legt.

Für große Konzerne ist das eine Frage von Ressourcen. Sie stellen Juristen ein, passen ihre Prozesse an, investieren in neue Tools. Für normale Bürger und kleine oder mittelständische Unternehmen dagegen fühlt sich diese Entwicklung oft unübersichtlich, manchmal sogar bedrohlich an – nicht, weil man etwas zu verbergen hätte, sondern weil man ahnt, dass sich der Charakter der digitalen Kommunikation verändert.

Was normale Bürger beachten sollten

- Wachsam bleiben, ohne sich verrückt zu machen. Es braucht keine Panik, aber ein gesundes Bewusstsein dafür, dass Kommunikation im digitalen Raum zunehmend beobachtet und gefiltert wird – nicht unbedingt von Menschen, sondern durch Systeme, Algorithmen und automatisierte Prüfungen.

- Eigene Informationswege pflegen. Je stärker Inhalte gefiltert und sortiert werden, desto wichtiger wird es, bewusst verschiedene Informationsquellen zu nutzen. Nicht nur soziale Netzwerke – auch klassische Medien, Fachportale oder unabhängige Newsletter.

- Bewusst kommunizieren. Man muss nicht jeden Gedanken öffentlich schreiben. Aber es hilft, sich klarzumachen, dass Plattformen im Zweifel eher löschen als stehen lassen. Das heißt nicht, sich kleinzumachen – aber man sollte verstehen, wie die Mechanismen arbeiten.

- Nicht jeder KI vertrauen – aber auch keine Angst davor haben. Wenn Inhalte künftig als KI-generiert gekennzeichnet werden, kann das helfen, nicht alles für bare Münze zu nehmen. Gleichzeitig sollte man sich nicht davon abhalten lassen, KI-Werkzeuge sinnvoll zu nutzen – mit Augenmaß.

Was kleine und mittlere Unternehmen beachten sollten

- Kommunikation und Plattformpräsenz bewusst strukturieren. Kommentarbereiche, Supportforen, Social-Media-Kanäle – all das kann sinnvoll sein, aber sollte gut gepflegt werden. Die neue Regulierung zwingt dazu, Verantwortung zu übernehmen, aber damit kann man professionell umgehen.

- KI-Nutzung dokumentieren. Nicht jedes Tool ist problematisch, aber Unternehmen sollten wissen, wo KI eingesetzt wird – und es im Zweifel offen kommunizieren. Das schafft Vertrauen und verhindert Missverständnisse.

- Klare interne Regeln schaffen. Welche Inhalte veröffentlicht man? Wer prüft Beschwerden? Welche Plattformen nutzt man wirklich aktiv? Eine klare Struktur nimmt viel Unsicherheit.

- Den eigenen Weg nicht verlieren. Gerade kleine Unternehmen leben von ihrer Persönlichkeit, ihrer Handschrift und ihrer direkten Kundenbeziehung. Kein Gesetz zwingt dazu, das zu verlieren. Im Gegenteil – in einer Welt voller automatisierter Prozesse wirkt echte Menschlichkeit heute fast schon wie ein Wettbewerbsvorteil.

Unklare Wirkung im Ernstfall: Was passiert im Spannungsfall?

Bislang bleibt völlig offen, wie sich das gesamte Paket an EU-Zensurgesetzen – vom Digital Services Act bis hin zu erweiterten Kontrollbefugnissen – in einem tatsächlichen Spannungsfall auswirken würde. Es gibt bislang keine belastbaren Erfahrungen, wie die Vielzahl an Bestimmungen in der Praxis zusammenspielen, wenn nationale Regierungen plötzlich mit dem Verweis auf äußere Bedrohungslagen oder hybride Angriffe weitreichende Eingriffe in Kommunikations- und Informationsfreiheiten rechtfertigen.

Weder für Bürger noch für Unternehmen ist derzeit klar erkennbar, welche Einschränkungen im Ernstfall greifen könnten, welche Mechanismen zur Gegenwehr bestehen – oder ob einzelne Maßnahmen im Ausnahmezustand sogar automatisch in Kraft treten.

Ein vertiefender Blick auf mögliche Szenarien im innerstaatlichen Ausnahmezustand findet sich im Artikel zum Spannungsfall in Deutschland – eine Perspektive, die im aktuellen politischen Diskurs bislang nur unzureichend beleuchtet wird.

Ein letzter Gedanke

Die digitale Zukunft wird geprägt sein von Regeln. Das ist unvermeidlich – und in vielen Bereichen notwendig. Doch entscheidend ist, wie wir als Bürger und Unternehmer damit umgehen. Wer informiert bleibt, wer bewusst kommuniziert und wer sich nicht von komplizierten Begriffen einschüchtern lässt, der behält seine Freiheit – auch in einem stärker regulierten Umfeld.

Vielleicht ist das die eigentliche Botschaft: Nicht blind vertrauen, nicht blind ablehnen. Sondern die Dinge verstehen, einordnen – und dann selbst entscheiden, welchen Weg man gehen möchte.

Häufig gestellte Fragen

- Was genau will die EU eigentlich mit diesen neuen digitalen Gesetzen erreichen?

Die EU möchte das Internet sicherer machen, Missbrauch bekämpfen, die Verbreitung illegaler Inhalte eindämmen und die Transparenz über Medien und digitale Dienste erhöhen. Dahinter steht die Vorstellung, dass der bisherige Rechtsrahmen nicht mehr ausreicht, weil digitale Dienste heute einen riesigen Einfluss auf Gesellschaft und Demokratie haben. Die Ziele wirken nachvollziehbar, doch die dafür geplanten Mittel sind weitreichend und teilweise umstritten. - Warum sprechen manche von „Zensurgesetzen“, obwohl die EU das bestreitet?

Der Begriff entsteht aus der Sorge, dass durch hohe Bußgelder und unklare Definitionen („Systemrisiken“, „Desinformation“) Plattformen Inhalte vorsorglich löschen. So entsteht faktisch eine privatisierte Form der Zensur, auch wenn sie nicht offiziell als solche bezeichnet wird. Kritiker sehen das Problem weniger im Gesetzestext selbst, sondern in der Art, wie Plattformen darauf reagieren. - Was macht Chatcontrol bzw. CSAR so umstritten?

Weil dieses Gesetz private Kommunikation potenziell automatisiert durchsuchen lässt. Technisch bedeutet das oft „Client-Side-Scanning“, bei dem Inhalte geprüft werden, bevor sie verschlüsselt werden. Kritiker sagen: Damit wird eine Infrastruktur geschaffen, die grundsätzlich jede Kommunikation überwachen könnte — egal, ob man etwas Verbotenes tut oder nicht. - Ist Chatcontrol schon beschlossen?

Nein. Es gibt massive Widerstände, vor allem aus Deutschland und anderen EU-Staaten. Der Entwurf ist politisch festgefahren, und Teile wurden mehrfach überarbeitet. Aber er ist auch nicht vom Tisch — er schwebt weiter über den Verhandlungen. - Was bedeutet der Digital Services Act (DSA) für ganz normale Menschen?

Beiträge, Kommentare oder Posts auf großen Plattformen können schneller entfernt werden, wenn Plattformen etwas als potenziell illegal oder riskant einstufen. Nutzer müssen sich darauf einstellen, dass der algorithmische „Filter“ enger wird. Gleichzeitig gibt es mehr Transparenzrechte — man erfährt eher, warum ein Beitrag gesperrt wurde. - Wie betrifft der DSA kleine und mittlere Unternehmen?

Firmen, die Social Media nutzen, Blog-Kommentare erlauben oder Online-Shop-Plattformen verwenden, sind indirekt betroffen. Ihre Inhalte können leichter Einschränkungen unterliegen — und sie müssen stärker auf die eigene Moderation achten. Fehler in Kommentarspalten oder Foren können zu rechtlichen Problemen führen. - Was regelt das neue Medienfreiheitsgesetz (EMFA)?

Es soll die Unabhängigkeit und Vielfalt der Medien schützen. Dazu gehört auch, dass Plattformen anerkannte Medien nicht ohne triftigen Grund herabstufen oder blockieren dürfen. Kritiker fürchten jedoch, dass dadurch eine Art Medien-Hierarchie entsteht, bei der etablierte Medien bevorzugt und alternative Stimmen benachteiligt werden. - Kann ein Unternehmen durch den EMFA „privilegierte“ Sichtbarkeit verlieren?

Ja — nicht direkt, aber indirekt. Inhalte kleiner Blogs oder Unternehmens-Webseiten konkurrieren mit „anerkannten Medien“, deren Sichtbarkeit algorithmisch geschützt wird. Das kann bedeuten, dass Firmeninhalte auf Plattformen weniger prominent erscheinen, weil Plattformen vorsichtigere Moderationsstrategien für Medien anwenden müssen. - Was ändert der AI Act für Bürger?

Viele KI-Inhalte — Bilder, Texte, Videos — müssen künftig als KI-generiert gekennzeichnet werden. Das soll Transparenz schaffen, damit man erkennt, ob ein Mensch oder ein Algorithmus der Urheber ist. Besonders bei politischen oder manipulationsanfälligen Themen spielt das eine große Rolle. - Und was bedeutet der AI Act für Unternehmen?

Unternehmen müssen prüfen, ob und wie sie KI einsetzen: im Marketing, im Kundenservice oder intern. Je nach Risikostufe müssen sie dokumentieren, markieren oder erklären, wie KI genutzt wird. Das kann zusätzlichen Aufwand bedeuten, schützt aber langfristig auch vor rechtlichen Problemen. - Warum ist die Kombination all dieser Gesetze so kritisch?

Weil jedes Gesetz eine eigene Funktion hat, aber erst das Zusammenwirken die Wirkung verstärkt: Überwachung privater Kommunikation (CSAR), stärkere Plattformkontrolle (DSA), mediale Hierarchien (EMFA) und KI-Kennzeichnungspflichten (AI Act). Kritiker sagen, dass dadurch ein Umfeld entsteht, in dem Kontrolle, Konformität und Vorsicht dominieren — mit Folgen für Debatte, Kreativität und Freiheit. - Was raten Experten normalen Bürgern im Umgang mit diesen Veränderungen?

Gelassen bleiben, aber aufmerksam. Eigene Informationswege pflegen, nicht alles einer einzigen Plattform überlassen und bewusst mit privaten oder sensiblen Inhalten umgehen. Wichtig ist, zu verstehen, dass digitale Kommunikation nicht mehr „neutral“ moderiert wird, sondern zunehmend regelgesteuert. - Wie kann man sich als Bürger gegen Fehlentscheidungen von Plattformen wehren?

Der DSA gibt neue Rechte: Man kann Moderationsentscheidungen anfechten, Beschwerden einreichen und eine Begründung verlangen. Das ist ein Fortschritt – aber erfordert Zeit, Ausdauer und manchmal auch juristische Unterstützung. - Was sollten kleine Unternehmen in den nächsten Jahren konkret vorbereiten?

Sie sollten klare interne Regeln zur Kommunikation schaffen, Kommentarbereiche besser kontrollieren, KI-Nutzung dokumentieren und prüfen, welche Plattformen sie wirklich brauchen. Es lohnt sich, nicht alles öffentlich zu machen, was intern geregelt werden kann. - Wer gehört zu den seriösen Kritikern dieser Gesetze?

Patrick Breyer (Europäisches Parlament), European Digital Rights (EDRi), die Messenger-App Signal, IT-Sicherheitsforschende sowie zahlreiche Medienrechtler. Ihre Kritik basiert weniger auf Ideologie, sondern auf technischen und rechtsstaatlichen Bedenken. - Geht es bei all diesen Gesetzen letztlich um Zensur?

Das kommt darauf an, wen man fragt. Befürworter sagen: Es geht um Sicherheit und Ordnung. Kritiker sagen: Auch wenn „Zensur“ nicht im Gesetz steht, entsteht durch Pflichten, Strafen und Risikoaversion eine faktische Einschränkung der Sichtbarkeit und Freiheit. Die Wahrheit liegt wahrscheinlich irgendwo dazwischen — aber der Trend ist eindeutig: Kommunikationsräume werden stärker reguliert. - Sind diese neuen Regeln gefährlich für die Demokratie?

Nicht unbedingt per se — aber sie können es werden, wenn sie falsch umgesetzt oder später politisch erweitert werden. Demokratie lebt von offenen Debatten, Kritik und Vielfalt. Wenn Plattformen vor Angst zu viel löschen oder wenn Kommunikationswege überwacht werden, kann das die demokratische Kultur schwächen. - Wie sollte ein Unternehmen oder Bürger langfristig reagieren?

Am besten mit einer Mischung aus informierter Gelassenheit und praktischer Vorbereitung. Man sollte sich nicht einschüchtern lassen, aber auch nicht naiv sein. Wer seine Kommunikationswege klug wählt, Transparenz schafft und die eigenen Daten schützt, bleibt handlungsfähig — auch in einem Umfeld, das stärker reguliert wird.