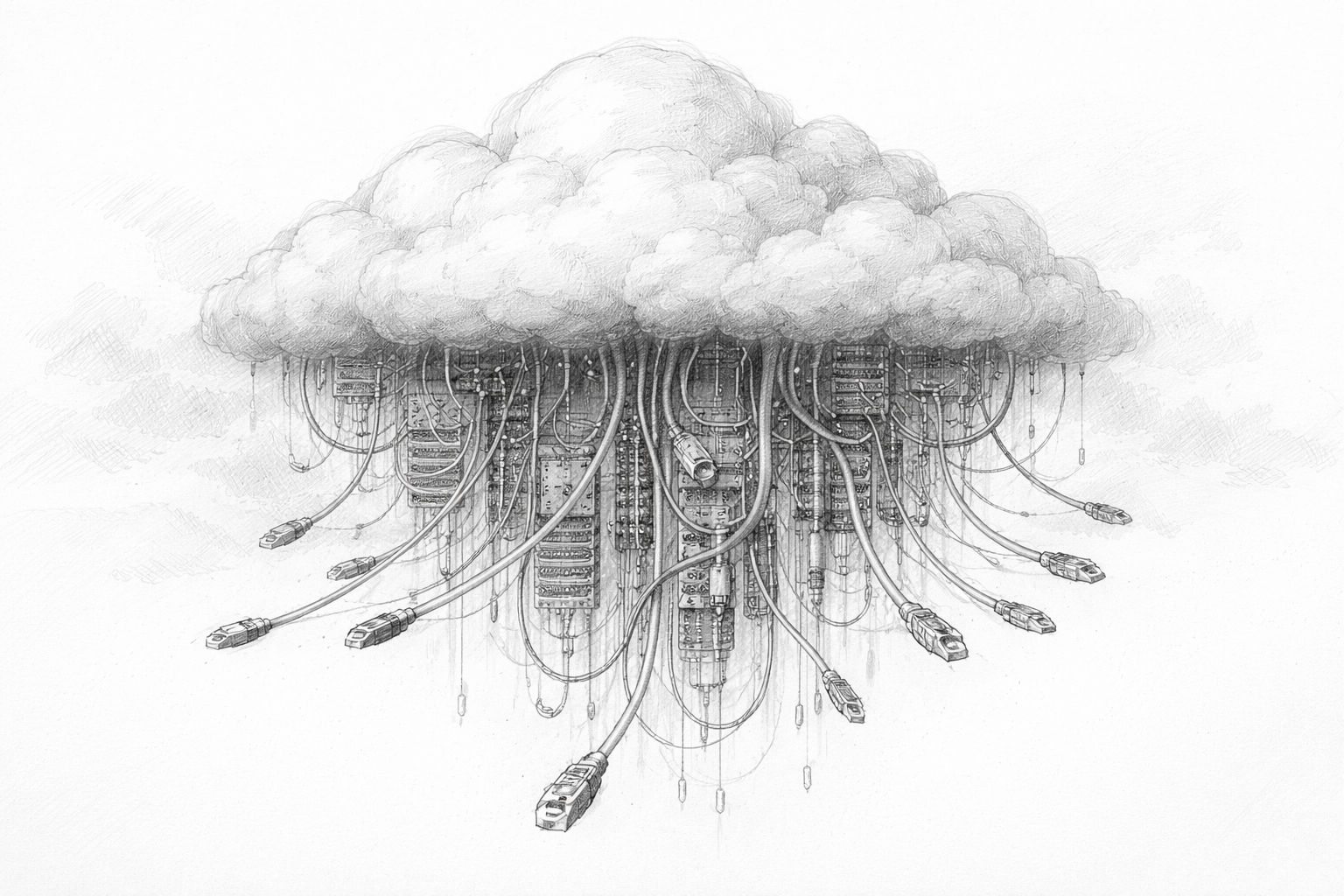

Künstliche Intelligenz wirkt auf den ersten Blick fast schwerelos. Man tippt eine Frage ein, Sekunden später erscheint eine Antwort. Kein Lärm, kein Rauch, keine sichtbare Bewegung. Alles passiert scheinbar „in der Cloud“. Genau darin liegt der Denkfehler. KI ist keine abstrakte Zauberei, sondern das Ergebnis sehr konkreter, physischer Prozesse. Hinter jeder Antwort stehen Rechenzentren, Stromleitungen, Kühlsysteme, Chips und ganze Infrastrukturen. Je stärker KI in unseren Alltag drängt, desto sichtbarer wird diese Realität. Und genau hier beginnt die Frage nach der Nachhaltigkeit.

Wer über KI spricht, ohne über Energie, Ressourcen und Infrastruktur zu sprechen, beschreibt nur die Oberfläche. Dieser Artikel setzt tiefer an. Nicht mit Alarmismus, sondern mit einem nüchternen Blick auf das, was KI tatsächlich braucht, um zu funktionieren – heute und in Zukunft.

Der verbreitete Irrtum: KI als „immaterielle Cloud“

Viele Menschen stellen sich KI ähnlich vor wie Software früherer Tage: Ein Programm, das irgendwo läuft, aktualisiert wird und fertig. Diese Vorstellung stammt aus einer Zeit, in der Rechenleistung vergleichsweise günstig, lokal begrenzt und energetisch unauffällig war. KI sprengt diesen Rahmen.

Der Begriff „Cloud“ verstärkt diesen Eindruck zusätzlich. Er klingt weich, fast natürlich. Wolken schweben, sie belasten nichts. In Wirklichkeit verbirgt sich dahinter eine der energieintensivsten Industrien unserer Zeit. Große Hallen voller Hochleistungsrechner, die rund um die Uhr laufen. Tausende Kilometer Kabel. Massive Kühlanlagen. Permanente Wartung.

Der Unterschied zur klassischen Software liegt nicht im Prinzip, sondern in der Größenordnung. KI skaliert nicht linear. Je leistungsfähiger sie wird, desto stärker wächst der Ressourcenbedarf. Und dieser wächst nicht irgendwo abstrakt, sondern ganz konkret vor Ort.

Was moderne KI wirklich braucht

Um zu verstehen, warum KI kein reines Softwarethema mehr ist, hilft ein Blick auf ihre Grundbedürfnisse. Moderne KI-Systeme benötigen vor allem drei Dinge: Rechenleistung, Energie und Kühlung.

Rechenleistung entsteht nicht aus dem Nichts. Sie wird von spezialisierten Chips erbracht, die für maschinelles Lernen optimiert sind. Diese Chips arbeiten parallel, extrem schnell – und sie verbrauchen dabei enorme Mengen Strom. Je größer das KI-Modell, desto mehr dieser Chips müssen gleichzeitig arbeiten. Ein einzelnes Modell kann aus zehntausenden solcher Recheneinheiten bestehen.

Der Stromverbrauch ist dabei kein Nebeneffekt, sondern eine zentrale Größe. KI rechnet nicht punktuell, sondern dauerhaft. Anfragen kommen rund um die Uhr. Trainingsläufe dauern Tage oder Wochen. Stillstand ist wirtschaftlich keine Option. Das System muss laufen, egal ob nachts, am Wochenende oder an Feiertagen.

Damit entsteht sofort das nächste Problem: Wärme. Elektrische Energie wird nicht vollständig in Rechenleistung umgewandelt. Ein erheblicher Teil wird zu Abwärme. Ohne aufwendige Kühlung würden moderne KI-Rechner innerhalb kurzer Zeit ausfallen. Kühlung wiederum braucht selbst Energie – und oft Wasser.

Spätestens hier wird klar: KI ist physisch. Sie ist an Orte gebunden, an Netze, an Ressourcen. Und damit wird sie zwangsläufig zu einer Frage von Nachhaltigkeit, auch wenn man dieses Wort vermeiden möchte.

Training und Nutzung: Zwei völlig unterschiedliche Belastungen

Ein weiterer Punkt, der in der öffentlichen Debatte oft untergeht, ist der Unterschied zwischen dem Anlernen einer KI und ihrer späteren Nutzung. Beides wird gerne in einen Topf geworfen, obwohl die Belastungen sehr unterschiedlich sind.

Beim Training werden große Datenmengen verarbeitet. Das System lernt Zusammenhänge, Muster, Sprache, Bilder. Diese Phase ist extrem rechenintensiv. Sie findet meist konzentriert in großen Rechenzentren statt und kann enorme Energiemengen verschlingen. Ein einziges Training eines großen Modells kann so viel Strom verbrauchen wie eine Kleinstadt über einen längeren Zeitraum.

Nach dem Training folgt die Nutzung. Hier wird das Modell nicht mehr grundlegend verändert, sondern angewendet. Jede Anfrage löst Rechenprozesse aus, aber in kleinerem Maßstab. Das Problem liegt in der Masse. Wenn Millionen oder Milliarden Menschen KI täglich nutzen, summiert sich dieser scheinbar kleine Aufwand zu einer dauerhaften Grundlast.

Beide Phasen sind relevant. Das Training sorgt für Spitzenbelastungen, die Nutzung für Dauerverbrauch. Nachhaltigkeit muss beide Ebenen berücksichtigen, sonst bleibt die Analyse unvollständig.

Warum KI anders ist als frühere Digitalisierung

Man könnte argumentieren, dass jede neue Technologie Energie verbraucht. Das stimmt. Doch KI unterscheidet sich in einem entscheidenden Punkt von früheren Digitalisierungsschritten: Sie ersetzt nicht nur bestehende Prozesse, sie erzeugt neue.

Das Internet hat Kommunikation effizienter gemacht. E-Mails ersetzten Briefe, Videokonferenzen ersetzten Geschäftsreisen. KI hingegen wird häufig zusätzlich eingesetzt. Texte werden nicht nur geschrieben, sondern mehrfach variiert. Bilder werden nicht nur erstellt, sondern in Serien. Entscheidungen werden nicht automatisiert und abgeschlossen, sondern simuliert, bewertet, neu berechnet.

Effizienzgewinne führen hier oft nicht zu Einsparungen, sondern zu Mehrnutzung. Was billig und schnell verfügbar ist, wird häufiger genutzt. Dieses Phänomen ist nicht neu, aber bei KI besonders ausgeprägt. Je besser sie wird, desto stärker wächst der Wunsch, sie überall einzusetzen. Genau deshalb greift die Hoffnung zu kurz, technische Effizienz allein werde das Nachhaltigkeitsproblem lösen. Selbst effizientere Systeme können am Ende zu höherem Gesamtverbrauch führen.

Wenn heute über nachhaltige KI gesprochen wird, schwingt oft ein moralischer Unterton mit. Das ist verständlich, aber nicht immer hilfreich. Bevor man über Gut und Böse spricht, lohnt sich ein Blick auf die physikalischen Grundlagen.

Strom muss erzeugt werden. Wärme muss abgeführt werden. Wasser ist endlich. Netze haben Kapazitätsgrenzen. Diese Tatsachen lassen sich nicht wegdiskutieren, egal wie fortschrittlich die Software ist. Nachhaltigkeit beginnt daher nicht bei guten Absichten, sondern bei der Frage:

Was ist technisch und infrastrukturell überhaupt leistbar?

Erst wenn diese Basis verstanden ist, lassen sich sinnvolle Entscheidungen treffen. Entscheidungen darüber, wo KI eingesetzt wird, in welchem Umfang, und zu welchem Preis – ökonomisch wie gesellschaftlich.

Die eigentliche Frage hinter der Debatte

Am Ende dieses ersten Kapitels steht noch keine Bewertung, sondern eine Verschiebung der Perspektive. Die entscheidende Frage lautet nicht: „Ist KI nachhaltig?“ Diese Frage ist zu allgemein und lädt zu schnellen Antworten ein.

Die präzisere Frage lautet: Welche Form von KI wollen wir, und was sind wir bereit, dafür aufzuwenden? Energie, Ressourcen, Infrastruktur, politische Entscheidungen – all das ist Teil dieser Rechnung. Wer KI als reines Softwareprodukt betrachtet, übersieht diese Zusammenhänge.

In den nächsten Kapiteln geht es deshalb nicht um Hype oder Angst, sondern um Strukturen. Um Energiepolitik, Chipdesign, Standortfragen und Zukunftsszenarien. Denn erst wenn man die Maschine hinter der Magie sieht, lässt sich sinnvoll über ihre Zukunft sprechen.

Der politische Wendepunkt – wenn KI eigene Kraftwerke verlangt

Manchmal sagt ein einzelner Satz mehr über den Zustand einer Entwicklung aus als seitenlange Studien. Als Donald Trump auf dem Weltwirtschaftsforum in Davos sinngemäß erklärte, KI-Firmen sollten sich ihre Kraftwerke eben selbst bauen oder sich an der Finanzierung beteiligen, war das kein ausgearbeiteter energiepolitischer Masterplan. Aber es war ein bemerkenswert ehrlicher Moment. Denn in diesem Satz steckt eine unausgesprochene Erkenntnis:

Künstliche Intelligenz ist nicht mehr einfach ein weiterer Softwarezweig, sondern ein Industriekomplex mit massivem Energiebedarf.

Unabhängig davon, wie man Trump politisch bewertet – die Aussage trifft einen Nerv. Große KI-Unternehmen machen inzwischen offen klar, dass sie langfristig nicht mehr darauf vertrauen können, dass bestehende Stromnetze ihren Bedarf einfach „mitbedienen“. Sie benötigen planbare, dauerhafte und große Energiemengen. Und genau an diesem Punkt beginnt die politische Dimension der KI-Nachhaltigkeit.

Rechenzentren als neue Schwerindustrie

Lange Zeit galten Rechenzentren als vergleichsweise unauffällige Infrastruktur. Sie standen irgendwo am Stadtrand, verbrauchten Strom, erzeugten Wärme – und waren ansonsten kaum Thema öffentlicher Debatten. Das ändert sich gerade grundlegend.

Moderne KI-Rechenzentren bewegen sich in einer Größenordnung, die man früher nur aus der klassischen Industrie kannte. Ihr Strombedarf kann dem eines mittelgroßen Industrieparks entsprechen. Ihre Kühlanforderungen sind komplex. Ihr Flächenbedarf wächst. Und vor allem: Sie laufen nicht nur tagsüber, sondern 24 Stunden am Tag, sieben Tage die Woche.

Damit rücken sie automatisch in eine Kategorie mit Stahlwerken, Chemieanlagen oder Raffinerien. Solche Anlagen wurden früher gezielt angesiedelt, politisch begleitet und energiepolitisch eingeplant. Genau diese Fragen stellen sich nun auch bei KI-Infrastruktur – nur deutlich schneller und oft ohne klare Zuständigkeiten.

Warum Politik hier nicht ausweichen kann

Energie ist kein freier Markt im luftleeren Raum. Stromnetze, Kraftwerke und Genehmigungsverfahren sind politisch reguliert, langfristig geplant und gesellschaftlich sensibel. Wenn ein einzelnes Rechenzentrum plötzlich so viel Strom benötigt wie eine ganze Stadt, bleibt das nicht ohne Folgen.

Politik steht hier vor einem Dilemma. Einerseits gilt KI als Schlüsseltechnologie für wirtschaftliche Wettbewerbsfähigkeit, Innovation und nationale Sicherheit. Andererseits konkurriert ihr Energiebedarf direkt mit Haushalten, Mittelstand und bestehender Industrie. Steigende Strompreise, Netzausbaukosten und lokale Engpässe werden schnell zu politischen Konflikten.

Die Idee, KI-Firmen sollten ihre Energieversorgung selbst organisieren, ist daher nicht nur pragmatisch, sondern auch politisch entlastend. Sie verschiebt Verantwortung. Statt öffentliche Netze auszubauen und zu subventionieren, sollen private Akteure eigene Lösungen schaffen. Das klingt marktwirtschaftlich – hat aber weitreichende Konsequenzen.

Trump und die Tech-Energiefrage – ein politischer Einschnitt

In den USA sorgt gerade ein ungewöhnlicher energiepolitischer Vorschlag für Diskussion: Präsident Donald Trump und mehrere Gouverneure drängen darauf, große Technologieunternehmen faktisch dazu zu bringen, den Bau neuer Kraftwerke mitzufinanzieren, um die steigenden Stromkosten für private Haushalte zu begrenzen.

Hintergrund ist der massive Strombedarf von Rechenzentren, die unter anderem für KI-Dienste betrieben werden und das Netz spürbar belasten. Geplant ist eine sogenannte Zuverlässigkeitsauktion, bei der Tech-Konzerne langfristige Stromverträge abschließen sollen, die den Bau von Kraftwerken absichern – unabhängig davon, ob sie den Strom tatsächlich abnehmen oder nicht. Dies könnte Investitionen in neue Kraftwerke in Milliardenhöhe auslösen und den Druck auf öffentliche Netze verringern. Kritiker warnen jedoch vor möglichen Nebenwirkungen, etwa steigenden Kosten für kleinere Anbieter und einer stärkeren Privatisierung von Energieinfrastruktur.

Die Logik hinter „baut Euch Eure Kraftwerke selbst“

Auf den ersten Blick wirkt der Gedanke radikal. Bei näherem Hinsehen folgt er jedoch einer klaren Logik. Wer dauerhaft große Energiemengen benötigt, sollte auch an deren Erzeugung beteiligt sein. So war es in der Industrie lange üblich. Fabriken betrieben eigene Kraftwerke oder schlossen langfristige Lieferverträge ab.

Für KI-Konzerne bedeutet das konkret: eigene Kraftwerke, eigene Stromspeicher, direkte Anbindungen an Erzeuger oder exklusive Lieferverträge. Das kann Gas, Kernkraft, erneuerbare Energien oder Mischformen betreffen. Entscheidend ist nicht die Technologie, sondern die Planbarkeit.

Damit entsteht jedoch eine neue Form von Infrastruktur: private Energieinseln. Hochleistungsrechenzentren mit eigener Versorgung, eigener Priorisierung und eigener Absicherung. Sie sind weniger abhängig vom öffentlichen Netz – und damit auch weniger in klassische Ausgleichsmechanismen eingebunden.

Wenn Standortpolitik zur Energiepolitik wird

Spätestens hier wird klar, warum KI-Infrastruktur politisch brisant ist. Der Standort eines Rechenzentrums wird nicht mehr nur nach Steuerrecht oder Arbeitskräften ausgewählt, sondern nach Energieverfügbarkeit, Genehmigungslage und politischer Berechenbarkeit.

Regionen mit stabilen Netzen, günstigen Energiequellen und schneller Genehmigung werden attraktiver. Andere fallen zurück. Das kann bestehende Ungleichgewichte verstärken – zwischen Ländern, innerhalb von Staaten und sogar zwischen Kommunen.

Für lokale Entscheidungsträger ist das eine neue Situation. Einerseits versprechen Rechenzentren Investitionen und Prestige. Andererseits bringen sie kaum Arbeitsplätze, aber hohe Infrastrukturkosten. Straßen, Netze, Wasseranschlüsse und Sicherheitsmaßnahmen müssen bereitgestellt werden, während der direkte Nutzen begrenzt bleibt.

Was in nationalen Strategien abstrakt klingt, wird vor Ort sehr konkret. Bürger fragen, warum neue Leitungen gebaut werden. Warum Wasser knapper wird. Warum Strompreise steigen. Und warum all das geschieht, damit irgendwo Texte generiert oder Bilder berechnet werden.

Diese Akzeptanzfrage wird oft unterschätzt. Während klassische Industrieprodukte greifbar sind, bleibt der Nutzen von KI für viele Menschen diffus. Das erschwert politische Kommunikation. Nachhaltigkeit ist hier nicht nur eine technische, sondern auch eine soziale Kategorie. Je sichtbarer die Infrastruktur wird, desto stärker wächst der Rechtfertigungsdruck. KI kann nicht dauerhaft als unsichtbarer Dienst betrachtet werden, wenn ihre physischen Spuren immer deutlicher werden.

Machtverschiebung durch Energieautarkie

Ein weiterer Aspekt wird selten offen diskutiert: Energieautarkie schafft Macht. Wer seine eigene Versorgung kontrolliert, ist weniger abhängig von politischen Entscheidungen, Netzausfällen oder regulatorischen Eingriffen.

Für große Tech-Konzerne ist das attraktiv. Für Staaten kann es problematisch sein. Denn klassische Instrumente der Steuerung – Netzentgelte, Priorisierung, Abschaltungen – greifen weniger, wenn kritische Infrastruktur privat organisiert ist.

Damit entsteht eine neue Verhandlungsebene zwischen Politik und Technologieunternehmen. Nicht mehr nur über Daten oder Regulierung, sondern über Energie, Flächen und langfristige Ressourcen.

Der Wendepunkt ist erreicht

Das erste Kapitel hat gezeigt, dass KI physisch ist. Dieses Kapitel zeigt, dass diese Physik politisch wird. Die Aussage, KI-Firmen sollten ihre Kraftwerke selbst bauen, markiert keinen Ausrutscher, sondern einen Wendepunkt. Sie macht sichtbar, was bislang oft ausgeblendet wurde: KI ist nicht nur eine Frage von Algorithmen, sondern von Infrastruktur, Macht und Verantwortung.

In den nächsten Kapiteln wird es deshalb noch konkreter. Es geht um Strommengen, Kühlung, Wasser und technische Grenzen. Denn erst wenn diese Grundlagen verstanden sind, lässt sich realistisch über Nachhaltigkeit sprechen – jenseits von Schlagworten und wohlklingenden Absichtserklärungen.

Stromhunger, Kühlung, Wasser – die physische Realität der KI

Solange KI als Softwarephänomen betrachtet wird, bleiben Zahlen abstrakt. Ein paar Prozent mehr Rechenleistung hier, ein neues Modell dort. Doch sobald man beginnt, den Energiebedarf in Kilowattstunden, Megawatt oder gar Terawattstunden zu denken, verändert sich die Perspektive. Dann geht es nicht mehr um technische Spielereien, sondern um reale Ressourcen, um Netze, Kraftwerke und Verteilungskonflikte.

Dieses Kapitel widmet sich genau dieser Ebene. Nicht, um Angst zu erzeugen, sondern um ein realistisches Bild zu zeichnen. Denn Nachhaltigkeit beginnt dort, wo abstrakte Begriffe in physische Grenzen übersetzt werden.

Wie viel Strom KI wirklich verbraucht

Eine der meistgestellten Fragen lautet: „Wie viel Strom verbraucht KI eigentlich?“ Die ehrliche Antwort ist: Es kommt darauf an. Auf das Modell, die Nutzung, den Standort, die Hardware. Trotzdem lassen sich Größenordnungen benennen – und die sind aufschlussreich.

Große KI-Rechenzentren bewegen sich heute in Leistungsbereichen, die früher für ganze Industrieareale typisch waren. Einzelne Anlagen benötigen mehrere hundert Megawatt Anschlussleistung. Das entspricht dem Strombedarf von zehntausenden Haushalten. Und das ist kein einmaliger Spitzenwert, sondern eine dauerhafte Last.

Wichtig ist dabei: KI erzeugt keinen saisonalen Verbrauch wie Heizungen oder Klimaanlagen. Sie läuft kontinuierlich. Das macht sie zu einer sogenannten Grundlast. Genau diese Art von Verbrauch ist für Stromnetze besonders anspruchsvoll, weil sie dauerhaft abgesichert werden muss.

Der entscheidende Punkt ist nicht, ob dieser Strombedarf „zu hoch“ ist, sondern wie schnell er wächst. Während klassische Industrien oft über Jahrzehnte expandierten, wächst KI-Infrastruktur in wenigen Jahren. Netze, Kraftwerke und Genehmigungsverfahren sind auf dieses Tempo nicht ausgelegt.

Warum Prognosen oft missverstanden werden

In der öffentlichen Diskussion werden gerne große Zahlen zitiert. Verdopplung des Stromverbrauchs, explodierende Nachfrage, massive Belastungen. Solche Aussagen sind nicht falsch, werden aber häufig missverstanden.

Sie bedeuten nicht, dass morgen das Licht ausgeht. Sie bedeuten, dass langfristige Planungen unter Druck geraten. Stromnetze werden für bestimmte Lastprofile gebaut. Wenn sich diese Profile grundlegend ändern, entstehen Engpässe – lokal, regional oder national.

Das Problem ist weniger der absolute Verbrauch als die Konzentration. KI-Rechenzentren stehen nicht gleichmäßig verteilt. Sie ballen sich dort, wo Netze, Kühlung und politische Rahmenbedingungen passen. Genau dort entstehen dann Konflikte.

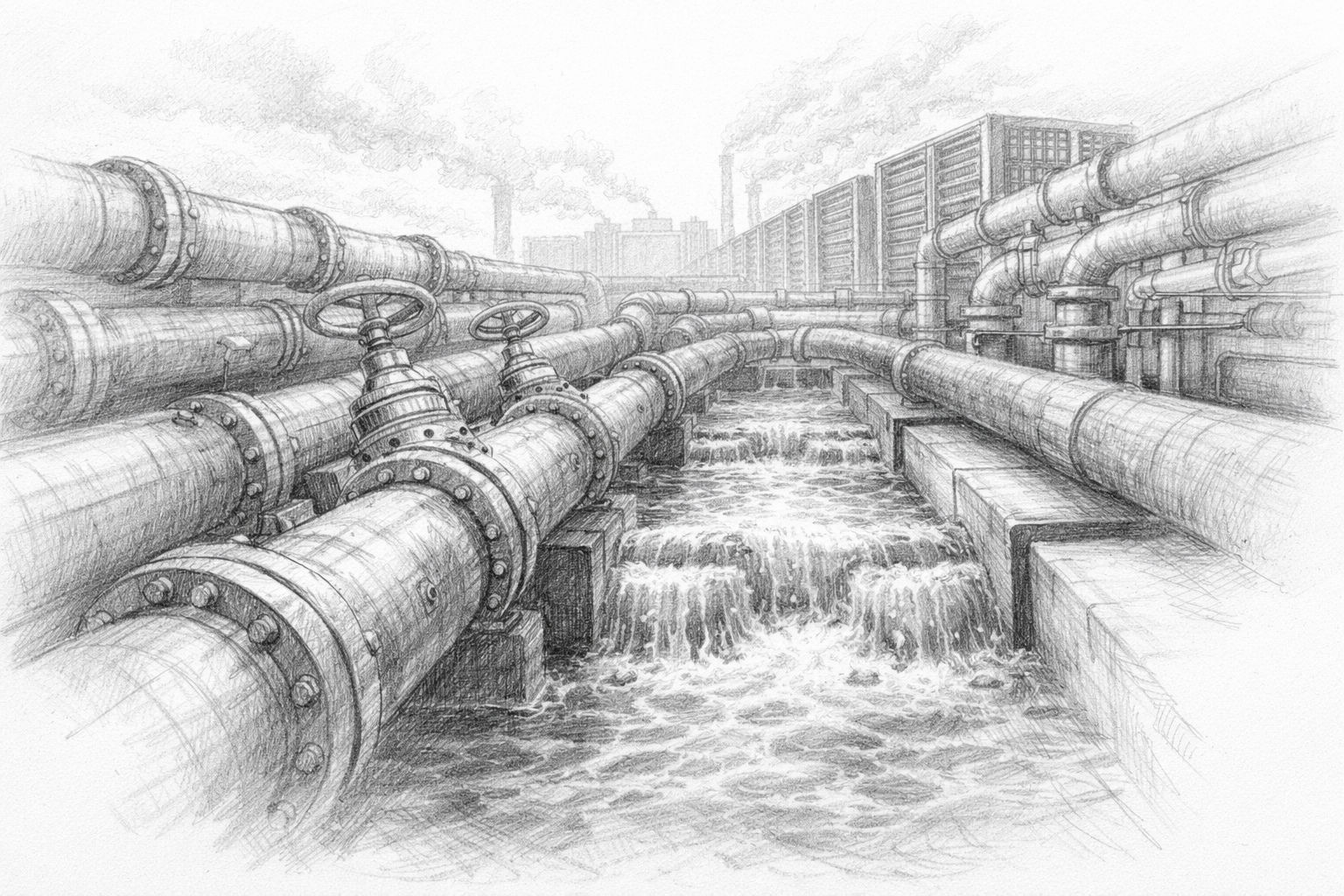

Kühlung: Das unsichtbare zweite System

Strom ist nur die halbe Wahrheit. Jede Kilowattstunde, die ein Rechenzentrum verbraucht, wird früher oder später zu Wärme. Diese Wärme muss abgeführt werden, sonst bricht der Betrieb zusammen. Kühlung ist daher kein Zusatz, sondern ein zentrales Betriebssystem moderner KI-Infrastruktur.

Früher reichte Luftkühlung. Ventilatoren, Klimaanlagen, warme Abluft. Mit der steigenden Leistungsdichte moderner Chips stößt dieses Prinzip an seine Grenzen. Heute kommen zunehmend Flüssigkühlungen zum Einsatz, bei denen Kühlmittel direkt an die Prozessoren herangeführt werden. Diese Systeme sind effizienter, aber komplexer. Sie benötigen Pumpen, Wärmetauscher, Notfallmechanismen. Und sie erzeugen neue Abhängigkeiten: von Wasser, von chemischen Kühlmitteln, von stabilen Temperaturen.

Kühlung ist kein Detailproblem. Sie entscheidet darüber, wo Rechenzentren überhaupt betrieben werden können. Regionen mit hohen Außentemperaturen, knappen Wasserressourcen oder instabilen Netzen geraten ins Hintertreffen.

Wasser: Der oft verdrängte Engpass

Während über Strom viel gesprochen wird, bleibt Wasser erstaunlich oft außen vor. Dabei ist es in vielen Kühlkonzepten unverzichtbar. Verdunstungskühlung, Rückkühlwerke, Wärmetauscher – all das benötigt Wasser in relevanten Mengen. In wasserreichen Regionen fällt das kaum auf. In trockenen Gebieten hingegen wird Wasser schnell zum politischen Thema. Wenn Rechenzentren mit Landwirtschaft, Industrie und Haushalten konkurrieren, entstehen Verteilungskonflikte. Und diese lassen sich nicht einfach mit Geld lösen.

Hinzu kommt: Wasserverbrauch ist lokal. Strom kann über Netze transportiert werden, Wasser nur begrenzt. Das macht den Standortfaktor noch kritischer. Ein Rechenzentrum kann nicht einfach dort gebaut werden, wo die Grundstücke günstig sind, wenn das Wasser fehlt.

Die Nachhaltigkeitsdebatte über KI wird deshalb zwangsläufig regionaler werden. Was global sinnvoll erscheint, kann lokal problematisch sein.

Häufig wird argumentiert, neue Technik werde das Problem entschärfen. Effizientere Chips, bessere Kühlung, optimierte Software. Das ist nicht falsch – aber unvollständig. Effizienzgewinne senken den Verbrauch pro Recheneinheit. Gleichzeitig sinken die Kosten und Hürden für den Einsatz. Das führt oft dazu, dass KI häufiger und in neuen Bereichen genutzt wird. Der Gesamteffekt kann dann sogar ein höherer Verbrauch sein.

Dieses Muster kennt man aus anderen Bereichen. Effizientere Motoren führten nicht zu weniger Verkehr, sondern zu mehr. Effizientere Beleuchtung senkte nicht automatisch den Stromverbrauch, sondern erhöhte die Nutzung. KI folgt demselben Prinzip.

Nachhaltigkeit lässt sich daher nicht allein technisch lösen. Sie ist immer auch eine Frage der Begrenzung, der Priorisierung und der bewussten Entscheidung.

Stromnetze als Flaschenhals

Ein weiterer Aspekt wird oft unterschätzt: das Stromnetz selbst. Kraftwerke zu bauen ist aufwendig, aber Netze auszubauen ist häufig noch komplizierter. Genehmigungen, Trassen, Akzeptanz – all das braucht Zeit.

KI-Rechenzentren benötigen nicht nur viel Strom, sondern auch stabile Netze. Spannungsschwankungen, Ausfälle oder Engpässe können teure Schäden verursachen. Deshalb bevorzugen Betreiber Standorte mit hoher Netzqualität. Das führt zu einer paradoxen Situation. Gerade dort, wo Netze gut ausgebaut sind, steigt der Druck am stärksten. Neue Großverbraucher verschärfen bestehende Engpässe. Der Ausbau hinkt hinterher.

Hier zeigt sich erneut: KI ist kein isoliertes System. Sie wirkt auf bestehende Infrastrukturen zurück und verändert deren Anforderungen.

Spätestens an diesem Punkt wird klar, dass die physische Realität der KI nicht losgelöst von gesellschaftlichen Fragen betrachtet werden kann. Strom, Wasser und Netze sind Gemeingüter. Ihre Nutzung ist politisch geregelt und sozial sensibel.

Je mehr KI diese Ressourcen beansprucht, desto stärker wird die Frage nach Prioritäten:

- Wofür setzen wir Energie ein?

- Welche Anwendungen rechtfertigen welchen Aufwand?

- Und wer entscheidet darüber?

Diese Fragen lassen sich nicht allein von Technikern beantworten. Sie betreffen Politik, Wirtschaft und Gesellschaft gleichermaßen.

Die unbequeme Erkenntnis

Dieses Kapitel führt zu einer unbequemen, aber notwendigen Erkenntnis: KI ist kein „sauberes“ digitales Produkt. Sie ist eingebettet in eine materielle Welt mit endlichen Ressourcen. Jede Nutzung hat einen Preis, auch wenn er nicht sofort sichtbar ist.

Nachhaltigkeit bedeutet in diesem Kontext nicht Verzicht, sondern Bewusstsein. Bewusstsein für Größenordnungen, für Zusammenhänge und für Folgen. Erst wenn diese Realität anerkannt wird, lassen sich tragfähige Lösungen entwickeln.

Im nächsten Kapitel richtet sich der Blick auf die Technik selbst – auf Chips, Effizienzversprechen und die Frage, ob technischer Fortschritt allein ausreicht, um diese Herausforderungen zu bewältigen.

KI und Wasserkrise: Warum verbrauchen Rechenzentren zu viel Wasser? | DW Deutsch

Chips, Effizienz und die Illusion vom technischen Selbstheilungsprozess

Wenn die Rede auf den enormen Energiebedarf von KI kommt, folgt fast reflexhaft ein beruhigender Satz: Die Technik wird effizienter. Neue Chips, bessere Software, intelligentere Kühlung – das Problem erledigt sich mit der nächsten Generation. Diese Hoffnung ist verständlich. Sie speist sich aus jahrzehntelanger Erfahrung. Computer wurden kleiner, schneller, sparsamer. Warum sollte das bei KI anders sein?

Die kurze Antwort lautet: Effizienzgewinne sind real, aber sie lösen das Grundproblem nicht automatisch. Im Gegenteil – sie können es sogar verschärfen. Um das zu verstehen, lohnt sich ein genauer Blick auf die Technik hinter der KI und auf die Dynamiken, die Effizienz auslöst.

Warum spezialisierte Chips so viel leisten – und so viel verbrauchen

Moderne KI läuft nicht mehr auf klassischen Universalprozessoren. Sie benötigt spezialisierte Recheneinheiten, die viele einfache Berechnungen parallel ausführen können. Genau hier liegen ihre Stärken – und ihre Schwächen. Diese Chips sind darauf ausgelegt, enorme Datenmengen gleichzeitig zu verarbeiten. Sie rechnen nicht Schritt für Schritt, sondern in großen Blöcken. Das macht sie extrem leistungsfähig, aber auch energiehungrig. Je dichter die Rechenleistung gepackt wird, desto größer wird die Abwärme, desto komplexer die Kühlung.

Der entscheidende Punkt ist: Diese Chips werden nicht gebaut, um sparsam zu sein, sondern um maximalen Durchsatz zu liefern. Effizienz spielt eine Rolle, aber Leistung steht im Vordergrund. Denn im Wettbewerb um KI-Fähigkeiten zählt Geschwindigkeit. Wer schneller trainiert, wer größere Modelle betreibt, verschafft sich Vorteile.

Damit entsteht ein struktureller Zielkonflikt. Effizienz wird verbessert, aber nicht auf Kosten der Leistungssteigerung. Der Gesamtverbrauch sinkt nicht zwangsläufig, sondern verlagert sich.

Performance pro Watt – eine wichtige, aber begrenzte Kennzahl

In den letzten Jahren hat sich eine neue Kennzahl etabliert: Performance pro Watt. Sie beschreibt, wie viel Rechenleistung mit einer bestimmten Energiemenge erzielt wird. Diese Kennzahl ist sinnvoll, weil sie Effizienz sichtbar macht. Sie ist aber kein Allheilmittel.

Ein System, das doppelt so effizient ist, verbraucht für dieselbe Aufgabe nur halb so viel Energie. Doch wenn es dadurch viermal so häufig eingesetzt wird, steigt der Gesamtverbrauch. Genau dieses Muster zeigt sich immer wieder.

Performance pro Watt ist eine technische Optimierung. Nachhaltigkeit hingegen ist eine Systemfrage. Sie hängt davon ab, wie Technik genutzt wird, nicht nur davon, wie gut sie gebaut ist.

Warum Effizienz oft zu mehr Nutzung führt

Dieses Phänomen ist nicht neu. Es wurde schon im 19. Jahrhundert beschrieben, lange bevor es Computer gab. Effizienz senkt Kosten und Hürden. Was günstiger und schneller wird, wird häufiger genutzt. Ausnahmen sind selten.

Bei KI ist dieser Effekt besonders stark. Je effizienter Modelle werden, desto einfacher lassen sie sich in neue Anwendungen integrieren. Texte, Bilder, Videos, Simulationen – alles wird plötzlich möglich, wo es vorher zu teuer oder zu langsam war.

Das führt nicht zu Einsparungen, sondern zu einer Ausweitung. KI ersetzt nicht nur bestehende Prozesse, sie erzeugt neue. Effizienz wird zum Wachstumstreiber.

Wer Nachhaltigkeit allein über technische Optimierung denkt, übersieht diese Dynamik. Es ist, als würde man hoffen, dass effizientere Autos den Verkehr reduzieren.

Der Mythos vom „nächsten großen Durchbruch“

Ein weiteres verbreitetes Argument lautet: Die nächste Chipgeneration wird alles verändern. Quantensprünge, neue Materialien, revolutionäre Architekturen. Solche Durchbrüche sind nicht ausgeschlossen, aber sie sind selten – und sie lösen selten alle Probleme zugleich.

Selbst wenn ein Chip doppelt oder dreifach effizienter wird, bleibt das Grundmuster bestehen. KI wächst, skaliert, breitet sich aus. Jeder Durchbruch wird sofort in neue Anwendungen übersetzt. Der technische Fortschritt wird absorbiert, nicht genutzt, um zu begrenzen.

Hinzu kommt: Viele Effizienzgewinne sind bereits eingepreist. Die einfache Optimierung ist gemacht. Weitere Fortschritte werden komplexer, teurer und langsamer. Gleichzeitig steigt die Nachfrage schneller, als die Effizienz zunimmt.

Lokale KI als Gegenmodell – mit Grenzen

Ein häufig genanntes Gegenmodell ist lokale KI. Kleinere Modelle, weniger Rechenleistung, geringerer Energiebedarf. Dieses Modell ist attraktiv, weil es Skalierung bremst und Abhängigkeiten reduziert.

Doch auch hier gilt: Lokale KI ersetzt nicht alle Anwendungen. Große Modelle, komplexe Analysen und globale Dienste lassen sich nicht einfach dezentralisieren. Lokale Effizienz entlastet das System, aber sie hebt die Grunddynamik nicht auf.

Nachhaltigkeit entsteht nicht automatisch durch Dezentralisierung. Sie entsteht durch bewusste Auswahl dessen, was lokal sinnvoll ist – und dessen, was man vielleicht nicht tun sollte.

Warum Technik allein keine Verantwortung übernimmt

Technik optimiert, was man ihr vorgibt. Sie kennt keine Ziele jenseits dieser Optimierung. Nachhaltigkeit hingegen ist ein normatives Ziel. Es setzt voraus, dass jemand Grenzen zieht, Prioritäten setzt und Entscheidungen trifft. Wer hofft, Technik werde diese Verantwortung übernehmen, verwechselt Mittel und Zweck. Effiziente Chips sind Werkzeuge. Ob sie zu mehr oder weniger Verbrauch führen, entscheidet ihr Einsatz.

In diesem Punkt unterscheidet sich KI nicht von früheren Technologien. Der Unterschied liegt nur in der Geschwindigkeit und im Ausmaß.

Die unbequeme Rolle der Begrenzung

Begrenzung ist kein populäres Wort. Es klingt nach Verzicht, nach Stillstand. In Wirklichkeit ist Begrenzung eine Form von Steuerung. Sie entscheidet, wo Technik sinnvoll ist und wo nicht.

Nachhaltige KI wird nicht dadurch entstehen, dass alles effizienter wird. Sie wird entstehen, wenn man entscheidet, welche Anwendungen Priorität haben und welche verzichtbar sind. Diese Entscheidung ist nicht technisch, sondern politisch und gesellschaftlich. Effizienz kann helfen. Sie kann entlasten. Aber sie ersetzt keine Entscheidung.

Dieses Kapitel führt zu einem klaren Zwischenfazit: Technischer Fortschritt ist unverzichtbar, aber er löst das Nachhaltigkeitsproblem nicht von selbst. Effizientere Chips, bessere Software und optimierte Kühlung sind Teil der Lösung – aber nur ein Teil. Wer Nachhaltigkeit ernst nimmt, muss über Nutzung, Skalierung und Begrenzung sprechen. Über Ziele, nicht nur über Mittel.

Im nächsten Kapitel richtet sich der Blick deshalb weg von der reinen Technik und hin zur Energiefrage selbst. Woher soll der Strom kommen, den KI dauerhaft benötigt? Und welche Optionen sind realistisch, jenseits von Ideologie und Wunschdenken?

Energiebedarf von KI: Eine wachsende Herausforderung | DW Deutsch

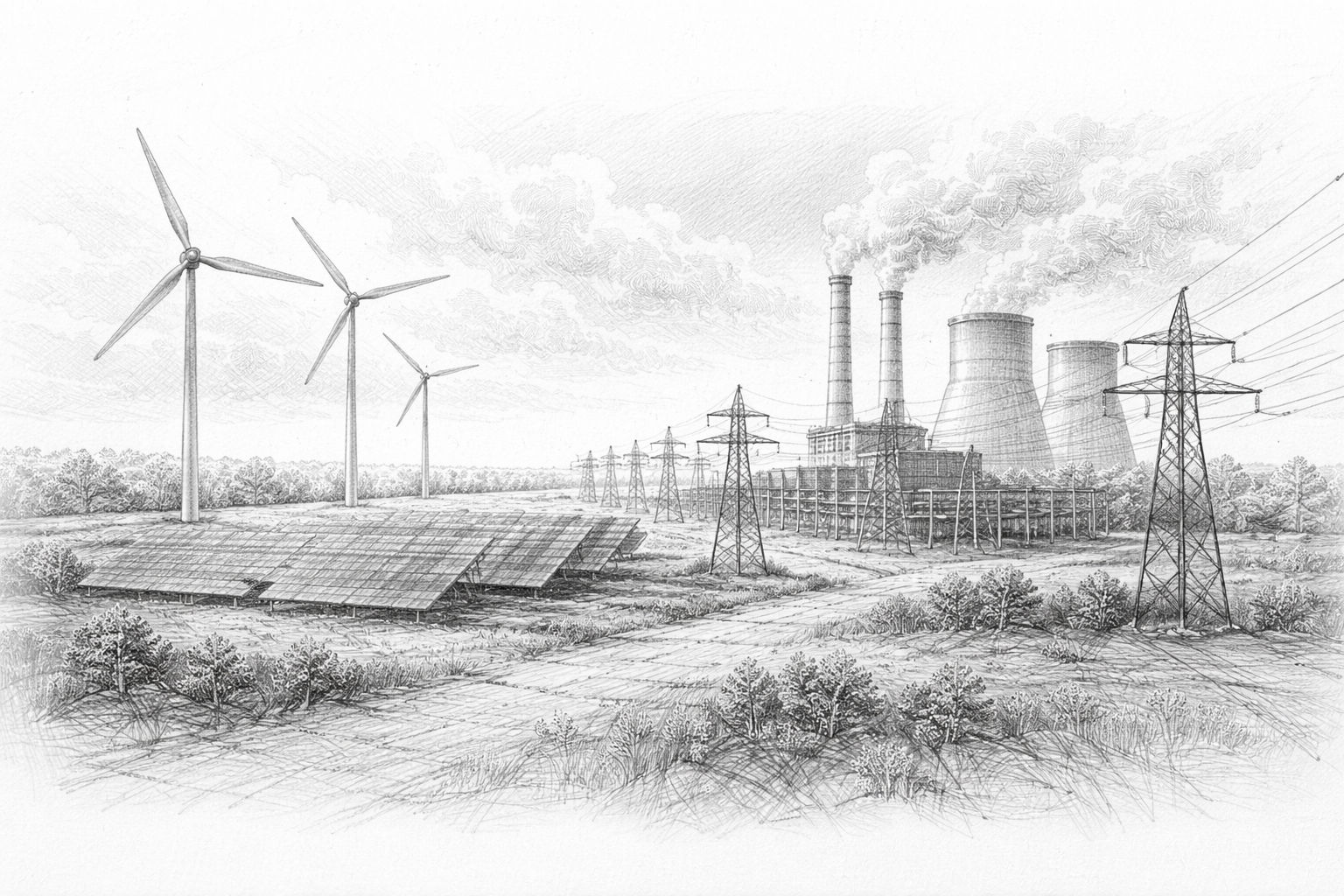

Woher soll der Strom kommen? – Energieoptionen ohne Ideologie

Spätestens an diesem Punkt lässt sich die Nachhaltigkeitsfrage nicht mehr abstrakt führen. Wenn KI dauerhaft große Mengen Strom benötigt, stellt sich zwangsläufig die einfache, aber unbequeme Frage: Woher soll dieser Strom kommen? Nicht theoretisch, sondern praktisch. Nicht irgendwann, sondern kontinuierlich.

Diese Frage ist deshalb so brisant, weil sie alte energiepolitische Konflikte mit neuer Dringlichkeit auflädt. KI ist kein gelegentlicher Verbraucher, sondern eine dauerhafte Last. Sie braucht Strom dann, wenn er gebraucht wird – nicht nur dann, wenn die Sonne scheint oder der Wind weht. Das macht sie zu einem Prüfstein für jedes Energiesystem.

Warum KI Grundlast braucht

KI-Systeme lassen sich nicht beliebig an- und abschalten. Trainingsläufe dauern oft Tage oder Wochen. Dienste müssen rund um die Uhr erreichbar sein. Unterbrechungen sind nicht nur ärgerlich, sondern wirtschaftlich teuer. Damit ähnelt der Energiebedarf von KI klassischen Industrien mit kontinuierlichem Betrieb. Sie benötigen sogenannte Grundlastfähigkeit. Das bedeutet: Strom muss jederzeit in ausreichender Menge verfügbar sein, unabhängig von Tageszeit, Wetter oder Jahreszeit.

Genau hier beginnen die Schwierigkeiten. Viele Energiequellen liefern Strom nicht konstant. Sie sind schwankend oder saisonal. Das ist kein grundsätzliches Problem, solange ausreichend Ausgleich vorhanden ist. Doch dieser Ausgleich ist teuer, technisch anspruchsvoll und oft politisch umstritten.

Erneuerbare Energien: unverzichtbar, aber nicht allein ausreichend

Erneuerbare Energien spielen eine zentrale Rolle in jeder nachhaltigen Zukunft. Daran besteht kaum Zweifel. Sie sind klimafreundlich, zunehmend kostengünstig und gesellschaftlich akzeptiert. Dennoch stoßen sie bei grundlastintensiven Anwendungen wie KI an Grenzen.

Solar- und Windenergie liefern Strom dann, wenn die Bedingungen stimmen. Speicher können Schwankungen ausgleichen, aber nur begrenzt. Große Speicher über Tage oder Wochen sind technisch möglich, aber teuer und flächenintensiv.

Für KI-Rechenzentren bedeutet das: Erneuerbare Energien können einen wichtigen Beitrag leisten, aber sie garantieren keine durchgehende Versorgung. Ohne zusätzliche Maßnahmen bleibt eine Versorgungslücke. Diese Lücke muss geschlossen werden – sonst bleibt die Nachhaltigkeit rechnerisch, aber nicht real.

Kernkraft: die unbequeme Renaissance

Kaum ein Energiethema ist so emotional aufgeladen wie die Kernkraft. Umso bemerkenswerter ist es, dass sie im Kontext von KI plötzlich wieder nüchtern diskutiert wird. Nicht aus Begeisterung, sondern aus Bedarf.

Kernkraft liefert große Mengen Strom kontinuierlich, mit geringer Flächeninanspruchnahme und unabhängig vom Wetter. Genau das macht sie für energiehungrige Rechenzentren attraktiv. Nicht als Allheilmittel, sondern als stabile Basis.

Für KI-Unternehmen zählt weniger die gesellschaftliche Debatte als die technische Realität. Planbarkeit, Versorgungssicherheit und langfristige Verträge stehen im Vordergrund. Dass große Technologiekonzerne sich wieder für Kernenergie interessieren, ist daher weniger ideologisch als pragmatisch.

Gleichzeitig bleiben die bekannten Probleme bestehen: lange Bauzeiten, hohe Kosten, Endlagerfragen, politische Akzeptanz. Kernkraft ist keine schnelle Lösung, sondern eine langfristige Entscheidung mit hohen Eintrittshürden.

Gas: Brücke mit Risiken

Erdgas gilt oft als flexible Ergänzung. Es lässt sich relativ schnell hoch- und runterfahren, Kraftwerke sind vergleichsweise schnell zu bauen, die Technik ist erprobt. Für KI-Rechenzentren kann Gas eine Brückenlösung darstellen.

Doch diese Brücke hat Risse. Gas ist fossil. Es verursacht Emissionen und bleibt geopolitisch sensibel. Auch mit CO₂-Abscheidung bleibt ein Restproblem. Zudem ist Gas preislich volatil. Für langfristige Planung ist das ein Risiko.

Trotzdem wird Gas in vielen Szenarien eine Rolle spielen. Nicht, weil es ideal ist, sondern weil Alternativen fehlen. Nachhaltigkeit bedeutet hier oft, zwischen schlechten und weniger schlechten Optionen zu wählen.

Speicher, Netze und der unterschätzte Aufwand

Häufig wird argumentiert, Speicher würden das Problem lösen. Große Batterien, Wasserstoff, Pumpspeicher. All diese Technologien existieren – aber sie skalieren nicht beliebig.

Speicher sind teuer, materialintensiv und selbst energiehungrig. Sie sind sinnvoll, um Schwankungen auszugleichen, aber sie ersetzen keine dauerhafte Erzeugung. Je größer der Verbrauch, desto größer muss auch der Speicher sein. Das ist keine theoretische, sondern eine physische Grenze.

Hinzu kommen Netze. Strom muss nicht nur erzeugt, sondern auch transportiert werden. Hochleistungsrechenzentren benötigen leistungsfähige Anbindungen. Der Ausbau dieser Netze ist aufwendig, langwierig und konfliktträchtig.

Private Energieversorgung: Rückkehr zu alten Mustern

Angesichts dieser Herausforderungen gewinnt ein alter Gedanke neue Aktualität: private Energieversorgung. Große Industrien betrieben früher eigene Kraftwerke oder schlossen exklusive Lieferverträge. KI-Konzerne bewegen sich zunehmend in diese Richtung.

Eigene Kraftwerke, eigene Speicher, direkte Anbindungen – all das reduziert Abhängigkeiten. Gleichzeitig entzieht es diese Infrastruktur teilweise der öffentlichen Steuerung. Strom wird zur privaten Ressource.

Diese Entwicklung ist rational, aber gesellschaftlich nicht neutral. Sie verschiebt Machtverhältnisse. Wer Energie kontrolliert, kontrolliert Handlungsspielräume. Das gilt für Staaten ebenso wie für Unternehmen.

Nachhaltigkeit ohne Illusionen

An diesem Punkt wird deutlich, warum ideologische Debatten wenig helfen. Es gibt keine perfekte Lösung. Jede Energiequelle hat Vor- und Nachteile. Jede Entscheidung bringt Zielkonflikte mit sich.

Nachhaltigkeit bedeutet hier nicht, die „richtige“ Technologie zu finden, sondern die Konsequenzen jeder Option offen zu benennen. Welche Risiken akzeptieren wir? Welche Abhängigkeiten gehen wir ein? Welche Kosten tragen wir – und wer trägt sie?

KI zwingt uns, diese Fragen neu zu stellen, weil sie den Energiebedarf verdichtet und beschleunigt.

Dieses Kapitel markiert eine Verschiebung im Denken. Die Frage ist nicht mehr, ob KI nachhaltig betrieben werden kann, sondern unter welchen Bedingungen. Energie ist dabei der limitierende Faktor. Nicht Rechenleistung, nicht Software, sondern Strom.

Im nächsten Kapitel geht es deshalb um die Zukunftsbilder, die aus diesen Bedingungen entstehen. Nicht als Prognose, sondern als Szenarien. Denn wie nachhaltig KI wird, entscheidet sich nicht an einem einzelnen Durchbruch, sondern an der Summe unserer Entscheidungen.

Aktuelle Umfrage zur Nutzung lokaler KI-Systeme

Drei Zukunftsszenarien – wie nachhaltig KI wirklich werden kann

Nach fünf Kapiteln voller Zahlen, technischer Grenzen und politischer Spannungen könnte leicht der Eindruck entstehen, KI steuere zwangsläufig auf ein Nachhaltigkeitsproblem zu, das sich kaum noch einfangen lässt. Diese Sicht wäre verständlich – aber sie wäre zu kurz gegriffen.

Die Zukunft der KI ist nicht festgeschrieben. Sie entsteht nicht aus einem einzelnen technologischen Durchbruch, sondern aus vielen Entscheidungen, die heute und in den kommenden Jahren getroffen werden. Entscheidungen darüber, wie KI genutzt wird, wo sie betrieben wird und welchen Stellenwert sie im Verhältnis zu anderen gesellschaftlichen Zielen einnimmt.

Um diese Offenheit greifbar zu machen, hilft es, nicht von einer einzigen Zukunft zu sprechen, sondern von möglichen Entwicklungspfaden. Drei solcher Szenarien lassen sich bereits heute erkennen. Keines davon ist garantiert, keines davon ist völlig unrealistisch. Wahrscheinlich wird die Realität Elemente aus allen dreien enthalten.

Szenario 1: Zentralisierung und Energie-Enklaven

In diesem Szenario setzt sich die Logik der Skalierung konsequent fort. Große KI-Anbieter bündeln Rechenleistung in wenigen, extrem leistungsfähigen Standorten. Diese Standorte verfügen über eigene Energiequellen, eigene Netzanbindungen und teilweise eigene Speicherlösungen. Sie sind hochoptimiert, abgeschottet und effizient im industriellen Sinne.

Der Vorteil dieses Modells liegt auf der Hand. Energieversorgung wird planbar, Ausfälle werden minimiert, Kosten lassen sich langfristig kalkulieren. KI wird zuverlässig, leistungsfähig und global verfügbar. Für Unternehmen und Staaten, die auf technologische Führungspositionen setzen, ist dieses Szenario attraktiv.

Der Preis ist ebenfalls klar. Energie wird stärker privatisiert. Infrastruktur entzieht sich teilweise der öffentlichen Steuerung. Regionale Ungleichgewichte nehmen zu. Die Akzeptanz vor Ort wird zur Dauerbaustelle. Nachhaltigkeit wird hier vor allem technisch verstanden, weniger gesellschaftlich.

Dieses Szenario ist realistisch, weil es an bestehende Muster anschließt. Es ist kein radikaler Bruch, sondern eine Fortsetzung industrieller Logik mit neuen Mitteln.

Szenario 2: Effizienz, Regulierung und bewusste Begrenzung

Ein anderes Zukunftsbild setzt stärker auf Steuerung. In diesem Szenario erkennen Politik und Gesellschaft, dass unbegrenzte Skalierung weder technisch noch sozial sinnvoll ist. KI wird gezielt eingesetzt, priorisiert und reguliert.

Effizienz bleibt wichtig, aber sie wird ergänzt durch Rahmenbedingungen. Bestimmte Anwendungen werden bevorzugt, andere bewusst eingeschränkt. Energieintensive Trainingsläufe unterliegen Auflagen. Standortentscheidungen werden stärker koordiniert. Nachhaltigkeit wird nicht dem Markt allein überlassen.

Der Vorteil dieses Modells liegt in der Balance. KI bleibt leistungsfähig, aber eingebettet. Energie- und Infrastrukturfragen werden gemeinsam gedacht. Belastungen werden transparenter verteilt.

Der Nachteil liegt in der Komplexität. Regulierung kostet Zeit, Abstimmung kostet Geschwindigkeit. Innovationsdruck kollidiert mit Planungsprozessen. Dieses Szenario erfordert politische Handlungsfähigkeit und gesellschaftlichen Konsens – beides ist nicht selbstverständlich. Dennoch ist dieses Szenario nicht utopisch. Viele Industrien wurden auf ähnliche Weise eingebettet, ohne ihre Leistungsfähigkeit zu verlieren. Es setzt voraus, dass KI nicht als Selbstzweck betrachtet wird, sondern als Werkzeug.

Szenario 3: Dezentrale und lokale KI

Das dritte Szenario verschiebt den Fokus. Statt immer größere zentrale Systeme zu bauen, wird KI stärker dezentral eingesetzt. Kleinere Modelle, lokale Rechenleistung, spezialisierte Anwendungen. Nicht jede Aufgabe benötigt maximale Leistung.

In diesem Modell wird KI näher an den Ort der Nutzung gebracht. Unternehmen betreiben eigene Systeme. Geräte werden leistungsfähiger. Daten bleiben lokal. Der Energiebedarf pro Anwendung sinkt, weil Skalierung begrenzt ist.

Der Vorteil liegt in der Robustheit. Abhängigkeiten werden reduziert. Infrastruktur wird entlastet. Nachhaltigkeit entsteht durch Maßhalten, nicht durch maximale Effizienz. Die Grenzen dieses Modells sind ebenfalls klar. Große, komplexe Anwendungen lassen sich nicht vollständig dezentralisieren. Forschung, globale Dienste und hochkomplexe Analysen benötigen weiterhin zentrale Ressourcen.

Dieses Szenario ist kein Ersatz für die anderen, sondern eine Ergänzung. Es zeigt, dass Nachhaltigkeit auch durch Vielfalt entstehen kann – nicht alles muss gleich groß, gleich schnell und gleich leistungsfähig sein.

Warum es kein „richtiges“ Szenario gibt

Diese drei Zukunftsbilder stehen nicht in einem Entweder-oder-Verhältnis. Sie sind eher unterschiedliche Antworten auf dieselbe Herausforderung. Je nach Anwendung, Region und Zielsetzung werden unterschiedliche Lösungen sinnvoll sein.

Der entscheidende Punkt ist nicht, welches Szenario sich durchsetzt, sondern ob die zugrunde liegenden Entscheidungen bewusst getroffen werden. Nachhaltigkeit entsteht nicht automatisch aus Technik. Sie entsteht aus Prioritäten.

Wenn KI überall und jederzeit eingesetzt wird, wächst ihr Energiebedarf zwangsläufig. Wenn sie gezielt eingesetzt wird, lässt sich dieser Bedarf steuern. Das ist keine moralische Wertung, sondern eine nüchterne Feststellung.

Die eigentliche Frage hinter der Nachhaltigkeit

Am Ende dieses Artikels steht keine einfache Antwort. Die Frage „Ist KI nachhaltig?“ führt in die Irre. Sie suggeriert, es gäbe ein klares Ja oder Nein.

Die sinnvollere Frage lautet: Wofür setzen wir KI ein – und was sind wir bereit, dafür aufzuwenden? Energie, Ressourcen, Infrastruktur, politische Aufmerksamkeit. Diese Frage lässt sich nicht an Algorithmen delegieren.

KI ist ein Werkzeug mit enormem Potenzial. Sie kann Prozesse effizienter machen, Wissen zugänglicher, Entscheidungen fundierter. Gleichzeitig beansprucht sie reale Ressourcen. Beides ist wahr.

Ein vorsichtig optimistischer Ausblick

Trotz aller Herausforderungen gibt es Grund für vorsichtigen Optimismus. Die Probleme sind sichtbar. Sie werden diskutiert. Sie lassen sich benennen. Das ist mehr, als man von vielen früheren Technologieumbrüchen sagen konnte.

Die Debatte über nachhaltige KI beginnt nicht bei Verzicht, sondern bei Verständnis. Wer die physische Realität der KI kennt, kann bessere Entscheidungen treffen. Wer ihre Grenzen anerkennt, kann sie sinnvoll nutzen.

Es wird nicht „alles von selbst gut“. Aber es ist auch nicht alles verloren. Zwischen blindem Fortschrittsglauben und lähmender Skepsis liegt ein weiter Raum. In diesem Raum wird sich entscheiden, welche Rolle KI künftig spielt – und wie nachhaltig sie tatsächlich sein kann.

Am Ende ist Nachhaltigkeit kein Zustand, sondern ein Prozess. KI wird Teil dieses Prozesses sein. Nicht als Heilsversprechen, sondern als Werkzeug, das verantwortungsvoll eingesetzt werden will.

Häufig gestellte Fragen

- Was genau bedeutet eigentlich „Nachhaltigkeit“ bei Künstlicher Intelligenz?

Nachhaltigkeit bei KI meint nicht nur Klimaschutz oder Stromsparen, sondern den gesamten Ressourcenverbrauch über den Lebenszyklus hinweg. Dazu gehören Energie für Rechenzentren, Wasser für Kühlung, Rohstoffe für Chips, Netzinfrastruktur und langfristige gesellschaftliche Auswirkungen. Nachhaltig ist KI dann, wenn ihr Nutzen in einem vernünftigen Verhältnis zu diesen Aufwänden steht. - Warum verbraucht KI so viel Strom, obwohl sie doch nur Software ist?

KI wirkt wie Software, läuft aber auf sehr leistungsstarker Hardware. Diese Hardware arbeitet rund um die Uhr, verarbeitet enorme Datenmengen parallel und erzeugt dabei viel Wärme. Strom wird nicht nur fürs Rechnen gebraucht, sondern auch für Kühlung, Netztechnik und Ausfallsicherheit. - Ist der Stromverbrauch von KI wirklich ein neues Problem?

Nicht grundsätzlich neu, aber neu in seiner Größenordnung und Geschwindigkeit. Während frühere digitale Technologien langsam wuchsen, skaliert KI in wenigen Jahren. Netze und Energieversorgung sind darauf oft nicht vorbereitet. - Bedeutet mehr KI automatisch mehr Energieverbrauch?

In der Praxis meist ja. Zwar werden Systeme effizienter, doch sinkende Kosten führen zu mehr Nutzung. Neue Anwendungen entstehen, alte Prozesse werden vervielfacht. Effizienz bremst den Anstieg, hebt ihn aber selten auf. - Warum können KI-Systeme nicht einfach dann rechnen, wenn genug Strom da ist?

Viele KI-Anwendungen benötigen eine kontinuierliche Verfügbarkeit. Trainingsläufe dauern Tage oder Wochen, Dienste müssen jederzeit erreichbar sein. KI ist daher kein flexibler Verbraucher, sondern eine dauerhafte Grundlast. - Welche Rolle spielen Rechenzentren in der Nachhaltigkeitsdebatte?

Rechenzentren sind das physische Herz der KI. Sie bündeln Stromverbrauch, Wärmeentwicklung und Kühlung an einem Ort. Je größer und dichter sie werden, desto stärker wirken sie auf lokale Infrastruktur und Umwelt. - Warum ist Kühlung bei KI ein so großes Thema?

Leistungsfähige Chips erzeugen enorme Hitze. Ohne effiziente Kühlung würden sie schnell ausfallen. Moderne Kühlungssysteme sind komplex, energieintensiv und oft auf Wasser angewiesen, was neue Engpässe schafft. - Ist Wasserverbrauch bei KI wirklich relevant?

Ja, besonders regional. In wasserarmen Gegenden konkurrieren Rechenzentren mit Haushalten, Landwirtschaft und Industrie. Wasser ist nicht beliebig transportierbar und wird schnell zum politischen Konfliktfaktor. - Können erneuerbare Energien den KI-Strombedarf vollständig decken?

Langfristig können sie einen großen Beitrag leisten, aber allein reichen sie derzeit nicht aus. KI benötigt Strom rund um die Uhr. Ohne Speicher, Netzausbau und ergänzende Energiequellen bleibt eine Versorgungslücke. - Warum interessieren sich KI-Unternehmen plötzlich wieder für Kernenergie?

Nicht aus Ideologie, sondern aus Bedarf. Kernkraft liefert planbaren, kontinuierlichen Strom mit geringer Flächeninanspruchnahme. Für energiehungrige Rechenzentren ist diese Stabilität attraktiv, trotz aller bekannten Probleme. - Ist Erdgas eine nachhaltige Lösung für KI?

Erdgas ist eher eine Übergangslösung. Es ist flexibel und verfügbar, verursacht aber Emissionen und geopolitische Abhängigkeiten. Nachhaltig ist es nur im relativen Sinne, nicht als Dauerlösung. - Warum bauen KI-Firmen eigene Kraftwerke?

Eigene Energieversorgung bietet Planbarkeit und Unabhängigkeit. Öffentliche Netze stoßen an Grenzen, Genehmigungen dauern lange. Private Kraftwerke sichern den Betrieb, verschieben aber Verantwortung vom Staat zum Unternehmen. - Ist private Energieversorgung für KI problematisch?

Sie ist effizient, aber gesellschaftlich nicht neutral. Sie kann öffentliche Netze entlasten, entzieht sich aber teilweise demokratischer Steuerung. Energie wird zur privaten Ressource mit politischer Sprengkraft. - Könnte lokale KI das Nachhaltigkeitsproblem lösen?

Lokale KI kann helfen, indem sie kleinere Modelle nutzt und Daten vor Ort verarbeitet. Sie reduziert zentrale Lasten, ersetzt aber nicht alle Anwendungen. Große Modelle bleiben weiterhin energieintensiv. - Warum reicht technischer Fortschritt allein nicht aus?

Weil Effizienz meist zu mehr Nutzung führt. Technik optimiert Mittel, nicht Ziele. Nachhaltigkeit erfordert Entscheidungen darüber, wofür KI eingesetzt wird – nicht nur, wie effizient sie rechnet. - Muss KI deshalb stärker reguliert werden?

Regulierung kann helfen, Prioritäten zu setzen und extreme Entwicklungen zu begrenzen. Sie ist jedoch komplex und langsam. Entscheidend ist nicht maximale Kontrolle, sondern sinnvolle Rahmensetzung. - Besteht die Gefahr, dass KI gesellschaftliche Ungleichheiten verstärkt?

Ja, insbesondere durch Standort- und Energiefragen. Regionen mit guter Infrastruktur profitieren, andere fallen zurück. Private Energieinseln können diese Ungleichgewichte verstärken. - Gibt es trotz all dieser Probleme Grund für Optimismus?

Ja. Die Herausforderungen sind sichtbar und diskutierbar. KI ist kein Naturereignis, sondern gestaltbar. Mit Bewusstsein, Maß und klaren Prioritäten kann sie sinnvoll genutzt werden – ohne sich selbst zu überholen.