Na pierwszy rzut oka sztuczna inteligencja wydaje się niemal nieważka. Wpisujesz pytanie, a odpowiedź pojawia się kilka sekund później. Bez hałasu, bez dymu, bez widocznego ruchu. Wszystko wydaje się dziać „w chmurze“. To jest właśnie błąd w myśleniu. Sztuczna inteligencja nie jest abstrakcyjną magią, ale wynikiem bardzo konkretnych, fizycznych procesów. Za każdą odpowiedzią stoją centra danych, linie energetyczne, systemy chłodzenia, chipy i cała infrastruktura. Im bardziej SI wkracza w nasze codzienne życie, tym bardziej widoczna staje się ta rzeczywistość. I tu właśnie zaczyna się kwestia zrównoważonego rozwoju.

Każdy, kto mówi o sztucznej inteligencji, nie wspominając o energii, zasobach i infrastrukturze, opisuje tylko powierzchnię. Ten artykuł sięga głębiej. Nie alarmując, ale trzeźwo patrząc na to, czego sztuczna inteligencja faktycznie potrzebuje do funkcjonowania - dziś i w przyszłości.

Powszechne błędne przekonanie: sztuczna inteligencja jako „niematerialna chmura“

Wiele osób wyobraża sobie, że sztuczna inteligencja jest podobna do oprogramowania z przeszłości: program, który gdzieś działa, jest aktualizowany i to wszystko. Pomysł ten wywodzi się z czasów, gdy moc obliczeniowa była stosunkowo tania, lokalnie ograniczona i niepozorna energetycznie. Sztuczna inteligencja wykracza poza te ramy.

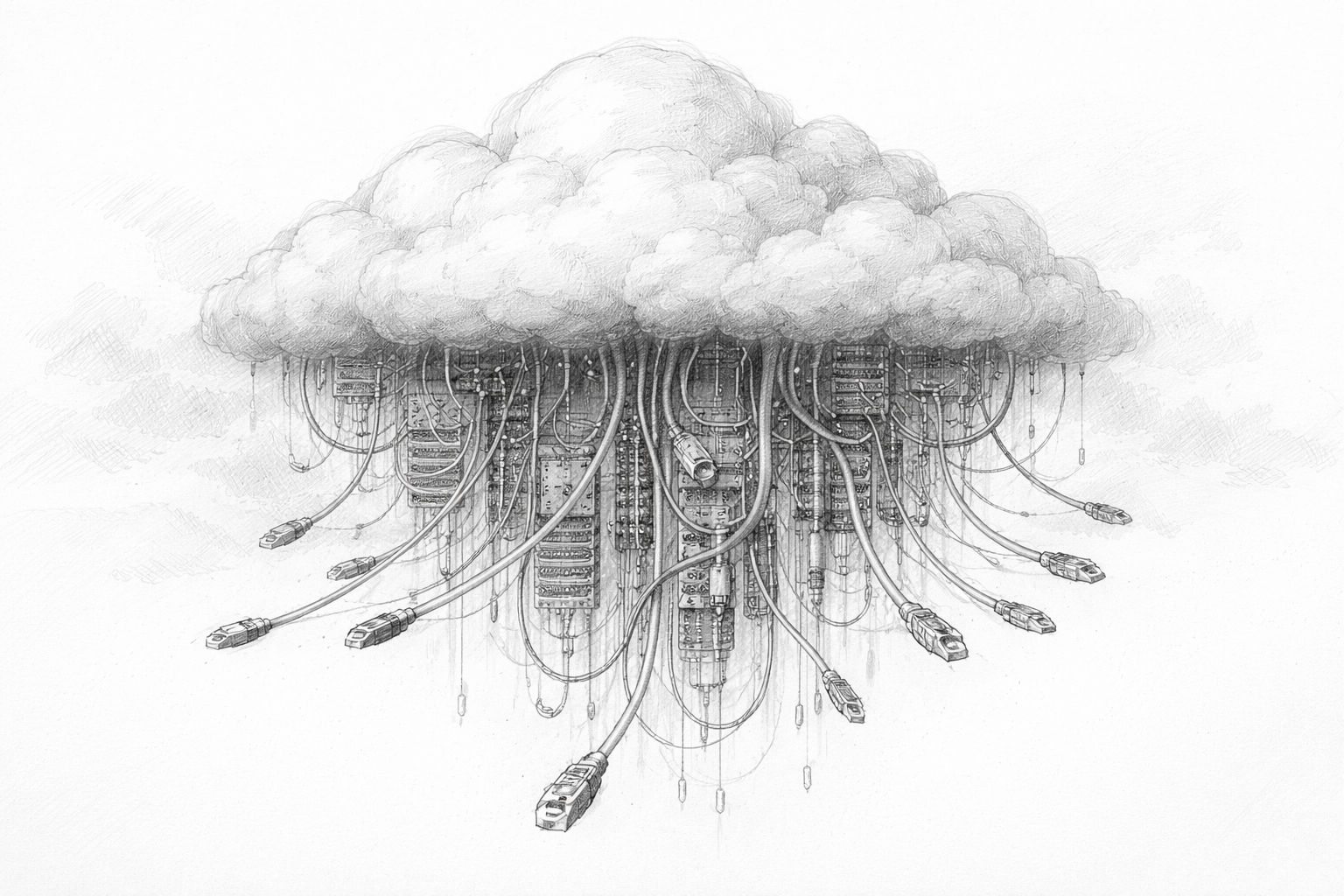

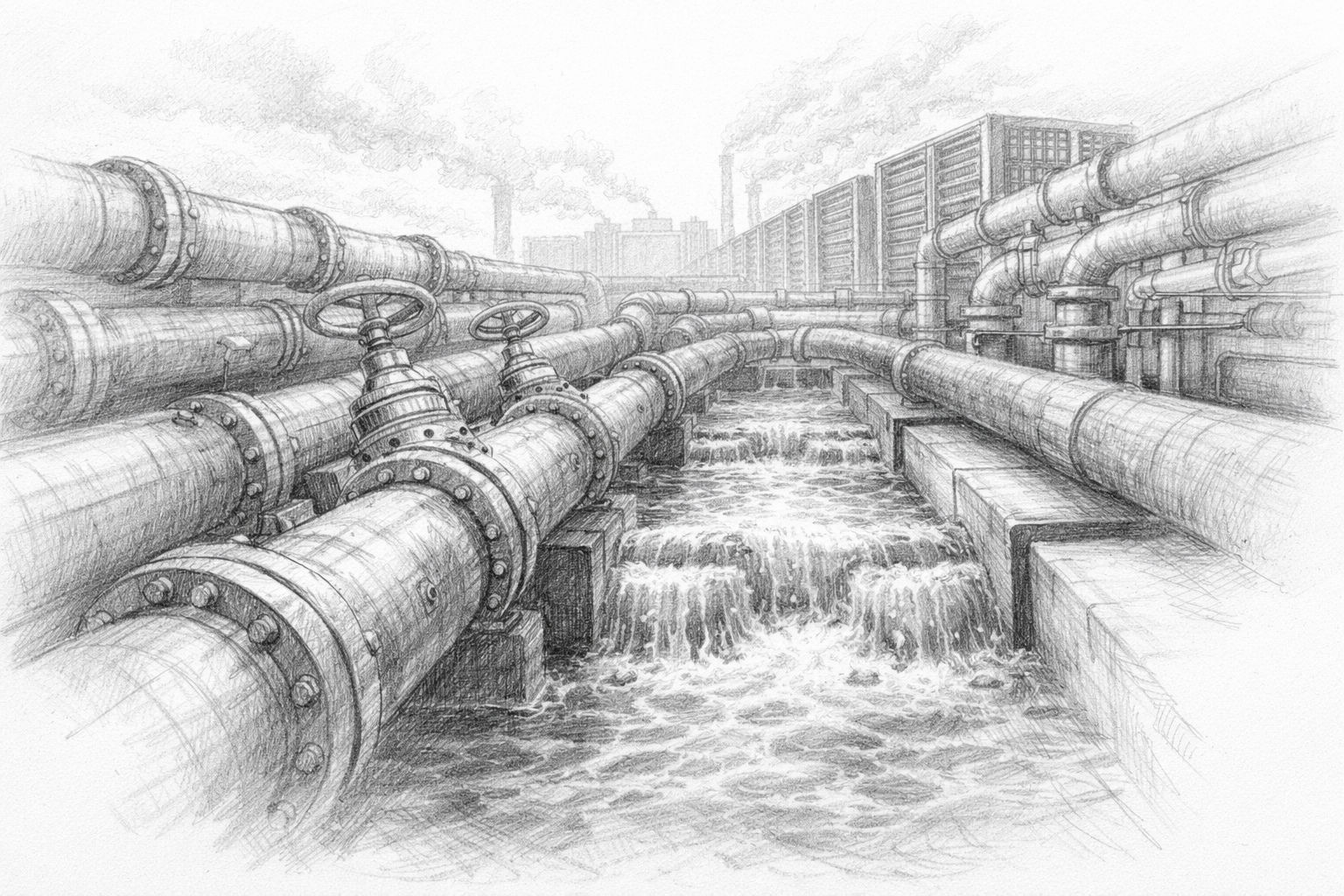

Określenie „chmura“ dodatkowo wzmacnia to wrażenie. Brzmi miękko, niemal naturalnie. Chmury unoszą się w powietrzu, niczego nie obciążają. W rzeczywistości kryje w sobie jedną z najbardziej energochłonnych gałęzi przemysłu naszych czasów. Wielkie hale pełne wysokowydajnych komputerów pracujących przez całą dobę. Tysiące kilometrów kabli. Ogromne systemy chłodzenia. Stała konserwacja.

Różnica w stosunku do tradycyjnego oprogramowania nie polega na zasadzie, ale na skali. Sztuczna inteligencja nie skaluje się liniowo. Im potężniejsza się staje, tym więcej zasobów wymaga. I nie rośnie gdzieś abstrakcyjnie, ale bardzo konkretnie na miejscu.

Czego naprawdę potrzebuje współczesna sztuczna inteligencja

Aby zrozumieć, dlaczego sztuczna inteligencja nie jest już tylko tematem oprogramowania, warto przyjrzeć się jej podstawowym potrzebom. Nowoczesne systemy sztucznej inteligencji wymagają w szczególności trzech rzeczy: mocy obliczeniowej, energii i chłodzenia.

Moc obliczeniowa nie bierze się z powietrza. Zapewniają ją wyspecjalizowane chipy zoptymalizowane pod kątem uczenia maszynowego. Chipy te pracują równolegle, niezwykle szybko - i zużywają przy tym ogromne ilości energii. Im większy model sztucznej inteligencji, tym więcej takich układów musi pracować jednocześnie. Pojedynczy model może składać się z dziesiątek tysięcy takich jednostek obliczeniowych.

Zużycie energii nie jest efektem ubocznym, ale kluczowym czynnikiem. Sztuczna inteligencja nie oblicza selektywnie, ale w sposób ciągły. Zapytania przychodzą przez całą dobę. Treningi trwają dni lub tygodnie. Stanie w miejscu nie jest ekonomiczną opcją. System musi działać, czy to w nocy, w weekendy, czy w dni wolne od pracy.

To natychmiast tworzy kolejny problem: ciepło. Energia elektryczna nie jest w pełni przekształcana w moc obliczeniową. Znaczna jej część staje się ciepłem odpadowym. Bez intensywnego chłodzenia, nowoczesne komputery AI uległyby awarii w krótkim czasie. Chłodzenie z kolei wymaga samej energii - i często wody.

W tym miejscu staje się jasne: sztuczna inteligencja jest fizyczna. Jest powiązana z miejscami, sieciami, zasobami. A to nieuchronnie sprawia, że jest to kwestia zrównoważonego rozwoju, nawet jeśli chcesz uniknąć używania tego słowa.

Trening i użytkowanie: dwa zupełnie różne obciążenia

Inną kwestią, która jest często pomijana w debacie publicznej, jest różnica między szkoleniem sztucznej inteligencji a jej późniejszym wykorzystaniem. Obie te kwestie są często łączone, choć obciążenia są bardzo różne.

Podczas szkolenia przetwarzane są duże ilości danych. System uczy się połączeń, wzorców, języka i obrazów. Faza ta jest niezwykle intensywna obliczeniowo. Zwykle koncentruje się w dużych centrach danych i może zużywać ogromne ilości energii. Pojedyncza sesja treningowa dla dużego modelu może zużywać tyle energii elektrycznej, co małe miasto przez dłuższy czas.

Po szkoleniu następuje wykorzystanie. Tutaj model nie jest już zasadniczo zmieniany, ale stosowany. Każde zapytanie uruchamia procesy obliczeniowe, ale na mniejszą skalę. Problem leży w masowości. Kiedy miliony lub miliardy ludzi korzystają z AI każdego dnia, ten pozornie niewielki wysiłek składa się na stałe obciążenie bazowe.

Obie fazy są istotne. Trening zapewnia obciążenia szczytowe, wykorzystanie zapewnia ciągłe zużycie. Zrównoważony rozwój musi uwzględniać oba poziomy, w przeciwnym razie analiza pozostanie niekompletna.

Dlaczego sztuczna inteligencja różni się od poprzedniej cyfryzacji

Można argumentować, że każda nowa technologia zużywa energię. To prawda. Ale sztuczna inteligencja różni się od poprzednich etapów cyfryzacji pod jednym istotnym względem: nie tylko zastępuje istniejące procesy, ale tworzy nowe.

Internet usprawnił komunikację. E-maile zastąpiły listy, wideokonferencje zastąpiły podróże służbowe. Z drugiej strony, sztuczna inteligencja jest często wykorzystywana jako dodatek. Teksty są nie tylko pisane, ale też wielokrotnie modyfikowane. Obrazy są tworzone nie tylko seryjnie. Decyzje nie są zautomatyzowane i sfinalizowane, ale symulowane, oceniane i przeliczane.

Wzrost wydajności często nie prowadzi do oszczędności, ale do zwiększonego wykorzystania. To, co jest tanie i szybko dostępne, jest wykorzystywane częściej. Zjawisko to nie jest nowe, ale jest szczególnie wyraźne w przypadku sztucznej inteligencji. Im jest ona lepsza, tym większa jest chęć korzystania z niej wszędzie. Właśnie dlatego nadzieja na to, że sama wydajność techniczna rozwiąże problem zrównoważonego rozwoju, nie jest wystarczająca. Nawet bardziej wydajne systemy mogą ostatecznie prowadzić do wyższej ogólnej konsumpcji.

Kiedy ludzie mówią dziś o zrównoważonej sztucznej inteligencji, często pojawia się podtekst moralny. Jest to zrozumiałe, ale nie zawsze pomocne. Zanim zaczniemy mówić o dobru i złu, warto przyjrzeć się zasadom fizyki.

Energia elektryczna musi być generowana. Ciepło musi zostać rozproszone. Woda jest skończona. Sieci mają ograniczenia przepustowości. Tych faktów nie da się zaprzeczyć, bez względu na to, jak zaawansowane jest oprogramowanie. Zrównoważony rozwój nie zaczyna się zatem od dobrych intencji, ale od pytania:

Co jest technicznie i infrastrukturalnie wykonalne?

Tylko wtedy, gdy ta podstawa jest zrozumiała, można podejmować znaczące decyzje. Decyzje o tym, gdzie sztuczna inteligencja jest wykorzystywana, w jakim zakresie i za jaką cenę - zarówno ekonomiczną, jak i społeczną.

Prawdziwe pytanie stojące za debatą

Pod koniec tego pierwszego rozdziału nadal nie ma oceny, ale raczej zmiana perspektywy. Kluczowe pytanie nie brzmi: „Czy sztuczna inteligencja jest zrównoważona?“. To pytanie jest zbyt ogólne i zachęca do szybkich odpowiedzi.

Bardziej precyzyjne pytanie brzmi: jakiej formy sztucznej inteligencji chcemy i ile jesteśmy gotowi na nią wydać? Energia, zasoby, infrastruktura, decyzje polityczne - wszystko to jest częścią równania. Każdy, kto postrzega sztuczną inteligencję wyłącznie jako produkt programowy, pomija te wzajemne powiązania.

Dlatego w kolejnych rozdziałach nie chodzi o szum czy strach, ale o struktury. O polityce energetycznej, projektowaniu chipów, kwestiach lokalizacji i scenariuszach na przyszłość. Ponieważ tylko wtedy, gdy można zobaczyć maszynę kryjącą się za magią, można sensownie rozmawiać o jej przyszłości.

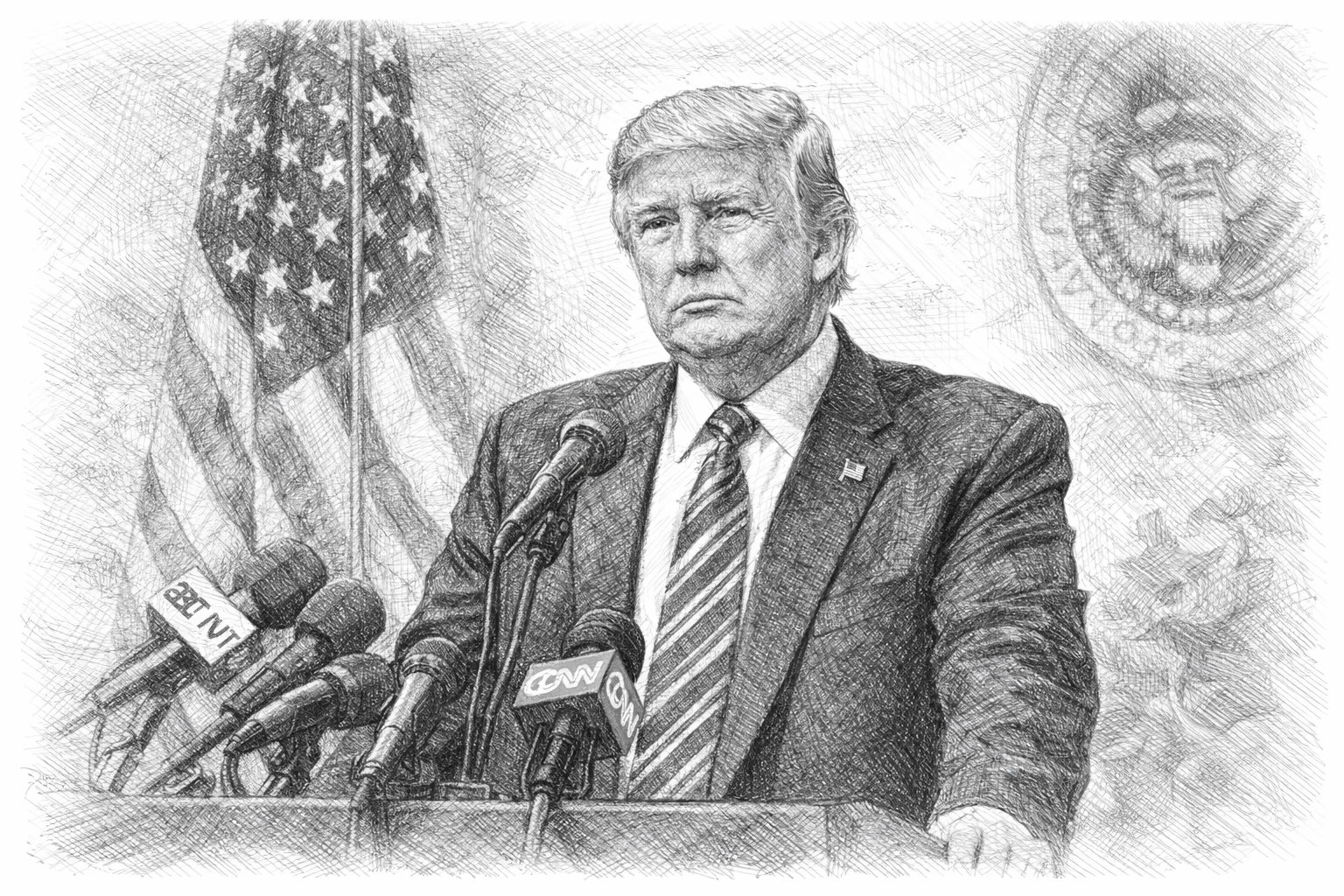

Polityczny punkt zwrotny - kiedy AI zażąda własnych elektrowni

Czasami jedno zdanie mówi więcej o stanie rozwoju niż strony badań. Kiedy Donald Trump powiedział na Światowym Forum Ekonomicznym w Davos, że firmy zajmujące się sztuczną inteligencją powinny po prostu budować własne elektrownie lub budować uczestniczyć w finansowaniu, Nie był to skomplikowany plan polityki energetycznej. Ale był to niezwykle szczery moment. Ponieważ to zdanie zawiera niewypowiedzianą świadomość:

Sztuczna inteligencja nie jest już tylko kolejną gałęzią oprogramowania, ale kompleksem przemysłowym o ogromnym zapotrzebowaniu na energię.

Niezależnie od tego, jak oceniasz Trumpa pod względem politycznym, to stwierdzenie trafia w sedno. Duże firmy zajmujące się sztuczną inteligencją otwarcie dają do zrozumienia, że nie mogą już polegać na istniejących sieciach energetycznych, które po prostu „zaspokoją“ ich potrzeby w dłuższej perspektywie. Potrzebują przewidywalnych, stałych i dużych ilości energii. I tu właśnie zaczyna się polityczny wymiar zrównoważonego rozwoju AI.

Centra danych jako nowy przemysł ciężki

Przez długi czas centra danych były uważane za stosunkowo niepozorną infrastrukturę. Znajdowały się gdzieś na obrzeżach miasta, zużywały energię elektryczną, generowały ciepło - i poza tym nie były przedmiotem debaty publicznej. Obecnie ulega to zasadniczej zmianie.

Nowoczesne centra danych AI działają na skalę znaną wcześniej jedynie z tradycyjnego przemysłu. Ich zapotrzebowanie na energię może odpowiadać zapotrzebowaniu średniej wielkości parku przemysłowego. Ich wymagania w zakresie chłodzenia są złożone. Ich zapotrzebowanie na przestrzeń rośnie. A przede wszystkim, działają nie tylko w ciągu dnia, ale 24 godziny na dobę, siedem dni w tygodniu.

To automatycznie stawia je w tej samej kategorii, co huty stali, zakłady chemiczne czy rafinerie. W przeszłości takie zakłady były specjalnie zlokalizowane, wspierane politycznie i planowane w zakresie polityki energetycznej. Dokładnie te same pytania pojawiają się teraz w przypadku infrastruktury sztucznej inteligencji - tylko znacznie szybciej i często bez jasnej odpowiedzialności.

Dlaczego nie można uniknąć polityki

Energia nie jest wolnym rynkiem w próżni. Sieci energetyczne, elektrownie i procedury wydawania zezwoleń są regulowane politycznie, planowane długoterminowo i wrażliwe społecznie. Jeśli pojedyncze centrum danych nagle potrzebuje tyle energii elektrycznej, co całe miasto, nie pozostanie to bez konsekwencji.

Politycy stają tu przed dylematem. Z jednej strony sztuczna inteligencja jest postrzegana jako kluczowa technologia dla konkurencyjności gospodarczej, innowacji i bezpieczeństwa narodowego. Z drugiej strony, jej zapotrzebowanie na energię konkuruje bezpośrednio z gospodarstwami domowymi, MŚP i istniejącym przemysłem. Rosnące ceny energii elektrycznej, koszty rozbudowy sieci i lokalne wąskie gardła szybko przeradzają się w konflikty polityczne.

Pomysł, że firmy AI powinny zorganizować własne dostawy energii, jest zatem nie tylko pragmatyczny, ale także politycznie odciążający. Przenosi bowiem odpowiedzialność. Zamiast rozbudowywać i subsydiować sieci publiczne, prywatni gracze powinni tworzyć własne rozwiązania. Brzmi to jak gospodarka rynkowa - ale ma daleko idące konsekwencje.

Trump i kwestia technologiczno-energetyczna - polityczny punkt zwrotny

W USA ma obecnie miejsce niezwykły przypadek propozycja polityki energetycznej do dyskusji: Prezydent Donald Trump i kilku gubernatorów naciska na duże firmy technologiczne, aby skutecznie współfinansowały budowę nowych elektrowni w celu ograniczenia rosnących kosztów energii elektrycznej dla gospodarstw domowych.

Tłem tego jest ogromne zapotrzebowanie na energię elektryczną ze strony centrów danych, które są obsługiwane m.in. na potrzeby usług AI i stanowią zauważalne obciążenie dla sieci. Planowana jest tak zwana aukcja niezawodności, w ramach której firmy technologiczne mają zawierać długoterminowe kontrakty na energię elektryczną, które zabezpieczają budowę elektrowni - niezależnie od tego, czy faktycznie kupują energię elektryczną, czy nie. Mogłoby to spowodować miliardowe inwestycje w nowe elektrownie i zmniejszyć presję na sieci publiczne. Krytycy ostrzegają jednak przed możliwymi skutkami ubocznymi, takimi jak wzrost kosztów dla mniejszych dostawców i większa prywatyzacja infrastruktury energetycznej.

Logika stojąca za „budową własnych elektrowni“

Na pierwszy rzut oka pomysł wydaje się radykalny. Jednak po bliższym przyjrzeniu się, jest on zgodny z jasną logiką. Każdy, kto stale potrzebuje dużych ilości energii, powinien być również zaangażowany w jej wytwarzanie. Przez długi czas było to powszechną praktyką w przemyśle. Fabryki posiadały własne elektrownie lub zawierały długoterminowe umowy na dostawy.

Dla firm AI oznacza to posiadanie własnych elektrowni, własnych magazynów energii elektrycznej, bezpośrednich połączeń z producentami lub umów na wyłączność dostaw. Może to obejmować gaz, energię jądrową, odnawialne źródła energii lub formy mieszane. Decydującym czynnikiem nie jest technologia, ale umiejętność planowania.

Tworzy to jednak nową formę infrastruktury: prywatne wyspy energetyczne. Wysokowydajne centra danych z własnymi dostawami, własnymi priorytetami i własnym bezpieczeństwem. Są one w mniejszym stopniu zależne od sieci publicznej, a zatem w mniejszym stopniu zaangażowane w tradycyjne mechanizmy bilansowania.

Kiedy polityka lokalizacji staje się polityką energetyczną

W tym miejscu staje się jasne, dlaczego infrastruktura AI jest politycznie kontrowersyjna. Lokalizacja centrum danych nie jest już wybierana wyłącznie na podstawie prawa podatkowego lub pracy, ale także na podstawie dostępności energii, sytuacji zatwierdzenia i przewidywalności politycznej.

Regiony ze stabilnymi sieciami, korzystnymi źródłami energii i szybkim zatwierdzaniem stają się coraz bardziej atrakcyjne. Inne pozostają w tyle. Może to pogłębić istniejącą nierównowagę - między krajami, wewnątrz krajów, a nawet między gminami.

To nowa sytuacja dla lokalnych decydentów. Z jednej strony centra danych obiecują inwestycje i prestiż. Z drugiej strony, nie przynoszą one prawie żadnych miejsc pracy, ale wiążą się z wysokimi kosztami infrastruktury. Konieczne jest zapewnienie dróg, sieci, przyłączy wody i środków bezpieczeństwa, podczas gdy bezpośrednie korzyści pozostają ograniczone.

To, co brzmi abstrakcyjnie w krajowych strategiach, staje się bardzo konkretne w terenie. Obywatele pytają, dlaczego budowane są nowe rurociągi. Dlaczego brakuje wody. Dlaczego rosną ceny energii elektrycznej. I dlaczego wszystko to dzieje się po to, by można było gdzieś wygenerować teksty lub obliczyć obrazy.

Kwestia akceptacji jest często niedoceniana. Podczas gdy tradycyjne produkty przemysłowe są namacalne, korzyści płynące ze sztucznej inteligencji pozostają niejasne dla wielu osób. Utrudnia to komunikację polityczną. Zrównoważony rozwój nie jest tu tylko kategorią techniczną, ale także społeczną. Im bardziej widoczna staje się infrastruktura, tym większa presja na jej uzasadnienie. Sztuczna inteligencja nie może być trwale postrzegana jako niewidzialna usługa, jeśli jej fizyczne ślady stają się coraz bardziej oczywiste.

Zmiana władzy poprzez samowystarczalność energetyczną

Inny aspekt jest rzadko omawiany otwarcie: Samowystarczalność energetyczna tworzy potęgę. Ci, którzy kontrolują własne dostawy, są mniej zależni od decyzji politycznych, awarii sieci lub interwencji regulacyjnych.

Jest to atrakcyjne dla dużych firm technologicznych. Może to być problematyczne dla państw. Wynika to z faktu, że tradycyjne instrumenty kontroli - opłaty sieciowe, priorytetyzacja, wyłączenia - są mniej skuteczne, gdy infrastruktura krytyczna jest zorganizowana prywatnie.

Stwarza to nowy poziom negocjacji między polityką a firmami technologicznymi. Nie chodzi już tylko o dane lub regulacje, ale o energię, przestrzeń i zasoby długoterminowe.

Punkt zwrotny został osiągnięty

Pierwszy rozdział pokazał, że sztuczna inteligencja jest fizyczna. Ten rozdział pokazuje, że ta fizyka staje się polityczna. Stwierdzenie, że firmy zajmujące się sztuczną inteligencją powinny budować własne elektrownie, nie oznacza poślizgu, ale punkt zwrotny. Uwidacznia to, co do tej pory było często ignorowane: AI to nie tylko kwestia algorytmów, ale infrastruktury, władzy i odpowiedzialności.

Kolejne rozdziały będą zatem jeszcze bardziej szczegółowe. Chodzi o wolumeny energii elektrycznej, chłodzenie, wodę i ograniczenia techniczne. Ponieważ tylko wtedy, gdy te podstawy są zrozumiałe, możemy realistycznie rozmawiać o zrównoważonym rozwoju - poza modnymi hasłami i eufonicznymi deklaracjami intencji.

Głód mocy, chłodzenie, woda - fizyczna rzeczywistość AI

Dopóki sztuczna inteligencja jest postrzegana jako zjawisko związane z oprogramowaniem, liczby pozostają abstrakcyjne. Kilka procent więcej mocy obliczeniowej tutaj, nowy model tam. Ale gdy tylko zaczniemy myśleć o zapotrzebowaniu na energię w kilowatogodzinach, megawatach, a nawet terawatogodzinach, perspektywa się zmienia. Wtedy nie chodzi już o techniczne sztuczki, ale o rzeczywiste zasoby, sieci, elektrownie i konflikty dystrybucyjne.

Ten rozdział jest poświęcony właśnie temu poziomowi. Nie po to, by wywołać strach, ale by nakreślić realistyczny obraz. Ponieważ zrównoważony rozwój zaczyna się tam, gdzie abstrakcyjne koncepcje przekładają się na fizyczne granice.

Ile energii elektrycznej naprawdę zużywa sztuczna inteligencja

Jednym z najczęściej zadawanych pytań jest: „Ile mocy faktycznie zużywa sztuczna inteligencja?“. Szczera odpowiedź brzmi: to zależy. Zależy to od modelu, zastosowania, lokalizacji i sprzętu. Niemniej jednak możliwe jest podanie rzędu wielkości - i jest to odkrywcze.

Obecnie duże centra danych AI działają w zakresach mocy, które kiedyś były typowe dla całych obszarów przemysłowych. Poszczególne systemy wymagają kilkuset megawatów podłączonego obciążenia. Odpowiada to zapotrzebowaniu na moc dziesiątek tysięcy gospodarstw domowych. I nie jest to jednorazowa wartość szczytowa, ale stałe obciążenie.

Co ważne, sztuczna inteligencja nie generuje zużycia sezonowego, jak systemy ogrzewania czy klimatyzacji. Działa w sposób ciągły. To sprawia, że jest to tak zwane obciążenie podstawowe. To właśnie ten rodzaj zużycia stanowi szczególne wyzwanie dla sieci elektroenergetycznych, ponieważ musi być stale zabezpieczony.

Kluczową kwestią nie jest to, czy zapotrzebowanie na energię elektryczną jest „zbyt wysokie“, ale jak szybko rośnie. Podczas gdy tradycyjne branże często rozwijały się przez dziesięciolecia, infrastruktura sztucznej inteligencji rośnie w ciągu zaledwie kilku lat. Sieci, elektrownie i procedury wydawania zezwoleń nie są przystosowane do takiego tempa.

Dlaczego prognozy są często źle rozumiane

W debacie publicznej często podaje się duże liczby. Podwojenie zużycia energii elektrycznej, eksplodujący popyt, ogromne obciążenia. Takie stwierdzenia nie są błędne, ale często są źle rozumiane.

Nie oznacza to, że jutro zgasną światła. Oznaczają jednak, że długoterminowe planowanie znajduje się pod presją. Sieci elektroenergetyczne są budowane dla określonych profili obciążenia. Jeśli profile te ulegną zasadniczej zmianie, pojawią się wąskie gardła - lokalne, regionalne lub krajowe.

Problemem jest nie tyle bezwzględna konsumpcja, co jej koncentracja. Centra danych AI nie są rozmieszczone równomiernie. Koncentrują się tam, gdzie sieci, chłodzenie i polityczne warunki ramowe są korzystne. To właśnie tam pojawiają się konflikty.

Chłodzenie: niewidzialny drugi system

Energia elektryczna to tylko połowa sukcesu. Każda kilowatogodzina zużyta przez centrum danych prędzej czy później zamienia się w ciepło. Ciepło to musi zostać rozproszone, w przeciwnym razie operacje ulegną załamaniu. Chłodzenie nie jest zatem dodatkiem, ale centralnym systemem operacyjnym nowoczesnej infrastruktury AI.

Kiedyś wystarczało chłodzenie powietrzem. Wentylatory, systemy klimatyzacji, ciepłe powietrze wylotowe. Wraz ze wzrostem gęstości mocy nowoczesnych chipów, zasada ta osiągnęła swoje granice. Obecnie coraz częściej stosuje się systemy chłodzenia cieczą, w których chłodziwo jest doprowadzane bezpośrednio do procesorów. Systemy te są bardziej wydajne, ale też bardziej złożone. Wymagają pomp, wymienników ciepła i mechanizmów awaryjnych. Tworzą też nowe zależności: od wody, od chłodziw chemicznych, od stabilnych temperatur.

Chłodzenie nie jest problemem szczegółowym. Decyduje o tym, gdzie centra danych mogą w ogóle działać. Regiony o wysokich temperaturach zewnętrznych, ograniczonych zasobach wody lub niestabilnych sieciach pozostają w tyle.

Woda: często pomijane wąskie gardło

Podczas gdy wiele mówi się o energii elektrycznej, woda jest zaskakująco często pomijana w tym równaniu. Tymczasem jest ona niezbędna w wielu koncepcjach chłodzenia. Chłodzenie wyparne, instalacje do ponownego chłodzenia, wymienniki ciepła - wszystko to wymaga wody w odpowiednich ilościach. W regionach bogatych w wodę jest to mało zauważalne. Jednak w regionach suchych woda szybko staje się kwestią polityczną. Gdy centra danych konkurują z rolnictwem, przemysłem i gospodarstwami domowymi, pojawiają się konflikty dystrybucyjne. A tych nie da się po prostu rozwiązać za pomocą pieniędzy.

Ponadto zużycie wody ma charakter lokalny. Energia elektryczna może być transportowana za pośrednictwem sieci, woda tylko w ograniczonym zakresie. To sprawia, że czynnik lokalizacji jest jeszcze bardziej krytyczny. Nie można po prostu zbudować centrum danych tam, gdzie ziemia jest tania, jeśli nie ma wody.

Debata na temat zrównoważonego rozwoju AI stanie się zatem nieuchronnie bardziej regionalna. To, co wydaje się mieć sens globalnie, może być problematyczne lokalnie.

Często twierdzi się, że nowa technologia złagodzi ten problem. Bardziej wydajne chipy, lepsze chłodzenie, zoptymalizowane oprogramowanie. Nie jest to błędne myślenie, ale jest ono niekompletne. Wzrost wydajności zmniejsza zużycie na jednostkę obliczeniową. Jednocześnie spadają koszty i bariery wdrożenia. Często prowadzi to do częstszego wykorzystywania sztucznej inteligencji w nowych obszarach. Ogólnym efektem może być nawet wyższe zużycie.

Wzorzec ten jest znany z innych obszarów. Bardziej wydajne silniki nie doprowadziły do zmniejszenia ruchu, ale do jego zwiększenia. Bardziej wydajne oświetlenie nie zmniejszyło automatycznie zużycia energii elektrycznej, ale zwiększyło jej wykorzystanie. Sztuczna inteligencja działa na tej samej zasadzie.

Zrównoważonego rozwoju nie można zatem rozwiązać wyłącznie technicznie. Jest to zawsze kwestia ograniczeń, ustalania priorytetów i świadomego podejmowania decyzji.

Sieci energetyczne jako wąskie gardło

Inny aspekt jest często niedoceniany: sama sieć elektroenergetyczna. Budowa elektrowni jest złożona, ale rozbudowa sieci jest często jeszcze bardziej skomplikowana. Zezwolenia, trasy, odbiory - wszystko to wymaga czasu.

Centra danych AI potrzebują nie tylko dużo energii, ale także stabilnych sieci. Wahania napięcia, przestoje lub wąskie gardła mogą powodować kosztowne szkody. Dlatego operatorzy preferują lokalizacje o wysokiej jakości sieci. Prowadzi to do paradoksalnej sytuacji. To właśnie tam, gdzie sieci są dobrze rozwinięte, presja wzrasta najbardziej. Nowi wielkoskalowi odbiorcy zaostrzają istniejące wąskie gardła. Rozbudowa pozostaje w tyle.

To po raz kolejny pokazuje, że sztuczna inteligencja nie jest odizolowanym systemem. Ma ona wpływ na istniejącą infrastrukturę i zmienia jej wymagania.

Najpóźniej w tym momencie staje się jasne, że fizyczna rzeczywistość AI nie może być postrzegana w oderwaniu od kwestii społecznych. Energia elektryczna, woda i sieci są dobrami wspólnymi. Ich wykorzystanie jest regulowane politycznie i wrażliwe społecznie.

Im więcej AI korzysta z tych zasobów, tym bardziej pojawia się pytanie o priorytety:

- Do czego używamy energii?

- Które aplikacje uzasadniają jakie wydatki?

- I kto o tym decyduje?

Odpowiedzi na te pytania nie mogą udzielić wyłącznie inżynierowie. Wpływają one w równym stopniu na politykę, biznes i społeczeństwo.

Niewygodna świadomość

Rozdział ten prowadzi do niewygodnej, ale koniecznej świadomości: sztuczna inteligencja nie jest „czystym“ produktem cyfrowym. Jest osadzona w materialnym świecie z ograniczonymi zasobami. Każde użycie ma swoją cenę, nawet jeśli nie jest ona od razu widoczna.

W tym kontekście zrównoważony rozwój nie oznacza bezczynności, ale świadomość. Świadomość skali, wzajemnych powiązań i konsekwencji. Tylko wtedy, gdy ta rzeczywistość zostanie rozpoznana, można opracować realne rozwiązania.

Następny rozdział koncentruje się na samej technologii - na chipach, obietnicy wydajności i pytaniu, czy sam postęp technologiczny wystarczy, aby sprostać tym wyzwaniom.

AI i kryzys wodny: dlaczego centra danych zużywają zbyt dużo wody? | DW German

Chipy, wydajność i iluzja technicznego procesu samoleczenia

Kiedy wspomina się o ogromnym zapotrzebowaniu SI na energię, niemal odruchowo pojawia się uspokajające zdanie: technologia staje się coraz bardziej wydajna. Nowe chipy, lepsze oprogramowanie, inteligentniejsze chłodzenie - problem zostanie rozwiązany wraz z kolejną generacją. Ta nadzieja jest zrozumiała. Podsycają ją dekady doświadczeń. Komputery stały się mniejsze, szybsze i bardziej ekonomiczne. Dlaczego sztuczna inteligencja miałaby być inna?

Krótka odpowiedź brzmi: wzrost wydajności jest realny, ale nie rozwiązuje on automatycznie podstawowego problemu. Wręcz przeciwnie - mogą go nawet pogłębić. Aby to zrozumieć, warto przyjrzeć się bliżej technologii stojącej za sztuczną inteligencją i dynamice, jaką wywołuje wydajność.

Dlaczego wyspecjalizowane chipy działają tak dobrze - i zużywają tak dużo?

Nowoczesna sztuczna inteligencja nie działa już na klasycznych procesorach uniwersalnych. Wymaga wyspecjalizowanych jednostek obliczeniowych, które mogą wykonywać wiele prostych obliczeń równolegle. W tym właśnie tkwi ich mocna - i słaba - strona. Układy te są zaprojektowane do jednoczesnego przetwarzania ogromnych ilości danych. Nie wykonują obliczeń krok po kroku, ale w dużych blokach. To sprawia, że są niezwykle wydajne, ale także energochłonne. Im gęściej upakowana jest moc obliczeniowa, tym większe jest ciepło odpadowe i tym bardziej skomplikowane jest chłodzenie.

Kluczową kwestią jest to, że chipy te nie są budowane z myślą o oszczędności, ale o zapewnieniu maksymalnej przepustowości. Efektywność odgrywa pewną rolę, ale wydajność zajmuje centralne miejsce. Ponieważ w rywalizacji o możliwości AI liczy się szybkość. Ten, kto trenuje szybciej, kto uruchamia większe modele, zyskuje przewagę.

Tworzy to strukturalny konflikt celów. Efektywność ulega poprawie, ale nie kosztem zwiększonej wydajności. Ogólna konsumpcja niekoniecznie spada, ale zmienia się.

Wydajność na wat - ważny, ale ograniczony kluczowy wskaźnik

W ostatnich latach pojawił się nowy kluczowy wskaźnik: Wydajność na wat. Opisuje ona, ile mocy obliczeniowej uzyskuje się przy określonej ilości energii. Ta kluczowa wartość jest przydatna, ponieważ wizualizuje wydajność. Nie jest to jednak panaceum.

System, który jest dwa razy bardziej wydajny, zużywa tylko o połowę mniej energii do wykonania tego samego zadania. Ale jeśli jest używany cztery razy częściej, całkowite zużycie wzrasta. Jest to dokładnie ten wzorzec, który widzimy wielokrotnie.

Wydajność na wat jest optymalizacją techniczną. Z drugiej strony, zrównoważony rozwój jest kwestią systemową. Zależy od tego, jak technologia jest wykorzystywana, a nie tylko od tego, jak dobrze jest zbudowana.

Dlaczego wydajność często prowadzi do większego wykorzystania

Zjawisko to nie jest nowe. Zostało opisane już w XIX wieku, na długo przed pojawieniem się komputerów. Wydajność zmniejsza koszty i przeszkody. To, co jest tańsze i szybsze, jest używane częściej. Wyjątki są rzadkie.

Efekt ten jest szczególnie silny w przypadku sztucznej inteligencji. Im bardziej wydajne stają się modele, tym łatwiej można je zintegrować z nowymi aplikacjami. Teksty, obrazy, filmy, symulacje - wszystko nagle staje się możliwe tam, gdzie wcześniej było zbyt drogie lub zbyt wolne.

Nie prowadzi to do oszczędności, ale do ekspansji. Sztuczna inteligencja nie tylko zastępuje istniejące procesy, ale także tworzy nowe. Wydajność staje się motorem wzrostu.

Każdy, kto myśli o zrównoważonym rozwoju wyłącznie w kategoriach optymalizacji technicznej, pomija tę dynamikę. To tak, jakby mieć nadzieję, że bardziej wydajne samochody zmniejszą natężenie ruchu.

Mit „kolejnego wielkiego przełomu“

Innym częstym argumentem jest to, że następna generacja chipów zmieni wszystko. Skoki kwantowe, nowe materiały, rewolucyjne architektury. Takie przełomy nie są niemożliwe, ale są rzadkie - i rzadko rozwiązują wszystkie problemy jednocześnie.

Nawet jeśli chip stanie się dwa lub trzy razy bardziej wydajny, podstawowy wzorzec pozostaje ten sam. Sztuczna inteligencja rośnie, skaluje się i rozprzestrzenia. Każdy przełom natychmiast przekłada się na nowe zastosowania. Postęp techniczny jest absorbowany, a nie ograniczany.

Co więcej, wiele wzrostów wydajności jest już wliczonych w cenę. Osiągnięto prostą optymalizację. Dalszy postęp będzie bardziej złożony, droższy i wolniejszy. Jednocześnie popyt rośnie szybciej niż wydajność.

Lokalna sztuczna inteligencja jako kontr-model - z ograniczeniami

Często wymienianym modelem alternatywnym jest lokalna sztuczna inteligencja. Mniejsze modele, mniejsza moc obliczeniowa, niższe wymagania energetyczne. Model ten jest atrakcyjny, ponieważ spowalnia skalowanie i zmniejsza zależności.

Ale i w tym przypadku lokalna sztuczna inteligencja nie zastąpi wszystkich aplikacji. Duże modele, złożone analizy i globalne usługi nie mogą być po prostu zdecentralizowane. Lokalna wydajność odciąża system, ale nie eliminuje podstawowej dynamiki.

Zrównoważony rozwój nie powstaje automatycznie w wyniku decentralizacji. Jest on tworzony poprzez świadomy wybór tego, co ma sens lokalnie - a co być może nie powinno być robione.

Dlaczego sama technologia nie ponosi odpowiedzialności

Technologia optymalizuje to, co jest jej dane. Nie zna celów wykraczających poza tę optymalizację. Z drugiej strony, zrównoważony rozwój jest celem normatywnym. Wymaga wyznaczenia granic, ustalenia priorytetów i podejmowania decyzji. Każdy, kto ma nadzieję, że technologia weźmie na siebie tę odpowiedzialność, myli środki i cele. Wydajne chipy to narzędzia. To, czy prowadzą do większej czy mniejszej konsumpcji, zależy od tego, jak są wykorzystywane.

Pod tym względem sztuczna inteligencja nie różni się od wcześniejszych technologii. Różnica polega jedynie na szybkości i skali.

Niewygodna rola ograniczeń

Ograniczenie nie jest popularnym słowem. Brzmi jak wyrzeczenie się, jak zastój. W rzeczywistości ograniczenie jest formą kontroli. Decyduje o tym, gdzie technologia ma sens, a gdzie nie.

Zrównoważona sztuczna inteligencja nie zostanie stworzona poprzez uczynienie wszystkiego bardziej wydajnym. Zostanie stworzona poprzez podjęcie decyzji, które aplikacje mają priorytet, a które są zbędne. Decyzja ta nie jest kwestią techniczną, ale polityczną i społeczną. Wydajność może pomóc. Może zmniejszyć obciążenie. Ale nie zastąpi decyzji.

Rozdział ten prowadzi do jasnego wniosku: postęp technologiczny jest niezbędny, ale sam w sobie nie rozwiązuje problemu zrównoważonego rozwoju. Bardziej wydajne chipy, lepsze oprogramowanie i zoptymalizowane chłodzenie są częścią rozwiązania - ale tylko częścią. Jeśli poważnie traktujesz zrównoważony rozwój, musisz mówić o wykorzystaniu, skalowaniu i ograniczeniach. O celach, a nie tylko o środkach.

W następnym rozdziale odwrócimy zatem naszą uwagę od czystej technologii i zajmiemy się samą kwestią energii. Skąd powinna pochodzić energia elektryczna, której AI potrzebuje w dłuższej perspektywie? I jakie opcje są realistyczne, poza ideologią i myśleniem życzeniowym?

Wymagania energetyczne sztucznej inteligencji: rosnące wyzwanie | DW German

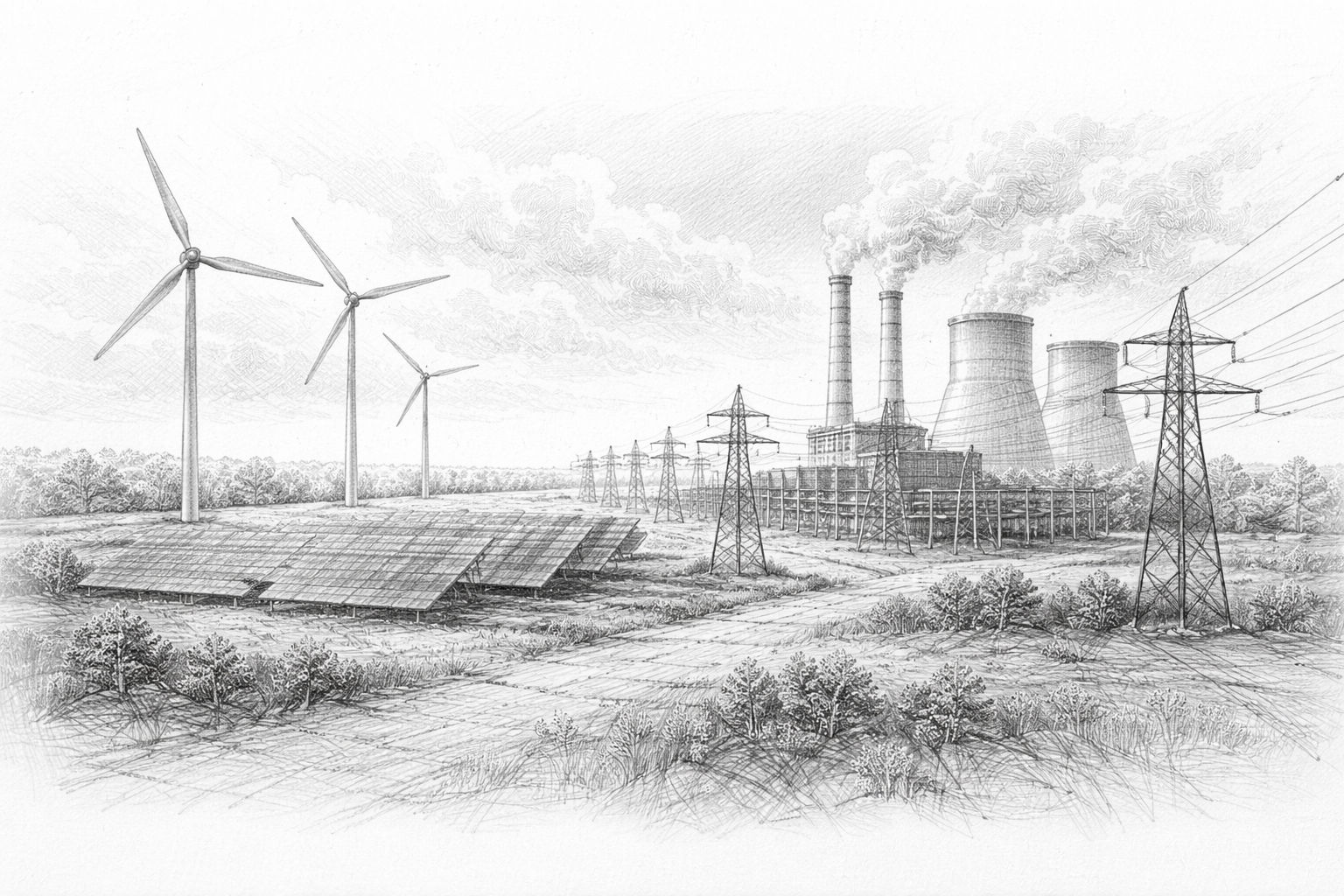

Skąd powinna pochodzić energia elektryczna? - Opcje energetyczne bez ideologii

Najpóźniej w tym momencie kwestia zrównoważonego rozwoju nie może być już rozpatrywana abstrakcyjnie. Jeśli sztuczna inteligencja wymaga dużych ilości energii elektrycznej na stałe, nieuchronnie pojawia się proste, ale niewygodne pytanie: skąd ta energia powinna pochodzić? Nie teoretycznie, ale praktycznie. Nie w pewnym momencie, ale w sposób ciągły.

Kwestia ta jest tak wybuchowa, ponieważ powoduje, że stare konflikty w polityce energetycznej nabierają nowego, pilnego charakteru. Sztuczna inteligencja nie jest okazjonalnym konsumentem, ale stałym obciążeniem. Potrzebuje energii elektrycznej, gdy jest potrzebna - nie tylko wtedy, gdy świeci słońce lub wieje wiatr. To sprawia, że jest kamieniem milowym dla każdego systemu energetycznego.

Dlaczego sztuczna inteligencja potrzebuje obciążenia podstawowego

Systemy AI nie mogą być włączane i wyłączane według własnego uznania. Szkolenia często trwają dni lub tygodnie. Usługi muszą być dostępne przez całą dobę. Przerwy są nie tylko irytujące, ale także kosztowne ekonomicznie. Wymagania energetyczne AI są zatem podobne do tradycyjnych branż z ciągłą pracą. Wymagają one możliwości obciążenia podstawowego. Oznacza to, że energia elektryczna musi być dostępna w wystarczających ilościach przez cały czas, niezależnie od pory dnia, pogody czy pory roku.

W tym miejscu zaczynają się trudności. Wiele źródeł energii nie zapewnia stałych dostaw energii elektrycznej. Wahają się one lub są sezonowe. Nie stanowi to zasadniczego problemu, o ile dostępne jest wystarczające bilansowanie. Takie bilansowanie jest jednak kosztowne, wymagające technicznie i często kontrowersyjne politycznie.

Odnawialne źródła energii: niezbędne, ale niewystarczające same w sobie

Odnawialne źródła energii odgrywają kluczową rolę w zrównoważonej przyszłości. Nie ma co do tego wątpliwości. Są one przyjazne dla klimatu, coraz bardziej opłacalne i społecznie akceptowane. Niemniej jednak osiągają swoje granice w zastosowaniach wymagających dużego obciążenia podstawowego, takich jak sztuczna inteligencja.

Energia słoneczna i wiatrowa dostarczają energię elektryczną, gdy warunki są odpowiednie. Systemy magazynowania mogą kompensować wahania, ale tylko w ograniczonym zakresie. Technicznie możliwe jest stworzenie dużych magazynów na kilka dni lub tygodni, ale są one drogie i wymagają dużej powierzchni.

W przypadku centrów danych AI oznacza to, że energia odnawialna może wnieść istotny wkład, ale nie gwarantuje ciągłości dostaw. Bez dodatkowych środków pozostanie luka w podaży. Luka ta musi zostać wypełniona - w przeciwnym razie zrównoważony rozwój pozostanie matematyczny, ale nie rzeczywisty.

Energia jądrowa: niewygodny renesans

Prawie żaden inny temat energetyczny nie jest tak emocjonalnie naładowany jak energia jądrowa. Dlatego tym bardziej niezwykłe jest to, że nagle znów trzeźwo dyskutuje się o niej w kontekście sztucznej inteligencji. Nie z entuzjazmu, ale z potrzeby.

Energia jądrowa dostarcza duże ilości energii elektrycznej w sposób ciągły, przy niskim zużyciu gruntów i niezależnie od pogody. To właśnie czyni ją atrakcyjną dla energochłonnych centrów danych. Nie jako panaceum, ale jako stabilna podstawa.

Dla firm zajmujących się sztuczną inteligencją debata społeczna jest mniej ważna niż rzeczywistość techniczna. Przewidywalność, bezpieczeństwo dostaw i długoterminowe kontrakty zajmują centralne miejsce. Fakt, że duże firmy technologiczne ponownie interesują się energią jądrową, jest zatem mniej ideologiczny niż pragmatyczny.

Jednocześnie pozostają znane problemy: długi czas budowy, wysokie koszty, kwestie ostatecznego składowania, akceptacja polityczna. Energia jądrowa nie jest szybkim rozwiązaniem, ale długoterminową decyzją z wysokimi barierami wejścia.

Gaz: most z ryzykiem

Gaz ziemny jest często postrzegany jako elastyczne uzupełnienie. Można go stosunkowo szybko zwiększać i zmniejszać, elektrownie można budować stosunkowo szybko, a technologia jest wypróbowana i przetestowana. Gaz może być rozwiązaniem pomostowym dla centrów danych AI.

Ale ten most ma pęknięcia. Gaz jest paliwem kopalnym. Powoduje emisje i pozostaje geopolitycznie wrażliwy. Nawet w przypadku wychwytywania CO₂ pozostaje problem szczątkowy. Gaz jest również niestabilny pod względem cen. Stanowi to ryzyko dla długoterminowego planowania.

Niemniej jednak gaz będzie odgrywał rolę w wielu scenariuszach. Nie dlatego, że jest idealny, ale dlatego, że nie ma alternatyw. Zrównoważony rozwój w tym przypadku często oznacza wybór między złymi i mniej złymi opcjami.

Magazynowanie, sieci i niedoceniane koszty

Często argumentuje się, że magazynowanie rozwiązałoby problem. Duże baterie, wodór, elektrownie szczytowo-pompowe. Wszystkie te technologie istnieją, ale nie można ich dowolnie skalować.

Systemy magazynowania są drogie, materiałochłonne i energochłonne. Są przydatne do równoważenia wahań, ale nie zastępują stałego wytwarzania energii. Im większe zużycie, tym większy musi być system magazynowania. Nie jest to ograniczenie teoretyczne, ale fizyczne.

Do tego dochodzą sieci. Energia elektryczna musi być nie tylko generowana, ale także transportowana. Wysokowydajne centra danych wymagają wysokowydajnych połączeń. Rozbudowa tych sieci jest kosztowna, czasochłonna i pełna konfliktów.

Prywatne dostawy energii: Powrót do starych wzorców

W obliczu tych wyzwań stary pomysł nabiera nowego znaczenia: prywatne dostawy energii. Duże branże obsługiwały własne elektrownie lub zawierały umowy na wyłączność. Firmy zajmujące się sztuczną inteligencją coraz częściej podążają w tym kierunku.

Własne elektrownie, własne magazyny, bezpośrednie połączenia - wszystko to zmniejsza zależność. Jednocześnie pozbawia to część infrastruktury kontroli publicznej. Energia elektryczna staje się zasobem prywatnym.

Rozwój ten jest racjonalny, ale nie neutralny społecznie. Przesuwa równowagę sił. Ci, którzy kontrolują energię, mają pole manewru. Dotyczy to zarówno państw, jak i firm.

Zrównoważony rozwój bez złudzeń

W tym momencie staje się jasne, dlaczego debaty ideologiczne są mało pomocne. Nie ma idealnego rozwiązania. Każde źródło energii ma wady i zalety. Każda decyzja wiąże się ze sprzecznymi celami.

Zrównoważony rozwój nie oznacza tutaj znalezienia „właściwej“ technologii, ale raczej otwarte nazwanie konsekwencji każdej opcji. Jakie ryzyko akceptujemy? Jakie zależności akceptujemy? Jakie koszty ponosimy - i kto je ponosi?

Sztuczna inteligencja zmusza nas do zadawania tych pytań na nowo, ponieważ kompresuje i przyspiesza zapotrzebowanie na energię.

Ten rozdział wyznacza zmianę w sposobie myślenia. Pytanie nie brzmi już, czy sztuczna inteligencja może działać w sposób zrównoważony, ale na jakich warunkach. Energia jest tutaj czynnikiem ograniczającym. Nie moc obliczeniowa, nie oprogramowanie, ale energia elektryczna.

Następny rozdział dotyczy zatem obrazów przyszłości, które wyłaniają się z tych warunków. Nie jako prognozy, ale jako scenariusze. Ponieważ o tym, jak zrównoważona stanie się sztuczna inteligencja, nie zadecyduje pojedynczy przełom, ale suma naszych decyzji.

Aktualne badanie dotyczące korzystania z lokalnych systemów AI

Trzy scenariusze przyszłości - jak zrównoważona może stać się sztuczna inteligencja?

Po pięciu rozdziałach pełnych danych liczbowych, ograniczeń technicznych i napięć politycznych, łatwo byłoby odnieść wrażenie, że sztuczna inteligencja nieuchronnie zmierza w kierunku problemu zrównoważonego rozwoju, którego nie da się powstrzymać. Taki pogląd byłby zrozumiały - ale byłby zbyt krótkowzroczny.

Przyszłość sztucznej inteligencji nie jest przesądzona. Nie wyłoni się z pojedynczego przełomu technologicznego, ale z wielu decyzji podejmowanych dziś i w nadchodzących latach. Decyzji dotyczących tego, w jaki sposób sztuczna inteligencja będzie wykorzystywana, gdzie będzie działać i jakie znaczenie będzie miała w odniesieniu do innych celów społecznych.

Aby uczynić tę otwartość namacalną, warto mówić nie o jednej przyszłości, ale o możliwych ścieżkach rozwoju. Już dziś można wyróżnić trzy takie scenariusze. Żaden z nich nie jest gwarantowany, żaden nie jest całkowicie nierealny. Rzeczywistość będzie prawdopodobnie zawierać elementy wszystkich trzech.

Scenariusz 1: Centralizacja i enklawy energetyczne

W tym scenariuszu logika skalowania jest kontynuowana konsekwentnie. Duzi dostawcy sztucznej inteligencji łączą moc obliczeniową w kilku niezwykle wydajnych lokalizacjach. Lokalizacje te mają własne źródła energii, własne połączenia sieciowe, a w niektórych przypadkach własne rozwiązania pamięci masowej. Są one wysoce zoptymalizowane, odizolowane i wydajne w sensie przemysłowym.

Zaleta tego modelu jest oczywista. Dostawy energii można zaplanować, zminimalizować przestoje i obliczyć koszty w perspektywie długoterminowej. Sztuczna inteligencja staje się niezawodna, wydajna i globalnie dostępna. Ten scenariusz jest atrakcyjny dla firm i krajów, które polegają na przywództwie technologicznym.

Cena jest również jasna. Energia staje się coraz bardziej sprywatyzowana. Infrastruktura częściowo wymyka się spod kontroli publicznej. Zwiększa się nierównowaga regionalna. Lokalna akceptacja staje się stałym placem budowy. Zrównoważony rozwój jest tu rozumiany przede wszystkim w kategoriach technicznych, a w mniejszym stopniu w kategoriach społecznych.

Scenariusz ten jest realistyczny, ponieważ opiera się na istniejących wzorcach. Nie jest to radykalne zerwanie, ale kontynuacja logiki przemysłowej przy użyciu nowych środków.

Scenariusz 2: Wydajność, regulacja i celowe ograniczenie

Inna wizja przyszłości kładzie nacisk na kontrolę. W tym scenariuszu politycy i społeczeństwo uznają, że nieograniczone skalowanie nie ma sensu ani technicznego, ani społecznego. Sztuczna inteligencja jest wykorzystywana w sposób ukierunkowany, traktowana priorytetowo i regulowana.

Wydajność pozostaje ważna, ale jest uzupełniana przez warunki ramowe. Niektóre aplikacje są faworyzowane, inne są celowo ograniczane. Energochłonne treningi podlegają określonym warunkom. Decyzje dotyczące lokalizacji są ściślej koordynowane. Zrównoważony rozwój nie jest pozostawiony samemu rynkowi.

Zaletą tego modelu jest równowaga. Sztuczna inteligencja pozostaje potężna, ale wbudowana. Kwestie energii i infrastruktury są rozpatrywane wspólnie. Obciążenia są rozłożone w bardziej przejrzysty sposób.

Wadą jest złożoność. Regulacja kosztuje czas, koordynacja kosztuje szybkość. Presja na innowacje koliduje z procesami planowania. Scenariusz ten wymaga politycznej zdolności do działania i konsensusu społecznego - żadnego z nich nie można uznać za pewnik. Niemniej jednak scenariusz ten nie jest utopijny. Wiele branż zostało osadzonych w podobny sposób bez utraty wydajności. Zakłada on, że sztuczna inteligencja nie jest postrzegana jako cel sam w sobie, ale jako narzędzie.

Scenariusz 3: Zdecentralizowana i lokalna sztuczna inteligencja

Trzeci scenariusz przesuwa punkt ciężkości. Zamiast budować coraz większe scentralizowane systemy, sztuczna inteligencja jest wykorzystywana bardziej zdecentralizowanie. Mniejsze modele, lokalna moc obliczeniowa, wyspecjalizowane aplikacje. Nie każde zadanie wymaga maksymalnej wydajności.

W tym modelu sztuczna inteligencja jest bliżej punktu użycia. Firmy obsługują własne systemy. Urządzenia stają się bardziej wydajne. Dane pozostają lokalne. Zapotrzebowanie na energię na aplikację jest zmniejszone, ponieważ skalowanie jest ograniczone.

Zaletą jest solidność. Zależności są zredukowane. Infrastruktura jest odciążona. Zrównoważony rozwój osiąga się poprzez umiarkowanie, a nie poprzez maksymalną wydajność. Ograniczenia tego modelu są również jasne. Duże, złożone aplikacje nie mogą być w pełni zdecentralizowane. Badania, usługi globalne i wysoce złożone analizy nadal wymagają scentralizowanych zasobów.

Scenariusz ten nie zastępuje innych, ale je uzupełnia. Pokazuje, że zrównoważony rozwój można osiągnąć również poprzez różnorodność - nie wszystko musi mieć ten sam rozmiar, tę samą prędkość i tę samą wydajność.

Dlaczego nie ma „właściwego“ scenariusza

Te trzy wizje przyszłości nie są w relacji albo-albo. Są to raczej różne odpowiedzi na to samo wyzwanie. W zależności od zastosowania, regionu i celu, różne rozwiązania będą miały sens.

Kluczową kwestią nie jest to, który scenariusz przeważa, ale to, czy podstawowe decyzje są podejmowane świadomie. Zrównoważony rozwój nie wynika automatycznie z technologii. Wynika on z priorytetów.

Jeśli sztuczna inteligencja będzie używana wszędzie i przez cały czas, jej zapotrzebowanie na energię nieuchronnie wzrośnie. Jeśli jest używana w sposób ukierunkowany, zapotrzebowanie to można kontrolować. Nie jest to osąd moralny, ale trzeźwa obserwacja.

Prawdziwe pytanie dotyczące zrównoważonego rozwoju

Na końcu tego artykułu nie ma prostej odpowiedzi. Pytanie „Czy sztuczna inteligencja jest zrównoważona?“ jest mylące. Sugeruje ono, że istnieje jednoznaczna odpowiedź "tak" lub "nie".

Bardziej sensowne pytanie brzmi: do czego używamy sztucznej inteligencji i ile jesteśmy gotowi na nią wydać? Energia, zasoby, infrastruktura, uwaga polityczna. Tego pytania nie można powierzyć algorytmom.

Sztuczna inteligencja to narzędzie o ogromnym potencjale. Może sprawić, że procesy będą bardziej wydajne, wiedza bardziej dostępna, a decyzje bardziej świadome. Jednocześnie wymaga realnych zasobów. Oba są prawdziwe.

Ostrożnie optymistyczne perspektywy

Pomimo wszystkich wyzwań, istnieją powody do ostrożnego optymizmu. Problemy są widoczne. Są dyskutowane. Można je nazwać. To więcej niż można było powiedzieć o wielu wcześniejszych przewrotach technologicznych.

Debata na temat zrównoważonej sztucznej inteligencji nie zaczyna się od wyrzeczenia, ale od zrozumienia. Ci, którzy rozpoznają fizyczną rzeczywistość sztucznej inteligencji, mogą podejmować lepsze decyzje. Ci, którzy rozpoznają jej ograniczenia, mogą z niej rozsądnie korzystać.

Nie „wszystko samo się ułoży“. Ale też nie wszystko jest stracone. Istnieje szeroka przestrzeń między ślepą wiarą w postęp a paraliżującym sceptycyzmem. Przestrzeń ta określi rolę, jaką sztuczna inteligencja odegra w przyszłości - i jak zrównoważona może być w rzeczywistości.

Ostatecznie zrównoważony rozwój nie jest stanem, ale procesem. Sztuczna inteligencja będzie częścią tego procesu. Nie jako obietnica zbawienia, ale jako narzędzie, które musi być używane w sposób odpowiedzialny.

Często zadawane pytania

- Co dokładnie oznacza „zrównoważony rozwój“, jeśli chodzi o sztuczną inteligencję?

Zrównoważony rozwój w sztucznej inteligencji oznacza nie tylko ochronę klimatu czy oszczędność energii elektrycznej, ale całe zużycie zasobów w całym cyklu życia. Obejmuje to energię dla centrów danych, wodę do chłodzenia, surowce do produkcji chipów, infrastrukturę sieciową i długoterminowe skutki społeczne. Sztuczna inteligencja jest zrównoważona, gdy jej korzyści są w rozsądnej proporcji do tych kosztów. - Dlaczego sztuczna inteligencja zużywa tak dużo energii, skoro jest tylko oprogramowaniem?

Sztuczna inteligencja wygląda jak oprogramowanie, ale działa na bardzo wydajnym sprzęcie. Sprzęt ten działa przez całą dobę, równolegle przetwarza ogromne ilości danych i generuje przy tym dużo ciepła. Moc jest potrzebna nie tylko do obliczeń, ale także do chłodzenia, technologii sieciowej i niezawodności. - Czy zużycie energii przez sztuczną inteligencję to naprawdę nowy problem?

Nie jest to zasadniczo nowa technologia, ale nowa pod względem skali i szybkości. Podczas gdy wcześniejsze technologie cyfrowe rozwijały się powoli, sztuczna inteligencja skaluje się w ciągu zaledwie kilku lat. Sieci i dostawy energii często nie są na to przygotowane. - Czy więcej sztucznej inteligencji automatycznie oznacza większe zużycie energii?

W praktyce przeważnie tak. Chociaż systemy stają się coraz bardziej wydajne, spadające koszty prowadzą do ich większego wykorzystania. Tworzone są nowe aplikacje, mnożą się stare procesy. Wydajność spowalnia wzrost, ale rzadko go niweluje. - Dlaczego systemy AI nie mogą po prostu obliczyć, kiedy jest wystarczająco dużo mocy?

Wiele aplikacji AI wymaga ciągłej dostępności. Treningi trwają dni lub tygodnie, a usługi muszą być dostępne przez cały czas. Sztuczna inteligencja nie jest zatem elastycznym konsumentem, ale stałym obciążeniem podstawowym. - Jaką rolę odgrywają centra danych w debacie na temat zrównoważonego rozwoju?

Centra danych są fizycznym sercem sztucznej inteligencji. Łączą one zużycie energii, wytwarzanie ciepła i chłodzenie w jednym miejscu. Im większe i gęstsze się stają, tym większy jest ich wpływ na lokalną infrastrukturę i środowisko. - Dlaczego chłodzenie jest tak ważną kwestią w przypadku sztucznej inteligencji?

Potężne chipy generują ogromne ilości ciepła. Bez wydajnego chłodzenia szybko uległyby awarii. Nowoczesne systemy chłodzenia są złożone, energochłonne i często opierają się na wodzie, co tworzy nowe wąskie gardła. - Czy zużycie wody jest naprawdę istotne dla sztucznej inteligencji?

Tak, zwłaszcza regionalnie. Na obszarach, gdzie brakuje wody, centra danych konkurują z gospodarstwami domowymi, rolnictwem i przemysłem. Woda nie może być dowolnie transportowana i szybko staje się czynnikiem konfliktu politycznego. - Czy odnawialne źródła energii mogą w pełni pokryć zapotrzebowanie AI na energię elektryczną?

W dłuższej perspektywie mogą one wnieść znaczący wkład, ale obecnie same w sobie nie są wystarczające. Sztuczna inteligencja potrzebuje energii elektrycznej przez całą dobę. Bez magazynowania, rozbudowy sieci i dodatkowych źródeł energii pozostanie luka w podaży. - Dlaczego firmy zajmujące się sztuczną inteligencją nagle zainteresowały się energią jądrową?

Nie z ideologii, ale z potrzeby. Energia jądrowa dostarcza przewidywalną, ciągłą energię elektryczną przy niskim zużyciu gruntów. Ta stabilność jest atrakcyjna dla energochłonnych centrów danych, pomimo wszystkich znanych problemów. - Czy gaz ziemny jest zrównoważonym rozwiązaniem dla sztucznej inteligencji?

Gaz ziemny jest raczej rozwiązaniem przejściowym. Jest elastyczny i dostępny, ale powoduje emisje i zależności geopolityczne. Jest zrównoważony tylko w sensie względnym, a nie jako trwałe rozwiązanie. - Dlaczego firmy AI budują własne elektrownie?

Własne dostawy energii zapewniają przewidywalność i niezależność. Sieci publiczne osiągają swoje limity, autoryzacje zajmują dużo czasu. Prywatne elektrownie zabezpieczają operacje, ale przenoszą odpowiedzialność z państwa na firmę. - Czy prywatne dostawy energii stanowią problem dla AI?

Jest wydajny, ale nie neutralny społecznie. Może odciążyć sieci publiczne, ale częściowo pozostaje poza demokratyczną kontrolą. Energia staje się prywatnym zasobem o politycznej sile rażenia. - Czy lokalna sztuczna inteligencja może rozwiązać problem zrównoważonego rozwoju?

Lokalna sztuczna inteligencja może pomóc, wykorzystując mniejsze modele i przetwarzając dane lokalnie. Zmniejsza to scentralizowane obciążenia, ale nie zastępuje wszystkich aplikacji. Duże modele pozostają energochłonne. - Dlaczego sam postęp techniczny nie wystarczy?

Ponieważ wydajność zwykle prowadzi do większego wykorzystania. Technologia optymalizuje środki, a nie cele. Zrównoważony rozwój wymaga decyzji dotyczących tego, do czego wykorzystywana jest sztuczna inteligencja - a nie tylko tego, jak wydajnie oblicza. - Czy sztuczna inteligencja musi być zatem ściślej regulowana?

Regulacja może pomóc w ustaleniu priorytetów i ograniczeniu ekstremalnych zmian. Jest to jednak proces złożony i powolny. Decydującym czynnikiem nie jest maksymalna kontrola, ale rozsądne ramy. - Czy istnieje ryzyko, że sztuczna inteligencja wzmocni nierówności społeczne?

Tak, zwłaszcza ze względu na lokalizację i kwestie energetyczne. Regiony z dobrą infrastrukturą odnoszą korzyści, inne pozostają w tyle. Prywatne wyspy energetyczne mogą pogłębiać te dysproporcje. - Czy mimo tych wszystkich problemów jest powód do optymizmu?

Tak, wyzwania są widoczne i można o nich dyskutować. Sztuczna inteligencja nie jest zjawiskiem naturalnym, ale można ją kształtować. Ze świadomością, umiarem i jasnymi priorytetami, może być używana rozsądnie - bez wyprzedzania samej siebie.