Sadece birkaç yıl önce, yapay zeka araştırma kurumları ve büyük şirketler için bir konuydu. İnsanlar sinir ağları, derin öğrenme ve konuşma tanıma hakkında konuşuyordu - ancak günlük yaşamda pek bir rol oynamıyordu. Bugün, yapay zeka artık geleceğin bir konusu değil, bir gerçek: metinler yazıyor, görüntüler oluşturuyor, verileri analiz ediyor ve üretim süreçlerini kontrol ediyor. İster yönetimde, ister ticarette veya endüstride olsun - artık her yerde bulunabilir.

Dil modeli

Dil modelleri ve olası uygulamaları hakkında makaleler. Bu bölüm GPT, LLaMA, Mistral ve diğer LLM'leri temellerinden pratik uygulamalarına kadar ele almaktadır.

gFM-Business ve ERP'nin geleceği: bulut bağımlılığı yerine yerel zeka

On yılı aşkın bir süredir gFM-Business yazılımı Alman ERP pazarında özel bir yere sahiptir: Hantal, bakımı zor bir sisteme değil, hafif, özelleştirilebilir ve görsel olarak modellenmiş FileMaker platformuna dayanmaktadır. Bunun birçok avantajı vardır: gFM-Business bireysel olarak genişletilebilir, Windows, macOS ve iOS üzerinde çalışır ve hem geliştiriciler hem de hırslı uzman kullanıcılar tarafından özelleştirilebilir.

Yapay zekanın (AI) ortaya çıkmasıyla - özellikle ChatGPT gibi sözde dil modelleri aracılığıyla - artık geleneksel otomasyonun çok ötesine geçen yeni fırsatlar ortaya çıkıyor. gFM-Business bu geleceğe aktif olarak hazırlanıyor: sadece verileri yönetmek değil, aynı zamanda bilginin kilidini açmak amacıyla.

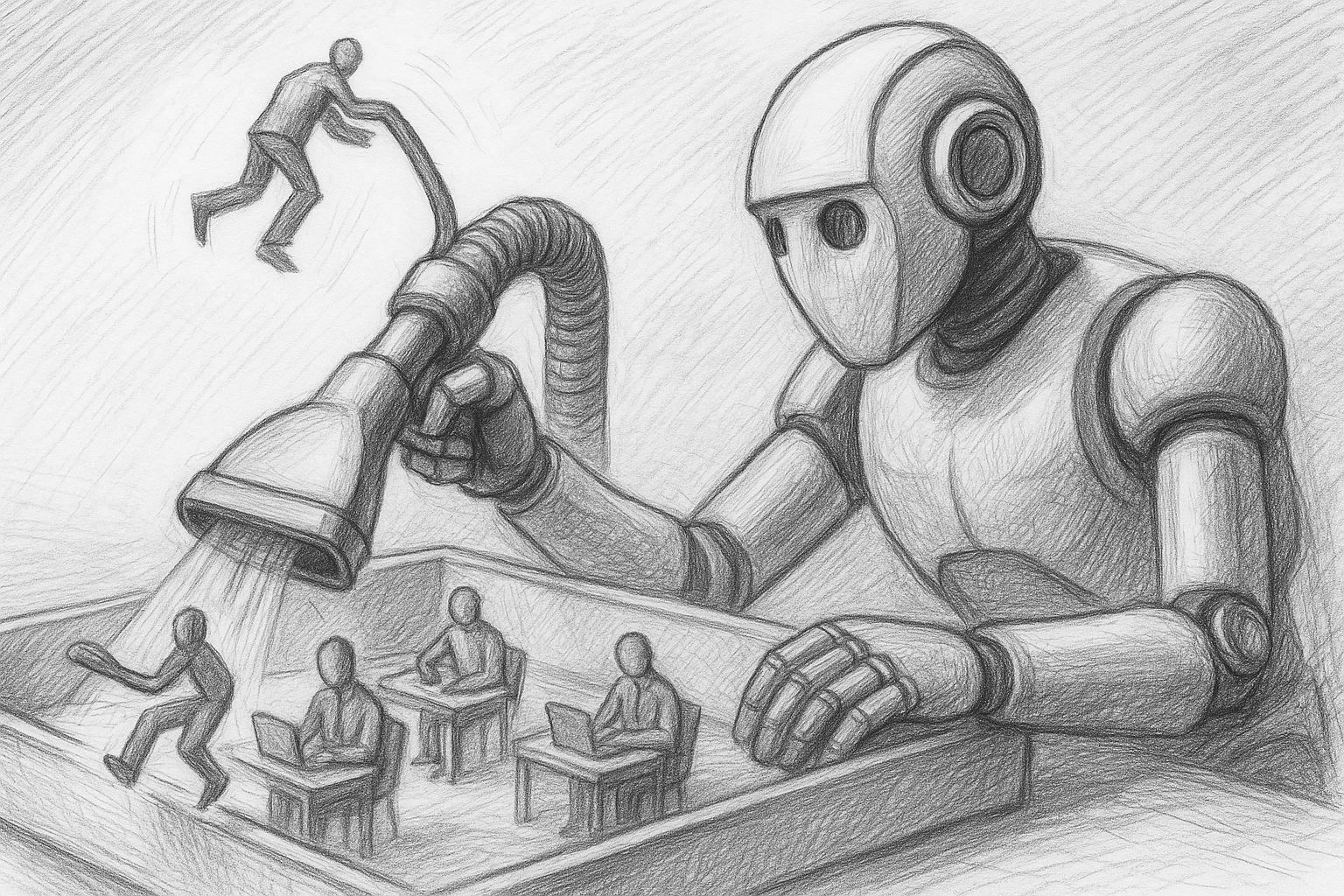

Yapay zeka: hangi işler risk altında ve şimdi kendimizi nasıl silahlandırabiliriz

Neredeyse hiçbir teknolojik değişim yapay zeka kadar hızlı bir şekilde günlük hayatımıza girmedi. Dün geleceğin vizyoner teknolojisi olarak görülen şey bugün artık bir gerçek - ister mesajlaşmada, ister programlamada, ister teşhis koymada, ister çeviride, hatta ister müzik, sanat ya da hukuk özetleri yaratmada olsun.

MLX'in FileMaker 2025'e entegrasyonu: Yeni standart olarak yerel yapay zeka

MLX başlangıçta Apple Research tarafından deneysel bir çerçeve olarak başlatılmış olsa da, son aylarda sessiz ama önemli bir gelişme yaşandı: FileMaker 2025'in piyasaya sürülmesiyle Claris, MLX'i Apple Silicon için yerel bir yapay zeka altyapısı olarak sunucuya sağlam bir şekilde entegre etti. Bu, Mac ile çalışan ve Apple Silicon kullanan herkesin MLX modellerini yalnızca yerel olarak çalıştırabileceği değil, aynı zamanda bunları herhangi bir ara katman olmadan yerel işlevlerle doğrudan FileMaker'de kullanabileceği anlamına geliyor.

Ollama & Co. ile karşılaştırıldığında yerel AI olarak Apple Silicon üzerinde MLX.

ChatGPT, Claude veya Gemini gibi merkezi yapay zeka hizmetlerinin manşetlere çıktığı bir dönemde, birçok profesyonel kullanıcının yerel, kendi kendini kontrol edebilen bir yapay zeka altyapısı gibi bir alternatife olan ihtiyacı giderek artıyor. Özellikle yaratıcı süreçler, hassas veriler veya yinelenen iş akışları için yerel bir çözüm genellikle daha sürdürülebilir ve güvenli bir seçenektir.

Mac ile çalışan herkes - özellikle Apple Silicon (M1, M2, M3 veya M4) ile - artık kendi dil modellerini doğrudan cihaz üzerinde çalıştırmak için inanılmaz güçlü araçlar bulabilir. Bunun merkezinde büyük ölçüde bilinmeyen yeni bir bileşen var: MLX, Apple tarafından geliştirilen ve önümüzdeki yıllarda şirketin yapay zeka ekosisteminde giderek daha merkezi bir rol oynaması muhtemel bir makine öğrenimi çerçevesi.

Ollama Qdrant ile buluşuyor: Mac'te yapay zekanız için yerel bir bellek

Hafızalı yerel yapay zeka - bulut olmadan, abonelik olmadan, saptırma olmadan

Bir önceki makaleler Mac install üzerinde Ollama'nin nasıl yapılandırılacağını anlattım. Bu adımı zaten tamamladıysanız, artık Mistral, LLaMA3 veya REST API aracılığıyla adreslenebilen başka bir uyumlu model gibi güçlü bir yerel dil modeline sahipsiniz demektir.

Ancak, model yalnızca mevcut istemde ne olduğunu "bilir". Önceki konuşmaları hatırlamaz. Eksik olan şey bir hafıza.

Mac'te Yerel Yapay Zeka: Ollama ile bir dil modeli nasıl installiere edilir

Mac'te yerel yapay zeka uzun zamandır pratiktir - özellikle Apple-Silicon bilgisayarlarda (M serisi). Ollama ile birçok açık kaynak dil modeli (örneğin Llama 3.1/3.2, Mistral, Gemma, Qwen) için yalın bir çalışma zamanı ortamı elde edersiniz. Mevcut Ollama sürümü artık bir fare tıklamasıyla Mac'inizde yerel bir dil modeli kurmanıza olanak tanıyan kullanıcı dostu bir uygulama ile birlikte geliyor. Bu makalede kurulumdan ilk komut istemine kadar pragmatik bir rehber bulacaksınız - geleneksel olarak işlerin nerede yanlış gitme eğiliminde olduğuna dair pratik ipuçları ile birlikte.