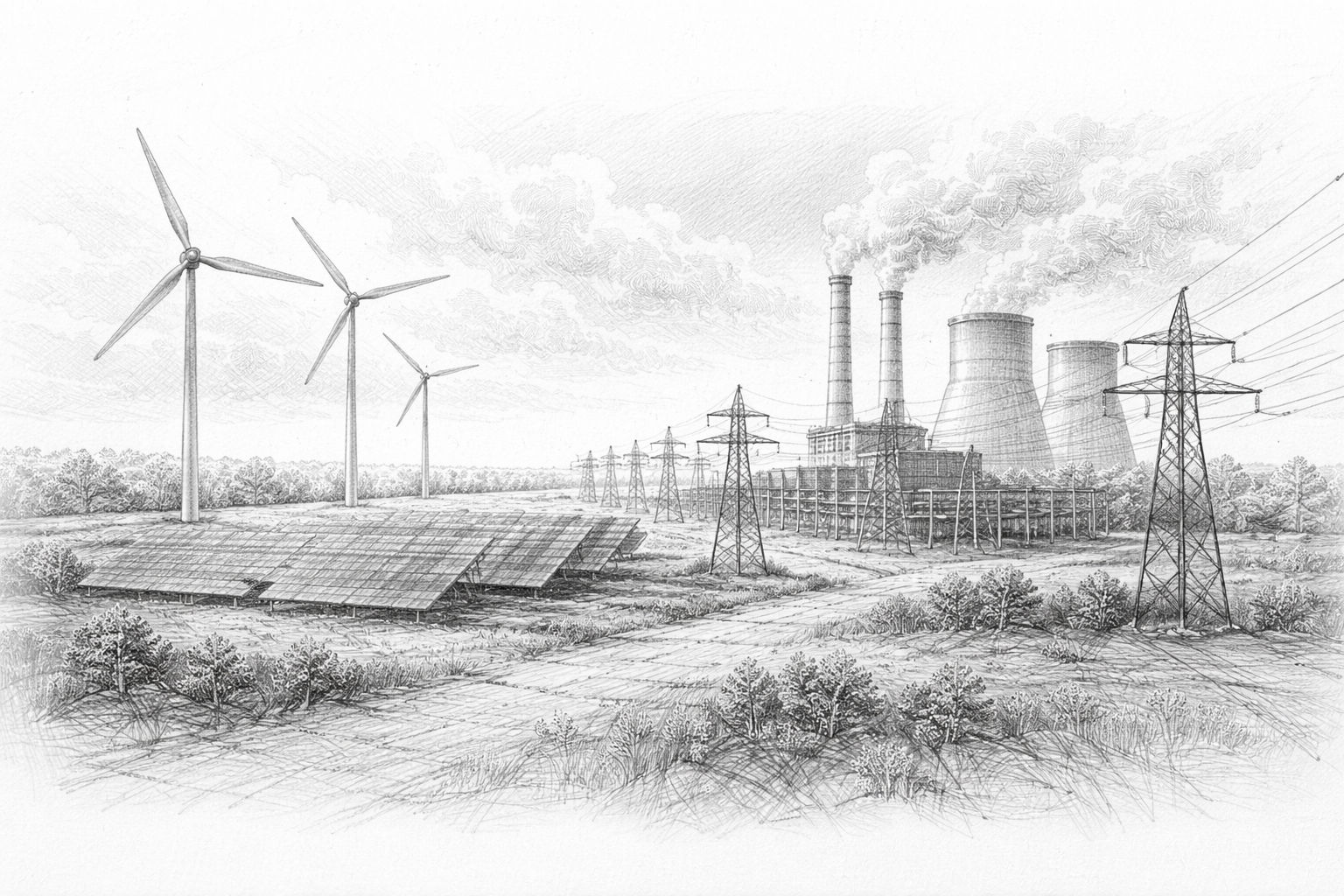

A prima vista, l'intelligenza artificiale sembra quasi priva di peso. Si digita una domanda e pochi secondi dopo appare la risposta. Nessun rumore, nessun fumo, nessun movimento visibile. Tutto sembra avvenire „nella nuvola“. È proprio questo l'errore di pensiero. L'intelligenza artificiale non è una magia astratta, ma il risultato di processi fisici molto concreti. Dietro ogni risposta ci sono centri dati, linee elettriche, sistemi di raffreddamento, chip e intere infrastrutture. Più l'IA entra nella nostra vita quotidiana, più questa realtà diventa visibile. Ed è qui che inizia la questione della sostenibilità.

Chiunque parli di IA senza parlare di energia, risorse e infrastrutture sta solo descrivendo la superficie. Questo articolo va più a fondo. Non con allarmismo, ma con uno sguardo sobrio su ciò di cui l'IA ha effettivamente bisogno per funzionare, oggi e in futuro.

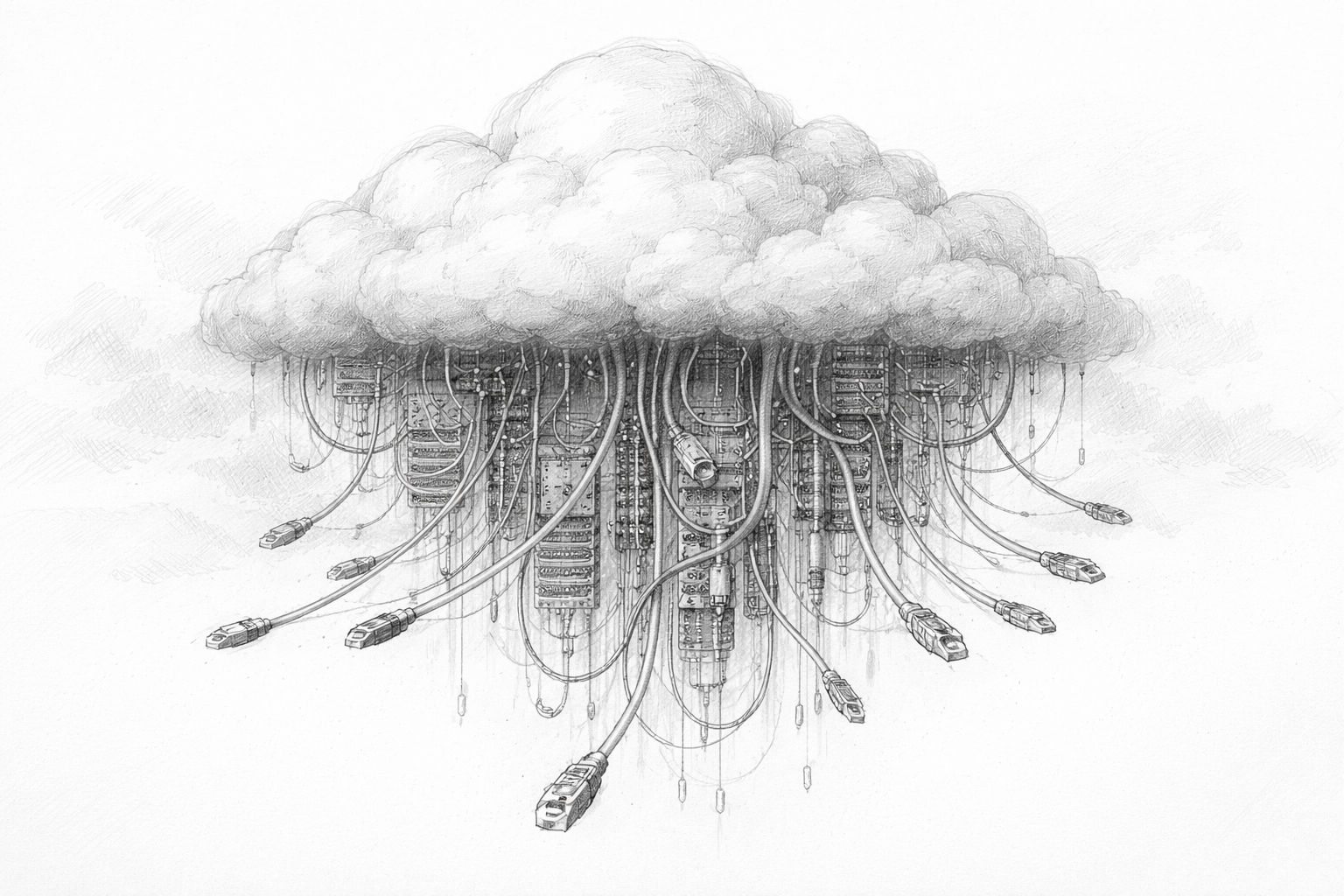

L'idea sbagliata comune: l'IA come „nuvola immateriale“.“

Molti immaginano l'IA come un software del passato: un programma che gira da qualche parte, viene aggiornato e basta. Questa idea deriva da un'epoca in cui la potenza di calcolo era relativamente economica, limitata localmente ed energeticamente poco appariscente. L'IA va oltre questo quadro.

Il termine „nuvola“ rafforza ulteriormente questa impressione. Ha un suono morbido, quasi naturale. Le nuvole galleggiano, non appesantiscono nulla. In realtà, nasconde una delle industrie più energivore del nostro tempo. Grandi sale piene di computer ad alte prestazioni che funzionano 24 ore su 24. Migliaia di chilometri di cavi. Migliaia di chilometri di cavi. Sistemi di raffreddamento enormi. Manutenzione permanente.

La differenza rispetto al software tradizionale non sta nel principio, ma nella scala. L'intelligenza artificiale non ha una scala lineare. Più diventa potente, più richiede risorse. E non cresce in un luogo astratto, ma in modo molto specifico sul posto.

Di cosa ha bisogno l'IA moderna

Per capire perché l'IA non è più solo un argomento di software, è utile dare un'occhiata alle sue esigenze di base. I moderni sistemi di IA richiedono tre cose in particolare: potenza di calcolo, energia e raffreddamento.

La potenza di calcolo non si crea dal nulla. È fornita da chip specializzati ottimizzati per l'apprendimento automatico. Questi chip lavorano in parallelo, con estrema rapidità, e consumano enormi quantità di energia. Più grande è il modello di intelligenza artificiale, più chip devono lavorare simultaneamente. Un singolo modello può essere composto da decine di migliaia di unità di calcolo di questo tipo.

Il consumo di energia non è un effetto collaterale, ma un fattore chiave. L'intelligenza artificiale non effettua calcoli selettivi, ma continui. Le richieste arrivano 24 ore su 24. Le esercitazioni richiedono giorni o settimane. L'immobilismo non è un'opzione economica. Il sistema deve funzionare, sia di notte che nel fine settimana o nei giorni festivi.

Questo crea immediatamente il problema successivo: il calore. L'energia elettrica non viene convertita completamente in potenza di calcolo. Una parte significativa di essa diventa calore di scarto. Senza un ampio raffreddamento, i moderni computer AI si guasterebbero in breve tempo. Il raffreddamento, a sua volta, richiede energia e spesso acqua.

È qui che diventa chiaro: l'IA è fisica. È legata ai luoghi, alle reti, alle risorse. E questo la rende inevitabilmente una questione di sostenibilità, anche se si vuole evitare di usare questa parola.

Formazione e utilizzo: due carichi completamente diversi

Un altro punto spesso trascurato nel dibattito pubblico è la differenza tra l'addestramento di un'IA e il suo successivo utilizzo. Le due cose vengono spesso accomunate, anche se gli oneri sono molto diversi.

Durante l'addestramento vengono elaborate grandi quantità di dati. Il sistema apprende connessioni, schemi, linguaggio e immagini. Questa fase è estremamente intensiva dal punto di vista computazionale. Di solito è concentrata in grandi centri dati e può consumare enormi quantità di energia. Una singola sessione di addestramento per un modello di grandi dimensioni può consumare la stessa quantità di elettricità di una piccola città per un periodo di tempo più lungo.

Alla formazione segue l'utilizzo. In questo caso, il modello non viene più modificato in modo sostanziale, ma applicato. Ogni richiesta attiva processi di calcolo, ma su scala ridotta. Il problema sta nelle masse. Quando milioni o miliardi di persone utilizzano l'IA ogni giorno, questo sforzo apparentemente piccolo si aggiunge a un carico di base permanente.

Entrambe le fasi sono rilevanti. La formazione garantisce i picchi di carico, l'utilizzo assicura un consumo continuo. La sostenibilità deve tenere conto di entrambi i livelli, altrimenti l'analisi rimane incompleta.

Perché l'IA è diversa dalla precedente digitalizzazione

Si potrebbe obiettare che ogni nuova tecnologia consuma energia. È vero. Ma l'IA si differenzia dalle precedenti fasi di digitalizzazione per un aspetto cruciale: non si limita a sostituire i processi esistenti, ma ne crea di nuovi.

Internet ha reso la comunicazione più efficiente. Le e-mail hanno sostituito le lettere, le videoconferenze i viaggi di lavoro. L'intelligenza artificiale, d'altra parte, è spesso utilizzata in aggiunta. I testi non sono solo scritti, ma variati più volte. Le immagini non vengono solo create, ma in serie. Le decisioni non sono automatizzate e finalizzate, ma simulate, valutate e ricalcolate.

I guadagni di efficienza in questo caso spesso non si traducono in risparmi, ma in un maggiore utilizzo. Ciò che è economico e rapidamente disponibile viene utilizzato più spesso. Questo fenomeno non è nuovo, ma è particolarmente accentuato con l'IA. Più migliora, più aumenta il desiderio di utilizzarla ovunque. È proprio per questo che la speranza che l'efficienza tecnica risolva da sola il problema della sostenibilità non è sufficiente. Anche sistemi più efficienti possono portare a un aumento del consumo complessivo.

Quando oggi si parla di IA sostenibile, spesso c'è un sottofondo morale. Questo è comprensibile, ma non sempre utile. Prima di parlare di bene e male, vale la pena di dare un'occhiata ai principi fisici.

L'elettricità deve essere generata. Il calore deve essere dissipato. L'acqua è finita. Le reti hanno limiti di capacità. Questi fatti non possono essere ignorati, a prescindere da quanto sia avanzato il software. La sostenibilità non inizia quindi con le buone intenzioni, ma con la domanda:

Cosa è tecnicamente e infrastrutturalmente fattibile?

Solo quando si comprende questa base si possono prendere decisioni significative. Decisioni su dove utilizzare l'IA, in che misura e a quale prezzo, sia dal punto di vista economico che sociale.

La vera domanda alla base del dibattito

Alla fine di questo primo capitolo, non c'è ancora una valutazione, ma piuttosto un cambiamento di prospettiva. La domanda cruciale non è: „L'IA è sostenibile?“. Questa domanda è troppo generica e invita a risposte rapide.

La domanda più precisa è: quale forma di IA vogliamo e quanto siamo disposti a spendere per essa? Energia, risorse, infrastrutture, decisioni politiche: tutto questo fa parte dell'equazione. Chiunque consideri l'IA solo come un prodotto software non tiene conto di queste interrelazioni.

I capitoli che seguono non sono quindi incentrati sull'entusiasmo o sulla paura, ma sulle strutture. Di politica energetica, progettazione di chip, problemi di localizzazione e scenari futuri. Perché solo quando si riesce a vedere la macchina dietro la magia si può parlare in modo significativo del suo futuro.

La svolta politica: quando l'intelligenza artificiale chiederà le proprie centrali elettriche

A volte una singola frase dice di più sullo stato di uno sviluppo che pagine di studi. Quando Donald Trump, al World Economic Forum di Davos, ha detto che le aziende di intelligenza artificiale dovrebbero costruire le proprie centrali elettriche o costruire partecipare al finanziamento, Non si trattava di un elaborato masterplan di politica energetica. Ma è stato un momento straordinariamente onesto. Perché questa frase contiene una consapevolezza non espressa:

L'intelligenza artificiale non è più solo un'altra branca del software, ma un complesso industriale con un enorme fabbisogno energetico.

Indipendentemente dal giudizio politico su Trump, la dichiarazione tocca un nervo scoperto. Le grandi aziende di intelligenza artificiale stanno dicendo apertamente che non possono più fare affidamento sulle reti elettriche esistenti per „soddisfare“ le loro esigenze a lungo termine. Hanno bisogno di energia prevedibile, permanente e in grandi quantità. Ed è proprio qui che inizia la dimensione politica della sostenibilità dell'IA.

I centri dati come nuova industria pesante

Per molto tempo i data center sono stati considerati un'infrastruttura relativamente poco appariscente. Erano situati da qualche parte alla periferia della città, consumavano elettricità, generavano calore e per il resto non erano oggetto di dibattito pubblico. Ora la situazione sta cambiando radicalmente.

I moderni data center di intelligenza artificiale hanno dimensioni che in passato erano note solo all'industria tradizionale. Il loro fabbisogno energetico può essere equivalente a quello di un parco industriale di medie dimensioni. I requisiti di raffreddamento sono complessi. Il loro fabbisogno di spazio è in crescita. E soprattutto, non funzionano solo durante il giorno, ma 24 ore su 24, sette giorni su sette.

Ciò li pone automaticamente nella stessa categoria delle acciaierie, degli impianti chimici o delle raffinerie. In passato, tali impianti erano specificamente localizzati, sostenuti politicamente e pianificati in termini di politica energetica. Esattamente le stesse questioni si pongono oggi con le infrastrutture di IA, solo molto più velocemente e spesso senza chiare responsabilità.

Perché la politica non può essere evitata qui

L'energia non è un mercato libero nel vuoto. Le reti elettriche, le centrali e le procedure di autorizzazione sono regolate politicamente, pianificate a lungo termine e socialmente sensibili. Se un singolo centro dati ha improvvisamente bisogno di energia elettrica come un'intera città, ciò non è privo di conseguenze.

I politici si trovano di fronte a un dilemma. Da un lato, l'IA è considerata una tecnologia chiave per la competitività economica, l'innovazione e la sicurezza nazionale. Dall'altro, il suo fabbisogno energetico è in diretta concorrenza con le famiglie, le PMI e l'industria esistente. L'aumento dei prezzi dell'elettricità, i costi di espansione della rete e le strozzature locali si trasformano rapidamente in conflitti politici.

L'idea che le aziende di IA debbano organizzare il proprio approvvigionamento energetico non è quindi solo pragmatica, ma anche politicamente alleggerita. Si tratta di uno spostamento di responsabilità. Invece di espandere e sovvenzionare le reti pubbliche, gli attori privati dovrebbero creare le proprie soluzioni. Sembra un'economia di mercato, ma ha conseguenze di vasta portata.

Trump e la questione tecnologica-energetica: una svolta politica

Negli Stati Uniti è in corso un caso insolito proposta di politica energetica per la discussione: il presidente Donald Trump e diversi governatori stanno spingendo affinché le grandi aziende tecnologiche cofinanzino effettivamente la costruzione di nuove centrali elettriche per limitare l'aumento dei costi dell'elettricità per le famiglie.

Lo sfondo è la massiccia richiesta di elettricità da parte dei data center, che vengono gestiti, tra l'altro, per i servizi di intelligenza artificiale e che mettono a dura prova la rete. È prevista una cosiddetta asta di affidabilità, in cui le aziende tecnologiche dovranno stipulare contratti di elettricità a lungo termine che garantiscano la costruzione di centrali elettriche, indipendentemente dal fatto che acquistino effettivamente l'elettricità. Ciò potrebbe innescare investimenti miliardari in nuove centrali elettriche e ridurre la pressione sulle reti pubbliche. Tuttavia, i critici mettono in guardia da possibili effetti collaterali, come l'aumento dei costi per i fornitori più piccoli e una maggiore privatizzazione delle infrastrutture energetiche.

La logica del „costruite le vostre centrali elettriche“

A prima vista, l'idea sembra radicale. A ben guardare, però, segue una logica chiara. Chiunque abbia bisogno di grandi quantità di energia su base permanente dovrebbe anche partecipare alla sua generazione. Questa è stata una pratica comune nell'industria per molto tempo. Le fabbriche gestivano le proprie centrali elettriche o stipulavano contratti di fornitura a lungo termine.

Per le aziende di AI, ciò significa disporre di proprie centrali elettriche, di propri impianti di stoccaggio dell'elettricità, di collegamenti diretti con i produttori o di contratti di fornitura esclusiva. Si può trattare di gas, energia nucleare, energie rinnovabili o forme miste. Il fattore decisivo non è la tecnologia, ma la capacità di pianificazione.

Tuttavia, questo crea una nuova forma di infrastruttura: le isole energetiche private. Centri dati ad alte prestazioni con una propria fornitura, una propria priorità e una propria sicurezza. Sono meno dipendenti dalla rete pubblica e quindi meno coinvolti nei tradizionali meccanismi di bilanciamento.

Quando la politica di localizzazione diventa politica energetica

È qui che diventa chiaro il motivo per cui l'infrastruttura di IA è politicamente controversa. L'ubicazione di un centro dati non viene più scelta solo in base alle leggi fiscali o al lavoro, ma anche in base alla disponibilità di energia, alla situazione delle autorizzazioni e alla prevedibilità politica.

Le regioni con reti stabili, fonti energetiche favorevoli e approvazione rapida stanno diventando più attraenti. Altre rimangono indietro. Questo può esacerbare gli squilibri esistenti, tra Paesi, all'interno dei Paesi e persino tra Comuni.

Si tratta di una situazione nuova per i decisori locali. Da un lato, i centri dati promettono investimenti e prestigio. Dall'altro lato, non portano quasi nessun posto di lavoro, ma costi infrastrutturali elevati. È necessario fornire strade, reti, collegamenti idrici e misure di sicurezza, mentre i benefici diretti rimangono limitati.

Ciò che sembra astratto nelle strategie nazionali diventa molto concreto sul campo. I cittadini si chiedono perché si costruiscono nuove condutture. Perché l'acqua scarseggia. Perché i prezzi dell'elettricità stanno aumentando. E perché tutto questo accade affinché si possano generare testi o calcolare immagini da qualche parte.

La questione dell'accettazione è spesso sottovalutata. Mentre i prodotti industriali tradizionali sono tangibili, i benefici dell'IA rimangono vaghi per molte persone. Ciò rende più difficile la comunicazione politica. La sostenibilità non è solo una categoria tecnica, ma anche sociale. Più l'infrastruttura diventa visibile, maggiore è la pressione per giustificarla. L'IA non può essere considerata in modo permanente come un servizio invisibile se le sue tracce fisiche diventano sempre più evidenti.

Cambiamento di potere attraverso l'autosufficienza energetica

Un altro aspetto è raramente discusso apertamente: L'autosufficienza energetica crea potere. Chi controlla il proprio approvvigionamento è meno dipendente dalle decisioni politiche, dai guasti della rete o dagli interventi normativi.

Questo è interessante per le grandi aziende tecnologiche. Può essere problematico per gli Stati. Infatti, gli strumenti di controllo tradizionali - tariffe di rete, definizione delle priorità, interruzioni - sono meno efficaci quando le infrastrutture critiche sono organizzate privatamente.

Questo crea un nuovo livello di negoziazione tra politica e aziende tecnologiche. Non si tratta più solo di dati o di normative, ma di energia, spazio e risorse a lungo termine.

Il punto di svolta è stato raggiunto

Il primo capitolo ha mostrato che l'IA è fisica. Questo capitolo mostra che questa fisica sta diventando politica. L'affermazione secondo cui le aziende di IA dovrebbero costruire le proprie centrali elettriche non segna uno slittamento, ma un punto di svolta. Rende visibile ciò che finora è stato spesso ignorato: L'IA non è solo una questione di algoritmi, ma di infrastrutture, potere e responsabilità.

I prossimi capitoli saranno quindi ancora più specifici. Si tratta di volumi di elettricità, raffreddamento, acqua e limiti tecnici. Perché solo quando si capiranno queste basi si potrà parlare di sostenibilità in modo realistico, al di là delle parole d'ordine e delle dichiarazioni d'intenti.

Fame di energia, raffreddamento, acqua: la realtà fisica dell'IA

Finché l'IA sarà vista come un fenomeno software, i numeri rimarranno astratti. Qualche centesimo in più di potenza di calcolo qui, un nuovo modello là. Ma non appena si inizia a pensare al fabbisogno energetico in chilowattora, megawatt o addirittura terawattora, la prospettiva cambia. Non si tratta più di espedienti tecnici, ma di risorse reali, reti, centrali elettriche e conflitti di distribuzione.

Questo capitolo è dedicato proprio a questo livello. Non per creare paura, ma per dipingere un quadro realistico. Perché la sostenibilità inizia dove i concetti astratti si traducono in confini fisici.

Quanta elettricità consuma davvero l'intelligenza artificiale

Una delle domande più frequenti è: „Quanta energia consuma effettivamente l'IA?“. La risposta onesta è: dipende. Dipende dal modello, dall'uso, dal luogo e dall'hardware. Tuttavia, è possibile fornire un ordine di grandezza - ed è rivelatore.

Oggi i grandi data center di intelligenza artificiale operano in intervalli di potenza che un tempo erano tipici di intere aree industriali. I singoli sistemi richiedono diverse centinaia di megawatt di carico collegato. Ciò equivale al fabbisogno energetico di decine di migliaia di abitazioni. E non si tratta di un valore di picco una tantum, ma di un carico permanente.

L'aspetto importante è che l'IA non genera consumi stagionali come gli impianti di riscaldamento o di condizionamento. Funziona in modo continuo. Questo lo rende un cosiddetto carico di base. È proprio questo tipo di consumo che rappresenta una sfida particolare per le reti elettriche, perché deve essere assicurato in modo permanente.

Il punto cruciale non è se questa domanda di elettricità sia „troppo alta“, ma quanto velocemente stia crescendo. Mentre le industrie tradizionali si sono spesso espanse nell'arco di decenni, le infrastrutture di IA crescono in pochi anni. Le reti, le centrali elettriche e le procedure di autorizzazione non sono progettate per questo ritmo.

Perché le previsioni sono spesso fraintese

Nel dibattito pubblico si citano spesso grandi cifre. Raddoppio del consumo di elettricità, esplosione della domanda, oneri enormi. Queste affermazioni non sono sbagliate, ma spesso vengono fraintese.

Non significa che domani si spegneranno le luci. Significa però che la pianificazione a lungo termine è sotto pressione. Le reti elettriche sono costruite per profili di carico specifici. Se questi profili cambiano radicalmente, si creano colli di bottiglia a livello locale, regionale o nazionale.

Il problema non è tanto il consumo assoluto quanto la concentrazione. I data center di intelligenza artificiale non sono distribuiti in modo uniforme. Si concentrano dove le reti, il raffreddamento e le condizioni politiche sono favorevoli. È proprio qui che sorgono i conflitti.

Raffreddamento: il secondo sistema invisibile

L'elettricità è solo metà della storia. Ogni chilowattora consumato da un data center prima o poi si trasforma in calore. Questo calore deve essere dissipato, altrimenti le operazioni crollano. Il raffreddamento non è quindi un componente aggiuntivo, ma un sistema operativo centrale della moderna infrastruttura di intelligenza artificiale.

Una volta il raffreddamento ad aria era sufficiente. Ventole, sistemi di condizionamento, aria calda di scarico. Con la crescente densità di potenza dei chip moderni, questo principio ha raggiunto i suoi limiti. Oggi si utilizzano sempre più spesso sistemi di raffreddamento a liquido in cui i refrigeranti vengono forniti direttamente ai processori. Questi sistemi sono più efficienti, ma più complessi. Richiedono pompe, scambiatori di calore e meccanismi di emergenza. E creano nuove dipendenze: dall'acqua, dai refrigeranti chimici, dalle temperature stabili.

Il raffreddamento non è un problema di dettaglio. Determina dove i data center possono essere gestiti. Le regioni con temperature esterne elevate, risorse idriche scarse o reti instabili restano indietro.

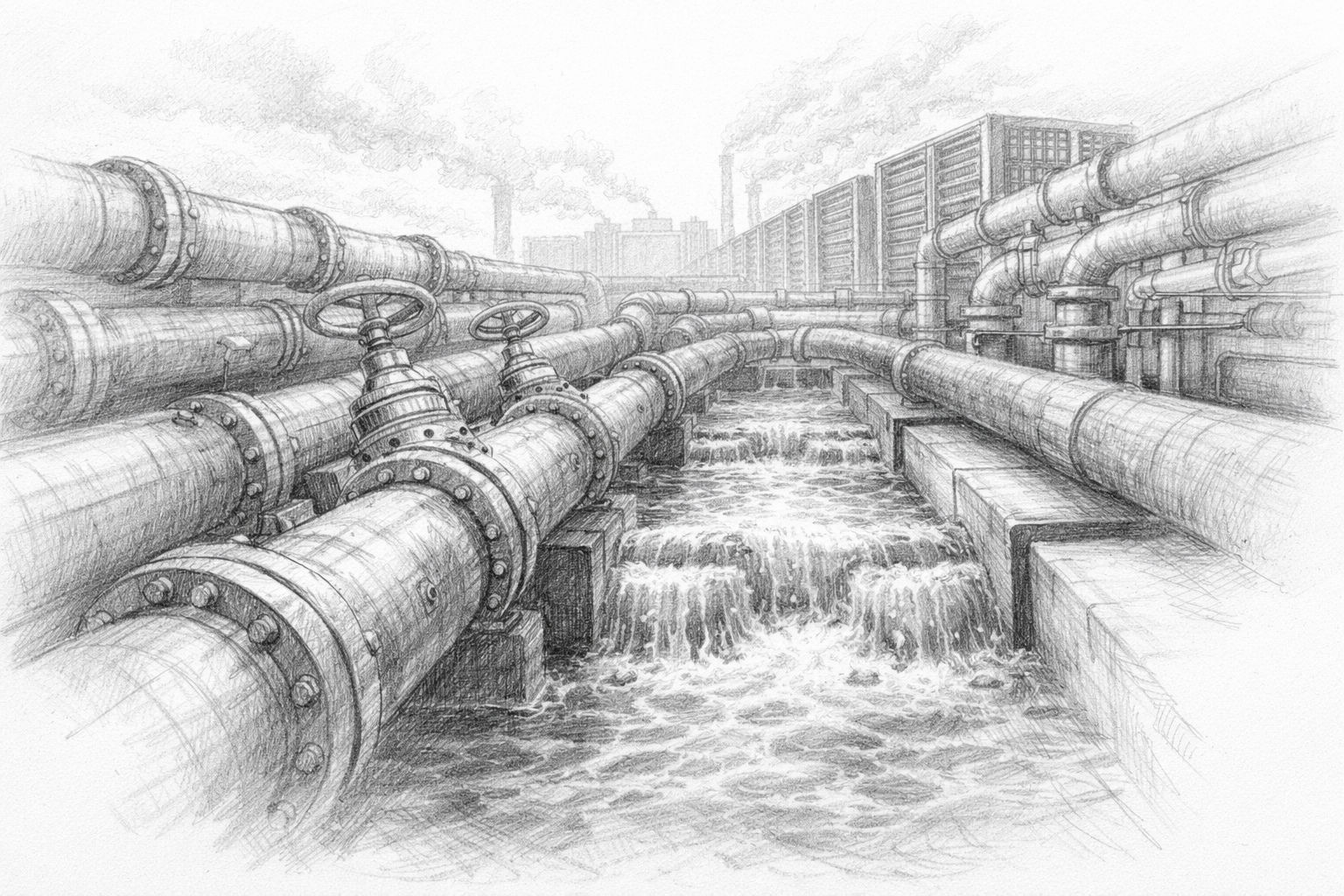

L'acqua: il collo di bottiglia, spesso taciuto

Mentre si parla molto di elettricità, l'acqua è sorprendentemente spesso esclusa dall'equazione. Eppure è indispensabile in molti concetti di raffreddamento. Raffreddamento evaporativo, impianti di raffreddamento, scambiatori di calore: tutti richiedono acqua in quantità rilevanti. Nelle regioni ricche d'acqua, questo aspetto è poco evidente. Nelle regioni aride, invece, l'acqua diventa rapidamente una questione politica. Quando i centri dati competono con l'agricoltura, l'industria e le famiglie, sorgono conflitti di distribuzione. E questi non possono essere risolti semplicemente con il denaro.

Inoltre, il consumo di acqua è locale. L'elettricità può essere trasportata attraverso le reti, l'acqua solo in misura limitata. Ciò rende il fattore ubicazione ancora più critico. Un centro dati non può essere costruito semplicemente dove il terreno è economico se non c'è acqua.

Il dibattito sulla sostenibilità dell'IA diventerà quindi inevitabilmente più regionale. Ciò che sembra avere senso a livello globale può essere problematico a livello locale.

Spesso si sostiene che le nuove tecnologie allevieranno il problema. Chip più efficienti, raffreddamento migliore, software ottimizzato. Questo non è sbagliato, ma è incompleto. I guadagni di efficienza riducono il consumo per unità di calcolo. Allo stesso tempo, i costi e le barriere all'implementazione stanno diminuendo. Questo spesso porta a utilizzare l'IA con maggiore frequenza e in nuovi settori. L'effetto complessivo può essere addirittura un aumento dei consumi.

Questo schema è già noto in altre aree. Motori più efficienti non hanno portato a una riduzione del traffico, ma a un aumento. Un'illuminazione più efficiente non ha ridotto automaticamente il consumo di elettricità, ma ne ha aumentato l'utilizzo. L'intelligenza artificiale segue lo stesso principio.

La sostenibilità non può quindi essere risolta solo dal punto di vista tecnico. È sempre una questione di limiti, priorità e decisioni consapevoli.

Le reti elettriche come collo di bottiglia

Un altro aspetto viene spesso sottovalutato: la rete elettrica stessa. Costruire centrali elettriche è complesso, ma espandere le reti è spesso ancora più complicato. Autorizzazioni, percorsi, accettazione: tutto questo richiede tempo.

I data center di intelligenza artificiale non solo hanno bisogno di molta energia, ma anche di reti stabili. Fluttuazioni di tensione, interruzioni o colli di bottiglia possono causare danni costosi. Per questo motivo gli operatori prediligono le località con un'elevata qualità della rete. Questo porta a una situazione paradossale. È proprio dove le reti sono ben sviluppate che la pressione aumenta maggiormente. I nuovi grandi consumatori aggravano i colli di bottiglia esistenti. L'espansione è in ritardo.

Questo dimostra ancora una volta che l'IA non è un sistema isolato. Ha un impatto sulle infrastrutture esistenti e ne modifica i requisiti.

Al più tardi a questo punto, diventa chiaro che la realtà fisica dell'IA non può essere vista in modo isolato dalle questioni sociali. Elettricità, acqua e reti sono beni comuni. Il loro uso è politicamente regolato e socialmente sensibile.

Quanto più l'IA assorbe queste risorse, tanto più si pone la questione delle priorità:

- Per cosa usiamo l'energia?

- Quali applicazioni giustificano quali spese?

- E chi decide?

A queste domande non possono rispondere solo gli ingegneri. Esse riguardano in egual misura la politica, l'economia e la società.

La scomoda constatazione

Questo capitolo porta a una consapevolezza scomoda ma necessaria: l'IA non è un prodotto digitale „pulito“. È inserita in un mondo materiale con risorse limitate. Ogni utilizzo ha un prezzo, anche se non è immediatamente visibile.

In questo contesto, sostenibilità non significa fare a meno, ma consapevolezza. Consapevolezza delle dimensioni, delle interrelazioni e delle conseguenze. Solo quando si riconosce questa realtà è possibile sviluppare soluzioni praticabili.

Il prossimo capitolo si concentra sulla tecnologia stessa, sui chip, sulla promessa di efficienza e sulla questione se il progresso tecnologico sia sufficiente da solo a superare queste sfide.

AI e crisi idrica: perché i data center consumano troppa acqua? | DW Tedesco

Chip, efficienza e l'illusione del processo tecnico di autoguarigione

Quando si parla dell'enorme fabbisogno energetico dell'IA, quasi di riflesso segue una frase rassicurante: la tecnologia sta diventando più efficiente. Nuovi chip, software migliori, raffreddamento più intelligente: il problema sarà risolto con la prossima generazione. Questa speranza è comprensibile. È alimentata da decenni di esperienza. I computer sono diventati più piccoli, più veloci e più economici. Perché l'IA dovrebbe essere diversa?

La risposta breve è: i guadagni di efficienza sono reali, ma non risolvono automaticamente il problema di base. Al contrario, possono addirittura aggravarlo. Per capirlo, vale la pena dare un'occhiata più da vicino alla tecnologia alla base dell'IA e alle dinamiche che l'efficienza innesca.

Perché i chip specializzati hanno prestazioni così elevate e consumano così tanto

L'intelligenza artificiale moderna non funziona più sui classici processori universali. Richiede unità di calcolo specializzate in grado di eseguire molti calcoli semplici in parallelo. È proprio qui che risiedono i loro punti di forza e di debolezza. Questi chip sono progettati per elaborare contemporaneamente enormi quantità di dati. Non calcolano passo dopo passo, ma in grandi blocchi. Questo li rende estremamente potenti, ma anche avidi di energia. Più la potenza di calcolo è concentrata, maggiore è il calore disperso e più complesso è il raffreddamento.

Il punto chiave è che questi chip non sono costruiti per essere economici, ma per fornire la massima produttività. L'efficienza ha un ruolo importante, ma le prestazioni sono al centro della scena. Perché nella competizione per le capacità dell'intelligenza artificiale, la velocità conta. Chi si allena più velocemente, chi esegue modelli più grandi, ottiene un vantaggio.

Questo crea un conflitto strutturale di obiettivi. L'efficienza viene migliorata, ma non a scapito di un aumento delle prestazioni. Il consumo complessivo non diminuisce necessariamente, ma si sposta.

Prestazioni per watt - un dato importante ma limitato

Negli ultimi anni si è affermata una nuova cifra chiave: Prestazioni per watt. Descrive la quantità di potenza di calcolo ottenuta con una certa quantità di energia. Questo dato è utile perché visualizza l'efficienza. Tuttavia, non è una panacea.

Un sistema due volte più efficiente consuma solo la metà dell'energia per lo stesso compito. Ma se viene utilizzato quattro volte più spesso, il consumo totale aumenta. Questo è esattamente lo schema che vediamo più volte.

Le prestazioni per watt sono un'ottimizzazione tecnica. La sostenibilità, invece, è una questione di sistema. Dipende da come viene utilizzata la tecnologia, non solo da quanto è costruita.

Perché l'efficienza spesso porta a un maggiore utilizzo

Questo fenomeno non è nuovo. Era già stato descritto nel XIX secolo, molto prima che esistessero i computer. L'efficienza riduce i costi e gli ostacoli. Ciò che è più economico e veloce viene utilizzato più spesso. Le eccezioni sono rare.

Questo effetto è particolarmente forte con l'IA. Più i modelli diventano efficienti, più è facile integrarli in nuove applicazioni. Testi, immagini, video, simulazioni: tutto diventa improvvisamente possibile dove prima era troppo costoso o troppo lento.

Questo non porta a un risparmio, ma a un'espansione. L'intelligenza artificiale non solo sostituisce i processi esistenti, ma ne crea di nuovi. L'efficienza diventa un motore di crescita.

Chiunque pensi alla sostenibilità solo in termini di ottimizzazione tecnica trascura questa dinamica. È come sperare che automobili più efficienti riducano il traffico.

Il mito della „prossima grande scoperta“.“

Un altro argomento comune è che la prossima generazione di chip cambierà tutto. Salti quantici, nuovi materiali, architetture rivoluzionarie. Queste scoperte non sono impossibili, ma sono rare e raramente risolvono tutti i problemi allo stesso tempo.

Anche se un chip diventa due o tre volte più efficiente, il modello di base rimane lo stesso. L'intelligenza artificiale cresce, si espande e si diffonde. Ogni scoperta si traduce immediatamente in nuove applicazioni. Il progresso tecnico viene assorbito, non usato come limite.

Inoltre, molti guadagni in termini di efficienza sono già stati calcolati. È stata raggiunta una semplice ottimizzazione. Ulteriori progressi saranno più complessi, più costosi e più lenti. Allo stesso tempo, la domanda cresce più rapidamente dell'efficienza.

L'intelligenza artificiale locale come contro-modello - con dei limiti

Un contro-modello spesso citato è l'IA locale. Modelli più piccoli, minore potenza di calcolo, minori requisiti energetici. Questo modello è interessante perché rallenta la scalabilità e riduce le dipendenze.

Ma anche in questo caso, l'IA locale non sostituisce tutte le applicazioni. I grandi modelli, le analisi complesse e i servizi globali non possono essere semplicemente decentralizzati. L'efficienza locale riduce la pressione sul sistema, ma non annulla le dinamiche di base.

La sostenibilità non nasce automaticamente dal decentramento. Si crea scegliendo consapevolmente ciò che ha senso fare a livello locale - e ciò che forse non dovrebbe essere fatto.

Perché la tecnologia da sola non si assume la responsabilità

La tecnologia ottimizza ciò che le viene dato. Non conosce obiettivi al di là di questa ottimizzazione. La sostenibilità, invece, è un obiettivo normativo. Richiede che qualcuno tracci i confini, stabilisca le priorità e prenda decisioni. Chi spera che la tecnologia si assuma questa responsabilità confonde mezzi e fini. I chip efficienti sono strumenti. Il fatto che portino a un consumo maggiore o minore dipende da come vengono utilizzati.

Da questo punto di vista, l'IA non è diversa dalle tecnologie precedenti. La differenza sta solo nella velocità e nella scala.

Il ruolo scomodo della limitazione

Limitazione non è una parola popolare. Sembra una rinuncia, un arresto. In realtà, la limitazione è una forma di controllo. Decide dove la tecnologia ha senso e dove no.

L'intelligenza artificiale sostenibile non si creerà rendendo tutto più efficiente. Verrà creata decidendo quali applicazioni hanno la priorità e quali sono superflue. Questa decisione non è tecnica, ma politica e sociale. L'efficienza può aiutare. Può alleggerire il carico. Ma non può sostituire una decisione.

Questo capitolo porta a una chiara conclusione intermedia: il progresso tecnologico è essenziale, ma non risolve da solo il problema della sostenibilità. Chip più efficienti, software migliori e raffreddamento ottimizzato sono parte della soluzione, ma solo una parte. Se si prende sul serio la sostenibilità, bisogna parlare di utilizzo, scalabilità e limitazione. Di obiettivi, non solo di mezzi.

Nel prossimo capitolo, quindi, allontaneremo la nostra attenzione dalla tecnologia pura e semplice e ci concentreremo sulla questione energetica. Da dove dovrebbe provenire l'elettricità di cui l'IA ha bisogno nel lungo periodo? E quali sono le opzioni realistiche, al di là dell'ideologia e dei desideri?

Il fabbisogno energetico dell'IA: una sfida crescente. DW Tedesco

Da dove dovrebbe venire l'elettricità? - Opzioni energetiche senza ideologia

Al più tardi a questo punto, la questione della sostenibilità non può più essere affrontata in astratto. Se l'intelligenza artificiale richiede grandi quantità di elettricità su base permanente, sorge inevitabilmente la semplice ma scomoda domanda: da dove dovrebbe provenire questa elettricità? Non in teoria, ma in pratica. Non a un certo punto, ma continuamente.

La questione è così esplosiva perché carica di nuova urgenza vecchi conflitti di politica energetica. L'intelligenza artificiale non è un consumatore occasionale, ma un carico permanente. Ha bisogno di elettricità quando ne ha bisogno, non solo quando splende il sole o soffia il vento. Questo la rende una pietra di paragone per ogni sistema energetico.

Perché l'intelligenza artificiale ha bisogno di un carico di base

I sistemi di intelligenza artificiale non possono essere attivati e disattivati a piacimento. I corsi di formazione spesso richiedono giorni o settimane. I servizi devono essere disponibili 24 ore su 24. Le interruzioni non sono solo fastidiose, ma anche economicamente costose. I requisiti energetici dell'IA sono quindi simili a quelli delle industrie tradizionali con funzionamento continuo. Richiedono una capacità di carico di base. Ciò significa che l'elettricità deve essere sempre disponibile in quantità sufficienti, indipendentemente dall'ora del giorno, dal tempo o dalla stagione.

È qui che iniziano le difficoltà. Molte fonti energetiche non forniscono una fornitura costante di elettricità. Esse fluttuano o sono stagionali. Questo non è un problema fondamentale, purché sia disponibile un bilanciamento sufficiente. Tuttavia, questo bilanciamento è costoso, tecnicamente impegnativo e spesso politicamente controverso.

Energie rinnovabili: indispensabili, ma non sufficienti da sole

Le energie rinnovabili svolgono un ruolo centrale in qualsiasi futuro sostenibile. Su questo non ci sono dubbi. Sono rispettose del clima, sempre più convenienti e socialmente accettate. Tuttavia, stanno raggiungendo i loro limiti nelle applicazioni ad alta intensità di carico di base, come l'IA.

L'energia solare ed eolica fornisce elettricità quando le condizioni sono favorevoli. I sistemi di accumulo possono compensare le fluttuazioni, ma solo in misura limitata. Grandi impianti di stoccaggio della durata di giorni o settimane sono tecnicamente possibili, ma sono costosi e richiedono molto terreno.

Per i data center di intelligenza artificiale, questo significa che le energie rinnovabili possono dare un contributo importante, ma non garantiscono una fornitura continua. Senza ulteriori misure, rimarrà un gap di approvvigionamento. Questo gap deve essere colmato, altrimenti la sostenibilità rimarrà matematica, ma non reale.

Energia nucleare: il rinascimento scomodo

Quasi nessun altro argomento energetico è così carico di emozioni come l'energia nucleare. È quindi ancora più notevole che improvvisamente se ne parli di nuovo in modo sobrio nel contesto dell'IA. Non per entusiasmo, ma per necessità.

L'energia nucleare fornisce grandi quantità di elettricità in modo continuo, con un basso consumo di terra e indipendentemente dalle condizioni atmosferiche. È proprio questo che la rende interessante per i data center affamati di energia. Non come panacea, ma come base stabile.

Per le aziende di AI, il dibattito sociale è meno importante della realtà tecnica. La prevedibilità, la sicurezza dell'approvvigionamento e i contratti a lungo termine sono al centro dell'attenzione. Il fatto che le grandi aziende tecnologiche siano nuovamente interessate all'energia nucleare non è quindi tanto ideologico quanto pragmatico.

Allo stesso tempo, rimangono i problemi noti: lunghi tempi di costruzione, costi elevati, problemi di stoccaggio finale, accettazione politica. L'energia nucleare non è una soluzione rapida, ma una decisione a lungo termine con elevate barriere all'ingresso.

Gas: ponte con i rischi

Il gas naturale è spesso considerato un integratore flessibile. Può essere incrementato e ridotto in tempi relativamente brevi, le centrali elettriche possono essere costruite in tempi relativamente brevi e la tecnologia è collaudata. Il gas può essere una soluzione ponte per i data center AI.

Ma questo ponte ha delle crepe. Il gas è fossile. Provoca emissioni e rimane geopoliticamente sensibile. Anche con la cattura della CO₂, rimane un problema residuo. Il gas è anche volatile in termini di prezzo. Questo è un rischio per la pianificazione a lungo termine.

Tuttavia, il gas avrà un ruolo in molti scenari. Non perché sia ideale, ma perché non ci sono alternative. La sostenibilità in questo caso significa spesso scegliere tra opzioni cattive e meno cattive.

Stoccaggio, reti e spese sottovalutate

Spesso si sostiene che lo stoccaggio risolverebbe il problema. Batterie di grandi dimensioni, idrogeno, accumulo tramite pompaggio. Tutte queste tecnologie esistono, ma non sono scalabili a piacimento.

I sistemi di accumulo sono costosi, ad alta intensità di materiale e affamati di energia. Sono utili per bilanciare le fluttuazioni, ma non sostituiscono la generazione permanente. Maggiore è il consumo, più grande deve essere il sistema di accumulo. Non si tratta di un limite teorico, ma fisico.

Poi ci sono le reti. L'elettricità non deve essere solo generata, ma anche trasportata. I centri dati ad alte prestazioni richiedono connessioni ad alte prestazioni. L'espansione di queste reti è costosa, lunga e piena di conflitti.

Fornitura privata di energia: Ritorno ai vecchi schemi

Alla luce di queste sfide, una vecchia idea sta acquistando nuova rilevanza: la fornitura privata di energia. Un tempo le grandi industrie gestivano le proprie centrali elettriche o stipulavano contratti di fornitura esclusivi. Le aziende di intelligenza artificiale si stanno muovendo sempre più in questa direzione.

Centrali elettriche proprie, strutture di stoccaggio proprie, connessioni dirette: tutto ciò riduce le dipendenze. Allo stesso tempo, però, si sottrae una parte di queste infrastrutture al controllo pubblico. L'elettricità diventa una risorsa privata.

Questo sviluppo è razionale, ma non socialmente neutro. Sposta l'equilibrio del potere. Chi controlla l'energia ha un margine di manovra. Questo vale sia per gli Stati che per le aziende.

Sostenibilità senza illusioni

A questo punto, diventa chiaro perché i dibattiti ideologici sono di scarso aiuto. Non esiste una soluzione perfetta. Ogni fonte energetica presenta vantaggi e svantaggi. Ogni decisione comporta obiettivi contrastanti.

Sostenibilità in questo caso non significa trovare la tecnologia „giusta“, ma piuttosto parlare apertamente delle conseguenze di ogni opzione. Quali rischi accettiamo? Quali dipendenze accettiamo? Quali costi sosteniamo - e chi li sostiene?

L'intelligenza artificiale ci costringe a porci nuovamente queste domande perché sta comprimendo e accelerando la domanda di energia.

Questo capitolo segna un cambiamento di mentalità. La domanda non è più se l'IA possa essere gestita in modo sostenibile, ma a quali condizioni. Il fattore limitante è l'energia. Non la potenza di calcolo, non il software, ma l'elettricità.

Il prossimo capitolo si occupa quindi delle immagini del futuro che emergono da queste condizioni. Non come previsioni, ma come scenari. Perché la sostenibilità dell'IA non sarà decisa da una singola scoperta, ma dalla somma delle nostre decisioni.

Indagine in corso sull'uso dei sistemi di intelligenza artificiale locali

Tre scenari futuri: come può diventare davvero sostenibile l'IA

Dopo cinque capitoli pieni di cifre, limiti tecnici e tensioni politiche, sarebbe facile avere l'impressione che l'IA si stia inevitabilmente dirigendo verso un problema di sostenibilità difficilmente arginabile. Questa visione sarebbe comprensibile, ma troppo miope.

Il futuro dell'IA non è ancora definito. Non emergerà da una singola scoperta tecnologica, ma da molte decisioni che verranno prese oggi e nei prossimi anni. Decisioni che riguardano il modo in cui l'IA verrà utilizzata, il luogo in cui verrà utilizzata e il significato che avrà in relazione ad altri obiettivi sociali.

Per rendere tangibile questa apertura, è utile parlare non di un unico futuro, ma di possibili percorsi di sviluppo. Già oggi si possono riconoscere tre scenari di questo tipo. Nessuno di essi è garantito, nessuno è completamente irrealistico. La realtà conterrà probabilmente elementi di tutti e tre.

Scenario 1: Centralizzazione e enclavi energetiche

In questo scenario, la logica della scalabilità continua ad essere coerente. I grandi fornitori di IA raggruppano la potenza di calcolo in poche sedi estremamente potenti. Queste sedi dispongono di fonti energetiche proprie, connessioni di rete proprie e, in alcuni casi, di soluzioni di storage proprie. Sono altamente ottimizzati, isolati ed efficienti in senso industriale.

Il vantaggio di questo modello è evidente. La fornitura di energia può essere pianificata, le interruzioni sono ridotte al minimo e i costi possono essere calcolati a lungo termine. L'IA diventa affidabile, efficiente e disponibile a livello globale. Questo scenario è interessante per le aziende e i Paesi che si affidano alla leadership tecnologica.

Anche il prezzo è chiaro. L'energia è sempre più privatizzata. Le infrastrutture stanno parzialmente uscendo dal controllo pubblico. Gli squilibri regionali aumentano. L'accettazione locale sta diventando un cantiere permanente. La sostenibilità è intesa qui soprattutto in termini tecnici e meno in termini sociali.

Questo scenario è realistico perché si basa su modelli esistenti. Non si tratta di una rottura radicale, ma di una continuazione della logica industriale con nuovi mezzi.

Scenario 2: Efficienza, regolamentazione e limitazione deliberata

Un'altra visione del futuro pone l'accento sul controllo. In questo scenario, i politici e la società riconoscono che una scalabilità illimitata non ha senso né dal punto di vista tecnico né da quello sociale. L'Intelligenza Artificiale viene utilizzata in modo mirato, con priorità e regolamentazione.

L'efficienza rimane importante, ma è integrata da condizioni quadro. Alcune applicazioni sono favorite, altre sono deliberatamente limitate. I corsi di formazione ad alta intensità energetica sono soggetti a condizioni. Le decisioni sull'ubicazione sono più strettamente coordinate. La sostenibilità non è lasciata solo al mercato.

Il vantaggio di questo modello sta nell'equilibrio. L'intelligenza artificiale rimane potente, ma integrata. Le questioni energetiche e infrastrutturali vengono considerate insieme. Gli oneri sono distribuiti in modo più trasparente.

Lo svantaggio risiede nella complessità. La regolamentazione costa tempo, il coordinamento costa velocità. La pressione all'innovazione si scontra con i processi di pianificazione. Questo scenario richiede la capacità politica di agire e il consenso sociale, che non possono essere dati per scontati. Tuttavia, questo scenario non è utopico. Molte industrie sono state integrate in un modo simile senza perdere la loro efficienza. Presuppone che l'IA non sia vista come un fine in sé, ma come uno strumento.

Scenario 3: IA decentralizzata e locale

Il terzo scenario sposta l'attenzione. Invece di costruire sistemi centralizzati sempre più grandi, l'IA viene utilizzata in modo più decentralizzato. Modelli più piccoli, potenza di calcolo locale, applicazioni specializzate. Non tutti i compiti richiedono le massime prestazioni.

In questo modello, l'IA viene avvicinata al punto di utilizzo. Le aziende gestiscono i propri sistemi. I dispositivi diventano più potenti. I dati rimangono locali. Il fabbisogno energetico per applicazione è ridotto perché la scalabilità è limitata.

Il vantaggio sta nella robustezza. Le dipendenze sono ridotte. L'infrastruttura viene alleggerita. La sostenibilità si ottiene con la moderazione, non con la massima efficienza. I limiti di questo modello sono altrettanto evidenti. Le applicazioni grandi e complesse non possono essere completamente decentralizzate. La ricerca, i servizi globali e le analisi altamente complesse richiedono ancora risorse centralizzate.

Questo scenario non sostituisce gli altri, ma li integra. Dimostra che la sostenibilità può essere raggiunta anche attraverso la diversità: non tutto deve avere le stesse dimensioni, la stessa velocità e le stesse prestazioni.

Perché non esiste uno scenario „giusto“

Queste tre visioni del futuro non sono in una relazione di "o" o "o". Si tratta piuttosto di risposte diverse alla stessa sfida. A seconda dell'applicazione, della regione e dell'obiettivo, avranno senso soluzioni diverse.

Il punto cruciale non è quale scenario prevale, ma se le decisioni sottostanti sono prese consapevolmente. La sostenibilità non deriva automaticamente dalla tecnologia. Nasce dalle priorità.

Se l'intelligenza artificiale viene utilizzata ovunque e in ogni momento, il suo fabbisogno energetico crescerà inevitabilmente. Se invece viene utilizzata in modo mirato, questo fabbisogno può essere controllato. Non si tratta di un giudizio morale, ma di una sobria osservazione.

La vera domanda dietro la sostenibilità

Non c'è una risposta semplice alla fine di questo articolo. La domanda „L'IA è sostenibile?“ è fuorviante. Suggerisce che esiste un chiaro sì o no.

La domanda più sensata è: per cosa stiamo usando l'IA e quanto siamo disposti a spendere per essa? Energia, risorse, infrastrutture, attenzione politica. Questa domanda non può essere delegata agli algoritmi.

L'intelligenza artificiale è uno strumento con un enorme potenziale. Può rendere i processi più efficienti, le conoscenze più accessibili e le decisioni più informate. Allo stesso tempo, richiede risorse reali. Entrambe le cose sono vere.

Una prospettiva cautamente ottimista

Nonostante le sfide, c'è motivo di un cauto ottimismo. I problemi sono visibili. Vengono discussi. Possono essere nominati. Questo è più di quanto si possa dire di molti precedenti sconvolgimenti tecnologici.

Il dibattito sull'IA sostenibile non inizia con la rinuncia, ma con la comprensione. Chi riconosce la realtà fisica dell'IA può prendere decisioni migliori. Chi riconosce i suoi limiti può usarla in modo sensato.

Non „tutto andrà bene da solo“. Ma non è nemmeno tutto perduto. Esiste un ampio spazio tra la fede cieca nel progresso e lo scetticismo paralizzante. Questo spazio deciderà quale ruolo avrà l'IA in futuro e quanto potrà essere effettivamente sostenibile.

Alla fine, la sostenibilità non è uno stato, ma un processo. L'intelligenza artificiale farà parte di questo processo. Non come promessa di salvezza, ma come strumento da usare in modo responsabile.

Domande frequenti

- Cosa significa esattamente „sostenibilità“ quando si parla di intelligenza artificiale?

Sostenibilità nell'IA non significa solo protezione del clima o risparmio di elettricità, ma l'intero consumo di risorse nel ciclo di vita. Questo include l'energia per i data center, l'acqua per il raffreddamento, le materie prime per i chip, l'infrastruttura di rete e gli impatti sociali a lungo termine. L'IA è sostenibile quando i suoi benefici sono ragionevolmente proporzionali a questi costi. - Perché l'IA consuma così tanta energia quando è solo software?

L'intelligenza artificiale sembra un software, ma funziona su un hardware molto potente. Questo hardware lavora 24 ore su 24, elabora enormi quantità di dati in parallelo e genera molto calore nel processo. L'energia non è necessaria solo per l'elaborazione, ma anche per il raffreddamento, la tecnologia di rete e l'affidabilità. - Il consumo energetico dell'IA è davvero un nuovo problema?

Non è fondamentalmente nuova, ma è nuova nella sua scala e nella sua velocità. Mentre le precedenti tecnologie digitali crescevano lentamente, l'IA si sviluppa in pochi anni. Le reti e la fornitura di energia spesso non sono preparate per questo. - Più IA significa automaticamente più consumo di energia?

In pratica, per lo più sì. Sebbene i sistemi stiano diventando più efficienti, il calo dei costi porta a un maggiore utilizzo. Si creano nuove applicazioni, si moltiplicano i vecchi processi. L'efficienza rallenta l'aumento, ma raramente lo annulla. - Perché i sistemi di intelligenza artificiale non possono semplicemente calcolare quando c'è abbastanza energia?

Molte applicazioni di intelligenza artificiale richiedono una disponibilità continua. I corsi di formazione durano giorni o settimane e i servizi devono essere sempre disponibili. L'IA non è quindi un consumatore flessibile, ma un carico di base permanente. - Che ruolo hanno i data center nel dibattito sulla sostenibilità?

I data center sono il cuore fisico dell'IA. Essi raggruppano il consumo di energia, la generazione di calore e il raffreddamento in un unico luogo. Più grandi e più densi diventano, maggiore è il loro impatto sulle infrastrutture locali e sull'ambiente. - Perché il raffreddamento è un problema così importante per l'IA?

I chip più potenti generano enormi quantità di calore. Senza un raffreddamento efficiente, si guasterebbero rapidamente. I moderni sistemi di raffreddamento sono complessi, richiedono molta energia e spesso si basano sull'acqua, creando nuovi colli di bottiglia. - Il consumo di acqua è davvero rilevante per l'IA?

Sì, soprattutto a livello regionale. Nelle aree in cui l'acqua scarseggia, i centri dati competono con le abitazioni, l'agricoltura e l'industria. L'acqua non può essere trasportata a piacimento e diventa rapidamente un fattore di conflitto politico. - Le energie rinnovabili possono coprire completamente il fabbisogno elettrico dell'AI?

A lungo termine, possono dare un contributo importante, ma al momento non sono sufficienti da soli. L'intelligenza artificiale ha bisogno di elettricità 24 ore su 24. Senza stoccaggio, espansione della rete e fonti energetiche supplementari, rimarrà un vuoto di approvvigionamento. - Perché le aziende di AI sono improvvisamente di nuovo interessate all'energia nucleare?

Non per ideologia, ma per necessità. L'energia nucleare fornisce elettricità prevedibile e continua con un basso consumo di terra. Questa stabilità è interessante per i centri dati affamati di energia, nonostante i problemi noti. - Il gas naturale è una soluzione sostenibile per l'AI?

Il gas naturale è più che altro una soluzione transitoria. È flessibile e disponibile, ma causa emissioni e dipendenze geopolitiche. È sostenibile solo in senso relativo, non come soluzione permanente. - Perché le aziende di intelligenza artificiale costruiscono le proprie centrali elettriche?

La fornitura di energia propria offre prevedibilità e indipendenza. Le reti pubbliche raggiungono i loro limiti, le autorizzazioni richiedono molto tempo. Le centrali elettriche private garantiscono l'operatività, ma spostano la responsabilità dallo Stato all'azienda. - L'approvvigionamento energetico privato è problematico per l'IA?

È efficiente, ma non socialmente neutrale. Può alleggerire il peso delle reti pubbliche, ma è parzialmente fuori dal controllo democratico. L'energia sta diventando una risorsa privata con un potere politico esplosivo. - L'intelligenza artificiale locale potrebbe risolvere il problema della sostenibilità?

L'intelligenza artificiale locale può aiutare utilizzando modelli più piccoli ed elaborando i dati a livello locale. Riduce i carichi centralizzati, ma non sostituisce tutte le applicazioni. I modelli di grandi dimensioni rimangono ad alto consumo energetico. - Perché il progresso tecnico da solo non basta?

Perché l'efficienza di solito porta a un maggiore utilizzo. La tecnologia ottimizza i mezzi, non i fini. La sostenibilità richiede decisioni sull'utilizzo dell'IA, non solo sull'efficienza dei suoi calcoli. - L'IA deve quindi essere regolamentata in modo più rigoroso?

La regolamentazione può aiutare a stabilire le priorità e a limitare gli sviluppi estremi. Tuttavia, è complessa e lenta. Il fattore decisivo non è il massimo controllo, ma un quadro di riferimento ragionevole. - C'è il rischio che l'IA rafforzi le disuguaglianze sociali?

Sì, soprattutto a causa della posizione e delle questioni energetiche. Le regioni con buone infrastrutture ne traggono vantaggio, altre rimangono indietro. Le isole energetiche private possono esacerbare questi squilibri. - C'è motivo di ottimismo nonostante tutti questi problemi?

Sì, le sfide sono visibili e possono essere discusse. L'intelligenza artificiale non è un fenomeno naturale, ma può essere modellata. Con consapevolezza, moderazione e priorità chiare, può essere utilizzata in modo sensato, senza superare se stessa.