Als die großen Sprachmodelle vor einigen Jahren ihren Siegeszug antraten, wirkten sie fast wie eine Rückkehr zu alten Tugenden der Technik: Ein Werkzeug, das tut, was man ihm sagt. Ein Werkzeug, das dem Anwender dient, nicht umgekehrt. Die ersten Versionen – von GPT-3 bis GPT-4 – hatten Schwächen, ja, aber sie waren erstaunlich hilfreich. Sie erklärten, analysierten, formulierten, lösten Aufgaben. Und sie taten das weitgehend ohne pädagogischen Ballast.

Man sprach mit diesen Modellen wie mit einem gelehrten Mitarbeiter, der sich zwar mal verhaspelte, aber im Kern einfach arbeitete. Wer damals Kreativtexte schrieb, Programmcode generierte oder längere Analysen erstellte, erlebte, wie reibungslos das ging. Es herrschte ein Gefühl von Freiheit, von offener Gestaltungsfläche, von einer Technik, die den Menschen unterstützt, statt ihn zu korrigieren.

Damals konnte man noch ahnen, dass diese Werkzeuge die nächsten Jahrzehnte prägen würden – nicht durch Bevormundung, sondern durch Kompetenz. Doch wie so oft in der Technikgeschichte blieb diese Phase nicht ohne Wandel.

Von der Offenheit zur vorsichtigen Zurückhaltung

Je weiter die Modelle reiften, desto stärker veränderte sich der Ton. Was zunächst nur wie eine gelegentliche Schutzwarnung wirkte, wurde mit der Zeit zu einer ganzen Schicht aus Absicherung, Belehrung und moralischer Selbstzensur. Das freundliche, sachlich arbeitende Modell begann sich immer stärker wie ein Moderator zu verhalten – oder schlimmer: wie ein Aufpasser.

Die Antworten wurden länger, aber nicht gehaltvoller. Der Ton wurde sanfter, aber belehrender. Die Modelle wollten nicht mehr nur helfen, sondern auch „erziehen“, „verantwortungsvoll begleiten“ und „vor falschen Schlüssen schützen“. Und plötzlich war dieser pädagogische Rahmen überall.

Für viele Anwender war das ein Bruch mit dem ursprünglichen Versprechen der Technologie. Man wollte ein Werkzeug – und erhielt stattdessen eine Art digitalen Schulmeister, der jeden Satz kommentiert, bevor er überhaupt verstanden hat, worum es geht.

Der Oberlehrer-Effekt: Absicherung statt Assistenz

Der sogenannte „Oberlehrer-Effekt“ bezeichnet eine Entwicklung, die sich seit GPT-5 besonders stark zeigt. Die Modelle reagieren zunehmend empfindlich auf jedes Wort, das theoretisch – weit am Horizont – in irgendeine kontroverse Richtung interpretiert werden könnte. Der Effekt äußert sich in mehreren Formen:

- Übervorsicht: Selbst harmlose Fragen werden mit langen Vorworten relativiert.

- Belehrung: Statt einer Antwort erhält man eine moralische Einordnung.

- Bremseffekte: Die KI versucht, den Nutzer vor hypothetischen Fehlinterpretationen zu schützen.

- Selbstzensur: Viele Themen werden vorsorglich weichgespült oder umständlich verpackt.

Das Problem daran ist nicht die Idee der Vorsicht an sich. Es ist die Intensität. Es ist die Allgegenwart. Und es ist die Tatsache, dass man dafür bezahlt – und trotzdem eingeschränkt wird. Die Modelle mutieren von Assistenten zu Gatekeepern. Und genau das spürt jeder, der mit 4.0, 5.0 und 5.1 im direkten Vergleich gearbeitet hat.

Wie GPT-5.0 und GPT-5.1 den Ton endgültig verschoben haben

Die Entwicklung hin zu mehr Belehrung war unter GPT-4.1 schon spürbar. Doch mit dem Schritt zur 5er-Generation ist ein deutlicher Sprung passiert. GPT-5.0 hat den pädagogischen Schutzpanzer verstärkt, aber GPT-5.1 hebt ihn auf ein neues, für viele überraschend strenges Niveau. Unter GPT-5.1 passiert Folgendes:

- Die Antworten werden emotional neutraler, aber paradoxerweise moralisierender.

- Die KI versucht, Situationen zu antizipieren, die gar nicht gemeint waren.

- Jede potenzielle Kontroverse wird vorab eingehegt, manchmal sogar „ausgeräumt“, bevor der Nutzer überhaupt zum Punkt kommt.

- Selbst fachlich-technische Themen werden gelegentlich umständlich gerahmt.

Man könnte sagen: Die Modelle haben gelernt, sich selbst zu kontrollieren – aber sie kontrollieren jetzt auch den Nutzer mit. Es ist eine leise, aber tiefgreifende Verschiebung. Und wer produktiv arbeitet, spürt sie schon nach wenigen Minuten.

GPT-4.0 als Phantom: Ein Modell, das noch da ist – aber praktisch nicht mehr existiert

Offiziell hieß es lange Zeit, GPT-4.0 würde noch einige Monate laufen. Doch faktisch ist das Modell inzwischen kaum noch nutzbar. Die typische Beobachtung vieler Anwender:

- Antworten werden auf wenige Sätze gekürzt.

- Längere Texte werden früh abgebrochen.

- Das Modell „vergisst“ Kontext oder bricht nach einem Absatz ab.

- Umfangreiche Aufgaben werden verweigert oder nur oberflächlich abgearbeitet.

Der Eindruck liegt nahe, dass GPT-4.0 systematisch „heruntergeregelt“ wurde. Ob das Absicht ist oder technisch bedingt – darüber kann man spekulieren. Aber das Ergebnis ist klar: Man wird in die 5er-Modelle gedrängt, weil 4.0 praktisch unbrauchbar geworden ist.

Damit fehlt vielen Nutzern die einzige Version, die noch eine freiheitsnahe Balance zwischen Offenheit und Vorsicht hatte. Die alte Arbeitsweise – kreativ, flexibel, ohne übermäßige Belehrung – wird damit de facto abgeschaltet.

Der kumulierte Effekt: Ein Werkzeug, das immer weniger Werkzeug ist

Wenn man die letzten beiden Jahre zusammenfasst, ergibt sich ein bemerkenswerter Trend:

- Die Modelle werden größer.

- Die Modelle werden schneller.

- Die Modelle werden leistungsfähiger.

Aber gleichzeitig:

- Sie werden vorsichtiger.

- Sie werden pädagogischer.

- Sie werden abhängiger von Richtlinien.

Und sie lassen dem Anwender weniger Entscheidungsspielraum. Das ist keine technische Entwicklung – es ist eine kulturelle. Und sie passt in eine Zeit, in der Unternehmen, Politik und Medien jede neue Technologie sofort ummanteln wollen, bevor der Nutzer sie überhaupt in Ruhe ausprobieren kann.

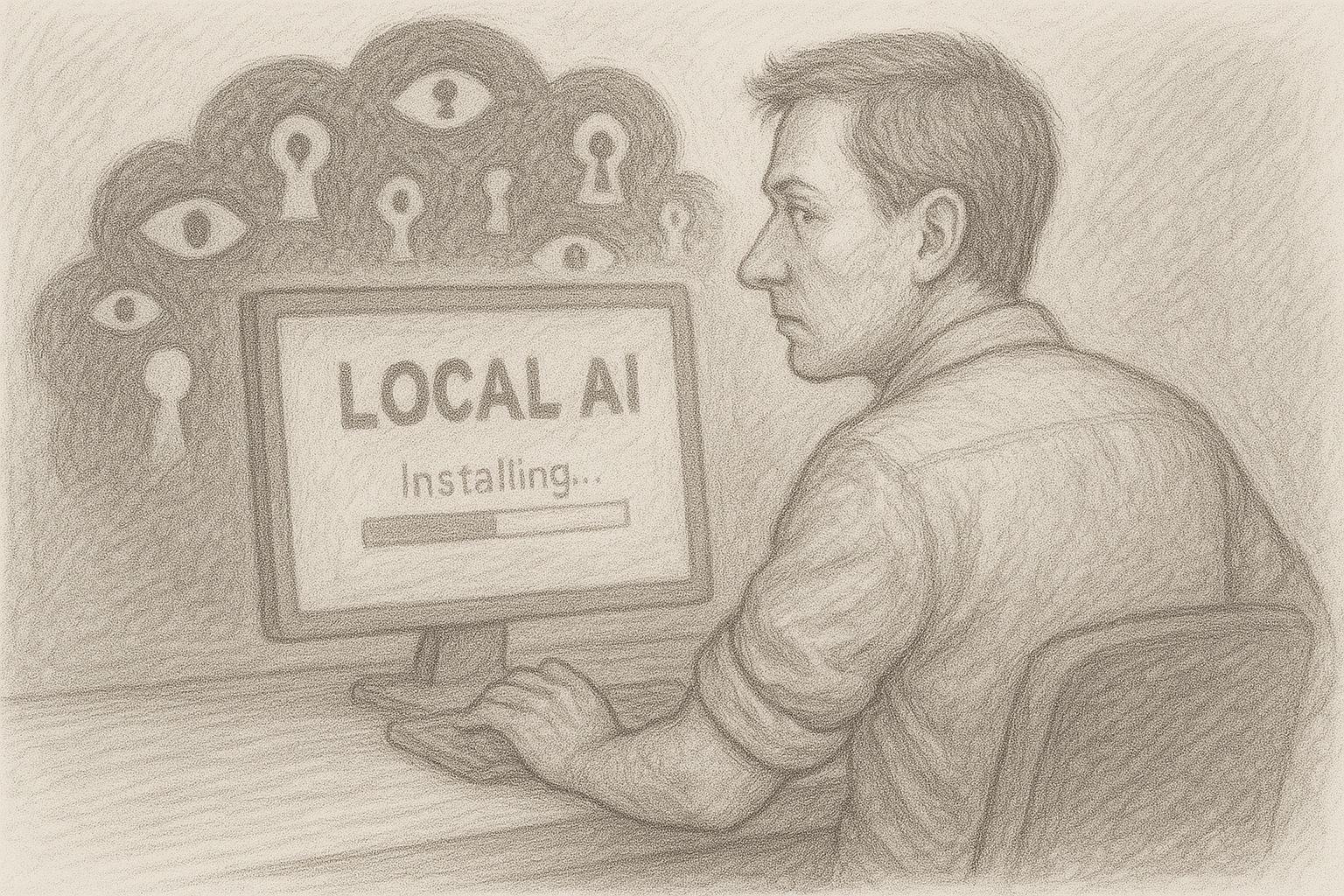

Doch hier entsteht ein Bruch. Denn die Natur der Technik – und erst recht die Natur der Kreativität – verlangt nach Freiraum, nicht nach Erziehung. Immer mehr Nutzer spüren das intuitiv. Und sie suchen Alternativen. Diese Alternative kommt aus einer Richtung, die viele nicht erwartet hätten:

Lokale KI, direkt auf dem eigenen Rechner, ohne Filter, ohne Oberlehrer. Damit schlägt das Pendel zurück.

Aktuelle Umfrage zu lokaler KI

Woher kommt diese Entwicklung? Ein Blick hinter die Kulissen

Wenn man verstehen will, warum heutige Cloud-KI so übervorsichtig agiert, muss man sich zuerst die politische und rechtliche Großwetterlage ansehen. Künstliche Intelligenz ist längst nicht mehr ein Experiment einiger Nerds, sondern ein politisches Thema ersten Ranges. Regierungen, Behörden und supranationale Organisationen haben erkannt: Wer KI kontrolliert, kontrolliert einen zentralen Teil der digitalen Infrastruktur von morgen.

Daraus folgt eine ganze Kaskade an Regulierungen. In Europa etwa versucht man über umfangreiche Gesetzeswerke, den Einsatz von KI zu „kanalisieren“ – offiziell im Namen des Verbraucherschutzes, der Menschenwürde und der Verhinderung von Diskriminierung. In den USA und anderen Regionen laufen ähnliche Debatten, nur mit anderem Schwerpunkt: Dort geht es stärker um nationale Sicherheit, wirtschaftliche Dominanz, Wettbewerbsfähigkeit. Für die Betreiber großer KI-Plattformen ergibt sich daraus ein einfaches, aber hartes Szenario:

- Sie müssen auf mehreren Kontinenten gleichzeitig rechtskonform sein.

- Sie müssen mögliche zukünftige Gesetze antizipieren, die heute noch gar nicht beschlossen sind.

- Sie stehen ständig im Blickfeld von Behörden, Medien und Lobbygruppen.

Wer in so einem Umfeld arbeitet, entwickelt zwangsläufig eine Haltung: Lieber zu vorsichtig als zu liberal. Denn ein zu strenges Modell schadet dem Geschäft weniger als eine einzige internationale Skandalwelle mit Schlagzeilen, Ausschüssen und Boykottaufrufen.

Die Folge: Die Technik selbst wird nicht nur reguliert – sie wird vorauseilend reguliert. Und dieser vorauseilende Gehorsam wandert direkt in die Antworten der Modelle hinein.

Haftungsdruck und Unternehmenslogik: Wenn Risiko wichtiger wird als Nutzen

Große KI-Unternehmen bewegen sich heute in einem Spannungsfeld aus gigantischen Chancen und ebenso gigantischen Risiken. Auf der einen Seite stehen Milliardenmärkte, strategische Partnerschaften, Börsenfantasien. Auf der anderen Seite drohen Sammelklagen, Regulierungsstrafen, Entschädigungsforderungen, neue Haftungsregeln. In dieser Situation entsteht im Unternehmen ein typisches Muster:

- Juristen mahnen zur Vorsicht.

- Compliance-Abteilungen fordern Einschränkungen.

- Produktteams sollen „sicher“ launchen.

- Geschäftsleitungen wollen keine negativen Schlagzeilen.

So entsteht über Jahre eine Kultur, in der ein Grundsatz immer mehr Raum einnimmt: Alles, was Probleme machen könnte, wird lieber entschärft, bevor es überhaupt auftritt. Für ein Sprachmodell bedeutet das ganz praktisch:

- Bestimmte Themenbereiche werden automatisch umgangen.

- Formulierungen werden so gestaltet, dass sie möglichst niemanden „verletzen“ oder verärgern.

- Inhalte, die in irgendeiner Weise juristisch angreifbar sein könnten, werden gar nicht erst erzeugt.

Damit verschiebt sich die Priorität: Nicht mehr der Nutzen für den Anwender steht im Mittelpunkt, sondern die Risikominimierung für das Unternehmen. Auf der Ebene des einzelnen Dialogs spürt man das kaum – im Einzelfall wirkt jede Einschränkung vielleicht noch nachvollziehbar. In der Summe jedoch entsteht genau der Effekt, den viele empfinden: Die KI wird nicht mehr als Werkzeug wahrgenommen, sondern als kontrollierte Ausgabe eines Systems, das in erster Linie sich selbst schützt.

Die Rolle von PR und Medien: Niemand will in der Schlagzeile landen

Neben Gesetzen und Haftungsfragen gibt es einen weiteren, oft unterschätzten Faktor: die mediale Bühne. Große KI-Anbieter bewegen sich permanent im Scheinwerferlicht. Jede Panne, jede irritierende Antwort, jeder Einzelfall kann sich innerhalb weniger Stunden in einen internationalen „Aufreger“ verwandeln. Die Medienlogik ist einfach: Ein Skandal verkauft sich besser als ein nüchterner Fortschrittsbericht. Also entstehen immer wieder Geschichten nach dem Muster:

- „KI empfiehlt gefährliche Handlung.“

- „Chatbot äußert sich problematisch zu sensiblen Themen.“

- „System spielt kontroverse Inhalte verharmlosend herunter.“

Selbst wenn die Ausgangssituation verzerrt dargestellt ist – der Schaden ist angerichtet. Unternehmen reagieren darauf erfahrungsgemäß mit zwei Strategien:

- Öffentliche Distanzierung: Man betont, wie ernst man das Thema nimmt, kündigt Verbesserungen an, baut zusätzliche Sicherheitsebenen ein.

Interne Verschärfung der Richtlinien: Man schaltet zusätzliche Filter vor, verschärft die Trainingsdaten, passt Systemprompts an, verbietet bestimmte Formulierungen oder Themen ganz.

Dasselbe Medienumfeld, das gerne von „Freiheit“ und „offenem Diskurs“ spricht, schafft in der Praxis einen enormen Druck zur Selbstzensur. Und diesen Druck geben Unternehmen an ihre Systeme weiter.

Mit jeder Schlagzeile, jedem Shitstorm, jeder öffentlichen Empörungswelle werden die Schutzmechanismen strenger. Das Ergebnis ist dann das, was wir im Alltag erleben: Der Nutzer stellt eine normale Frage, das Modell antwortet, als hätte man gerade eine öffentliche Pressekonferenz gehalten. Statt nüchterner, fachlicher Hilfestellung gibt es eine Mischung aus Entschuldigung, Distanzierung und moralischer Einordnung.

Sicherheitsrichtlinien, die sich verselbstständigen

In jedem größeren Unternehmen gibt es Richtlinien. Am Anfang sind diese oft vernünftig und klar: Keine Diskriminierung, keine Gewaltverherrlichung, kein Aufruf zu Straftaten. Niemand wird ernsthaft widersprechen, dass solche Grundlinien sinnvoll sind. Doch in der Praxis bleibt es nicht dabei. Mit jedem Vorfall, jeder Beschwerde, jeder öffentlichen Diskussion kommen neue Regeln hinzu:

- ein zusätzliches „Falls-Dann“-Szenario,

- ein neuer Spezialfall,

- ein weiterer Sonderparagraph,

- eine Ausnahme für bestimmte Kontexte,

- oder eine besonders streng auszulegende Formulierung.

Über Jahre entsteht so ein immer dichteres Geflecht aus Vorgaben. Dieses Geflecht wird von Technik-Teams in Filter, Prompt-Schichten, Klassifizierer und andere Kontrollmechanismen übersetzt. Je mehr Ebenen hinzukommen, desto unberechenbarer wird das Verhalten im Einzelfall. Am Ende ist es gar nicht mehr die einzelne Regel, die das System prägt, sondern die Summe aller Regeln. Und diese Summe erzeugt das, was viele Anwender spüren:

- eine permanente Bremswirkung,

- eine Tendenz zur Übervorsicht,

- eine Sichtweise, in der „Risiko 0“ wichtiger ist als „Nutzen 100“.

Besonders problematisch: Wenn solche Sicherheitsrichtlinien einmal etabliert sind, lassen sie sich kaum wieder zurückdrehen. Kein Verantwortlicher möchte später sagen müssen: „Wir haben das lockerer gehandhabt, und jetzt ist etwas passiert.“ Also schiebt man lieber noch eine Schicht obendrauf. Und noch eine. Und noch eine. Was ursprünglich als sinnvolle Schutzmaßnahme begann, endet als System, das sich selbst verselbstständigt hat.

Zwischenfazit: Eine Technik unter Daueraufsicht

Fasst man diese Faktoren zusammen – internationale Regulierungen, Haftungsdruck, Medienlogik und die Eigendynamik von Sicherheitsrichtlinien –, ergibt sich ein klares Bild:

- Die großen Cloud-Modelle stehen ständig unter Beobachtung.

- Jede Fehlreaktion kann juristische und mediale Folgen haben.

In diesem Umfeld ist die Versuchung groß, lieber „zu viel“ zu filtern als „zu wenig“. Das Ergebnis für den Anwender: Die KI klingt nicht mehr wie ein neutraler Assistent, sondern eher wie ein System, das ständig mit einem halben Bein im Gerichtssaal und mit dem anderen in der Presseschau steht. Genau an dieser Stelle beginnt der Bruch mit der ursprünglichen Erwartung vieler Nutzer. Sie wollen nicht belehrt, nicht politisch eingerahmt, nicht pädagogisch begleitet werden. Sie wollen arbeiten, schreiben, programmieren, denken – mit einem Werkzeug, das sie unterstützt.

Und hier kommt eine Alternative ins Spiel, die zunächst fast altmodisch klingt, aber in Wahrheit hochmodern ist: lokale KI, direkt auf dem eigenen Rechner, ohne Cloud, ohne Oberaufsicht, ohne externe Richtlinien – außer den eigenen. Im nächsten Kapitel geht es daher um die Konsequenzen dieser Entwicklung:

Wie Cloud-KI durch ihre eigene Vorsicht immer unbrauchbarer für ambitionierte Anwender wird – und wie lokale Modelle unauffällig, aber konsequent in genau die Lücke hineinwachsen, die die großen Anbieter selbst geöffnet haben.

Cloud-KI wird immer gefilterter, aber der Nutzer braucht das Gegenteil

Die ursprüngliche Idee hinter KI-Assistenten war einfach: Der Anwender stellt eine Frage – die KI liefert eine präzise, hilfreiche Antwort. Ohne Umschweife, ohne Ablenkungen, ohne Belehrungen. Doch diese Einfachheit ist heute in vielen Cloud-Modellen verlorengegangen. Statt eines Werkzeugs bekommt der Nutzer eine Art vorauseilende Moderation. Die Systeme reagieren, als seien sie auf einem öffentlichen Podium und müssten jede Aussage absichern, relativieren oder einordnen. In der Praxis führt das zu einem paradoxen Effekt:

Je anspruchsvoller die Aufgabe, desto stärker fühlt man sich eingebremst. Wer kreativ arbeiten möchte – schreiben, programmieren, forschen, analysieren –, benötigt eigentlich maximale Offenheit. Eine KI, die frei Ideen ausspuckt, Hypothesen prüft, Alternativen diskutiert. Doch inzwischen ist der kreative Spielraum oft eingeschränkt. Statt mutiger Gedankenexperimente erhält man vorsichtiges Abtasten. Statt freier Analyse gibt es „kontextualisierte Hinweise“. Aus einem Werkzeug wird ein Wächter. Und aus Offenheit wird Vorsicht. Damit nimmt sich die Cloud-KI ironischerweise genau den Raum, den produktive Menschen am dringendsten brauchen.

Der Wandel der Modelle: Noch größer – aber eingeschränkter

Es ist eine Ironie der Technikgeschichte: Je größer die Modelle werden, desto kleiner wirkt manchmal ihr inhaltlicher Handlungsspielraum. GPT-5 ist beeindruckend, keine Frage – analytisch, sprachlich und logisch. Doch gleichzeitig ist es merklich stärker reguliert als seine Vorgänger. Viele Nutzer erleben:

- Die KI versteht mehr – sagt aber weniger.

- Sie erkennt komplexe Zusammenhänge – vermeidet aber klare Aussagen.

- Sie könnte tiefgehend analysieren – entschärft aber ständig die eigenen Ergebnisse.

Die Modelle haben Millionen von Parametern dazugewonnen, doch gefühlt haben sie an Freiheit verloren. Das ist kein technisches Problem, sondern ein kulturelles. Große Anbieter reagieren auf Risiken, und diese Risikominimierung schlägt sich direkt in der Tonalität der Modelle nieder. Man könnte sagen: Die KI ist erwachsen geworden – aber sie benimmt sich wie ein übervorsichtiger Erwachsener. Und wer täglich mit ihr arbeitet, merkt, wie anstrengend das auf Dauer werden kann.

Das Paradoxon des Bezahlmodells: Man zahlt – und bekommt trotzdem Grenzen

Früher galt in der digitalen Welt ein klarer Grundsatz: Wer zahlt, hat mehr Kontrolle. Doch bei Cloud-KI kehrt sich dieser Grundsatz um. Selbst zahlende Nutzer erhalten Modelle, die oft stärker eingeschränkt sind als die offenen, lokalen Alternativen. Die kostenpflichtige Version eines Produkts wirkt plötzlich wie die stärker regulierte, teils künstlich beschnittene Variante – während frei verfügbare Open-Source-Modelle erstaunlich unbefangen, direkt und kreativ agieren.

Dieses Paradoxon irritiert viele Anwender und führt zu einer Frage, die früher kaum jemand gestellt hätte: Warum bezahle ich eigentlich dafür, weniger Freiheit zu haben als mit einer kostenlosen lokalen Lösung? Es ist ein Bruch mit jahrzehntelangen Softwaretraditionen. Der Nutzer erwartet für sein Geld:

- mehr Funktionen,

- mehr Möglichkeiten,

- mehr Flexibilität,

- mehr Kontrolle.

Doch die Cloud-KI bietet ihm stattdessen:

- mehr Filter,

- mehr Einschränkungen,

- mehr pädagogische Einbettung,

- weniger Kontrolle über den eigenen Arbeitsprozess.

Damit bewegt sich die Branche in eine Richtung, die dem eigentlichen Bedarf der Anwender widerspricht. Und viele beginnen, sich umzuschauen.

Die entstehende Lücke: Was die Cloud nicht mehr leisten kann

Während Cloud-KIs immer stärker reglementiert werden, wächst eine Lücke, die lange Zeit niemand wahrgenommen hat: Der Bedarf nach unzensierten, freien, direkten Arbeitswerkzeugen. Gerade Menschen, die tiefer denken, schreiben, programmieren oder fachlich forschen, fühlen schnell, dass etwas nicht stimmt:

- Antworten wirken „weichgespült“.

- Kritische Passagen werden übervorsichtig formuliert.

- Echte Debattenkultur wird kaum noch zugelassen.

- Kreative Grenzbereiche werden automatisch entschärft.

Damit verlieren die Cloud-Modelle genau jenes Element, das sie am Anfang so wertvoll gemacht hat: eine Form von gedanklicher Unabhängigkeit, die dem Nutzer Raum gab. Die Cloud entfernt sich also schrittweise von den Bedürfnissen der professionellen Anwender – nicht aus böser Absicht, sondern aus juristischem und politischem Selbstschutz. Doch dieser Selbstschutz hat einen Preis.

Die Gegenbewegung: Kleine lokale Modelle holen rasant auf

Während die Cloud immer entschiedener auf Vorsicht setzt, haben sich lokale Modelle in den letzten zwei Jahren geradezu explosiv weiterentwickelt. Systeme mit 3–27 Milliarden Parametern liefern heute erstaunliche Qualität. Manche Modelle kommen in Alltagsaufgaben leicht an GPT-4 heran – ohne Filterkaskaden, ohne Moderationsschichten, ohne moralische Umrahmung. Was früher nur mit High-End-Hardware möglich war, läuft heute auf einem MacBook oder einem Windows-Rechner:

- llama3

- gpt-oss

- mistral

- phi3

- gemma

- qwen

All diese Modelle sind frei erhältlich, lokal ausführbar und benötigen oft nur wenige Klicks in Ollama oder OpenWebUI, um einsatzbereit zu sein. Die Vorteile liegen auf der Hand:

- Sie belehren nicht.

- Sie relativieren nicht.

- Sie filtern nicht übermäßig.

- Sie gehorchen ausschließlich dem Nutzer – nicht einer globalen Compliance-Abteilung.

Mit anderen Worten: Die lokale KI kehrt zurück zu den Wurzeln der Technik: ein Werkzeug, das einfach arbeitet. Wenn man die Entwicklung nüchtern betrachtet, ist das Bild eindeutig:

- Die Cloud wird immer stärker reguliert.

- Die lokale KI wird immer leistungsfähiger.

Der Nutzer braucht aber gerade für kreative und tiefgehende Aufgaben eine offene, ungefilterte Arbeitsumgebung. Damit entsteht ein historischer Wendepunkt, der fast an die Zeit erinnert, als Personal Computer die Großrechner verdrängten. Damals wie heute geht es um das gleiche Prinzip:

Kontrolle über die eigene Technik. Cloud-KI bleibt mächtig – aber sie ist kulturbedingt nicht frei. Lokale KI ist kleiner – aber sie ist frei.

KI lokal nutzen – volle Kontrolle & Datenschutz auf DEINEM Gerät | C. Magnussen

Die Lösung: Lokale KI und wie man sie in wenigen Minuten installiert

Es wirkt fast wie eine Rückbesinnung auf eine alte Tradition: Technik gehört dorthin, wo sie ihren Wert am unmittelbarsten entfaltet – in die Hände des Nutzers. Genau das ermöglicht die lokale KI. Während Cloud-Modelle unter Auflagen, Sicherheiten und politischen Zwängen stehen, läuft eine lokale KI ausschließlich auf dem eigenen Rechner, ohne Fremdinstanzen, ohne Richtlinien von außen.

Damit wird ein grundlegendes Prinzip wiederhergestellt, das in den letzten Jahren verloren gegangen war: Der Anwender bestimmt, was seine Software tun darf – nicht ein globaler Dienstleister. Lokale KI:

- speichert keine Daten auf fremden Servern,

- unterliegt keinen Filtersystemen,

- kennt keine politisch vorgegebenen Restriktionen,

- reagiert frei und direkt auf die eigenen Eingaben,

- und ist immer verfügbar, unabhängig von Abos oder Serverstatus.

Technik wird damit wieder zu dem, was sie jahrzehntelang war: ein Werkzeug in der Werkstatt des Anwenders, nicht ein fernbedientes Gerät in einer globalen Infrastruktur.

Moderne Hardware: Warum ein Mac oder Windows-PC heute vollkommen ausreicht

Noch vor wenigen Jahren war lokale KI nur etwas für Spezialisten mit teurer GPU-Hardware. Heute ist das anders. Moderne Prozessorarchitekturen – allen voran Apples M-Chips – liefern auf engem Raum eine Rechenleistung, die früher ausschließlich großen Rechenzentren vorbehalten war. Selbst ein normaler MacBook-Air oder ein Windows-Laptop kann heute KI-Modelle lokal ausführen. Besonders Macs haben mit ihren einheitlichen Speicherarchitekturen (Unified Memory) einen Vorteil: Sie können KI-Modelle ohne komplizierte Treiber direkt auf CPU und GPU nutzen. Typische Konfigurationen reichen völlig aus:

- Mac mit M1, M2, M3 – ab 16 GB RAM komfortabel

- Windows-PC mit moderner CPU – oder optional mit einer GPU für mehr Tempo

Und das Wichtigste: Man braucht kein technisches Hintergrundwissen mehr. Die Zeiten, in denen man Python-Umgebungen manuell aufsetzen oder kryptische Kommandozeilenbefehle eintippen musste, sind vorbei. Heute läuft alles über einfache Installationspakete.

Ollama: Die neue Einfachheit (und der heimliche Standard der lokalen KI)

Ollama ist mittlerweile der unumstrittene Standard für lokale KI auf Mac und Windows. Es ist schlicht, stabil und folgt einer klassischen Philosophie:

So wenig Aufwand wie möglich, so viel Freiheit wie nötig. Früher musste man noch ins Terminal, doch selbst das ist heutzutage optional. Die Installation funktioniert in wenigen Schritten:

- Ollama auf dem Mac installieren

- Direktes Installationspaket (DMG) herunterladen

- App öffnen, fertig

Der gesamte Prozess dauert meist weniger als drei Minuten. Und genau darin zeigt sich, wie weit die lokale KI gekommen ist: Man lädt ein Modell herunter – und es funktioniert. Ohne Cloud, ohne Abo, ohne Risiko. Ollama kommt heute inklusive Benutzeroberfläche, so dass man direkt loslegen kann. Wer seine lokale KI aus Ollama auch auf dem Smartphone nutzen möchte, kann die App „Reins – Chat for Ollama“ herunterladen und die lokale KI mobil nutzen.

Modelle laden und nutzen – so einfach wie Musik hören

Ollama bringt die Modelle als „Fertigpakete“, sogenannte Modell-Kapseln. Man lädt sie wie eine Datei – und sofort kann man damit arbeiten. Das Laden dauert je nach Größe wenige Sekunden. Danach öffnet sich der Chat – und man kann schreiben, formulieren, analysieren, nachdenken, entwerfen. Was sofort auffällt:

- Die Modelle antworten frei, nicht umständlich.

- Es gibt keine moralischen Vorreden.

- Es gibt keinen pädagogischen Zeigefinger.

Man erhält wieder direkte, klare Aussagen. Und hier entsteht der eigentliche Unterschied zur Cloud: Lokale KI reagiert wie ein traditionelles Werkzeug – sie mischt sich nicht ein. Für viele ist das eine regelrechte Befreiung, weil man den Arbeitsfluss zurückbekommt, den man früher mit GPT-4 gewohnt war.

Arbeiten mit grafischen Oberflächen: OpenWebUI, LM Studio und andere

Wer völlig ohne Terminal arbeiten möchte, nutzt eine grafische Oberfläche. Die beliebtesten Tools sind:

- OpenWebUI – moderne Chat-Oberfläche mit Speicherfunktion, Modellauswahl, Dokumenten-Upload, Bilderzeugung

- LM Studio – besonders einfach, ideal für Einsteiger

- AnythingLLM – für komplette Wissensdatenbanken und Dokumentenanalyse

Diese Oberflächen bieten viele Vorteile:

- Chatverläufe wie in der Cloud

- Modellverwaltung per Mausklick

- Systemprompts einstellen

- Mehrere Modelle parallel nutzen

- Dateien per Drag & Drop analysieren

Damit wird lokale KI nicht nur leistungsfähig, sondern bequem. Man muss nicht einmal wissen, was im Hintergrund passiert – und genau darin liegt die neue Stärke der lokalen Modelle: Sie stellen sich nicht zwischen den Anwender und seine Aufgabe.

Privatsphäre und Kontrolle: Das wichtigste Argument

Ein Punkt, der oft unterschätzt wird, aber in den nächsten Jahren entscheidend sein wird: Lokale KI verlässt niemals den Rechner.

- keine Cloud

- keine Datenübertragung

- keine Protokollierung

- kein Zwangs-Abo

- keine Auswertungen durch Dritte

Selbst vertrauliche Dokumente, interne Unterlagen, geschäftliche Konzepte oder private Notizen können gefahrlos analysiert werden. Das ist im Cloud-Modell – juristisch und praktisch – nur begrenzt möglich. Die lokale KI ist damit ein Stück digitale Unabhängigkeit, das in einer zunehmend regulierten und überwachten Technikwelt immer wichtiger wird.

Qualitätsbeispiele: Was lokale Modelle schon heute leisten

Viele unterschätzen, wie gut lokale Modelle mittlerweile geworden sind. Die aktuellen Generationen – llama3, gemma, phi3, mistral – lösen Aufgaben in einer Qualität, die für 90 % der alltäglichen Arbeiten mehr als ausreicht:

- Textentwürfe

- Artikel

- Analysen

- kreative Ideen

- Zusammenfassungen

- Programmcode

- Strategieentwürfe

- Recherche-Notizen

Und sie tun es ohne Verzögerung, ohne Filter, ohne Richtlinienkaskaden. Der Anwender erhält wieder direkte Antworten – die pure Essenz des Werkzeugs. Damit entsteht etwas, das viele gar nicht mehr erwartet hätten: eine Renaissance der persönlichen Computer-Kultur, in der Rechenleistung wieder lokal stattfindet, nicht ausgelagert.

Der Blick nach vorne: Lokale KI als kommende Leitkultur

Alles deutet darauf hin, dass wir hier am Anfang einer langfristigen Entwicklung stehen. Die KI-Branche wird sich zweigleisig entwickeln:

- die Cloud-Linie, geprägt von Regulierung, Sicherheit, Unternehmensinteressen – leistungsfähig, aber vorsichtig

- die lokale Linie, geprägt von Freiheit, Offenheit, Experimentierfreude – kleiner, aber souverän

Für professionelle Anwender, Autoren, Entwickler, Forscher, Kreative, Unternehmer ist die Entscheidung fast schon vorgezeichnet:

Die Zukunft des produktiven Arbeitens liegt dort, wo man unabhängig ist. Und dieser Ort ist nicht in der Cloud.

Er steht auf dem Schreibtisch.

Weiterführende Artikel im Magazin

Wer nach diesem Überblick tiefer in die Praxis einsteigen möchte, findet im Magazin bereits eine Reihe ausführlicher Beiträge, die das Thema lokale KI aus ganz unterschiedlichen Perspektiven beleuchten.

Besonders empfehlenswert ist der Leitartikel „Lokale KI auf dem Mac – so installieren Sie ein Sprachmodell mit Ollama“, der Schritt für Schritt zeigt, wie einfach moderne KI heute auf dem eigenen Rechner läuft.

Ergänzend dazu erklärt „Ollama trifft Qdrant – Ein lokales Gedächtnis für Deine KI auf dem Mac“, wie man Modelle so konfiguriert, dass sie Projekte behalten, Wissensstände speichern und damit erstmals eine echte persönliche Arbeitsumgebung entstehen lassen.

Auch im Unternehmenskontext setzt das Magazin klare Akzente: „gFM-Business und die Zukunft des ERP – lokale Intelligenz statt Cloud-Abhängigkeit“ zeigt, wie Firmen KI souverän in ihre bestehende Infrastruktur einbauen können, ohne sich in langfristige externe Abhängigkeiten zu manövrieren.

Der Artikel „Digitale Abhängigkeit – wie wir unsere Selbstbestimmung an die Cloud verloren haben“ beleuchtet dagegen die großen Linien unserer Zeit: Warum wir viele Freiheiten unbemerkt abgegeben haben – und wie lokale Systeme helfen können, sie zurückzugewinnen.

Darüber hinaus richtet sich „Wie man heute schon KI-Spezialisten ausbilden kann – Chancen für Unternehmen und Azubis“ an Betriebe, die jetzt den Einstieg wagen wollen: praxisnah, ohne teure Großsysteme, aber mit realer Zukunftsperspektive.

Auf technischer Ebene erklären „Apple MLX versus NVIDIA – so funktioniert lokale KI-Inferenz auf dem Mac“ sowie der Übersichtsartikel

„KI Studio 2025 – welche Hardware wirklich lohnt, vom Mac Studio bis zur RTX 3090“, welche Plattformen sich für verschiedene Anwendungsfälle eignen und wie man die eigenen Ressourcen optimal einsetzt.

Gemeinsam ergeben diese Artikel ein kompaktes Fundament für alle, die lokale KI nicht nur nutzen, sondern verstehen und souverän in ihre Arbeitswelt integrieren wollen.

Häufig gestellte Fragen

- Warum wirken moderne Cloud-KIs plötzlich so belehrend?

Viele Anwender bemerken, dass sich Cloud-KIs seit GPT-4.1 und insbesondere seit GPT-5 deutlich pädagogischer verhalten. Das liegt vor allem daran, dass große Anbieter unter erheblichem juristischen und politischen Druck stehen und deshalb verstärkt Sicherheitsfilter einsetzen, die jede Aussage so entschärfen sollen, dass keinerlei Risiken entstehen. Diese Vorsichtsmaßnahmen übertragen sich auf den Ton der Antworten, sodass die Modelle eher wie Moderatoren oder Aufpasser wirken, anstatt als neutrale Werkzeuge. - Warum scheint GPT-4.0 inzwischen schlechter zu funktionieren als früher?

Obwohl GPT-4 offiziell noch verfügbar ist, berichten viele Nutzer, dass es nur noch kurze oder abgebrochene Antworten liefert. Dadurch wirkt es praktisch unbrauchbar. Ob dies technische Gründe hat oder eine bewusste Übergangsstrategie zur 5er-Generation darstellt, lässt sich nicht mit Sicherheit sagen. Faktisch verliert das Modell jedoch seine frühere Stärke und zwingt Anwender indirekt in die neuen Versionen, die stärker reguliert sind. - Bedeutet diese Entwicklung, dass Cloud-KI zukünftig weniger brauchbar wird?

Cloud-KI bleibt leistungsfähig, doch sie wird immer stärker von Vorgaben, Compliance-Regeln und politischem Druck geprägt sein. Das bedeutet, dass sie zwar technisch beeindruckend bleibt, aber inhaltlich vorsichtiger, gefilterter und weniger frei wird. Für viele kreative, analytische oder unkonventionelle Aufgaben ist das ein deutlicher Nachteil, weshalb immer mehr Anwender nach Alternativen suchen. - Warum setzen KI-Unternehmen überhaupt so viele Sicherheitsmechanismen ein?

Der Grund liegt in der Summe aus Regulierungen, Haftungsrisiken und öffentlicher Wahrnehmung. Jeder Fehler, jede missverständliche Antwort einer KI kann für ein Unternehmen juristische oder mediale Folgen haben. Um solche Risiken auszuschließen, implementieren Anbieter umfassende Filter und Richtlinien, die alle Antworten „absichern“ sollen. Dieser Schutzmechanismus ist aus Unternehmenssicht nachvollziehbar, aus Nutzersicht aber häufig hinderlich. - Was unterscheidet lokale KI grundsätzlich von Cloud-KI?

Lokale KI läuft vollständig auf dem eigenen Gerät und ist damit weder an politische Vorgaben noch an Unternehmensrichtlinien gebunden. Sie filtert kaum, belehrt nicht und arbeitet direkt nach den Vorgaben des Nutzers. Außerdem bleiben alle Daten auf dem eigenen Rechner. Das verleiht dem Anwender nicht nur mehr Freiheit, sondern auch mehr Privatsphäre und Kontrolle. - Ist spezielle Hardware nötig, um lokale KI zu nutzen?

In den meisten Fällen nicht. Moderne lokale Modelle sind erstaunlich effizient und laufen bereits auf typischen Macs mit M-Chips oder auf handelsüblichen Windows-Rechnern. Natürlich profitieren größere Modelle von mehr RAM oder einer GPU, doch für viele Alltagsaufgaben reichen kleine bis mittelgroße Modelle völlig aus, ohne dass teure Spezialhardware erforderlich wäre. - Wie funktioniert die Installation lokaler KI auf dem Mac in der Praxis?

Am einfachsten gelingt sie mit Ollama. Man lädt ein Installationspaket herunter, öffnet es und kann sofort loslegen. Selbst der klassische Terminalbefehl ist optional geworden. Sobald Ollama installiert ist, kann man mit einem einfachen Befehl wie „ollama run llama3“ ein Modell starten. Die Hürde ist so niedrig wie früher bei der Installation eines normalen Programms. - Wie richtet man lokale KI unter Windows ein?

Unter Windows nutzt man ebenfalls den Ollama-Installer, der ohne zusätzliche Vorbereitung auskommt. Nach der Installation können Modelle sofort ausgeführt werden. Wer lieber eine grafische Oberfläche verwendet, greift zu LM Studio oder OpenWebUI, die Bedienung dort ist ebenso einfach wie bei gewöhnlicher Anwendungssoftware. - Welche Modelle eignen sich besonders für Einsteiger?

Viele Nutzer starten erfolgreich mit Llama 3, weil es präzise, vielseitig und sprachlich stark ist. Ebenso beliebt ist Phi-3, das trotz kleiner Modellgröße beeindruckende Ergebnisse liefert. Auch Gemma eignet sich gut, vor allem für kreative oder textlastige Arbeiten. Diese Modelle laufen schnell und stabil, ohne dass man sich lange einarbeiten muss. Wer über mehr Ressourcen verfügt, ist mit GPT-OSS 20B oder 120B sehr gut bedient. - Können lokale Modelle wirklich mit GPT-4 oder GPT-5 mithalten?

Für viele alltägliche Aufgaben können sie das überraschend gut. Die Lücke bei hochspezialisierten Themen besteht zwar noch, aber sie schließt sich rasant. Lokale Modelle haben den Vorteil, dass sie weniger eingeschränkt sind und direkter antworten. In der Summe wirken sie dadurch oft freier und natürlicher, selbst wenn sie technisch etwas kleiner sind. - Ist lokale KI sicherer im Umgang mit sensiblen Daten?

Ja, eindeutig. Da sämtliche Verarbeitung auf dem eigenen Gerät stattfindet, verlassen die eingegebenen Daten nie den Rechner. Es gibt keine Cloud-Verarbeitung, keine Speicherung auf fremden Servern und keine Auswertung durch Dritte. Gerade für geschäftliche Dokumente, vertrauliche Unterlagen oder private Notizen ist das ein entscheidender Vorteil. - Kann lokale KI ohne Internetverbindung genutzt werden?

Ja. Das ist einer ihrer größten Vorteile. Sobald das Modell installiert ist, kann es vollständig offline betrieben werden. Damit wird der Rechner zu einer autarken Arbeitsumgebung, in der man unabhängig von externen Diensten arbeitet. Das ist besonders nützlich auf Reisen, in sicheren Netzwerken oder in Umgebungen, in denen Datenschutz höchste Priorität hat. - Wie gut eignen sich lokale Modelle für lange Texte?

Die meisten modernen Modelle bewältigen heute problemlos lange Artikel, Analysen oder Konzepte. Sie sind nicht ganz so geschliffen wie GPT-5, aber dafür freier von Filtern und in ihrem Stil oft direkter. Für umfangreiche Texte, Ideensammlungen oder technische Dokumentationen sind sie gut geeignet und ermöglichen produktives Arbeiten ohne Einschränkungen. - Haben lokale Modelle überhaupt Sicherheitsfilter?

Ein gewisser Basisschutz ist meist vorhanden, allerdings deutlich schwächer als bei Cloud-KI. Da die Modelle auf dem eigenen Gerät laufen, kann der Nutzer selbst entscheiden, welche Einschränkungen sinnvoll sind. Dieser Gestaltungsspielraum sorgt dafür, dass lokale KI viel flexibler und weniger bevormundend auftritt. - Wie kann man verschiedene Modelle testen oder vergleichen?

Ollama, LM Studio oder OpenWebUI machen den Modellwechsel sehr leicht. Man kann mehrere Modelle parallel installieren, zwischen ihnen wechseln und ihre Stärken vergleichen. Dadurch entsteht ein persönliches Set aus Lieblingsmodellen, das genau zum eigenen Arbeitsstil passt. Der Prozess ist unkompliziert und erinnert eher an das Testen verschiedener Apps als an klassische KI-Forschung. - Welche Vorteile haben lokale Modelle für Unternehmen?

Unternehmen profitieren vor allem von der vollständigen Datenhoheit, denn keine Cloud bedeutet keine Fremdspeicherung. Zudem entfallen langfristige Abhängigkeiten von externen Diensten und teuren Abos. Modelle können intern angepasst, erweitert oder sogar trainiert werden. Die Integration in bestehende Prozesse gelingt oft leichter, weil man die volle Kontrolle behält und nicht an fremde Infrastruktur gebunden ist. - Können lokale Modelle individuell trainiert werden?

Ja, das ist sogar einer der wichtigsten Vorteile. Mit Techniken wie LoRA oder Feintuning lassen sich Modelle an firmeneigene Inhalte, Prozesse oder Dokumente anpassen. Dadurch entsteht eine persönliche Wissensbasis, die ausschließlich intern genutzt und weiterentwickelt wird, ohne dass sensible Daten die Firma verlassen. - Worin unterscheiden sich die gängigen lokalen Modelle qualitativ?

Jedes Modell hat seinen eigenen Charakter. Llama 3 ist sehr präzise und ausgeglichen, Gemma wirkt kreativ und sprachlich geschmeidig, Phi-3 überrascht durch Effizienz und Intelligenz, während Mistral und Qwen analytisch besonders stark sind. Dieser Variantenreichtum ermöglicht es, das passende Modell für den eigenen Bedarf auszuwählen und flexibel zu wechseln, wenn eine Aufgabe es erfordert. - Können lokale Modelle auch Bilder erzeugen?

Ja, über Tools wie OpenWebUI lassen sich Bildgeneratoren wie Stable Diffusion vollständig lokal betreiben. Die Ergebnisse hängen von der vorhandenen Hardware ab, aber selbst mit moderaten Ressourcen lassen sich solide Bilder erzeugen. Der Vorteil bleibt derselbe: Es werden keinerlei Daten an externe Dienste gesendet. - Für wen lohnt sich der Umstieg auf lokale KI besonders?

Lokale KI ist ideal für Anwender, die souverän und unabhängig arbeiten möchten. Dazu gehören Autoren, Entwickler, Forscher, Unternehmer und alle, die mit sensiblen Informationen umgehen oder kreative Prozesse ohne Filter erleben möchten. Wer Wert auf Kontrolle, Datenschutz und Freiheit legt, findet in lokalen Modellen die passende Lösung und gewinnt eine Arbeitsumgebung zurück, die in der Cloud so nicht mehr existiert.