Quem lida atualmente com o tema da inteligência artificial depara-se quase inevitavelmente com uma sensação estranha: uma inquietação constante. Mal nos habituamos a uma ferramenta, aparecem as dez seguintes. Um vídeo segue-se ao outro no YouTube: „Esta ferramenta de IA muda tudo“, „Tens mesmo de usar isto agora“, „Os que ficam de fora são deixados para trás“. E todas as vezes, a mesma mensagem ressoa subliminarmente: Chegou demasiado tarde. Os outros estão mais à frente. Tens de os apanhar.

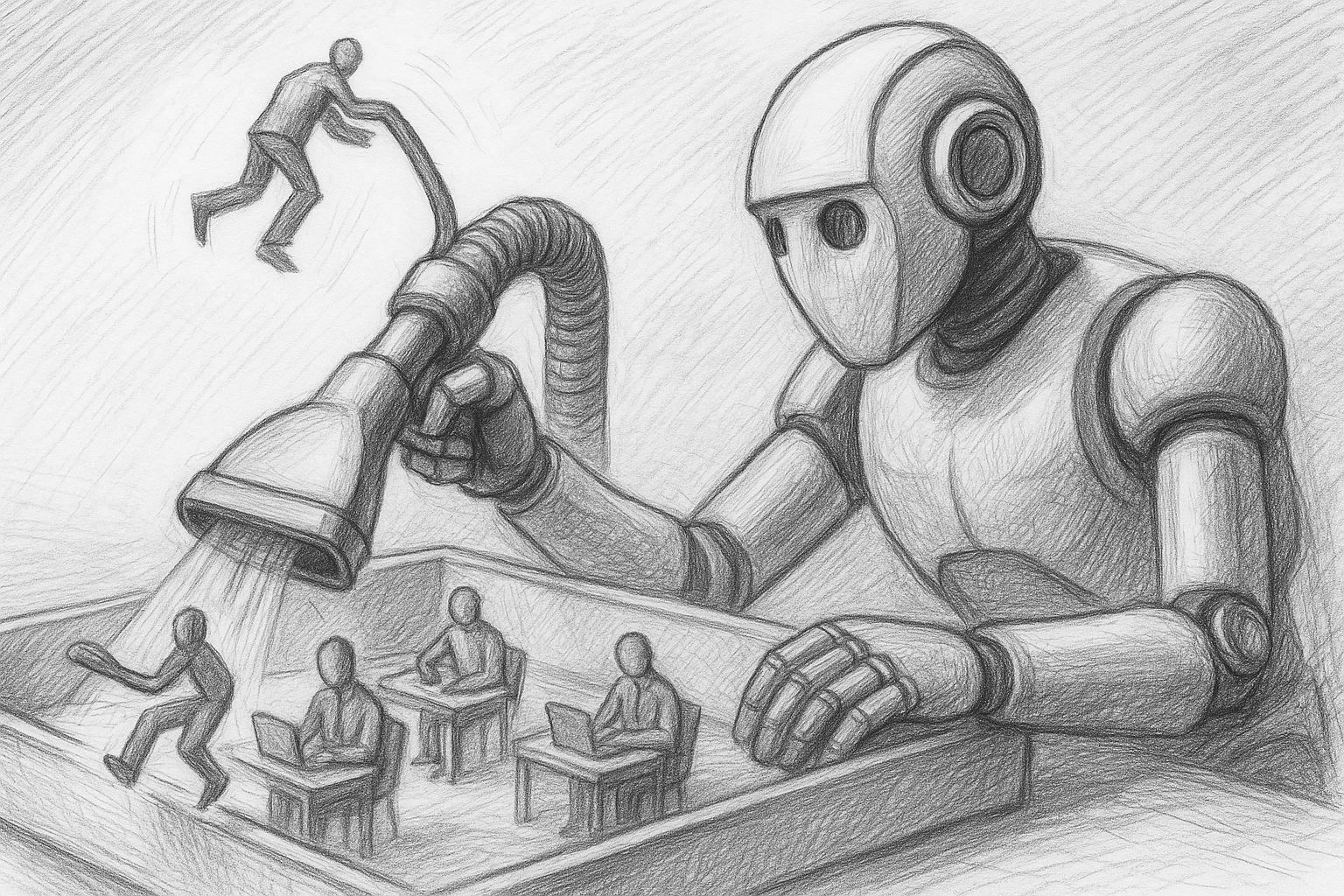

Esta situação não afecta apenas os informáticos. Os trabalhadores independentes, os profissionais criativos, os empresários e os empregados comuns também estão a sentir a pressão. Muitos nem sequer sabem exatamente o que estas ferramentas fazem, mas têm a sensação de que podem estar a perder alguma coisa. E é exatamente isso que causa stress.