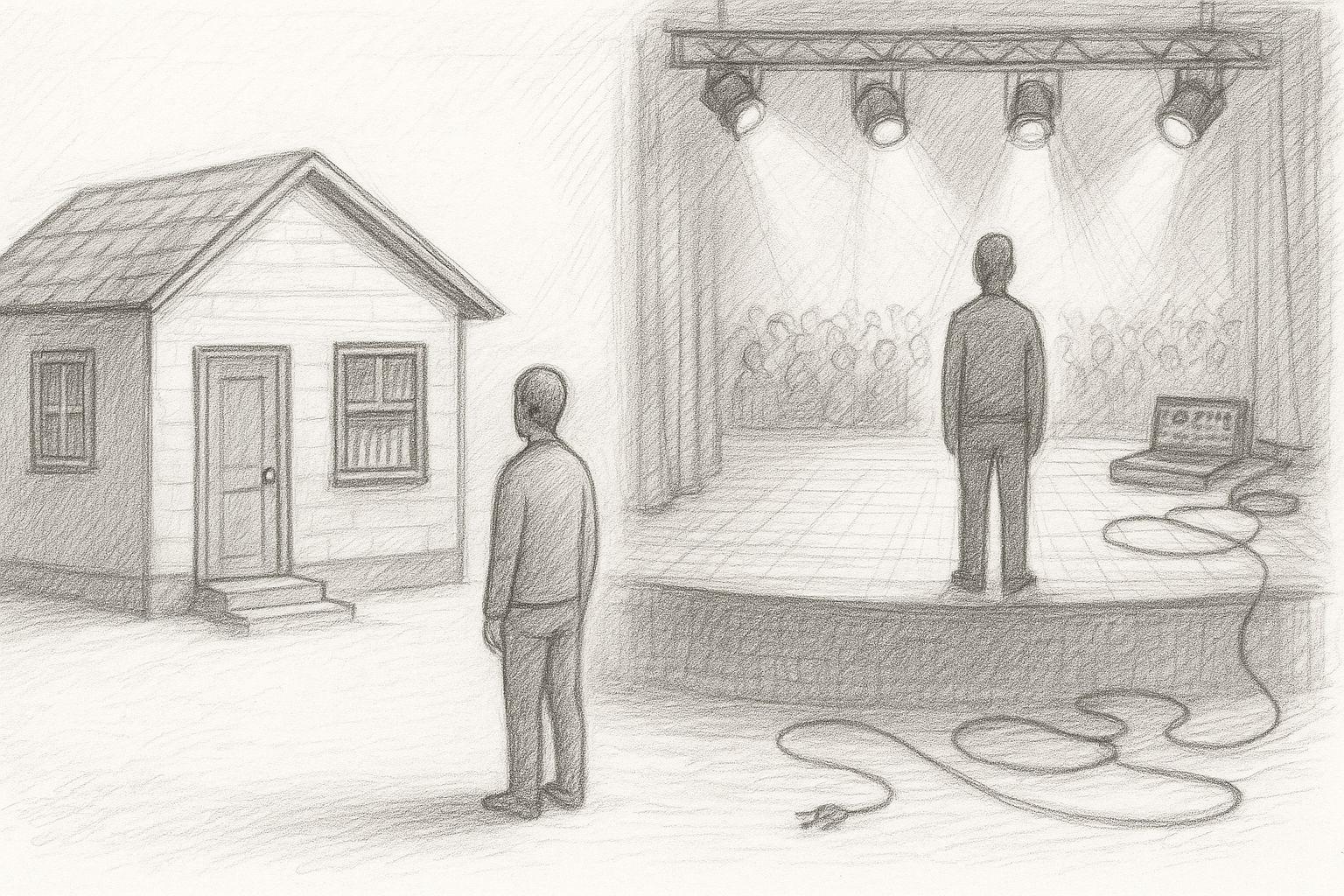

Vor gut zehn Jahren habe ich mir einmal eher zufällig einen Vortrag angesehen, in dem es um den Übergang von der Informationsgesellschaft zur Wissensgesellschaft ging. Damals klang vieles davon noch theoretisch, fast akademisch. Es ging um Begriffe wie Datenhoheit, Eigentum an Informationen und die Frage, wer künftig eigentlich bestimmt, was zugänglich ist – und was nicht. Heute, mit etwas Abstand, wirkt dieser Vortrag erstaunlich präzise. Denn vieles von dem, was damals als Entwicklung beschrieben wurde, ist inzwischen Realität geworden. Immer mehr Daten sind in die Cloud gewandert. Immer mehr Informationen liegen nicht mehr auf eigenen Systemen, sondern in fremden Infrastrukturen. Und immer häufiger entscheidet nicht mehr der Nutzer, sondern ein Anbieter, eine Plattform oder ein Regelwerk darüber, was möglich ist.

Um diese Entwicklung zu verstehen, lohnt sich ein Schritt zurück. Denn die Informationsgesellschaft, in der viele von uns aufgewachsen sind, war kein Normalzustand. Sie war ein historischer Sonderfall.