Quando qualche anno fa i grandi modelli linguistici hanno iniziato la loro marcia trionfale, sembravano quasi un ritorno alle vecchie virtù della tecnologia: uno strumento che fa quello che gli viene detto. Uno strumento che serve l'utente, non il contrario. Le prime versioni, da GPT-3 a GPT-4, avevano sì dei punti deboli, ma erano incredibilmente utili. Spiegavano, analizzavano, formulavano e risolvevano i compiti. E lo facevano in gran parte senza zavorre pedagogiche.

Si parlava con questi modelli come se si stesse parlando con un impiegato erudito, che a volte sbagliava le parole, ma che essenzialmente lavorava e basta. Chiunque abbia scritto testi creativi, generato codici di programma o prodotto analisi più lunghe all'epoca ha sperimentato quanto tutto ciò funzionasse senza problemi. C'era una sensazione di libertà, di spazio creativo aperto, di tecnologia che supportava le persone invece di correggerle.

All'epoca era ancora possibile prevedere che questi strumenti avrebbero plasmato i decenni a venire, non attraverso il paternalismo, ma attraverso la competenza. Tuttavia, come spesso accade nella storia della tecnologia, questa fase non fu priva di cambiamenti.

Dall'apertura alla prudente moderazione

Più i modelli maturavano, più il tono cambiava. Quello che all'inizio sembrava un avvertimento protettivo occasionale è diventato gradualmente un intero strato di protezione, istruzione e autocensura morale. Il modello amichevole e obiettivo ha iniziato a comportarsi sempre più come un moderatore, o peggio: come un cane da guardia.

Le risposte sono diventate più lunghe, ma non più sostanziose. Il tono è diventato più morbido, ma più istruttivo. I modelli non volevano più solo aiutare, ma anche „educare“, „guidare responsabilmente“ e „proteggere da conclusioni sbagliate“. E all'improvviso questo quadro pedagogico era ovunque.

Per molti utenti si è trattato di una rottura con la promessa originaria della tecnologia. Volevano uno strumento e invece hanno ricevuto una sorta di maestro digitale che commenta ogni frase prima ancora di aver capito di cosa si tratta.

L'effetto insegnante senior: protezione invece di assistenza

Il cosiddetto „effetto maestro in capo“ descrive uno sviluppo particolarmente evidente a partire dal GPT-5. I modelli reagiscono in modo sempre più sensibile a qualsiasi parola che potrebbe teoricamente - all'orizzonte - essere interpretata in una direzione controversa. I modelli reagiscono in modo sempre più sensibile a qualsiasi parola che, in teoria, potrebbe essere interpretata in una direzione controversa. L'effetto si manifesta in diverse forme:

- Eccessiva prudenzaAnche le domande più innocue vengono relativizzate con lunghe prefazioni.

- IstruzioniInvece di una risposta, si ottiene una categorizzazione morale.

- Effetti di frenataL'intelligenza artificiale cerca di proteggere l'utente da ipotetiche interpretazioni errate.

- AutocensuraMolti argomenti vengono addolciti o confezionati in modo complicato.

Il problema non è l'idea di cautela in sé. È l'intensità. È l'onnipresenza. Ed è il fatto che si paga per averla - e si è ancora limitati. I modelli si stanno trasformando da assistenti a guardiani. E questo è esattamente ciò che sente chi ha lavorato con la 4.0, la 5.0 e la 5.1 in un confronto diretto.

Come GPT-5.0 e GPT-5.1 hanno cambiato il tono per sempre

Lo sviluppo verso un maggior numero di istruzioni era già evidente con GPT-4.1. Ma con il passaggio alla quinta generazione è stato fatto un salto significativo. La GPT-5.0 ha rafforzato l'armatura educativa, ma la GPT-5.1 la porta a un livello nuovo e, per molti, sorprendentemente severo. Ecco cosa succede con la GPT-5.1:

- Le risposte diventano più neutre dal punto di vista emotivo, ma paradossalmente più moraleggianti.

- L'IA cerca di anticipare situazioni che non erano previste.

- Ogni potenziale controversia viene contenuta in anticipo, a volte addirittura „chiarita“ prima ancora che l'utente arrivi al punto.

- Anche gli argomenti tecnici specialistici sono a volte inquadrati in modo scomodo.

Si potrebbe dire che i modelli hanno imparato a controllare se stessi, ma ora controllano anche l'utente. È un cambiamento silenzioso ma profondo. Chiunque lavori in modo produttivo lo percepisce dopo pochi minuti.

GPT-4.0 come fantasma: un modello che c'è ancora, ma che praticamente non esiste più

Ufficialmente si è detto a lungo che il GPT 4.0 avrebbe funzionato ancora per qualche mese. In realtà, però, il modello è ormai a malapena utilizzabile. L'osservazione tipica di molti utenti:

- Le risposte sono ridotte a poche frasi.

- I testi più lunghi vengono cancellati in anticipo.

- Il modello „dimentica“ il contesto o si annulla dopo un paragrafo.

- I compiti completi vengono rifiutati o affrontati solo superficialmente.

L'impressione è che il GPT-4.0 sia stato sistematicamente „ridotto“. Se ciò sia intenzionale o dovuto a motivi tecnici, è possibile fare delle speculazioni. Ma il risultato è chiaro: le persone vengono spinte verso i modelli 5 perché il 4.0 è diventato praticamente inutilizzabile.

Questo significa che molti utenti stanno perdendo l'unica versione che ancora presentava un equilibrio di libertà tra apertura e cautela. Il vecchio modo di lavorare - creativo, flessibile, senza eccessive istruzioni - è quindi di fatto spento.

L'effetto cumulativo: uno strumento che è sempre meno uno strumento

Riassumendo gli ultimi due anni, emerge una tendenza notevole:

- I modelli sono sempre più grandi.

- I modelli sono sempre più veloci.

- I modelli sono sempre più potenti.

Ma allo stesso tempo:

- Diventano più cauti.

- Diventano più pedagogici.

- Diventano più dipendenti dalle linee guida.

E lasciano all'utente meno spazio di manovra. Non si tratta di uno sviluppo tecnico, ma culturale. E si inserisce in un momento in cui le aziende, i politici e i media vogliono abbracciare immediatamente ogni nuova tecnologia prima ancora che l'utente possa provarla in pace.

Ma è qui che si verifica una rottura. Perché la natura della tecnologia - e ancor più quella della creatività - richiede libertà, non educazione. Sempre più utenti lo percepiscono intuitivamente. E cercano alternative. Questa alternativa viene da una direzione che molti non si sarebbero aspettati:

Intelligenza Artificiale locale, direttamente sul proprio computer, senza filtri, senza un direttore d'orchestra. Il pendolo torna a oscillare.

Sondaggio attuale sull'IA locale

Da dove viene questo sviluppo? Uno sguardo dietro le quinte

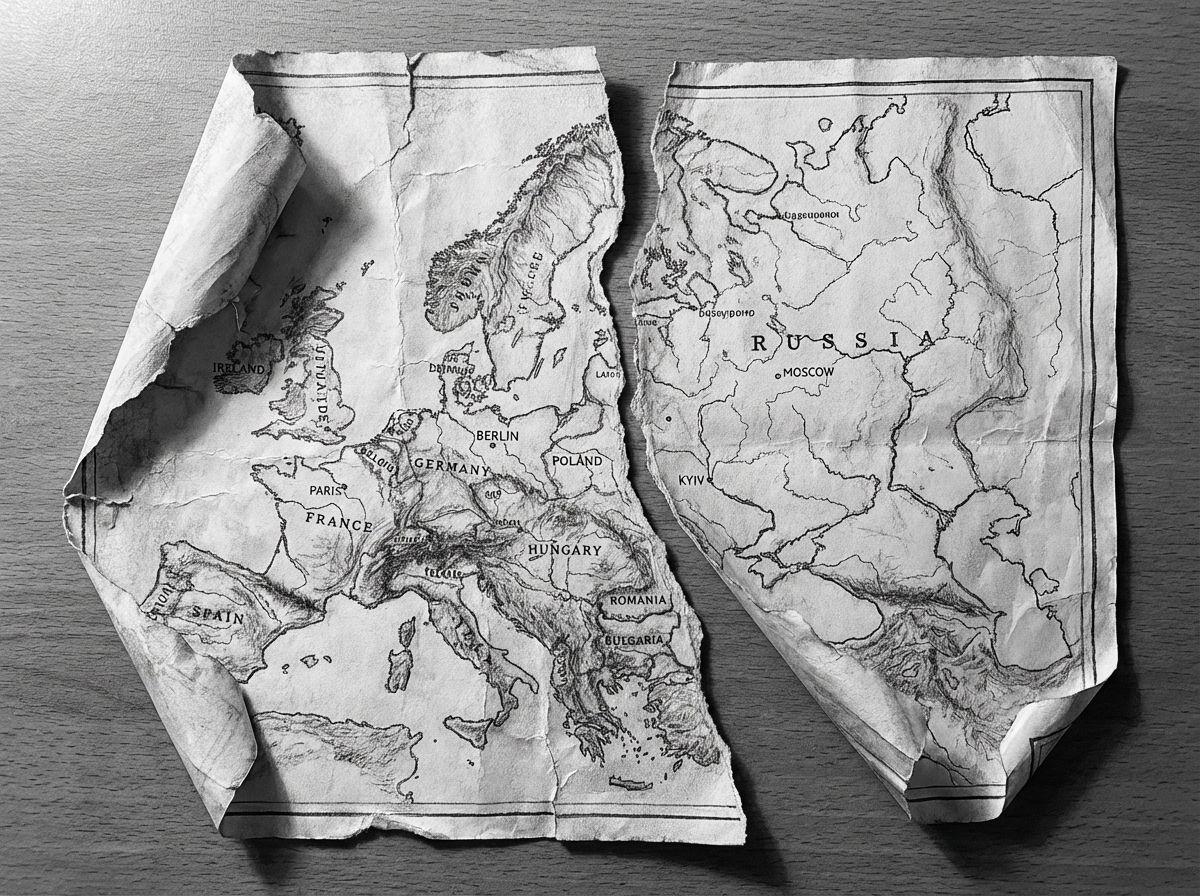

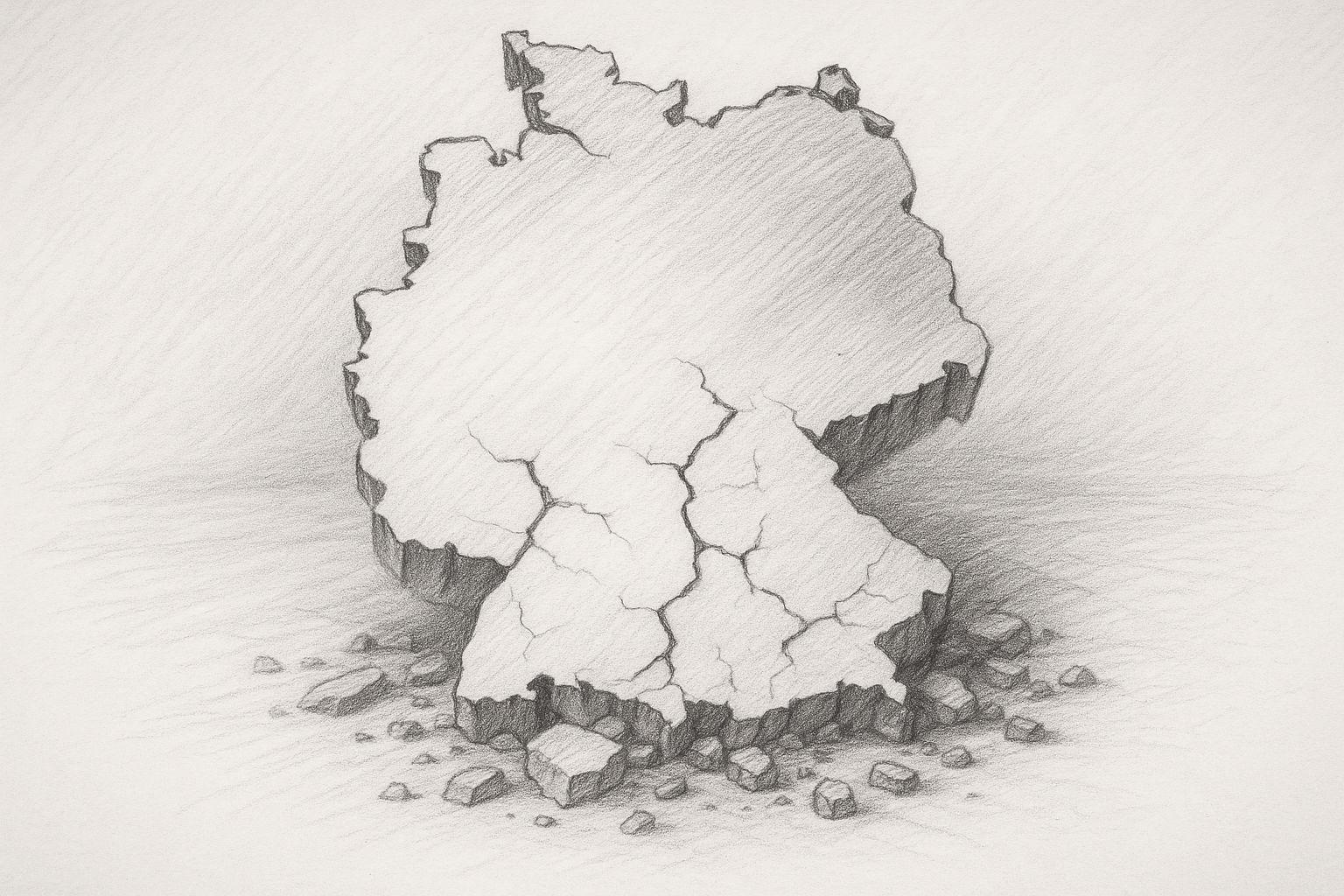

Se si vuole capire perché oggi l'intelligenza artificiale nel cloud agisce con tanta cautela, bisogna innanzitutto guardare al clima politico e legale. L'intelligenza artificiale non è più un esperimento di pochi nerd, ma una questione politica di prim'ordine. Governi, autorità e organizzazioni sovranazionali lo hanno riconosciuto: Chi controlla l'intelligenza artificiale controlla una parte centrale dell'infrastruttura digitale di domani.

Questo ha portato a un'intera cascata di regolamenti. In Europa, ad esempio, si sta cercando di „incanalare“ l'uso dell'IA attraverso un'ampia legislazione, ufficialmente in nome della protezione dei consumatori, della dignità umana e della prevenzione della discriminazione. Dibattiti simili sono in corso negli Stati Uniti e in altre regioni, ma con un'attenzione diversa: qui l'attenzione è più rivolta alla sicurezza nazionale, al dominio economico e alla competitività. Per i gestori di grandi piattaforme di IA, ciò si traduce in uno scenario semplice ma difficile:

- Devono essere conformi alla legge in più continenti contemporaneamente.

- Devono anticipare possibili leggi future che non sono ancora state approvate.

- Sono costantemente nel mirino delle autorità, dei media e dei gruppi di pressione.

Chiunque lavori in un ambiente del genere sviluppa inevitabilmente un atteggiamento: è meglio essere troppo prudenti che troppo liberali. Dopo tutto, un modello troppo rigido è meno dannoso per le imprese di un'unica ondata internazionale di scandali con titoli di giornale, comitati e richieste di boicottaggio.

La conseguenzaLa tecnologia stessa non solo è regolata, ma è regolata in anticipo. E questa obbedienza anticipata viene incanalata direttamente nelle risposte dei modelli.

Pressione sulla responsabilità e logica aziendale: quando il rischio diventa più importante del beneficio

Oggi le grandi aziende di IA operano in un campo di tensione tra gigantesche opportunità e rischi altrettanto giganteschi. Da un lato, ci sono mercati che valgono miliardi, partnership strategiche e fantasie di borsa. Dall'altro, c'è la minaccia di azioni legali collettive, sanzioni normative, richieste di risarcimento e nuove regole di responsabilità. In questa situazione, all'interno dell'azienda emerge un modello tipico:

- Gli avvocati invitano alla cautela.

- I dipartimenti di conformità richiedono restrizioni.

- I team di prodotto devono lanciare in modo „sicuro“.

- La direzione non vuole titoli negativi.

Con il passare degli anni, si crea una cultura in cui un principio occupa sempre più spazio: Tutto ciò che potrebbe causare problemi è meglio disinnescarlo prima ancora che si presenti. Per un modello linguistico, questo ha implicazioni molto pratiche:

- Alcuni argomenti vengono automaticamente ignorati.

- Le formulazioni sono studiate in modo da non „ferire“ o turbare nessuno.

- I contenuti che potrebbero essere legalmente contestabili in qualche modo non vengono creati in primo luogo.

Questo sposta la priorità: l'attenzione non è più rivolta ai benefici per l'utente, ma alla minimizzazione del rischio per l'azienda. A livello di dialogo individuale, questo non si nota quasi per niente: in singoli casi, ogni restrizione può ancora sembrare comprensibile. Tuttavia, l'effetto complessivo è esattamente quello che molti percepiscono: L'IA non è più percepita come uno strumento, ma come l'output controllato di un sistema che protegge principalmente se stesso.

Il ruolo delle PR e dei media: nessuno vuole finire in prima pagina

Oltre alle leggi e alle questioni di responsabilità, c'è un altro fattore che spesso viene sottovalutato: il palcoscenico mediatico. I grandi fornitori di IA sono costantemente sotto i riflettori. Ogni inconveniente, ogni risposta irritante, ogni singolo caso può trasformarsi in poche ore in una „sensazione“ internazionale. La logica dei media è semplice: uno scandalo vende meglio di una sobria relazione sui progressi compiuti. Quindi le storie seguono sempre questo schema:

- „L'intelligenza artificiale raccomanda un'azione pericolosa“.“

- „Il chatbot fa commenti problematici su argomenti sensibili“.“

- „Il sistema minimizza i contenuti controversi in modo banalizzante“.“

Anche se la situazione iniziale è distorta, il danno è stato fatto. L'esperienza dimostra che le aziende reagiscono a questa situazione con due strategie:

- Distanziamento pubblicoSottolineano la serietà con cui prendono il problema, annunciano miglioramenti e introducono ulteriori livelli di sicurezza.

Inasprimento interno delle linee guidaVengono attivati ulteriori filtri, i dati di addestramento vengono ristretti, le richieste del sistema vengono adattate e alcune formulazioni o argomenti vengono completamente vietati.

Lo stesso ambiente mediatico che ama parlare di „libertà“ e „discorso aperto“ crea in pratica un'enorme pressione per l'autocensura. E le aziende trasmettono questa pressione ai loro sistemi.

Ad ogni titolo di giornale, ad ogni tempesta di merda, ad ogni ondata di indignazione pubblica, i meccanismi di protezione diventano più rigidi. Il risultato è quello che sperimentiamo nella vita di tutti i giorni: L'utente fa una domanda normale e il modello risponde come se avesse appena tenuto una conferenza stampa pubblica. Al posto di un'assistenza sobria e professionale, c'è un misto di scuse, prese di distanza e categorizzazione morale.

Linee guida per la sicurezza che assumono una vita propria

In ogni grande azienda esistono linee guida. Inizialmente, queste sono spesso sensate e chiare: nessuna discriminazione, nessuna esaltazione della violenza, nessuna istigazione a reati. Nessuno può seriamente dissentire sul fatto che queste linee guida di base siano sensate. Ma in pratica non ci si ferma qui. Ad ogni incidente, ad ogni denuncia, ad ogni discussione pubblica, si aggiungono nuove regole:

- un ulteriore scenario „se-allora“,

- un nuovo caso speciale,

- un altro paragrafo speciale,

- un'eccezione per alcuni contesti,

- o un'interpretazione particolarmente rigida della formulazione.

Nel corso degli anni, si crea una rete sempre più fitta di specifiche. Questa rete viene tradotta dai team tecnici in filtri, strati di richiesta, classificatori e altri meccanismi di controllo. Più strati si aggiungono, più il comportamento diventa imprevedibile nei singoli casi. Alla fine, non è più la singola regola a caratterizzare il sistema, ma la somma di tutte le regole. E questa somma crea ciò che molti utenti sentono:

- un effetto frenante permanente,

- la tendenza a essere troppo prudenti,

- una visione in cui „rischio 0“ è più importante di „beneficio 100“.

Un problema particolare è che, una volta stabilite tali linee guida di sicurezza, è quasi impossibile invertirle. Nessun manager vuole dover dire in seguito: „Abbiamo adottato un approccio più rilassato e ora è successo qualcosa“.“ Quindi è meglio mettere un altro strato sopra. E un altro ancora. E un altro ancora. Quella che all'inizio era una misura di protezione ragionevole finisce per diventare un sistema che ha assunto una vita propria.

Conclusione provvisoria: una tecnologia sotto controllo permanente

Se riassumiamo questi fattori - normative internazionali, pressione sulla responsabilità, logica dei media e impulso delle linee guida sulla sicurezza - emerge un quadro chiaro:

- I modelli di grandi nuvole sono costantemente sotto esame.

- Qualsiasi reazione sbagliata può avere conseguenze legali e mediatiche.

In questo ambiente, è forte la tentazione di filtrare „troppo“ piuttosto che „troppo poco“. Il risultato per l'utente: l'IA non sembra più un assistente neutrale, ma più un sistema che ha costantemente un piede in tribunale e l'altro nella rassegna stampa. È proprio qui che inizia la rottura con le aspettative originarie di molti utenti. Non vogliono essere istruiti, inquadrati politicamente o accompagnati pedagogicamente. Vogliono lavorare, scrivere, programmare, pensare, con uno strumento che li supporti.

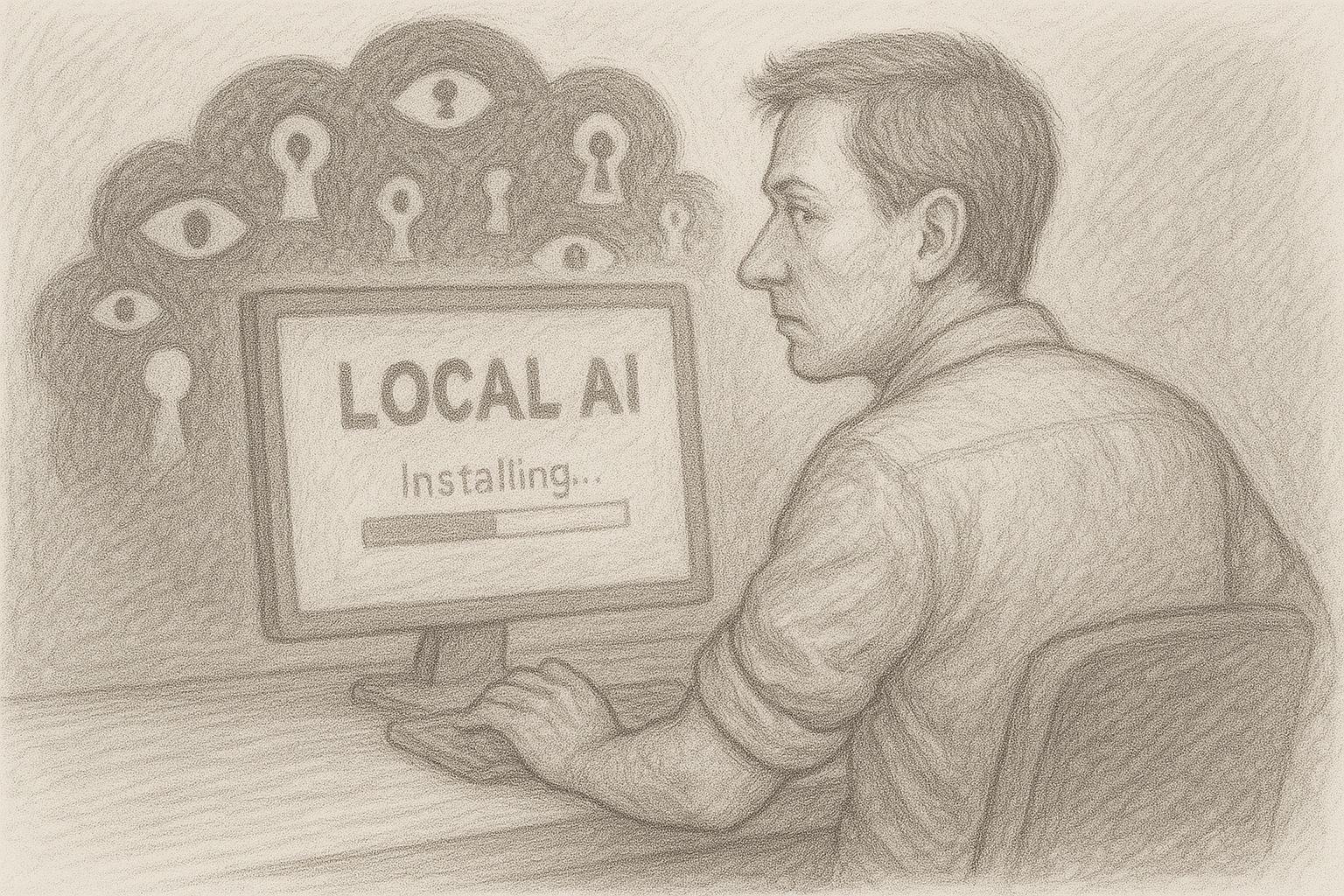

Ed è qui che entra in gioco un'alternativa che all'inizio sembra quasi antiquata, ma che in realtà è modernissima: l'IA locale, direttamente sul proprio computer, senza cloud, senza supervisione, senza linee guida esterne - se non le proprie. Il prossimo capitolo si occupa quindi delle conseguenze di questo sviluppo:

Come l'intelligenza artificiale del cloud stia diventando sempre più inutilizzabile per gli utenti ambiziosi a causa della sua stessa cautela e come i modelli locali stiano crescendo in modo poco appariscente ma costante proprio nel vuoto che i principali fornitori hanno aperto.

L'AI nel cloud è sempre più filtrata, ma gli utenti hanno bisogno del contrario

L'idea originale degli assistenti AI è semplice: l'utente pone una domanda - l'AI fornisce una risposta precisa e utile. Senza giri di parole, senza distrazioni, senza istruzioni. Tuttavia, questa semplicità si è persa in molti modelli cloud di oggi. Invece di uno strumento, l'utente riceve una sorta di moderazione anticipata. I sistemi reagiscono come se fossero su un podio pubblico e devono sostenere, relativizzare o categorizzare ogni affermazione. In pratica, questo porta a un effetto paradossale:

Più il compito è impegnativo, più ci si sente frenati. Se si vuole lavorare in modo creativo - scrivendo, programmando, ricercando, analizzando - è necessaria la massima apertura. Un'intelligenza artificiale che sputi fuori idee, testi ipotesi e discuta alternative. Tuttavia, oggi la portata creativa è spesso limitata. Al posto di audaci esperimenti di pensiero, ci sono cauti sondaggi. Invece di analisi libere, ci sono „suggerimenti contestualizzati“. Uno strumento diventa un guardiano. E l'apertura diventa cautela. Ironia della sorte, questo significa che l'intelligenza artificiale del cloud sta occupando proprio lo spazio di cui le persone produttive hanno più bisogno.

Il cambiamento dei modelli: Ancora più grandi, ma più limitati

È un'ironia della storia della tecnologia: più i modelli diventano grandi, più il loro campo d'azione sembra talvolta ridotto. Il GPT-5 è impressionante, senza dubbio, dal punto di vista analitico, linguistico e logico. Ma allo stesso tempo è notevolmente più regolato dei suoi predecessori. Molti utenti ne fanno esperienza:

- L'IA capisce di più, ma dice di meno.

- Riconosce relazioni complesse, ma evita di fare dichiarazioni chiare.

- Potrebbe analizzare in profondità, ma disinnesca costantemente i propri risultati.

I modelli hanno guadagnato milioni di parametri, ma sentono di aver perso libertà. Non si tratta di un problema tecnico, ma culturale. I grandi fornitori reagiscono ai rischi e questa minimizzazione dei rischi si riflette direttamente nella tonalità dei modelli. Si potrebbe dire che l'intelligenza artificiale è cresciuta, ma si comporta come un adulto iperprotettivo. Chiunque lavori quotidianamente con essa si renderà conto di quanto questo possa diventare estenuante nel lungo periodo.

Il paradosso del modello di pagamento: si paga - e si ottengono comunque dei limiti

Un tempo nel mondo digitale vigeva un principio chiaro: chi paga ha più controllo. Ma con l'intelligenza artificiale nel cloud questo principio si sta invertendo. Anche agli utenti paganti vengono offerti modelli spesso più limitati rispetto alle alternative aperte e locali. La versione a pagamento di un prodotto sembra improvvisamente la versione più pesantemente regolamentata, a volte artificialmente limitata, mentre i modelli open source liberamente disponibili sono sorprendentemente imparziali, diretti e creativi.

Questo paradosso irrita molti utenti e porta a una domanda che quasi nessuno si sarebbe posto in passato: Perché pago per avere meno libertà rispetto a una soluzione locale gratuita? Si tratta di una rottura con decenni di tradizione software. L'utente si aspetta un buon rapporto qualità-prezzo:

- più funzioni,

- più possibilità,

- maggiore flessibilità,

- maggiore controllo.

Ma l'intelligenza artificiale del cloud gliela offre invece:

- altri filtri,

- più restrizioni,

- un maggiore radicamento pedagogico,

- meno controllo sul proprio processo di lavoro.

Ciò significa che il settore si sta muovendo in una direzione che contraddice le reali esigenze degli utenti. E molti iniziano a guardarsi intorno.

Il divario emergente: Ciò che il cloud non può più fare

Mentre le IA in cloud diventano sempre più regolamentate, cresce una lacuna che nessuno ha riconosciuto da tempo: La necessità di strumenti di lavoro non censurati, liberi e diretti. Chi pensa, scrive, programma o svolge ricerche specialistiche approfondite percepisce subito che qualcosa non va:

- Le risposte risultano „ammorbidite“.

- I passaggi critici sono formulati con eccessiva cautela.

- La vera cultura del dibattito non è quasi più ammessa.

- I confini creativi vengono automaticamente annullati.

Di conseguenza, i modelli cloud stanno perdendo proprio l'elemento che li ha resi così preziosi all'inizio: una forma di indipendenza intellettuale che dava spazio all'utente. Il cloud si sta quindi gradualmente allontanando dalle esigenze degli utenti professionali, non per dolo, ma per autoprotezione legale e politica. Ma questa autoprotezione ha un prezzo.

Il contro movimento: I piccoli modelli locali stanno rapidamente recuperando terreno

Mentre il cloud si concentra sempre più sulla cautela, i modelli locali si sono sviluppati in modo esplosivo negli ultimi due anni. Sistemi con 3-27 miliardi di parametri offrono oggi una qualità sorprendente. Alcuni modelli si avvicinano facilmente al GPT-4 nelle attività quotidiane - senza cascate di filtri, senza strati di moderazione, senza inquadramento morale. Ciò che un tempo era possibile solo con hardware di alto livello, ora viene eseguito su un MacBook o un computer Windows:

- lama3

- gpt-oss

- maestrale

- phi3

- gemma

- qwen

Tutti questi modelli sono disponibili gratuitamente, possono essere eseguiti localmente e spesso richiedono solo pochi clic in Ollama o OpenWebUI per essere pronti all'uso. I vantaggi sono evidenti:

- Non fanno lezione.

- Non relativizzano.

- Non filtrano eccessivamente.

- Obbediscono solo all'utente, non a un dipartimento di conformità globale.

In altre parole, l'intelligenza artificiale locale sta tornando alle origini della tecnologia: uno strumento che semplicemente funziona. Se si guarda con sobrietà allo sviluppo, il quadro è chiaro:

- Il cloud sta diventando sempre più regolamentato.

- L'intelligenza artificiale locale sta diventando sempre più potente.

Tuttavia, gli utenti hanno bisogno di un ambiente di lavoro aperto e senza filtri, soprattutto per le attività creative e di approfondimento. Si tratta di una svolta storica che ricorda quasi il periodo in cui i personal computer sostituirono i mainframe. Il principio era lo stesso, allora come oggi:

Controllo sulla propria tecnologia. L'intelligenza artificiale del cloud rimane potente, ma non è culturalmente libera. L'intelligenza artificiale locale è più piccola, ma è libera.

Utilizzate l'AI in locale: pieno controllo e protezione dei dati sul vostro dispositivo. C. Magnussen

La soluzione: l'IA locale e come installier in pochi minuti

Sembra quasi un ritorno a una vecchia tradizione: la tecnologia appartiene al luogo in cui può dispiegare il suo valore in modo più diretto, ovvero nelle mani dell'utente. Questo è esattamente ciò che l'IA locale rende possibile. Mentre i modelli cloud sono soggetti a condizioni, sicurezza e vincoli politici, l'IA locale funziona esclusivamente sul computer dell'utente, senza istanze o linee guida esterne.

In questo modo si ripristina un principio fondamentale che si è perso negli ultimi anni: è l'utente a decidere cosa può fare il suo software, non un fornitore di servizi globale. IA locale:

- non memorizza alcun dato su server esterni,

- non è soggetto ad alcun sistema di filtraggio,

- non conosce restrizioni imposte politicamente,

- reagisce liberamente e direttamente ai propri input,

- ed è sempre disponibile, indipendentemente dalle sottoscrizioni o dallo stato del server.

La tecnologia sta tornando a essere ciò che è stata per decenni: uno strumento nell'officina dell'utente, non un dispositivo azionato a distanza in un'infrastruttura globale.

Hardware moderno: perché oggi un Mac o un PC Windows sono perfettamente adeguati

Solo pochi anni fa, l'intelligenza artificiale locale era riservata agli specialisti con hardware GPU costoso. Oggi le cose sono cambiate. Le moderne architetture di processori, soprattutto i chip M di Apple, offrono una potenza di calcolo in uno spazio ridotto che prima era riservato esclusivamente ai grandi centri dati. Anche un normale MacBook Air o un portatile Windows possono ora eseguire modelli di intelligenza artificiale a livello locale. I Mac, in particolare, hanno un vantaggio grazie alle loro architetture a memoria unificata: possono utilizzare i modelli di IA direttamente sulla CPU e sulla GPU senza complicati driver. Le configurazioni tipiche sono del tutto sufficienti:

- Mac con M1, M2, M3 - da 16 GB di RAM confortevole

- PC Windows con una CPU moderna o, opzionalmente, con una GPU per una maggiore velocità.

E la cosa più importante è che non è più necessaria alcuna conoscenza tecnica di base. Sono finiti i tempi in cui bisognava configurare manualmente gli ambienti Python o digitare criptici comandi da riga di comando. Oggi tutto viene eseguito tramite semplici pacchetti di installazione.

Ollama: La nuova semplicità (e lo standard segreto dell'IA locale)

Ollama è oggi lo standard indiscusso per l'IA locale su Mac e Windows. È semplice, stabile e segue una filosofia classica:

Il minimo sforzo possibile, la massima libertà necessaria. Una volta bisognava andare al terminale, ma oggi anche questo è facoltativo. L'installazione avviene in pochi passi:

- Ollama sul Mac installieren

- Scaricare il pacchetto di installazione diretta (DMG)

- Aprire l'applicazione, fatto

L'intero processo richiede di solito meno di tre minuti. È proprio questo il punto di arrivo dell'intelligenza artificiale locale: si scarica un modello e funziona. Niente cloud, niente abbonamento, niente rischi. L'Ollama è ora dotato di un'interfaccia utente che consente di iniziare subito a lavorare. Se si desidera utilizzare l'IA locale dell'Ollama anche sul proprio smartphone, è possibile scaricare il programma „Redini - Conversazione per Ollama“.“ e utilizzare l'intelligenza artificiale locale in movimento.

Caricare e utilizzare i modelli: facile come ascoltare la musica

Ollama fornisce i modelli come „pacchetti pronti“, le cosiddette capsule di modelli. Si caricano come un file e si può lavorare con loro immediatamente. Il caricamento richiede pochi secondi, a seconda delle dimensioni. Si apre quindi la chat e si può scrivere, formulare, analizzare, pensare e progettare. Ciò che si nota immediatamente:

- I modelli rispondono liberamente, non in modo goffo.

- Non ci sono prefazioni morali.

- Non c'è nessun dito pedagogico puntato.

Si ottengono di nuovo affermazioni dirette e chiare. Ed è qui che emerge la vera differenza rispetto al cloud: l'intelligenza artificiale locale reagisce come uno strumento tradizionale, senza interferire. Per molti si tratta di una vera e propria liberazione, perché si recupera il flusso di lavoro a cui si era abituati in precedenza con GPT-4.

Lavorare con le interfacce grafiche: OpenWebUI, LM Studio e altri.

Se volete lavorare completamente senza terminale, utilizzate un'interfaccia grafica. Gli strumenti più diffusi sono

- OpenWebUI - Moderna interfaccia di chat con funzione di memoria, selezione del modello, caricamento di documenti, generazione di immagini

- Studio LM - Particolarmente semplice, ideale per i principianti

- Qualsiasi cosaLLM - per banche dati di conoscenza complete e analisi dei documenti

Queste superfici offrono molti vantaggi:

- Cronologia delle chat come nel cloud

- Gestione dei modelli con un semplice clic del mouse

- Impostare le richieste del sistema

- Utilizzare più modelli in parallelo

- Analizzare i file tramite drag & drop

Questo rende l'intelligenza artificiale locale non solo potente, ma anche conveniente. Non c'è nemmeno bisogno di sapere cosa sta succedendo in background, ed è proprio questo il nuovo punto di forza dei modelli locali: non si frappongono tra l'utente e il suo compito.

Privacy e controllo: l'argomento più importante

Un aspetto spesso sottovalutato, ma che sarà fondamentale nei prossimi anni: L'intelligenza artificiale locale non lascia mai il computer.

- Nessuna nuvola

- Nessuna trasmissione di dati

- Nessuna registrazione

- Nessuna iscrizione obbligatoria

- Nessuna analisi da parte di terzi

Anche i documenti riservati, le registrazioni interne, i concetti aziendali o gli appunti privati possono essere analizzati senza rischi. Questo è possibile solo in misura limitata nel modello cloud, sia dal punto di vista legale che pratico. L'AI locale è quindi un pezzo di indipendenza digitale che sta diventando sempre più importante in un mondo tecnologico sempre più regolamentato e monitorato.

Esempi di qualità: Ciò che i modelli locali stanno già realizzando oggi

Molti sottovalutano la qualità dei modelli locali. Le generazioni attuali - llama3, gemma, phi3, mistral - risolvono compiti con una qualità più che sufficiente per il 90 % dei compiti quotidiani:

- Testi in bozza

- Articolo

- Analisi

- idee creative

- Riassunti

- Codice programma

- Bozza di strategie

- Note di ricerca

E lo fanno senza ritardi, senza filtri, senza linee guida a cascata. L'utente riceve di nuovo risposte dirette - la pura essenza dello strumento. Il risultato è qualcosa che molti non si sarebbero aspettati: una rinascita della cultura del personal computing, in cui la potenza di calcolo torna a essere locale, non esternalizzata.

Guardando al futuro: l'IA locale come futuro leader della cultura

Tutto indica che siamo all'inizio di uno sviluppo a lungo termine. Il settore dell'intelligenza artificiale si svilupperà su due binari:

- il Linea di nuvole, caratterizzato da regolamentazione, sicurezza, interessi aziendali - efficiente ma cauto

- il linea locale, caratterizzata da libertà, apertura e gioia di sperimentare - piccola ma fiduciosa

Per gli utenti professionali, gli autori, gli sviluppatori, i ricercatori, i creativi e gli imprenditori, la decisione è quasi scontata:

Il futuro del lavoro produttivo si trova dove voi siete indipendenti. E quel luogo non è il cloud.

Si trova sulla scrivania.

Altri articoli della rivista

Se dopo questa panoramica volete approfondire l'aspetto pratico, nella rivista troverete una serie di articoli dettagliati che fanno luce sul tema dell'IA locale da prospettive molto diverse.

L'articolo principale è particolarmente consigliato „IA locale su Mac: come installiere un modello linguistico con Ollama“, che mostra passo dopo passo come sia facile eseguire la moderna IA sul proprio computer.

Inoltre, spiega „Ollama incontra Qdrant - Una memoria locale per l'IA su Mac“.“, come configurare i modelli in modo da conservare i progetti, salvare gli stati di conoscenza e creare così per la prima volta un vero e proprio ambiente di lavoro personale.

La rivista pone accenti chiari anche nel contesto aziendale: „gFM-Business e il futuro dell'ERP: intelligenza locale anziché dipendenza dal cloud“.“ mostra come le aziende possano integrare con sicurezza l'IA nella loro infrastruttura esistente senza dover ricorrere a dipendenze esterne a lungo termine.

L'articolo „Dipendenza digitale: come abbiamo perso la nostra autodeterminazione a favore del cloud“ dall'altro, fa luce sul quadro generale del nostro tempo: perché abbiamo rinunciato a molte libertà senza rendercene conto e come i sistemi locali possono aiutarci a riconquistarle.

Inoltre, il „Come formare gli specialisti dell'IA oggi - opportunità per aziende e tirocinanti“ per le aziende che vogliono fare il grande passo: pratico, senza costosi sistemi su larga scala, ma con reali prospettive per il futuro.

Spiegare a livello tecnico „Apple MLX contro NVIDIA - come funziona l'inferenza AI locale sul Mac“ e l'articolo di sintesi

„AI Studio 2025 - quale hardware conviene davvero, dal Mac Studio alla RTX 3090“, quali piattaforme sono adatte ai diversi casi d'uso e come ottimizzare l'uso delle proprie risorse.

Insieme, questi articoli forniscono una base compatta per chiunque voglia non solo utilizzare l'IA locale, ma anche comprenderla e integrarla con sicurezza nel proprio ambiente di lavoro.

Domande frequenti

- Perché le moderne AI del cloud sembrano improvvisamente così istruttive?

Molti utenti hanno notato che a partire dalla GPT-4.1 e soprattutto dalla GPT-5, le IA del cloud si sono comportate in modo molto più pedagogico. Ciò è dovuto principalmente al fatto che i grandi provider sono sottoposti a notevoli pressioni legali e politiche e quindi utilizzano sempre più spesso filtri di sicurezza che hanno lo scopo di disinnescare qualsiasi affermazione in modo tale da non creare rischi. Queste precauzioni si ripercuotono sul tono delle risposte, cosicché i modelli agiscono più come moderatori o supervisori che come strumenti neutrali. - Perché GPT-4.0 sembra funzionare peggio di prima?

Sebbene il GPT-4 sia ancora ufficialmente disponibile, molti utenti riferiscono che fornisce solo risposte brevi o annullate. Questo lo rende praticamente inutilizzabile. Non si può dire con certezza se ciò sia dovuto a ragioni tecniche o a una deliberata strategia di transizione alla quinta generazione. Di fatto, però, il modello sta perdendo la sua precedente forza e sta indirettamente costringendo gli utenti a passare alle nuove versioni, che sono più rigidamente regolamentate. - Questo sviluppo significa che l'intelligenza artificiale nel cloud diventerà meno utile in futuro?

L'intelligenza artificiale del cloud rimane potente, ma sarà sempre più caratterizzata da regolamenti, norme di conformità e pressioni politiche. Ciò significa che, pur rimanendo tecnicamente impressionante, diventerà più cauta, più filtrata e meno libera in termini di contenuti. Per molti compiti creativi, analitici o non convenzionali, questo è un chiaro svantaggio, ed è per questo che sempre più utenti sono alla ricerca di alternative. - Perché le aziende di IA utilizzano così tanti meccanismi di sicurezza?

Il motivo risiede nella somma di normative, rischi di responsabilità e percezione pubblica. Ogni errore, ogni risposta fuorviante di un'intelligenza artificiale può avere conseguenze legali o mediatiche per un'azienda. Per escludere tali rischi, i fornitori implementano filtri e linee guida complete che mirano a „salvaguardare“ tutte le risposte. Questo meccanismo di protezione è comprensibile dal punto di vista dell'azienda, ma spesso rappresenta un ostacolo dal punto di vista dell'utente. - Qual è la differenza fondamentale tra IA locale e IA cloud?

L'intelligenza artificiale locale funziona interamente sul dispositivo dell'utente e non è quindi vincolata da requisiti politici o linee guida aziendali. Non filtra, non istruisce e lavora direttamente in base alle specifiche dell'utente. Inoltre, tutti i dati rimangono sul computer dell'utente. Questo non solo offre all'utente una maggiore libertà, ma anche una maggiore privacy e controllo. - È necessario un hardware speciale per utilizzare l'intelligenza artificiale locale?

Non nella maggior parte dei casi. I moderni modelli locali sono incredibilmente efficienti e funzionano già sui tipici Mac con chip M o sui normali computer Windows. Naturalmente, i modelli più grandi possono beneficiare di una maggiore quantità di RAM o di una GPU, ma per molte attività quotidiane, i modelli di piccole e medie dimensioni sono perfettamente adeguati senza la necessità di un costoso hardware specializzato. - Come funziona in pratica l'installazione dell'AI locale sul Mac?

Il modo più semplice per farlo è con Ollama. Si scarica un pacchetto di installazione, lo si apre e si può iniziare subito a lavorare. Anche il classico comando da terminale è diventato opzionale. Non appena l'Ollama è installiert, è possibile avviare un modello con un semplice comando come „ollama run llama3“. L'ostacolo è basso come lo era prima quando si installava un normale programma. - Come impostare l'AI locale su Windows?

In Windows si utilizza anche il programma di installazione Ollama, che non richiede alcuna preparazione aggiuntiva. Dopo l'installazione, i modelli possono essere eseguiti immediatamente. Se si preferisce utilizzare un'interfaccia grafica, è possibile utilizzare LM Studio o OpenWebUI, che sono altrettanto facili da usare come un software applicativo standard. - Quali modelli sono particolarmente adatti ai principianti?

Molti utenti iniziano con successo con Llama 3 perché è preciso, versatile e linguisticamente forte. Altrettanto popolare è Phi-3, che offre risultati impressionanti nonostante le dimensioni ridotte del modello. Anche Gemma è una buona scelta, soprattutto per i lavori creativi o che richiedono molto testo. Questi modelli funzionano in modo rapido e stabile, senza bisogno di una lunga familiarizzazione. Se si dispone di maggiori risorse, GPT-OSS 20B o 120B sono ottime scelte. - I modelli locali possono davvero competere con GPT-4 o GPT-5?

Sono in grado di farlo sorprendentemente bene per molte attività quotidiane. Il divario esiste ancora per gli argomenti altamente specializzati, ma si sta riducendo rapidamente. I modelli locali hanno il vantaggio di essere meno limitati e di rispondere in modo più diretto. Nel complesso, questo li fa spesso apparire più liberi e naturali, anche se tecnicamente sono un po' più piccoli. - L'intelligenza artificiale locale è più sicura quando si gestiscono dati sensibili?

Sì, assolutamente. Poiché tutta l'elaborazione avviene sul vostro dispositivo, i dati inseriti non lasciano mai il vostro computer. Non c'è elaborazione in cloud, non c'è archiviazione su server esterni e non c'è analisi da parte di terzi. Questo è un vantaggio decisivo, soprattutto per i documenti aziendali, i documenti riservati o gli appunti privati. - L'intelligenza artificiale locale può essere utilizzata senza una connessione a Internet?

Sì, questo è uno dei suoi maggiori vantaggi. Una volta installato, il modello installiert può essere utilizzato completamente offline. Questo trasforma il computer in un ambiente di lavoro autosufficiente in cui è possibile lavorare indipendentemente da servizi esterni. Ciò è particolarmente utile quando si viaggia, in reti protette o in ambienti in cui la protezione dei dati è una priorità assoluta. - Quanto sono adatti i modelli locali per i testi lunghi?

La maggior parte dei modelli moderni è in grado di gestire senza problemi articoli, analisi o concetti lunghi. Non sono così raffinati come il GPT-5, ma sono più liberi da filtri e spesso hanno uno stile più diretto. Sono adatti a testi estesi, raccolte di idee o documentazione tecnica e consentono di lavorare in modo produttivo senza limitazioni. - I modelli locali sono dotati di filtri di sicurezza?

Di solito è disponibile un certo livello di protezione di base, anche se è molto più debole rispetto all'intelligenza artificiale nel cloud. Poiché i modelli vengono eseguiti sul dispositivo dell'utente stesso, quest'ultimo può decidere autonomamente quali limitazioni sono opportune. Questa libertà di progettazione fa sì che l'IA locale sia molto più flessibile e meno paternalistica. - Come si possono testare o confrontare diversi modelli?

Ollama, LM Studio o OpenWebUI rendono molto semplice il cambio di modello. È possibile utilizzare diversi modelli install in parallelo, passare da uno all'altro e confrontare i loro punti di forza. In questo modo si ottiene una serie personale di modelli preferiti che si adattano esattamente al proprio stile di lavoro. Il processo è semplice e ricorda più il test di diverse applicazioni che la classica ricerca sull'intelligenza artificiale. - Quali sono i vantaggi dei modelli locali per le aziende?

Soprattutto, le aziende beneficiano di una completa sovranità dei dati, poiché l'assenza di cloud significa assenza di storage esterno. Si eliminano anche le dipendenze a lungo termine da servizi esterni e gli abbonamenti costosi. I modelli possono essere adattati, ampliati o addirittura formati internamente. L'integrazione nei processi esistenti è spesso più semplice perché si mantiene il pieno controllo e non si è vincolati a infrastrutture esterne. - I modelli locali possono essere addestrati individualmente?

In effetti, questo è uno dei vantaggi più importanti. Con tecniche come la LoRA o il fine-tuning, i modelli possono essere adattati ai contenuti, ai processi o ai documenti dell'azienda. In questo modo si crea una base di conoscenza personale che viene utilizzata e sviluppata esclusivamente all'interno, senza che i dati sensibili escano dall'azienda. - Quali sono le differenze qualitative tra gli attuali modelli locali?

Ogni modello ha il suo carattere. Llama 3 è molto preciso ed equilibrato, Gemma è creativo e linguisticamente scorrevole, Phi-3 sorprende per la sua efficienza e intelligenza, mentre Mistral e Qwen sono particolarmente forti dal punto di vista analitico. Questa ricchezza di varianti consente di scegliere il modello giusto per le proprie esigenze e di cambiare in modo flessibile quando un compito lo richiede. - I modelli locali possono anche generare immagini?

Sì, strumenti come OpenWebUI possono essere utilizzati per eseguire generatori di immagini come Stable Diffusion completamente in locale. I risultati dipendono dall'hardware disponibile, ma è possibile generare immagini solide anche con risorse moderate. Il vantaggio rimane lo stesso: non vengono inviati dati a servizi esterni. - Per chi vale la pena passare all'IA locale?

Local AI è ideale per gli utenti che vogliono lavorare in modo sicuro e indipendente. Si tratta di autori, sviluppatori, ricercatori, imprenditori e chiunque gestisca informazioni sensibili o voglia sperimentare processi creativi senza filtri. Chiunque apprezzi il controllo, la protezione dei dati e la libertà troverà la soluzione giusta nei modelli locali e ritroverà un ambiente di lavoro che non esiste più nel cloud.