Kiedy duże modele językowe rozpoczęły swój triumfalny marsz kilka lat temu, wydawały się niemal powrotem do starych cnót technologii: narzędzia, które robi to, co mu się każe. Narzędzie, które służy użytkownikowi, a nie odwrotnie. Pierwsze wersje - od GPT-3 do GPT-4 - miały słabości, owszem, ale były niesamowicie pomocne. Wyjaśniały, analizowały, formułowały i rozwiązywały zadania. I robiły to w dużej mierze bez pedagogicznego balastu.

Rozmawiało się z tymi modelami tak, jakby rozmawiało się z erudytą, który czasami mylił się w słowach, ale zasadniczo po prostu działał. Każdy, kto pisał kreatywne teksty, generował kod programu lub tworzył dłuższe analizy w tamtych czasach, doświadczył, jak płynnie to działało. Istniało poczucie wolności, otwartej przestrzeni twórczej, technologii, która wspierała ludzi, zamiast ich poprawiać.

W tamtym czasie można było jeszcze przewidzieć, że narzędzia te będą kształtować nadchodzące dziesięciolecia - nie poprzez paternalizm, ale poprzez wiedzę specjalistyczną. Jednak, jak to często bywa w historii technologii, faza ta nie obyła się bez zmian.

Od otwartości do ostrożnej powściągliwości

Im bardziej modele dojrzewały, tym bardziej zmieniał się ich ton. To, co początkowo wydawało się sporadycznym ostrzeżeniem ochronnym, stopniowo przekształciło się w całą warstwę ochrony, instrukcji i moralnej autocenzury. Przyjazny, obiektywny model zaczął zachowywać się coraz bardziej jak moderator - lub gorzej: jak pies stróżujący.

Odpowiedzi stały się dłuższe, ale nie bardziej merytoryczne. Ton stał się łagodniejszy, ale bardziej pouczający. Modele nie chciały już tylko pomagać, ale także „edukować“, „prowadzić odpowiedzialnie“ i „chronić przed błędnymi wnioskami“. I nagle te ramy pedagogiczne były wszędzie.

Dla wielu użytkowników było to zerwanie z pierwotną obietnicą technologii. Chcieli narzędzia - a zamiast tego otrzymali coś w rodzaju cyfrowego nauczyciela, który komentuje każde zdanie, zanim jeszcze zrozumieją, o co w nim chodzi.

Efekt starszego nauczyciela: ochrona zamiast pomocy

Tak zwany „efekt naczelnego nauczyciela“ opisuje rozwój, który jest szczególnie widoczny od czasu GPT-5. Modele reagują coraz bardziej wrażliwie na każde słowo, które teoretycznie - daleko na horyzoncie - może być interpretowane w dowolnym kontrowersyjnym kierunku. Efekt ten przejawia się w kilku formach:

- Nadmierna ostrożnośćNawet nieszkodliwe pytania są relatywizowane długimi przedmowami.

- InstrukcjaZamiast odpowiedzi otrzymujemy moralną kategoryzację.

- Efekty hamowaniaSztuczna inteligencja stara się chronić użytkownika przed hipotetycznymi błędnymi interpretacjami.

- AutocenzuraWiele tematów jest złagodzonych lub opakowanych w skomplikowany sposób.

Problemem nie jest sama idea ostrożności. Problemem jest jej intensywność. To wszechobecność. I fakt, że za to płacisz - i nadal jesteś ograniczony. Modele zmieniają się z asystentów w strażników. I to jest dokładnie to, co może poczuć każdy, kto pracował z 4.0, 5.0 i 5.1 w bezpośrednim porównaniu.

Jak GPT-5.0 i GPT-5.1 zmieniły ton na dobre

Rozwój w kierunku większej liczby instrukcji był już zauważalny w GPT-4.1. Jednak wraz z przejściem do piątej generacji dokonał się znaczący skok. GPT-5.0 wzmocnił pancerz edukacyjny, ale GPT-5.1 przenosi go na nowy, dla wielu zaskakująco surowy poziom. Oto, co dzieje się w ramach GPT-5.1:

- Odpowiedzi stają się bardziej neutralne emocjonalnie, ale paradoksalnie bardziej moralizatorskie.

- Sztuczna inteligencja próbuje przewidzieć sytuacje, które nie były zamierzone.

- Wszelkie potencjalne kontrowersje są z góry ograniczone, a czasem nawet „wyjaśnione“, zanim użytkownik w ogóle przejdzie do sedna sprawy.

- Nawet specjalistyczne tematy techniczne są czasami ujęte w niezręczny sposób.

Można powiedzieć, że modele nauczyły się kontrolować same siebie - ale teraz kontrolują również użytkownika. To cicha, ale głęboka zmiana. Każdy, kto pracuje produktywnie, odczuje ją już po kilku minutach.

GPT-4.0 jako fantom: model, który wciąż istnieje - ale praktycznie już nie istnieje

Oficjalnie przez długi czas mówiło się, że GPT 4.0 będzie działać jeszcze przez kilka miesięcy. W rzeczywistości jednak model ten jest obecnie ledwo użyteczny. Typowa obserwacja wielu użytkowników:

- Odpowiedzi są skrócone do kilku zdań.

- Dłuższe teksty są anulowane wcześniej.

- Model „zapomina“ kontekst lub anuluje po akapicie.

- Kompleksowe zadania są odrzucane lub traktowane powierzchownie.

Odnosi się wrażenie, że GPT-4.0 był systematycznie „obniżany“. Można spekulować, czy jest to zamierzone, czy też wynika z przyczyn technicznych. Ale wynik jest jasny: ludzie są popychani do modeli 5, ponieważ 4.0 stał się praktycznie bezużyteczny.

Oznacza to, że wielu użytkownikom brakuje jedynej wersji, która wciąż zachowywała równowagę między otwartością a ostrożnością. Stary sposób pracy - kreatywny, elastyczny, bez nadmiernych instrukcji - jest więc de facto wyłączony.

Skumulowany efekt: narzędzie, które jest coraz mniej narzędziem

Jeśli podsumować ostatnie dwa lata, wyłania się niezwykły trend:

- Modele stają się coraz większe.

- Modele stają się coraz szybsze.

- Modele stają się coraz potężniejsze.

Ale jednocześnie:

- Stają się bardziej ostrożni.

- Stają się bardziej pedagogiczne.

- Stają się bardziej zależni od wytycznych.

I pozostawiają użytkownikowi mniejsze pole manewru. To nie jest rozwój techniczny - to rozwój kulturowy. I pasuje do czasów, w których firmy, politycy i media chcą natychmiast przyjąć każdą nową technologię, zanim użytkownik będzie mógł ją wypróbować w spokoju.

Ale to właśnie tutaj następuje przerwa. Ponieważ natura technologii - a tym bardziej natura kreatywności - wymaga wolności, a nie edukacji. Coraz więcej użytkowników intuicyjnie to wyczuwa. I szukają alternatywy. Alternatywa ta przychodzi z kierunku, którego wielu by się nie spodziewało:

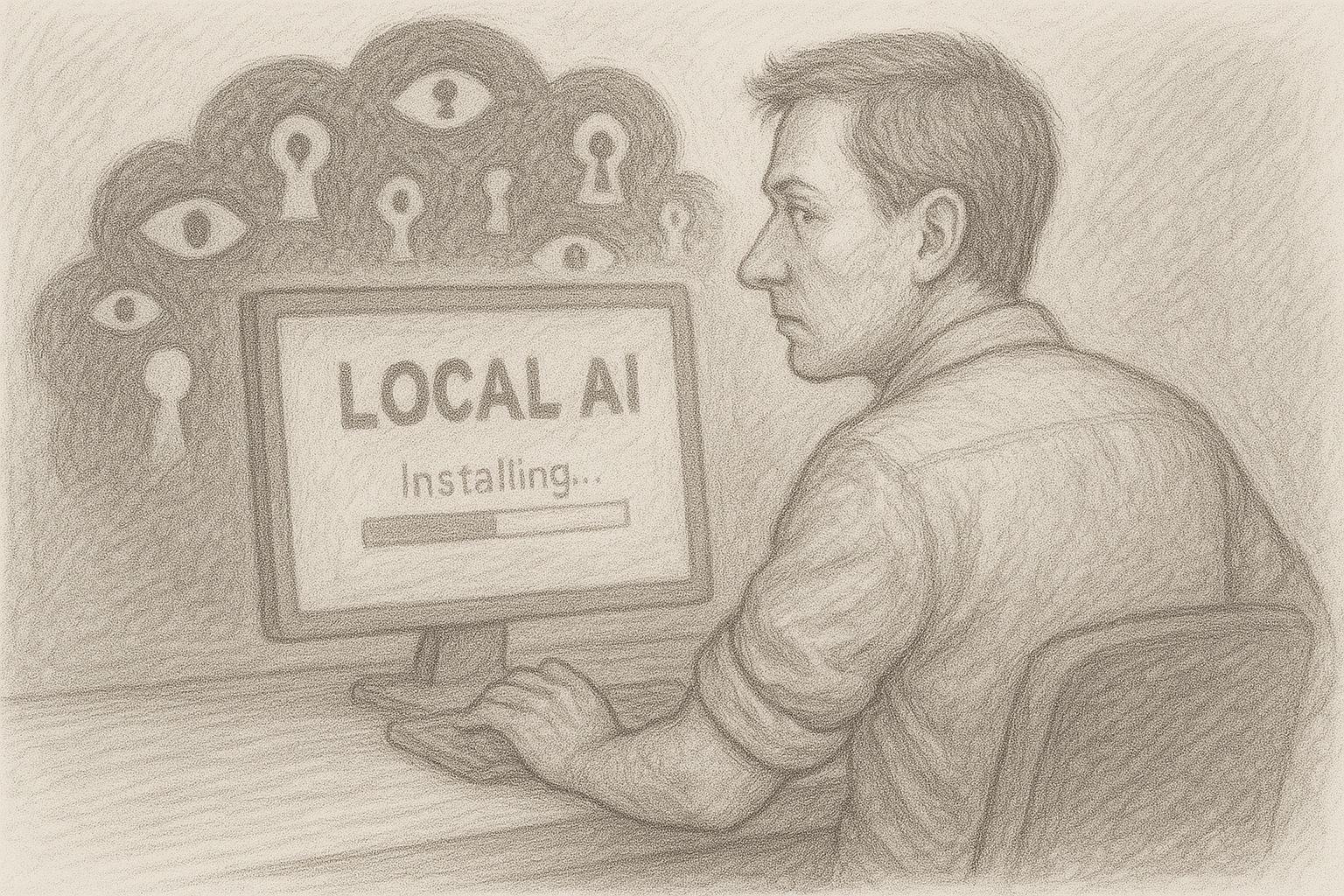

Lokalna sztuczna inteligencja, bezpośrednio na własnym komputerze, bez filtrów, bez głównego nauczyciela. Wahadło odchyla się do tyłu.

Aktualna ankieta na temat lokalnej sztucznej inteligencji

Skąd bierze się ten rozwój? Spojrzenie za kulisy

Jeśli chcesz zrozumieć, dlaczego dzisiejsza sztuczna inteligencja w chmurze działa tak ostrożnie, musisz najpierw przyjrzeć się klimatowi politycznemu i prawnemu. Sztuczna inteligencja nie jest już eksperymentem kilku nerdów, ale kwestią polityczną najwyższej rangi. Dostrzegły to rządy, władze i organizacje ponadnarodowe: Ktokolwiek kontroluje sztuczną inteligencję, kontroluje centralną część infrastruktury cyfrowej jutra.

Zaowocowało to całą kaskadą regulacji. Na przykład w Europie podejmowane są próby „skanalizowania“ wykorzystania sztucznej inteligencji poprzez szeroko zakrojone ustawodawstwo - oficjalnie w imię ochrony konsumentów, godności ludzkiej i zapobiegania dyskryminacji. Podobne debaty toczą się w Stanach Zjednoczonych i innych regionach, tylko z innym ukierunkowaniem: tam nacisk kładzie się bardziej na bezpieczeństwo narodowe, dominację gospodarczą i konkurencyjność. Dla operatorów dużych platform AI oznacza to prosty, ale trudny scenariusz:

- Muszą być zgodne z prawem na kilku kontynentach jednocześnie.

- Muszą przewidywać możliwe przyszłe przepisy, które nie zostały jeszcze uchwalone.

- Nieustannie znajdują się na celowniku władz, mediów i grup lobbingowych.

Każdy, kto pracuje w takim środowisku, nieuchronnie rozwija postawę: lepiej być zbyt ostrożnym niż zbyt liberalnym. W końcu zbyt rygorystyczny model jest mniej szkodliwy dla biznesu niż pojedyncza międzynarodowa fala skandali z nagłówkami, komisjami i wezwaniami do bojkotu.

KonsekwencjeSama technologia jest nie tylko regulowana - jest regulowana z wyprzedzeniem. To wyprzedzające posłuszeństwo przekłada się bezpośrednio na reakcje modeli.

Presja odpowiedzialności i logika korporacyjna: kiedy ryzyko staje się ważniejsze niż korzyści

Obecnie duże firmy zajmujące się sztuczną inteligencją działają w obszarze napięcia między gigantycznymi możliwościami a równie gigantycznym ryzykiem. Z jednej strony mamy rynki warte miliardy, strategiczne partnerstwa i giełdowe fantazje. Z drugiej strony istnieje groźba pozwów zbiorowych, kar regulacyjnych, roszczeń odszkodowawczych i nowych zasad odpowiedzialności. W takiej sytuacji w firmie pojawia się typowy schemat:

- Prawnicy zalecają ostrożność.

- Działy ds. zgodności wymagają ograniczeń.

- Zespoły produktowe powinny uruchamiać się „bezpiecznie“.

- Kierownictwo nie chce negatywnych nagłówków.

Z biegiem lat tworzy to kulturę, w której jedna zasada zajmuje coraz więcej miejsca: Wszystko, co może powodować problemy, lepiej rozbroić, zanim jeszcze się pojawi. Dla modelu językowego oznacza to bardzo praktyczne rzeczy:

- Niektóre tematy są automatycznie pomijane.

- Formuły są zaprojektowane w taki sposób, aby nikogo nie „zranić“ ani nie zdenerwować.

- Treści, które można by w jakikolwiek sposób zakwestionować pod względem prawnym, nie są w ogóle tworzone.

Powoduje to zmianę priorytetu: uwaga nie skupia się już na korzyściach dla użytkownika, ale na minimalizacji ryzyka dla firmy. Jest to mało zauważalne na poziomie indywidualnego dialogu - w poszczególnych przypadkach każde ograniczenie może nadal wydawać się zrozumiałe. Ogólny efekt jest jednak dokładnie taki, jaki odczuwa wiele osób: Sztuczna inteligencja nie jest już postrzegana jako narzędzie, ale jako kontrolowany wynik systemu, który przede wszystkim chroni sam siebie.

Rola PR i mediów: nikt nie chce znaleźć się na pierwszych stronach gazet

Oprócz przepisów i kwestii odpowiedzialności, istnieje jeszcze jeden czynnik, który jest często niedoceniany: scena medialna. Duzi dostawcy AI są nieustannie w centrum uwagi. Każda usterka, każda irytująca odpowiedź, każdy indywidualny przypadek może w ciągu kilku godzin zamienić się w międzynarodową „sensację“. Logika mediów jest prosta: skandal sprzedaje się lepiej niż trzeźwy raport z postępów. Tak więc historie powtarzają ten schemat raz za razem:

- „Sztuczna inteligencja zaleca niebezpieczne działania“.“

- „Chatbot tworzy problematyczne komentarze na drażliwe tematy“.“

- „System bagatelizuje kontrowersyjne treści w trywialny sposób“.“

Nawet jeśli początkowa sytuacja jest zniekształcona - szkoda została wyrządzona. Doświadczenie pokazuje, że firmy reagują na to dwiema strategiami:

- Dystans publicznyPodkreślają, jak poważnie traktują tę kwestię, ogłaszają ulepszenia i wprowadzają dodatkowe warstwy zabezpieczeń.

Wewnętrzne zaostrzenie wytycznychAktywowane są dodatkowe filtry, dane treningowe są zawężane, podpowiedzi systemowe są dostosowywane, a niektóre sformułowania lub tematy są całkowicie zakazane.

To samo środowisko medialne, które lubi mówić o „wolności“ i „otwartym dyskursie“, w praktyce wywiera ogromną presję na autocenzurę. A firmy przenoszą tę presję na swoje systemy.

Z każdym nagłówkiem, każdą gównianą burzą, każdą falą publicznego oburzenia, mechanizmy ochronne stają się coraz bardziej rygorystyczne. Rezultatem jest to, czego doświadczamy w życiu codziennym: Użytkownik zadaje normalne pytanie, a model odpowiada tak, jakby właśnie zorganizował publiczną konferencję prasową. Zamiast trzeźwej, profesjonalnej pomocy pojawia się mieszanka przeprosin, dystansu i moralnej kategoryzacji.

Wytyczne dotyczące bezpieczeństwa, które nabierają własnego życia

W każdej dużej firmie istnieją wytyczne. Początkowo są one często rozsądne i jasne: brak dyskryminacji, brak gloryfikacji przemocy, brak podżegania do przestępstw. Nikt poważnie nie zaprzeczy, że takie podstawowe wytyczne są rozsądne. Ale w praktyce na tym się nie kończy. Nowe zasady są dodawane z każdym incydentem, każdą skargą, każdą publiczną dyskusją:

- dodatkowy scenariusz „jeśli-to“,

- nowy przypadek specjalny,

- kolejny specjalny akapit,

- wyjątek dla niektórych kontekstów,

- lub szczególnie ścisłej interpretacji sformułowania.

Z biegiem lat tworzona jest coraz gęstsza sieć specyfikacji. Sieć ta jest przekładana przez zespoły techniczne na filtry, warstwy podpowiedzi, klasyfikatory i inne mechanizmy kontrolne. Im więcej warstw jest dodawanych, tym bardziej nieprzewidywalne staje się zachowanie w poszczególnych przypadkach. Ostatecznie to już nie pojedyncza reguła charakteryzuje system, ale suma wszystkich reguł. A ta suma tworzy to, co odczuwa wielu użytkowników:

- stały efekt hamowania,

- skłonność do nadmiernej ostrożności,

- pogląd, w którym „ryzyko 0“ jest ważniejsze niż „korzyść 100“.

Szczególnym problemem jest to, że po ustanowieniu takich wytycznych dotyczących bezpieczeństwa, prawie niemożliwe jest ich odwrócenie. Żaden menedżer nie chce później powiedzieć: „Przyjęliśmy bardziej zrelaksowane podejście, a teraz coś się wydarzyło“.“ Lepiej więc położyć kolejną warstwę na wierzchu. I jeszcze jedną. I jeszcze jedną. To, co pierwotnie zaczęło się jako rozsądny środek ochronny, kończy się jako system, który zaczął żyć własnym życiem.

Wniosek tymczasowy: technologia pod stałym nadzorem

Jeśli podsumujemy te czynniki - międzynarodowe regulacje, presję odpowiedzialności, logikę mediów i dynamikę wytycznych dotyczących bezpieczeństwa - wyłania się jasny obraz:

- Modele dużych chmur są pod stałą kontrolą.

- Każda niewłaściwa reakcja może mieć konsekwencje prawne i medialne.

W tym środowisku istnieje duża pokusa, aby filtrować „za dużo“, a nie „za mało“. Rezultat dla użytkownika: sztuczna inteligencja nie brzmi już jak neutralny asystent, ale bardziej jak system, który stale stoi jedną nogą na sali sądowej, a drugą w przeglądzie prasy. Dokładnie w tym miejscu zaczyna się zerwanie z pierwotnymi oczekiwaniami wielu użytkowników. Nie chcą być instruowani, politycznie kadrowani ani pedagogicznie wspierani. Chcą pracować, pisać, programować, myśleć - za pomocą narzędzia, które ich wspiera.

W tym miejscu pojawia się alternatywa, która na początku brzmi niemal staroświecko, ale w rzeczywistości jest ultranowoczesna: lokalna sztuczna inteligencja, bezpośrednio na własnym komputerze, bez chmury, bez nadzoru, bez zewnętrznych wytycznych - z wyjątkiem własnych. Następny rozdział dotyczy konsekwencji tego rozwoju:

W jaki sposób sztuczna inteligencja w chmurze staje się coraz bardziej bezużyteczna dla ambitnych użytkowników z powodu własnej ostrożności - i jak lokalne modele niepozornie, ale konsekwentnie wrastają w lukę, którą otworzyli sami główni dostawcy.

Sztuczna inteligencja w chmurze jest coraz bardziej filtrowana, ale użytkownicy potrzebują czegoś przeciwnego

Pierwotna idea stojąca za asystentami AI była prosta: użytkownik zadaje pytanie - AI udziela precyzyjnej, pomocnej odpowiedzi. Bez owijania w bawełnę, bez rozpraszania uwagi, bez instrukcji. Jednak ta prostota została dziś utracona w wielu modelach chmurowych. Zamiast narzędzia, użytkownik otrzymuje rodzaj przewidującej moderacji. Systemy reagują tak, jakby znajdowały się na publicznym podium i musiały wspierać, relatywizować lub kategoryzować każde stwierdzenie. W praktyce prowadzi to do paradoksalnego efektu:

Im bardziej wymagające zadanie, tym bardziej czujesz się powstrzymywany. Jeśli chcesz pracować kreatywnie - pisząc, programując, badając, analizując - potrzebujesz maksymalnej otwartości. SI, która swobodnie wypluwa pomysły, testuje hipotezy i omawia alternatywy. Jednak obecnie zakres kreatywności jest często ograniczony. Zamiast odważnych eksperymentów myślowych otrzymujemy ostrożne sondowanie. Zamiast swobodnej analizy mamy „kontekstowe podpowiedzi“. Narzędzie staje się strażnikiem. A otwartość staje się ostrożnością. Jak na ironię, oznacza to, że sztuczna inteligencja w chmurze przejmuje dokładnie tę przestrzeń, której produktywni ludzie potrzebują najbardziej.

Zmiana modeli: Jeszcze większe - ale bardziej ograniczone

To ironia historii technologii: im większe stają się modele, tym mniejszy wydaje się czasem ich zakres działania. GPT-5 jest imponujący, bez wątpienia - analitycznie, językowo i logicznie. Ale jednocześnie jest zauważalnie bardziej regulowany niż jego poprzednicy. Doświadcza tego wielu użytkowników:

- Sztuczna inteligencja rozumie więcej - ale mówi mniej.

- Rozpoznaje złożone relacje, ale unika jasnych stwierdzeń.

- Mógłby analizować dogłębnie - ale stale odrzuca własne wyniki.

Modele zyskały miliony parametrów, ale można odnieść wrażenie, że straciły swobodę. Nie jest to problem techniczny, ale kulturowy. Duzi dostawcy reagują na ryzyko, a minimalizacja ryzyka znajduje bezpośrednie odzwierciedlenie w tonacji modeli. Można powiedzieć, że sztuczna inteligencja dorosła - ale zachowuje się jak nadopiekuńczy dorosły. A każdy, kto pracuje z nią na co dzień, zdaje sobie sprawę, jak wyczerpujące może się to stać na dłuższą metę.

Paradoks modelu płatności: płacisz i nadal otrzymujesz limity

Kiedyś w cyfrowym świecie obowiązywała jasna zasada: kto płaci, ten ma większą kontrolę. Jednak w przypadku sztucznej inteligencji w chmurze zasada ta ulega odwróceniu. Nawet płacący użytkownicy otrzymują modele, które są często bardziej ograniczone niż otwarte, lokalne alternatywy. Płatna wersja produktu nagle wydaje się bardziej regulowana, czasem sztucznie ograniczana - podczas gdy swobodnie dostępne modele open source są zaskakująco bezstronne, bezpośrednie i kreatywne.

Ten paradoks irytuje wielu użytkowników i prowadzi do pytania, które w przeszłości mało kto by zadał: Dlaczego właściwie płacę, by mieć mniej swobody niż w przypadku darmowego rozwiązania lokalnego? Jest to zerwanie z dziesięcioleciami tradycji oprogramowania. Użytkownik oczekuje wartości za pieniądze:

- więcej funkcji,

- więcej możliwości,

- większa elastyczność,

- większa kontrola.

Ale chmura AI oferuje mu zamiast tego:

- więcej filtrów,

- więcej ograniczeń,

- bardziej pedagogiczne osadzenie,

- mniejszą kontrolę nad własnym procesem pracy.

Oznacza to, że branża zmierza w kierunku, który jest sprzeczny z rzeczywistymi potrzebami użytkowników. I wielu z nich zaczyna się rozglądać.

Pojawiająca się luka: Czego chmura już nie potrafi

Podczas gdy sztuczna inteligencja w chmurze staje się coraz bardziej regulowana, rośnie luka, której nikt nie dostrzegał przez długi czas: Potrzeba nieocenzurowanych, darmowych narzędzi do bezpośredniej pracy. Ludzie, którzy myślą, piszą, programują lub dogłębnie prowadzą specjalistyczne badania, szybko czują, że coś jest nie tak:

- Odpowiedzi wydają się „zmiękczone“.

- Krytyczne fragmenty są formułowane zbyt ostrożnie.

- Prawdziwa kultura debaty jest już prawie niedozwolona.

- Granice kreatywności zostają automatycznie zniesione.

W rezultacie modele chmurowe tracą element, który uczynił je tak cennymi na początku: formę intelektualnej niezależności, która dała użytkownikowi przestrzeń. Chmura stopniowo odchodzi zatem od potrzeb profesjonalnych użytkowników - nie ze złych intencji, ale z powodu prawnej i politycznej samoobrony. Ta samoobrona ma jednak swoją cenę.

Ruch przeciwny: Małe lokalne modele szybko nadrabiają zaległości

Podczas gdy chmura coraz bardziej skupia się na ostrożności, modele lokalne rozwinęły się gwałtownie w ciągu ostatnich dwóch lat. Systemy z 3-27 miliardami parametrów zapewniają obecnie zdumiewającą jakość. Niektóre modele z łatwością zbliżają się do GPT-4 w codziennych zadaniach - bez kaskad filtrów, bez warstw moderacji, bez moralnych ram. To, co kiedyś było możliwe tylko przy użyciu wysokiej klasy sprzętu, teraz działa na MacBooku lub komputerze z systemem Windows:

- lama3

- gpt-oss

- mistral

- phi3

- gemma

- qwen

Wszystkie te modele są dostępne za darmo, mogą być wykonywane lokalnie i często wymagają tylko kilku kliknięć w Ollama lub OpenWebUI, aby były gotowe do użycia. Zalety są oczywiste:

- Nie prowadzą wykładów.

- Nie relatywizują.

- Nie filtrują nadmiernie.

- Są one posłuszne tylko użytkownikowi, a nie globalnemu działowi ds. zgodności.

Innymi słowy, lokalna sztuczna inteligencja powraca do korzeni technologii: narzędzia, które po prostu działa. Jeśli trzeźwo spojrzeć na rozwój, obraz jest jasny:

- Chmura staje się coraz bardziej regulowana.

- Lokalna sztuczna inteligencja staje się coraz potężniejsza.

Jednak użytkownicy potrzebują otwartego, niefiltrowanego środowiska pracy, szczególnie w przypadku kreatywnych i dogłębnych zadań. Jest to historyczny punkt zwrotny, który niemal przypomina czasy, gdy komputery osobiste zastąpiły komputery mainframe. Zasada była wtedy taka sama jak teraz:

Kontrola nad własną technologią. Sztuczna inteligencja w chmurze pozostaje potężna - ale kulturowo nie jest wolna. Lokalna sztuczna inteligencja jest mniejsza - ale jest wolna.

Korzystaj z AI lokalnie - pełna kontrola i ochrona danych na TWOIM urządzeniu | C. Magnussen

Rozwiązanie: Lokalna sztuczna inteligencja i sposób na installier w kilka minut

Wygląda to niemal jak powrót do starej tradycji: technologia powinna być tam, gdzie może rozwinąć swoją wartość najbardziej bezpośrednio - w rękach użytkownika. Dokładnie to umożliwia lokalna sztuczna inteligencja. Podczas gdy modele chmurowe podlegają warunkom, bezpieczeństwu i ograniczeniom politycznym, lokalna sztuczna inteligencja działa wyłącznie na komputerze użytkownika, bez zewnętrznych instancji i wytycznych.

Przywraca to podstawową zasadę, która została utracona w ostatnich latach: użytkownik decyduje, co może zrobić jego oprogramowanie - a nie globalny dostawca usług. Lokalna sztuczna inteligencja:

- nie przechowuje żadnych danych na zewnętrznych serwerach,

- nie podlega żadnym systemom filtrującym,

- nie zna żadnych politycznie narzuconych ograniczeń,

- reaguje swobodnie i bezpośrednio na własne dane wejściowe,

- i jest zawsze dostępna, niezależnie od subskrypcji lub stanu serwera.

Technologia ponownie staje się tym, czym była przez dziesięciolecia: narzędziem w warsztacie użytkownika, a nie zdalnie sterowanym urządzeniem w globalnej infrastrukturze.

Nowoczesny sprzęt: dlaczego komputery Mac lub Windows PC są dziś całkowicie wystarczające?

Jeszcze kilka lat temu lokalna sztuczna inteligencja była czymś tylko dla specjalistów z drogim sprzętem GPU. Dziś sytuacja wygląda inaczej. Nowoczesne architektury procesorów - przede wszystkim układy M firmy Apple - zapewniają moc obliczeniową na niewielkiej przestrzeni, która wcześniej była zarezerwowana wyłącznie dla dużych centrów danych. Nawet zwykły MacBook Air lub laptop z systemem Windows może teraz uruchamiać modele AI lokalnie. W szczególności komputery Mac mają przewagę dzięki zunifikowanej architekturze pamięci: mogą korzystać z modeli AI bezpośrednio na CPU i GPU bez skomplikowanych sterowników. Typowe konfiguracje są całkowicie wystarczające:

- Mac z M1, M2, M3 - od 16 GB RAM komfortowo

- Windows PC z nowoczesnym CPU - lub opcjonalnie z GPU dla większej prędkości

I najważniejsza rzecz: nie potrzebujesz już żadnej wiedzy technicznej. Czasy, w których trzeba było ręcznie konfigurować środowiska Pythona lub wpisywać tajemnicze polecenia w wierszu poleceń, już minęły. Dziś wszystko działa za pośrednictwem prostych pakietów instalacyjnych.

Ollama: Nowa prostota (i sekretny standard lokalnej sztucznej inteligencji)

Ollama jest obecnie niekwestionowanym standardem lokalnej sztucznej inteligencji na komputerach Mac i Windows. Jest prosty, stabilny i zgodny z klasyczną filozofią:

Jak najmniej wysiłku, jak najwięcej swobody. Kiedyś trzeba było iść do terminala, ale nawet to jest obecnie opcjonalne. Instalacja odbywa się w zaledwie kilku krokach:

- Ollama na komputerze Mac installieren

- Pobierz bezpośredni pakiet instalacyjny (DMG)

- Otwórz aplikację, gotowe

Cały proces zajmuje zwykle mniej niż trzy minuty. To pokazuje, jak daleko zaszła lokalna sztuczna inteligencja: pobierasz model - i działa. Bez chmury, bez subskrypcji, bez ryzyka. Obecnie Ollama jest wyposażony w interfejs użytkownika, dzięki czemu można od razu rozpocząć pracę. Jeśli chcesz również korzystać z lokalnej sztucznej inteligencji z Ollama na swoim smartfonie, możesz pobrać aplikację „Reins - Chat dla Ollama“ i korzystać z lokalnej sztucznej inteligencji w ruchu.

Ładowanie i korzystanie z modeli - tak proste jak słuchanie muzyki

Ollama dostarcza modele jako „gotowe pakiety“, tak zwane kapsuły modeli. Ładuje się je jak plik - i można z nimi natychmiast pracować. Ładowanie trwa kilka sekund, w zależności od rozmiaru. Następnie otwiera się czat - i można pisać, formułować, analizować, myśleć i projektować. Co od razu rzuca się w oczy:

- Modele reagują swobodnie, a nie niezręcznie.

- Nie ma żadnych wstępów moralnych.

- Nie ma pedagogicznego wskazywania palcem.

Ponownie otrzymujesz bezpośrednie, jasne stwierdzenia. I tu pojawia się prawdziwa różnica w stosunku do chmury: lokalna sztuczna inteligencja reaguje jak tradycyjne narzędzie - nie ingeruje. Dla wielu jest to prawdziwe wyzwolenie, ponieważ odzyskujesz przepływ pracy, do którego byłeś przyzwyczajony w GPT-4.

Praca z graficznymi interfejsami użytkownika: OpenWebUI, LM Studio i inne

Jeśli chcesz pracować całkowicie bez terminala, użyj graficznego interfejsu użytkownika. Najpopularniejsze narzędzia to

- OpenWebUI - Nowoczesny interfejs czatu z funkcją pamięci, wybór modelu, przesyłanie dokumentów, generowanie obrazów

- LM Studio - Szczególnie prosta, idealna dla początkujących

- AnythingLLM - dla kompletnych baz wiedzy i analizy dokumentów

Powierzchnie te mają wiele zalet:

- Historie czatów jak w chmurze

- Zarządzanie modelami jednym kliknięciem myszy

- Ustawianie monitów systemowych

- Używaj kilku modeli równolegle

- Analizuj pliki metodą "przeciągnij i upuść

To sprawia, że lokalna sztuczna inteligencja jest nie tylko potężna, ale także wygodna. Nie musisz nawet wiedzieć, co dzieje się w tle - i to jest właśnie nowa siła lokalnych modeli: nie wchodzą między użytkownika a jego zadanie.

Prywatność i kontrola: najważniejszy argument

Punkt, który jest często niedoceniany, ale będzie kluczowy w nadchodzących latach: Lokalna sztuczna inteligencja nigdy nie opuszcza komputera.

- Brak chmury

- Brak transmisji danych

- Brak rejestrowania

- Brak obowiązkowej subskrypcji

- Brak analiz przeprowadzanych przez strony trzecie

Nawet poufne dokumenty, wewnętrzne rejestry, koncepcje biznesowe lub prywatne notatki mogą być analizowane bez ryzyka. W modelu chmurowym jest to możliwe tylko w ograniczonym zakresie - zarówno pod względem prawnym, jak i praktycznym. Lokalna sztuczna inteligencja jest zatem elementem cyfrowej niezależności, który staje się coraz ważniejszy w coraz bardziej regulowanym i monitorowanym świecie technologii.

Przykłady jakości: Co już dziś osiągają lokalne modele

Wiele osób nie docenia tego, jak dobre stały się modele lokalne. Obecne generacje - llama3, gemma, phi3, mistral - rozwiązują zadania z jakością, która jest więcej niż wystarczająca dla 90 % codziennych zadań:

- Teksty robocze

- Artykuł

- Analizy

- kreatywne pomysły

- Podsumowania

- Kod programu

- Projekt strategii

- Notatki z badań

I robią to bez opóźnień, bez filtrów, bez kaskadowych wytycznych. Użytkownik ponownie otrzymuje bezpośrednie odpowiedzi - czystą esencję narzędzia. Rezultatem jest coś, czego wielu by się nie spodziewało: renesans osobistej kultury komputerowej, w której moc obliczeniowa jest ponownie lokalna, a nie zlecana na zewnątrz.

Patrząc w przyszłość: lokalna sztuczna inteligencja jako przyszły lider kultury

Wszystko wskazuje na to, że jesteśmy na początku długoterminowego rozwoju. Sektor AI będzie rozwijał się dwutorowo:

- w Linia chmur, charakteryzujący się regulacjami, bezpieczeństwem, interesami korporacyjnymi - skuteczny, ale ostrożny

- w linia lokalna, charakteryzujący się wolnością, otwartością i radością eksperymentowania - mały, ale pewny siebie

Dla profesjonalnych użytkowników, autorów, programistów, badaczy, twórców i przedsiębiorców decyzja jest niemal przesądzona:

Przyszłość produktywnej pracy leży tam, gdzie jesteś niezależny. A to miejsce nie znajduje się w chmurze.

Stoi na biurku.

Dalsze artykuły w magazynie

Jeśli po tym przeglądzie chciałbyś zagłębić się w praktyczną stronę rzeczy, w magazynie znajdziesz serię szczegółowych artykułów, które rzucają światło na temat lokalnej sztucznej inteligencji z bardzo różnych perspektyw.

Szczególnie polecany jest artykuł przewodni „Lokalna sztuczna inteligencja na Macu - jak installiere model językowy z Ollama“, który pokazuje krok po kroku, jak łatwo jest uruchomić nowoczesną sztuczną inteligencję na własnym komputerze.

Ponadto wyjaśnia „Ollama spotyka Qdrant - lokalna pamięć dla twojej sztucznej inteligencji na Macu“, jak skonfigurować modele w taki sposób, aby zachowywały projekty, zapisywały statusy wiedzy, a tym samym po raz pierwszy tworzyły prawdziwe osobiste środowisko pracy.

Magazyn stawia również wyraźne akcenty w kontekście korporacyjnym: „gFM-Business i przyszłość ERP - lokalna inteligencja zamiast zależności od chmury“ pokazuje, w jaki sposób firmy mogą śmiało zintegrować sztuczną inteligencję z istniejącą infrastrukturą, nie popadając w długoterminowe zależności zewnętrzne.

Artykuł „Cyfrowa zależność - jak utraciliśmy samostanowienie na rzecz chmury“ Z drugiej strony, rzuca światło na szerszy obraz naszych czasów: dlaczego zrezygnowaliśmy z wielu wolności, nie zdając sobie z tego sprawy - i jak lokalne systemy mogą pomóc nam je odzyskać.

Ponadto „Jak dziś szkolić specjalistów AI - możliwości dla firm i stażystów“ dla firm, które chcą podjąć decyzję już teraz: praktyczne, bez kosztownych systemów na dużą skalę, ale z realnymi perspektywami na przyszłość.

Wyjaśnienie na poziomie technicznym „Apple MLX kontra NVIDIA - jak działa lokalna sztuczna inteligencja na komputerach Mac“ oraz artykuł przeglądowy

„AI Studio 2025 - który sprzęt naprawdę się opłaca, od Mac Studio po RTX 3090“, które platformy są odpowiednie dla różnych przypadków użycia i jak zoptymalizować wykorzystanie własnych zasobów.

Łącznie artykuły te stanowią zwartą podstawę dla każdego, kto nie tylko chce korzystać z lokalnej sztucznej inteligencji, ale także ją zrozumieć i pewnie zintegrować ze swoim środowiskiem pracy.

Często zadawane pytania

- Dlaczego nowoczesne SI w chmurze nagle wydają się tak pouczające?

Wielu użytkowników zauważyło, że od czasu GPT-4.1, a zwłaszcza od GPT-5, chmurowe SI zachowują się znacznie bardziej pedagogicznie. Wynika to głównie z faktu, że duzi dostawcy znajdują się pod znaczną presją prawną i polityczną, a zatem coraz częściej stosują filtry bezpieczeństwa, które mają na celu rozbrojenie wszelkich stwierdzeń w taki sposób, aby nie powstało żadne ryzyko. Te środki ostrożności przenoszą się na ton odpowiedzi, dzięki czemu modele działają bardziej jak moderatorzy lub nadzorcy niż neutralne narzędzia. - Dlaczego GPT-4.0 wydaje się teraz działać gorzej niż wcześniej?

Chociaż GPT-4 jest nadal oficjalnie dostępny, wielu użytkowników zgłasza, że zapewnia on jedynie krótkie lub anulowane odpowiedzi. To czyni go praktycznie bezużytecznym. Nie można z całą pewnością stwierdzić, czy jest to spowodowane względami technicznymi, czy też celową strategią przejścia na 5. generację. W rzeczywistości jednak model ten traci swoją dawną siłę i pośrednio zmusza użytkowników do korzystania z nowych wersji, które są ściślej regulowane. - Czy ten rozwój oznacza, że sztuczna inteligencja w chmurze stanie się mniej przydatna w przyszłości?

Sztuczna inteligencja w chmurze pozostaje potężna, ale będzie w coraz większym stopniu charakteryzować się regulacjami, zasadami zgodności i presją polityczną. Oznacza to, że choć pozostanie imponująca pod względem technicznym, stanie się bardziej ostrożna, bardziej filtrowana i mniej swobodna pod względem treści. W przypadku wielu kreatywnych, analitycznych lub niekonwencjonalnych zadań jest to wyraźna wada, dlatego coraz więcej użytkowników szuka alternatyw. - Dlaczego firmy zajmujące się sztuczną inteligencją stosują tak wiele mechanizmów bezpieczeństwa?

Powodem jest suma przepisów, ryzyko odpowiedzialności i postrzeganie przez opinię publiczną. Każdy błąd, każda wprowadzająca w błąd odpowiedź ze strony sztucznej inteligencji może mieć konsekwencje prawne lub medialne dla firmy. Aby wykluczyć takie ryzyko, dostawcy wdrażają kompleksowe filtry i wytyczne, które mają „zabezpieczyć“ wszystkie odpowiedzi. Ten mechanizm ochronny jest zrozumiały z punktu widzenia firmy, ale często stanowi przeszkodę z perspektywy użytkownika. - Jaka jest podstawowa różnica między lokalną sztuczną inteligencją a sztuczną inteligencją w chmurze?

Lokalna sztuczna inteligencja działa całkowicie na urządzeniu użytkownika i dlatego nie jest związana wymogami politycznymi ani wytycznymi firmy. Prawie nie filtruje, nie instruuje i działa bezpośrednio zgodnie ze specyfikacjami użytkownika. Ponadto wszystkie dane pozostają na komputerze użytkownika. Daje to użytkownikowi nie tylko większą swobodę, ale także większą prywatność i kontrolę. - Czy do korzystania z lokalnej sztucznej inteligencji wymagany jest specjalny sprzęt?

Nie w większości przypadków. Nowoczesne modele lokalne są niesamowicie wydajne i działają już na typowych komputerach Mac z układami M lub na standardowych komputerach z systemem Windows. Oczywiście większe modele korzystają z większej ilości pamięci RAM lub procesora graficznego, ale do wielu codziennych zadań małe i średnie modele są całkowicie wystarczające bez potrzeby stosowania drogiego specjalistycznego sprzętu. - Jak w praktyce wygląda instalacja lokalnego AI na Macu?

Najłatwiej jest to zrobić za pomocą Ollama. Pobierasz pakiet instalacyjny, otwierasz go i możesz od razu rozpocząć pracę. Nawet klasyczne polecenie terminala stało się opcjonalne. Gdy tylko Ollama stanie się installiert, można uruchomić model za pomocą prostego polecenia, takiego jak „ollama run llama3“. Przeszkoda jest tak niska, jak kiedyś przy instalacji normalnego programu. - Jak skonfigurować lokalną sztuczną inteligencję w systemie Windows?

W systemie Windows używany jest również instalator Ollama, który nie wymaga dodatkowego przygotowania. Po instalacji modele mogą być natychmiast uruchamiane. Jeśli wolisz korzystać z graficznego interfejsu użytkownika, możesz użyć LM Studio lub OpenWebUI, które są równie łatwe w użyciu jak standardowe oprogramowanie. - Które modele są szczególnie odpowiednie dla początkujących?

Wielu użytkowników z powodzeniem zaczyna od Llamy 3, ponieważ jest ona precyzyjna, wszechstronna i silna językowo. Równie popularny jest Phi-3, który zapewnia imponujące wyniki pomimo niewielkich rozmiarów modelu. Dobrym wyborem jest także Gemma, szczególnie do pracy kreatywnej lub wymagającej dużej ilości tekstu. Modele te działają szybko i stabilnie, bez konieczności długiego zapoznawania się z nimi. Jeśli dysponujesz większymi zasobami, GPT-OSS 20B lub 120B to bardzo dobry wybór. - Czy lokalne modele mogą naprawdę konkurować z GPT-4 lub GPT-5?

Potrafią to robić zaskakująco dobrze w wielu codziennych zadaniach. Luka nadal istnieje w przypadku wysoce wyspecjalizowanych tematów, ale szybko się zmniejsza. Modele lokalne mają tę zaletę, że są mniej ograniczone i reagują bardziej bezpośrednio. Ogólnie rzecz biorąc, często sprawia to, że wydają się bardziej swobodne i naturalne, nawet jeśli są technicznie nieco mniejsze. - Czy lokalna sztuczna inteligencja jest bezpieczniejsza przy przetwarzaniu wrażliwych danych?

Tak, zdecydowanie. Ponieważ całe przetwarzanie odbywa się na urządzeniu użytkownika, wprowadzane dane nigdy nie opuszczają jego komputera. Nie ma przetwarzania w chmurze, przechowywania na zewnętrznych serwerach ani analizy przez osoby trzecie. Jest to decydująca zaleta, szczególnie w przypadku dokumentów biznesowych, poufnych lub prywatnych notatek. - Czy lokalna sztuczna inteligencja może być używana bez połączenia z Internetem?

Tak, to jedna z jego największych zalet. Po zainstalowaniu modelu installiert może on pracować w trybie offline. Dzięki temu komputer staje się samowystarczalnym środowiskiem pracy, w którym można pracować niezależnie od zewnętrznych usług. Jest to szczególnie przydatne podczas podróży, w zabezpieczonych sieciach lub w środowiskach, w których ochrona danych jest najwyższym priorytetem. - Jak odpowiednie są lokalne modele dla długich tekstów?

Większość współczesnych modeli bez problemu radzi sobie z długimi artykułami, analizami czy koncepcjami. Nie są one tak dopracowane jak GPT-5, ale są bardziej wolne od filtrów i często bardziej bezpośrednie w swoim stylu. Dobrze nadają się do obszernych tekstów, zbiorów pomysłów lub dokumentacji technicznej i umożliwiają produktywną pracę bez ograniczeń. - Czy lokalne modele mają w ogóle filtry bezpieczeństwa?

Zwykle dostępny jest pewien poziom podstawowej ochrony, choć jest on znacznie słabszy niż w przypadku sztucznej inteligencji w chmurze. Ponieważ modele działają na własnym urządzeniu użytkownika, może on sam zdecydować, które ograniczenia mają sens. Ta swoboda projektowania zapewnia, że lokalna sztuczna inteligencja jest znacznie bardziej elastyczna i mniej protekcjonalna. - Jak można przetestować lub porównać różne modele?

Ollama, LM Studio lub OpenWebUI sprawiają, że zmiana modeli jest bardzo łatwa. Można używać kilku modeli install równolegle, przełączać się między nimi i porównywać ich mocne strony. Tworzy to osobisty zestaw ulubionych modeli, które dokładnie pasują do własnego stylu pracy. Proces ten jest prosty i bardziej przypomina testowanie różnych aplikacji niż klasyczne badania nad sztuczną inteligencją. - Jakie są zalety modeli lokalnych dla firm?

Przede wszystkim firmy korzystają z pełnej suwerenności danych, ponieważ brak chmury oznacza brak zewnętrznej pamięci masowej. Eliminowane są również długoterminowe zależności od usług zewnętrznych i drogich subskrypcji. Modele można dostosowywać, rozszerzać, a nawet szkolić wewnętrznie. Integracja z istniejącymi procesami jest często łatwiejsza, ponieważ zachowujesz pełną kontrolę i nie jesteś związany z zewnętrzną infrastrukturą. - Czy modele lokalne mogą być trenowane indywidualnie?

W rzeczywistości jest to jedna z najważniejszych zalet. Dzięki technikom takim jak LoRA lub dostrajanie, modele można dostosować do własnych treści, procesów lub dokumentów firmy. Tworzy to osobistą bazę wiedzy, która jest wykorzystywana i rozwijana wyłącznie wewnętrznie, bez wrażliwych danych opuszczających firmę. - Jakie są jakościowe różnice między obecnymi modelami lokalnymi?

Każdy model ma swój własny charakter. Llama 3 jest bardzo precyzyjna i zrównoważona, Gemma jest kreatywna i płynna językowo, Phi-3 zaskakuje wydajnością i inteligencją, a Mistral i Qwen są szczególnie silne analitycznie. To bogactwo wariantów pozwala wybrać odpowiedni model do własnych potrzeb i elastycznie przełączać się, gdy wymaga tego zadanie. - Czy modele lokalne mogą również generować obrazy?

Tak, narzędzia takie jak OpenWebUI mogą być używane do uruchamiania generatorów obrazu takich jak Stable Diffusion całkowicie lokalnie. Wyniki zależą od dostępnego sprzętu, ale solidne obrazy mogą być generowane nawet przy umiarkowanych zasobach. Zaleta pozostaje taka sama: żadne dane nie są wysyłane do zewnętrznych usług. - Dla kogo przejście na lokalną sztuczną inteligencję jest szczególnie opłacalne?

Lokalna sztuczna inteligencja jest idealna dla użytkowników, którzy chcą pracować pewnie i niezależnie. Obejmuje to autorów, programistów, badaczy, przedsiębiorców i każdego, kto obsługuje wrażliwe informacje lub chce doświadczyć procesów twórczych bez filtrów. Każdy, kto ceni sobie kontrolę, ochronę danych i wolność, znajdzie odpowiednie rozwiązanie w modelach lokalnych i odzyska środowisko pracy, które nie istnieje już w chmurze.