Hace solo unos años, la inteligencia artificial era un tema reservado a instituciones de investigación y grandes empresas. Se hablaba de redes neuronales, aprendizaje profundo y reconocimiento de voz, pero apenas desempeñaba un papel en la vida cotidiana. Hoy en día, la IA ya no es un tema del futuro, sino una realidad: escribe textos, crea imágenes, analiza datos y controla procesos de producción. Ya sea en la administración, el comercio o la industria, ahora se encuentra en todas partes.

Inteligencia artificial

La inteligencia artificial describe el intento de enseñar a las máquinas a pensar, no en el sentido de conciencia, sino como la capacidad de reconocer patrones, tomar decisiones y dominar tareas complejas. Desde los modelos lingüísticos y la generación de imágenes hasta los sistemas autónomos, la IA está cambiando hoy casi todas las industrias y abriendo posibilidades que hace sólo unos años se consideraban ciencia ficción. Al mismo tiempo, plantea interrogantes: ¿Hasta qué punto son fiables estos sistemas? ¿Cuáles son sus límites? ¿Y qué impacto tienen en la sociedad, la economía y la libertad personal? Esta palabra clave reúne los antecedentes, la evolución y las aplicaciones prácticas de la inteligencia artificial, explicadas con claridad y clasificadas de forma crítica.

gFM-Business y el futuro del ERP: inteligencia local en lugar de dependencia de la nube

Desde hace más de una década, el software gFM-Business es sinónimo de algo especial en el mercado alemán de ERP: no se basa en un sistema engorroso y difícil de mantener, sino en la plataforma FileMaker, ligera, personalizable y visualmente modelada. Esto tiene muchas ventajas: gFM-Business puede ampliarse individualmente, funciona en Windows, macOS e iOS y puede ser personalizado tanto por desarrolladores como por ambiciosos usuarios avanzados.

Con la llegada de la inteligencia artificial (IA) -especialmente a través de los llamados modelos lingüísticos como ChatGPT- surgen ahora nuevas oportunidades que van mucho más allá de la automatización tradicional. gFM-Business se prepara activamente para este futuro: con el objetivo no solo de gestionar datos, sino también de desbloquear conocimientos.

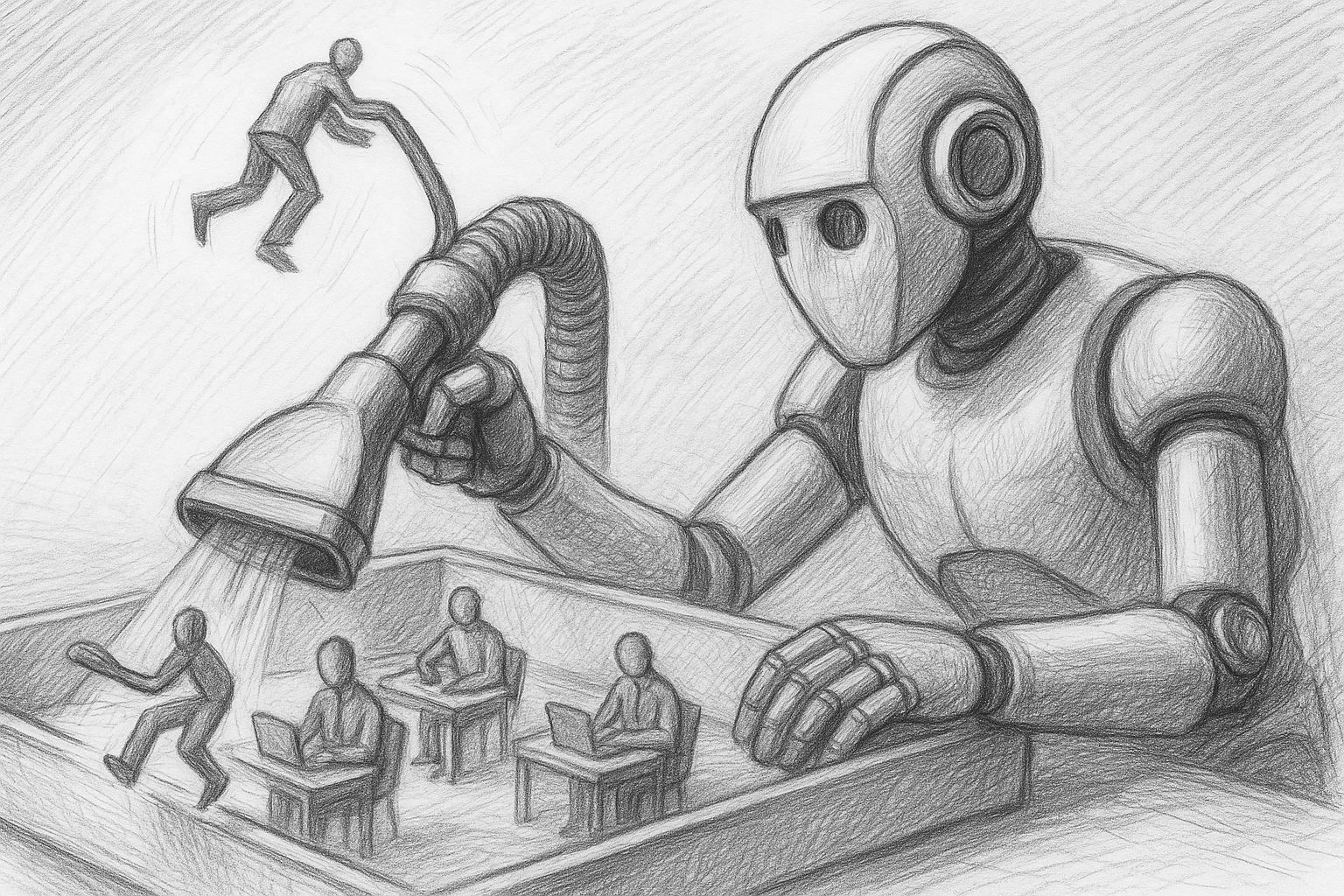

Inteligencia artificial: qué empleos están en peligro y cómo podemos armarnos ahora

Casi ningún otro cambio tecnológico se ha colado en nuestra vida cotidiana con tanta rapidez como la inteligencia artificial. Lo que ayer se consideraba una tecnología visionaria del futuro hoy ya es una realidad, ya sea para enviar mensajes de texto, programar, diagnosticar, traducir o incluso crear música, arte o informes jurídicos.

FileMaker Conferencia 2025: IA, comunidad y un incidente inesperado

La Conferencia FileMaker 2025 de Hamburgo ha terminado, y ha sido un hito especial en muchos aspectos. No sólo porque la conferencia de este año se ha centrado en muchos temas relacionados con la inteligencia artificial, el rendimiento y los flujos de trabajo modernos, sino también porque el intercambio personal y el "ambiente familiar" de la comunidad FileMaker han vuelto a cobrar todo su sentido. Para mí, personalmente, fue un momento intenso, inspirador y enriquecedor en todos los sentidos, desde la primera noche.

MLX en Apple Silicon como IA local en comparación con Ollama & Co.

En un momento en el que los servicios de IA centralizados como ChatGPT, Claude o Gemini dominan los titulares, muchos usuarios profesionales tienen una necesidad creciente de una alternativa: una infraestructura de IA local y autocontrolable. Especialmente para procesos creativos, datos sensibles o flujos de trabajo recurrentes, una solución local suele ser la opción más sostenible y segura.

Cualquiera que trabaje con un Mac -especialmente con Apple Silicon (M1, M2, M3 o M4)- puede encontrar ahora herramientas asombrosamente potentes para ejecutar sus propios modelos lingüísticos directamente en el dispositivo. En el centro de todo ello se encuentra un componente nuevo y en gran medida desconocido: MLX, un marco de aprendizaje automático desarrollado por Apple que probablemente desempeñará un papel cada vez más central en el ecosistema de IA de la empresa en los próximos años.

RAG con Ollama y Qdrant como motor de búsqueda universal de datos propios

En un mundo de información cada vez más confuso, es cada vez más importante hacer que sus propias bases de datos sean consultables de forma específica, no mediante las clásicas búsquedas de texto completo, sino a través de respuestas semánticamente relevantes. Aquí es exactamente donde entra en juego el principio de la base de datos RAG, una solución de búsqueda asistida por inteligencia artificial que consta de dos componentes centrales:

Ollama se reúne con Qdrant: una memoria local para tu IA en el Mac

IA local con memoria: sin nube, sin suscripción, sin distracciones

En un artículos anteriores He explicado cómo configurar Ollama en el Mac install. Si ya has completado este paso, ahora tienes un potente modelo de lenguaje local - como Mistral, LLaMA3 u otro modelo compatible que se puede abordar a través de REST API.

Sin embargo, el modelo sólo "sabe" lo que hay en la solicitud actual. No recuerda conversaciones anteriores. Lo que falta es un recuerdo.

IA local en el Mac: cómo installiere un modelo lingüístico con Ollama

La IA local en Mac es práctica desde hace tiempo, especialmente en los ordenadores Apple-Silicon (serie M). Con Ollama se obtiene un entorno de ejecución sencillo para muchos modelos lingüísticos de código abierto (por ejemplo, Llama 3.1/3.2, Mistral, Gemma, Qwen). La versión actual de Ollama también incluye una aplicación fácil de usar que le permite configurar un modelo lingüístico local en su Mac con un simple clic del ratón. En este artículo encontrarás una guía pragmática desde la instalación hasta la primera consulta, con consejos prácticos sobre dónde suelen fallar las cosas.