Während MLX ursprünglich als experimentelles Framework von Apple Research gestartet ist, hat sich in den letzten Monaten eine stille, aber bedeutende Entwicklung vollzogen: Mit der Veröffentlichung von FileMaker 2025 hat Claris MLX als native KI-Infrastruktur für Apple Silicon fest in den Server integriert. Das bedeutet: Wer mit einem Mac arbeitet und auf Apple Silicon setzt, kann MLX-Modelle nicht nur lokal ausführen, sondern direkt in FileMaker verwenden – mit nativen Funktionen, ganz ohne Zwischenschichten.

Die Grenzen zwischen lokalem MLX-Experiment und professioneller FileMaker-Anwendung beginnen zu verschwimmen – zugunsten eines vollständig integrierten, nachvollziehbaren und kontrollierbaren KI-Workflows.

Der neue KI-Bereich im FileMaker Server: „AI Services“

Herzstück dieser neuen Architektur ist der Bereich „AI Services“ in der Admin-Konsole von FileMaker Server 2025. Hier können Entwickler und Administratoren:

- den AI Model Server aktivieren,

- Modelle verwalten (herunterladen, bereitstellen, feintunen),

- API-Keys für autorisierte Clients vergeben,

- und die laufenden KI-Operationen gezielt überwachen.

Läuft der FileMaker Server auf einem Mac mit Apple Silicon, so verwendet der integrierte AI Model Server automatisch MLX als Inferenz-Backend. Das bringt alle Vorteile mit sich, die MLX auf Apple-Geräten bietet: hohe Speichereffizienz, native GPU-Nutzung über Metal, und eine klare Trennung von Modell und Infrastruktur – ganz im Stil der Apple-Welt.

Bereitstellung von MLX-Modellen direkt über die Server-Konsole

Die Bereitstellung eines MLX-Modells ist einfacher als erwartet: In der AI-Verwaltungskonsole lassen sich unterstützte Modelle aus einer wachsenden Liste von Claris-kompatiblen Sprachmodellen direkt auswählen und auf dem Server installieren. Dabei handelt es sich um Open-Source-Modelle (z. B. Varianten von Mistral, LLaMA oder Phi), die im .npz-Format vorliegen und speziell für MLX konvertiert wurden. Derzeit (Stand: September 2025) ist die Anzahl verfügbarer Modelle allerdings noch recht übersichtlich.

Alternativ lassen sich eigene Modelle vorbereiten – zum Beispiel durch Konvertierung von Hugging-Face-Modellen mit dem Tool mlx-lm. Mit einem einzigen Befehl kann man ein Modell herunterladen, quantisieren und in das passende Format bringen. Dieses kann dann im Serververzeichnis bereitgestellt werden – nach dem gleichen Schema, das auch Claris intern verwendet. Einmal installiert, stehen diese Modelle sofort für alle unterstützten KI-Funktionen innerhalb von FileMaker bereit.

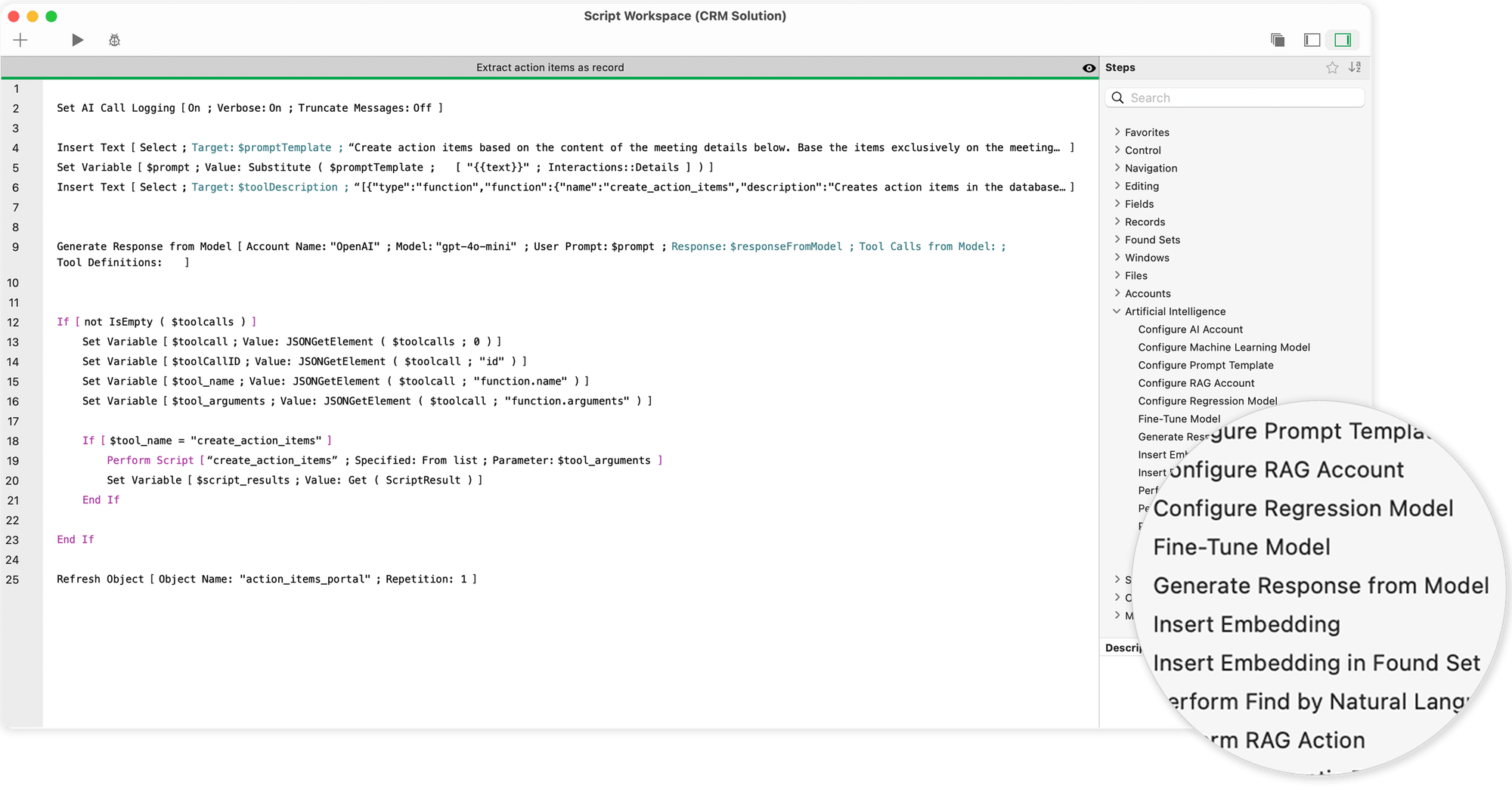

Native KI-Funktionen in FileMaker Pro: Skripten statt Umwege

Was früher über externe APIs, REST-Aufrufe und manuell gebaute JSON-Routinen lief, ist heute in FileMaker 2025 in Form von dedizierten Scriptbefehlen verfügbar. Sobald ein AI Account eingerichtet ist – mit dem Namen des Modells und der Verbindung zum Server – lassen sich KI-Aufgaben nahtlos in die Benutzeroberfläche und Geschäftslogik integrieren.

Zu den wichtigsten Befehlen zählen:

- „Generate Response from Model“, mit dem sich Textantworten erzeugen lassen – etwa für automatische Textvorschläge, Chatfunktionen oder E-Mail-Entwürfe.

- „Perform Find by Natural Language“, das eine einfache Formulierung („Zeig mir alle Kunden aus Berlin mit offenen Rechnungen“) in eine präzise Datenbankabfrage übersetzt.

- „Perform SQL Query by Natural Language“, mit dem auch komplexe SQL-Strukturen generiert und verarbeitet werden können – inklusive Joins und Subqueries.

- „Get Embedding“ und verwandte Funktionen, die semantische Vektoranalysen ermöglichen – etwa zur Suche nach inhaltlich ähnlichen Texten oder Kundenanfragen.

All diese Befehle greifen im Hintergrund auf das aktuell ausgewählte MLX-Modell zurück, das auf dem AI Model Server läuft. Die Antworten sind sofort verfügbar und lassen sich direkt weiterverarbeiten – als Text, JSON oder eingebetteter Vektor.

Scriptschritte und Möglichkeiten für KI in FileMaker

Scriptschritte für künstliche Intelligenz ermöglichen die direkte Integration leistungsfähiger KI-Modelle – wie etwa Large Language Models (LLMs) oder Core ML – in FileMaker-Workflows. Sie schaffen die technische Grundlage, um natürliche Sprache, Datenbankwissen und maschinelles Lernen miteinander zu verbinden. Die folgenden Funktionen stehen zur Verfügung:

- Konfiguration eines benannten KI-Kontos

Sie können ein bestimmtes KI-Konto einrichten und benennen, das anschließend in allen weiteren Scriptschritten und Funktionen verwendet wird. So behalten Sie die Kontrolle über Authentifizierung und Zugriff auf externe Modelle oder Dienste. - Abruf einer Textantwort anhand eines Prompts

Ein KI-Modell kann auf einen vom Benutzer eingegebenen Prompt reagieren und eine entsprechende Textantwort generieren. Dies ermöglicht automatisierte Texterstellung, Vorschläge oder Dialogfunktionen. - Datenbankabfrage auf Basis eines Prompts und des Datenbankschemas

Durch Übergabe eines Prompts in natürlicher Sprache zusammen mit dem strukturellen Schema Ihrer Datenbank kann das Modell relevante Inhalte identifizieren und daraus gezielt ein Ergebnis zurückgeben. - SQL-Abfragen generieren lassen

Das Modell kann auch SQL-Abfragen generieren, basierend auf einem Prompt und dem zugrunde liegenden Datenbankschema. So lassen sich komplexe Abfragen automatisch erzeugen, die anschließend für Datenbankoperationen genutzt werden können. - FileMaker-Suchabfragen auf Basis von Layoutfeldern

Indem Sie dem Modell die Felder des aktuellen Layouts zusammen mit einem natürlichen Sprachprompt übergeben, können automatisch Suchabfragen formuliert und passende Ergebnismengen abgerufen werden. - Einbettungsvektoren in Datensätze einfügen

Sie haben die Möglichkeit, semantische Einbettungen (Embeddings) – also numerische Vektoren, die Bedeutungen repräsentieren – in Felder einzelner Datensätze oder ganzer Ergebnismengen einzufügen. Dies bildet die Grundlage für spätere semantische Vergleiche oder KI-Analysen. - Semantische Suche durchführen

Basierend auf der Bedeutung einer Suchanfrage kann das System Datensätze identifizieren, deren Felddaten ähnliche Bedeutungen aufweisen – selbst wenn die Wörter nicht exakt übereinstimmen. Dies eröffnet neue Wege der intelligenten Datensuche. - Prompt-Vorlagen einrichten

Sie können wiederverwendbare Prompt-Vorlagen definieren, die in anderen Scriptschritten oder Funktionen genutzt werden. So sichern Sie Konsistenz und sparen Zeit bei der Erstellung strukturierter Prompts. - Regressionsmodell konfigurieren

Für Aufgaben wie Vorhersagen, Schätzungen oder Trendanalysen lässt sich ein Regressionsmodell einrichten, das dann auf numerischen Datensätzen operiert. Es eignet sich z. B. zur Analyse von Umsatzentwicklungen oder Risikobewertungen. - RAG-Konto konfigurieren und verwalten

Ein benanntes RAG-Konto (Retrieval-Augmented Generation) kann eingerichtet werden. Damit können Sie Daten hinzufügen oder entfernen sowie gezielt Prompts an einen RAG-Space senden. RAG-Systeme kombinieren klassische Suche mit KI-generierten Antworten. - Feinabstimmung eines Modells mit Trainingsdaten

Sie können ein bestehendes Modell mit einem eigenen Datensatz nachtrainieren, um es besser auf spezifische Anforderungen, Sprachstile oder Aufgabenbereiche abzustimmen. Das sogenannte Fine-Tuning erhöht die Relevanz und Qualität der Ausgaben. - KI-Aufrufe protokollieren

Zur Nachverfolgung und Analyse kann die Protokollierung aller KI-Aufrufe aktiviert werden. Dies ist hilfreich zur Optimierung von Prompts, zur Fehlersuche oder zur Dokumentation - Core ML-Modelle konfigurieren

Neben cloudbasierten LLMs lassen sich auch lokal ausgeführte Core ML-Modelle konfigurieren. Dies ist besonders sinnvoll für Offline-Anwendungen oder den Einsatz auf Apple-Geräten mit integrierter ML-Unterstützung.

Aktuelle Umfrage zur Zukunft von Claris FileMaker und KI

Feintuning direkt aus FileMaker heraus: LoRA als neuer Standard

Eine der spannendsten Neuerungen ist die Möglichkeit, eigene Modelle direkt in FileMaker zu feintunen – und zwar vollständig innerhalb der gewohnten Oberfläche. Dazu genügt ein Scriptbefehl: „Fine-Tune Model“.

Hier können Datensätze aus FileMaker-Tabellen (z. B. Supportverläufe, Kundendialoge, Textmuster) als Trainingsdaten genutzt werden. Die Feintuning-Methode basiert auf LoRA (Low-Rank Adaptation), einem ressourcenschonenden Verfahren, das nur einen kleinen Teil der Modellparameter verändert und so schnelle Anpassungen ermöglicht – selbst auf Geräten mit begrenztem Arbeitsspeicher.

Die Trainingsdaten werden entweder aus einem aktuellen Found Set übernommen oder über eine JSONL-Datei eingespielt. Nach dem Training wird ein neuer Modellname vergeben – z. B. „fm-mlx-support-v1“ – und das Ergebnis steht direkt für weitere KI-Funktionen zur Verfügung. Damit lassen sich maßgeschneiderte Sprachmodelle erzeugen, die im Ton, im Vokabular und im Verhalten genau auf die jeweilige Anwendung abgestimmt sind.

Datenschutz und Leistung – zwei Seiten derselben Medaille

Dass FileMaker 2025 auf lokale Modelle mit MLX setzt, ist kein Zufall. In einer Zeit, in der Datenhoheit, DSGVO-Konformität und interne Sicherheitsrichtlinien immer wichtiger werden, bietet dieser Ansatz gleich mehrere Vorteile:

- Keine Cloud, keine externen Server, keine API-Kosten: Alle Anfragen bleiben im eigenen Netzwerk.

- Schnellere Antwortzeiten durch lokale Verarbeitung – insbesondere bei wiederkehrenden Abläufen.

- Hohe Transparenz und Kontrollierbarkeit: Jede Antwort kann geprüft, jede Änderung nachvollzogen, jeder Trainingsschritt dokumentiert werden.

- Feintuning auf eigene Daten: Firmenspezifisches Wissen wird nicht mehr über fremde Anbieter geleitet, sondern bleibt vollständig im eigenen System.

Gleichzeitig ist es wichtig, die Ressourcen realistisch einzuschätzen: Große Modelle benötigen auch lokal eine solide Infrastruktur – etwa ein Apple Silicon Mac mit 32 oder 64 GB RAM, ggf. mit SSD-Caching und dediziertem Server-Profil. Doch wer diesen Weg geht, profitiert langfristig von maximaler Kontrolle bei voller Flexibilität.

MLX und FileMaker – eine neue Allianz für Profis

Was zunächst wie ein paralleler Pfad aussah – auf der einen Seite MLX als Forschungsframework von Apple, auf der anderen Seite FileMaker als klassische Datenbankplattform – ist jetzt zu einem geschlossenen System zusammengewachsen.

Claris hat erkannt, dass moderne Geschäftsanwendungen mehr brauchen als Formulare, Tabellen und Reports. Sie brauchen adaptive, verständnisfähige KI – und zwar integriert, nicht angeflanscht. Mit der nativen Unterstützung von MLX, den neuen KI-Befehlen und der Möglichkeit zum lokalen Feintuning bietet FileMaker 2025 erstmals eine vollständige Plattform, um eigene KI-Prozesse aufzubauen, zu steuern und produktiv zu nutzen – ohne dabei auf externe Anbieter oder fremde Clouds angewiesen zu sein.

Für Entwickler, die wie Du eine klare, konservativ durchdachte und datensichere Architektur schätzen, ist das mehr als ein Fortschritt – es ist der Beginn einer neuen Arbeitsweise.

In einem weiteren Artikel stelle ich einen Vergleich zwischen Apple Silicon und NVIDIA an und erläutere, welche Hardware geeignet ist, um lokale Sprachmodelle auf einem Mac auszuführen.

Häufig gestellte Fragen

- Was genau bedeutet es, dass FileMaker 2025 „MLX unterstützt“?

FileMaker Server 2025 enthält erstmals einen integrierten AI Model Server, der – sofern auf einem Apple Silicon Mac installiert – nativ MLX-Modelle verwendet. Das bedeutet: Du kannst ein MLX-kompatibles Modell (z. B. Mistral oder Phi-2) direkt über die Admin-Konsole bereitstellen und in Deiner FileMaker-Lösung verwenden – ohne Umwege über externe Dienste oder REST-Aufrufe. - Was brauche ich dafür konkret an Hardware und Software?

– Einen Mac mit Apple Silicon (M1, M2, M3, M4), idealerweise mit 32–64 GB RAM,

– FileMaker Server 2025, auf diesem Mac installiert,

– FileMaker Pro 2025 für die eigentliche Lösung,

– und ein oder mehrere MLX-kompatible Modelle – entweder von Claris bereitgestellt oder selbst konvertiert (z. B. via mlx-lm). - Wie binde ich so ein Modell in meine FileMaker-Lösung ein?

Über die neue Funktion „Configure AI Account“ in FileMaker Scripts legst Du fest, mit welchem Modell gearbeitet wird. Der Servername, der Modellname und der Auth-Key werden dabei definiert. Danach kannst Du sofort die anderen KI-Funktionen verwenden – z. B. zur Texterzeugung, Embedding oder semantischen Suche. Alles läuft über native Script-Schritte, keine Webviewer oder „Insert from URL“-Bastelarbeit mehr nötig. - Welche KI-Funktionen kann ich dann in FileMaker nutzen?

Folgende Funktionen stehen (je nach Modelltyp) zur Verfügung:

– Textgenerierung („Generate Response from Model“)

– Natürliche Suche („Perform Find by Natural Language“)

– SQL in Alltagssprache („Perform SQL Query by Natural Language“)

– Semantische Vektoren („Get Embedding“, „Cosine Similarity“)

– Prompt-Vorlagenverwaltung („Configure Prompt Template“)

– LoRA-Feintuning über eigene Daten („Fine-Tune Model“)

Alle Funktionen sind Script-schritt-basiert und können nahtlos in bestehende Lösungen eingebunden werden. - Wie funktioniert das Fine-Tuning direkt in FileMaker?

Du kannst in FileMaker 2025 ein vorhandenes MLX-Modell per LoRA direkt feintunen – also mit Deinen eigenen Daten anpassen. Dafür nutzt Du entweder Datensätze in einer Tabelle (z. B. Fragen + Antworten) oder eine JSONL-Datei. Ein einziger Scriptbefehl („Fine-Tune Model“) reicht aus, um ein neues, angepasstes Modell zu erzeugen – das dann sofort in der Lösung verfügbar ist. - Muss ich mich dann noch mit Python, JSON, APIs oder Modellformate auskennen?

Nein, nicht unbedingt. Claris hat bewusst darauf geachtet, dass viele dieser technischen Details in den Hintergrund treten. Du kannst mit nativen Scriptbefehlen arbeiten, die Daten in FileMaker selbst verwalten, und die Rückgaben als Text oder Vektor einfach verarbeiten. Wer will, kann tiefer einsteigen – aber es geht jetzt auch ohne Programmierkenntnisse. - Was sind die Vorteile, wenn ich MLX über FileMaker nutze – gegenüber externen APIs?

Die Vorteile liegen in der Datensicherheit, der Kostenkontrolle und der Performance:

– Keine Cloud-Anbindung notwendig, alle Daten bleiben im eigenen Netzwerk.

– Keine API-Kosten oder Token-Limits – einmal installiert, ist die Nutzung frei.

– Sehr kurze Antwortzeiten, da keine Netzwerklatenz dazwischen liegt.

– Volle Kontrolle über Trainingsdaten, Feintuning und Modellversionierung.

Besonders für interne Anwendungen, Branchenlösungen oder sensible Prozesse ist das ein echter Gamechanger. - Gibt es Einschränkungen oder Dinge, auf die man achten muss?

Ja – MLX funktioniert nur auf Apple Silicon, d. h. ein Intel-Server ist ausgeschlossen. Außerdem brauchst Du genügend RAM, damit auch größere Modelle zuverlässig laufen. Nicht alle Modelle sind sofort kompatibel – manche müssen konvertiert werden. Und schließlich: Obwohl vieles „automatisch“ funktioniert, sollte man bei produktivem Einsatz immer einen dedizierten Testlauf machen – z. B. mit kleinen Datenmengen, klaren Zieldefinitionen und guter Logging-Strategie.

Bildmaterial (c) Claris Inc. und Kohji Asakawa auf Pixabay