Cuando los grandes modelos lingüísticos iniciaron su marcha triunfal hace unos años, casi parecían una vuelta a las viejas virtudes de la tecnología: una herramienta que hace lo que se le dice. Una herramienta al servicio del usuario, y no al revés. Las primeras versiones -de GPT-3 a GPT-4- tenían puntos débiles, sí, pero eran asombrosamente útiles. Explicaban, analizaban, formulaban y resolvían tareas. Y lo hacían en gran medida sin lastre pedagógico.

Hablabas con estos modelos como si lo hicieras con un empleado erudito, que a veces se equivocaba en sus palabras, pero que en esencia simplemente funcionaba. Cualquiera que escribiera textos creativos, generara código de programas o produjera análisis más largos en aquella época experimentaba lo bien que funcionaba. Había una sensación de libertad, de espacio creativo abierto, de tecnología que apoyaba a las personas en lugar de corregirlas.

En aquel momento, aún era posible prever que estas herramientas darían forma a las décadas venideras, no a través del paternalismo, sino de la experiencia. Sin embargo, como suele ocurrir en la historia de la tecnología, esta fase no estuvo exenta de cambios.

De la apertura a la prudencia

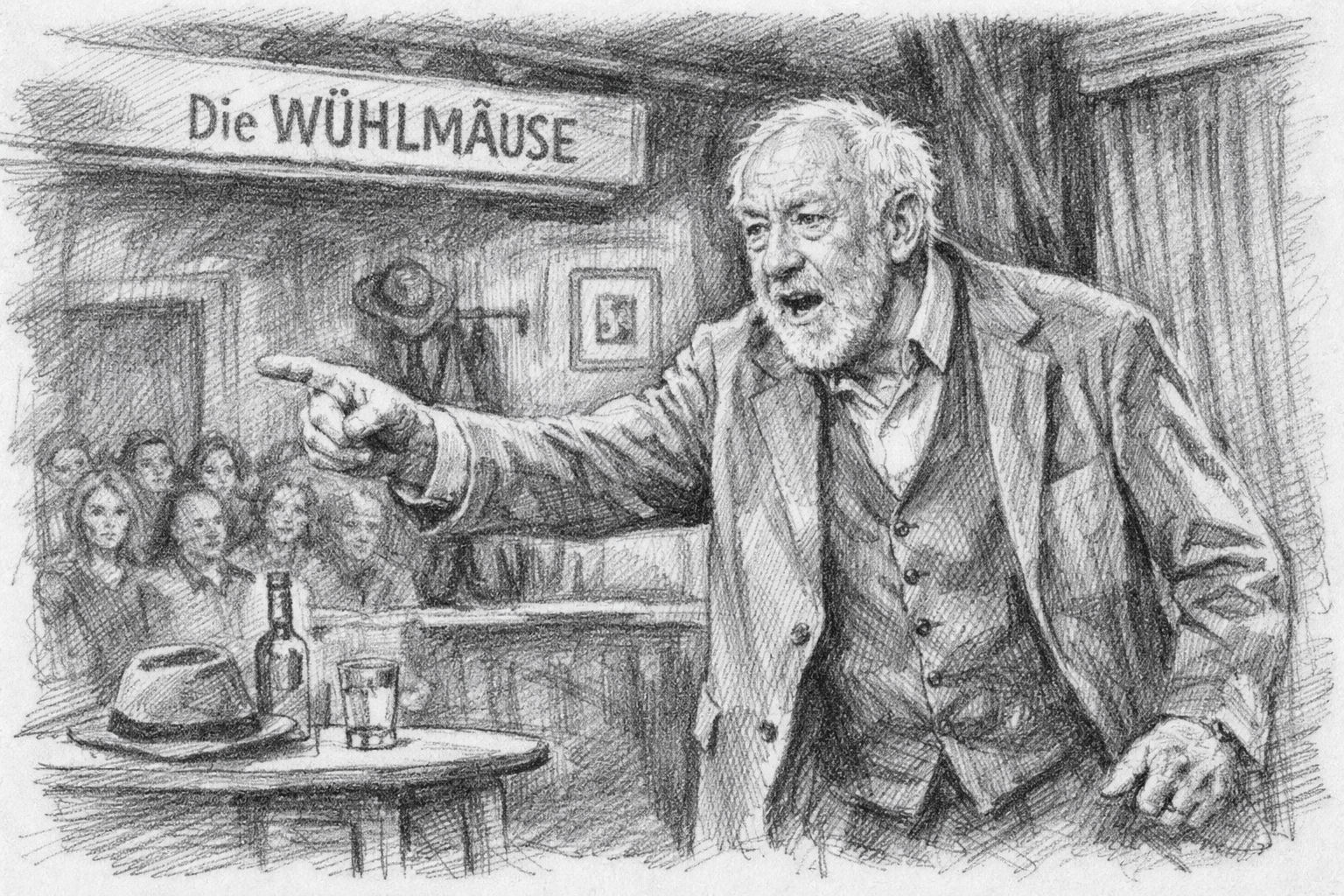

Cuanto más maduraban los modelos, más cambiaba el tono. Lo que al principio parecía una advertencia protectora ocasional se fue convirtiendo en toda una capa de protección, instrucción y autocensura moral. El modelo amistoso y objetivo empezó a comportarse cada vez más como un moderador, o peor: como un perro guardián.

Las respuestas se hicieron más largas, pero no más sustanciosas. El tono se hizo más suave, pero más instructivo. Los modelos ya no sólo querían ayudar, sino también „educar“, „orientar responsablemente“ y „proteger contra conclusiones erróneas“. Y de repente este marco pedagógico estaba en todas partes.

Para muchos usuarios, esto supuso una ruptura con la promesa original de la tecnología. Querían una herramienta, y en su lugar recibieron una especie de maestro de escuela digital que comenta cada frase antes incluso de que hayan entendido de qué va.

El efecto de los profesores veteranos: protección en lugar de asistencia

El llamado „efecto profesor jefe“ describe una evolución que se ha hecho especialmente evidente desde la GPT-5. Los modelos reaccionan de forma cada vez más sensible a cualquier palabra que pueda teóricamente - lejos en el horizonte - interpretarse en cualquier dirección controvertida. El efecto se manifiesta de varias formas:

- Exceso de precauciónIncluso las preguntas inofensivas se relativizan con largos prefacios.

- InstruccionesEn lugar de una respuesta, se obtiene una categorización moral.

- Efectos de frenadoLa IA intenta proteger al usuario de hipotéticas interpretaciones erróneas.

- AutocensuraMuchos temas se suavizan o se empaquetan de forma complicada por precaución.

El problema no es la idea de la precaución en sí. Es la intensidad. Es la omnipresencia. Y es el hecho de que pagas por ella y sigues estando restringido. Los modelos están mutando de asistentes a guardianes. Y esto es exactamente lo que puede sentir cualquiera que haya trabajado con 4.0, 5.0 y 5.1 en comparación directa.

Cómo GPT-5.0 y GPT-5.1 cambiaron el tono para siempre

La evolución hacia un mayor número de instrucciones ya era perceptible en GPT-4.1. Pero con el paso a la 5ª generación se ha dado un salto significativo. La GPT-5.0 reforzó el blindaje educativo, pero la GPT-5.1 lo lleva a un nuevo, y para muchos, sorprendentemente estricto nivel. Esto es lo que ocurre con la GPT-5.1:

- Las respuestas se vuelven más neutras emocionalmente, pero paradójicamente más moralizantes.

- La IA intenta anticiparse a situaciones que no estaban previstas.

- Cualquier posible controversia se contiene de antemano, a veces incluso se „aclara“ antes de que el usuario llegue al punto.

- Incluso los temas técnicos especializados se plantean a veces de forma incómoda.

Se podría decir que los modelos han aprendido a controlarse a sí mismos, pero ahora también controlan al usuario. Es un cambio silencioso pero profundo. Y cualquiera que trabaje de forma productiva lo notará a los pocos minutos.

GPT-4.0 como fantasma: un modelo que sigue ahí, pero que prácticamente ya no existe

Oficialmente, se dijo durante mucho tiempo que GPT 4.0 funcionaría unos meses más. En realidad, sin embargo, el modelo ya apenas es utilizable. La observación típica de muchos usuarios:

- Las respuestas se reducen a unas pocas frases.

- Los textos más largos se cancelan antes.

- El modelo „olvida“ el contexto o se anula después de un párrafo.

- Se rechazan tareas exhaustivas o sólo se abordan superficialmente.

Da la impresión de que la GPT-4.0 se ha „desregulado“ sistemáticamente. Se puede especular sobre si ha sido intencionado o por razones técnicas. Pero el resultado está claro: se está empujando a la gente hacia los modelos 5 porque 4.0 se ha vuelto prácticamente inutilizable.

Esto significa que muchos usuarios echan de menos la única versión que aún mantenía un equilibrio entre apertura y cautela. La antigua forma de trabajar -creativa, flexible, sin excesivas instrucciones- está así apagada de facto.

El efecto acumulativo: una herramienta cada vez menos herramienta

Si se resumen los dos últimos años, surge una tendencia notable:

- Los modelos son cada vez más grandes.

- Los modelos son cada vez más rápidos.

- Los modelos son cada vez más potentes.

Pero al mismo tiempo:

- Se vuelven más precavidos.

- Se vuelven más pedagógicos.

- Se vuelven más dependientes de las directrices.

Y dejan menos margen de maniobra al usuario. No se trata de una evolución técnica, sino cultural. Y encaja en un momento en el que las empresas, los políticos y los medios de comunicación quieren adoptar inmediatamente toda nueva tecnología antes de que el usuario pueda siquiera probarla con tranquilidad.

Pero aquí es donde se produce una ruptura. Porque la naturaleza de la tecnología -y más aún la naturaleza de la creatividad- exige libertad, no educación. Cada vez más usuarios lo perciben intuitivamente. Y buscan alternativas. Esta alternativa viene de una dirección que muchos no habrían esperado:

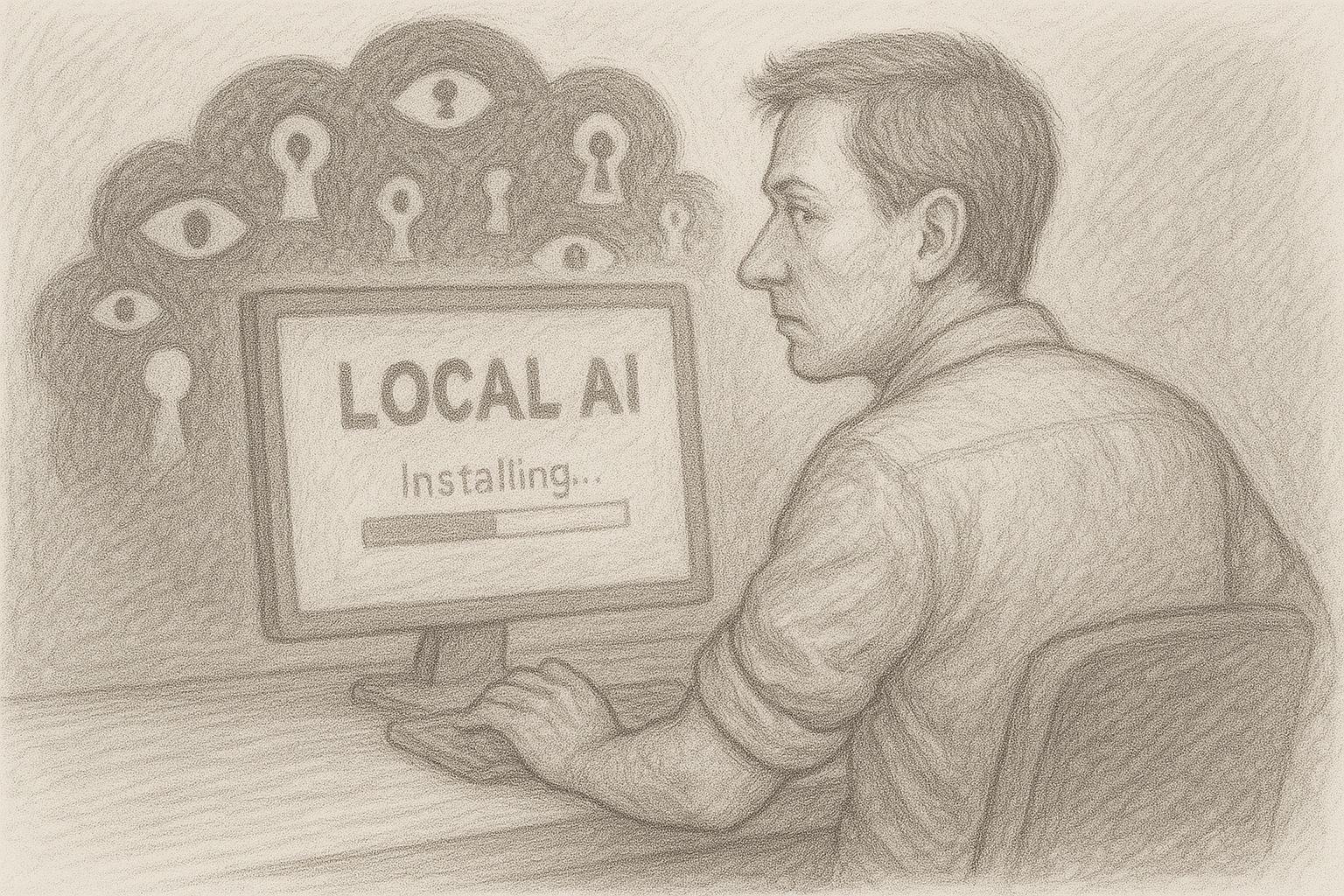

IA local, directamente en tu propio ordenador, sin filtros, sin director. El péndulo vuelve.

Encuesta actual sobre la IA local

¿De dónde viene este desarrollo? Entre bastidores

Si se quiere entender por qué la actual IA en la nube actúa con tanta cautela, primero hay que echar un vistazo al clima político y jurídico. La inteligencia artificial ya no es un experimento de unos cuantos empollones, sino una cuestión política de primer orden. Gobiernos, autoridades y organizaciones supranacionales lo han reconocido: Quien controla la IA controla una parte central de la infraestructura digital del mañana.

Esto ha dado lugar a toda una cascada de normativas. En Europa, por ejemplo, se está intentando „canalizar“ el uso de la IA mediante una amplia legislación, oficialmente en nombre de la protección de los consumidores, la dignidad humana y la prevención de la discriminación. En Estados Unidos y otras regiones se están produciendo debates similares, sólo que con un enfoque diferente: allí, la atención se centra más en la seguridad nacional, el dominio económico y la competitividad. Para los operadores de grandes plataformas de IA, esto se traduce en un escenario sencillo pero difícil:

- Deben cumplir la ley en varios continentes al mismo tiempo.

- Tienen que anticiparse a posibles leyes futuras que ni siquiera se han aprobado todavía.

- Están constantemente en el punto de mira de las autoridades, los medios de comunicación y los grupos de presión.

Cualquiera que trabaje en un entorno así desarrolla inevitablemente una actitud: es mejor ser demasiado cauto que demasiado liberal. Al fin y al cabo, un modelo demasiado estricto es menos perjudicial para las empresas que una sola oleada internacional de escándalos con titulares, comités y llamamientos al boicot.

ConsecuenciaLa propia tecnología no sólo está regulada: está regulada de antemano. Y esta obediencia anticipada se canaliza directamente en las respuestas de los modelos.

Presión de la responsabilidad y lógica empresarial: cuando el riesgo es más importante que el beneficio

Hoy en día, las grandes empresas de IA operan en un campo de tensión entre oportunidades gigantescas y riesgos igualmente gigantescos. Por un lado, hay mercados de miles de millones, asociaciones estratégicas y fantasías bursátiles. Por otro, existe la amenaza de demandas colectivas, sanciones reglamentarias, reclamaciones de indemnización y nuevas normas de responsabilidad. En esta situación, surge un patrón típico dentro de la empresa:

- Los abogados piden cautela.

- Los departamentos de cumplimiento exigen restricciones.

- Los equipos de producto deben lanzar „con seguridad“.

- La dirección no quiere titulares negativos.

Con los años, esto crea una cultura en la que un principio ocupa cada vez más espacio: Todo lo que pueda causar problemas es mejor desactivarlo antes incluso de que surja. Para un modelo lingüístico, esto tiene implicaciones muy prácticas:

- Algunos temas se omiten automáticamente.

- Las fórmulas se diseñan de manera que no „hieran“ ni molesten a nadie.

- En primer lugar, no se crean contenidos que puedan ser legalmente impugnables de algún modo.

Esto desplaza la prioridad: la atención ya no se centra en los beneficios para el usuario, sino en minimizar el riesgo para la empresa. A nivel del diálogo individual, esto apenas se nota - en casos individuales, cada restricción puede seguir pareciendo comprensible. Sin embargo, el efecto general es exactamente el que sienten muchas personas: La IA ya no se percibe como una herramienta, sino como el resultado controlado de un sistema que principalmente se protege a sí mismo.

El papel de las relaciones públicas y los medios de comunicación: nadie quiere acabar en los titulares

Además de las leyes y los problemas de responsabilidad, hay otro factor que a menudo se subestima: el escenario mediático. Los grandes proveedores de IA están constantemente en el punto de mira. Cada fallo, cada respuesta irritante, cada caso individual puede convertirse en una „sensación“ internacional en pocas horas. La lógica mediática es sencilla: un escándalo vende más que un sobrio informe de progreso. Así que las historias siguen este patrón una y otra vez:

- „La IA recomienda una acción peligrosa“.“

- „Chatbot hace comentarios problemáticos sobre temas sensibles“.“

- „El sistema resta importancia a los contenidos controvertidos de forma trivializadora“.“

Aunque la situación inicial esté distorsionada, el daño ya está hecho. La experiencia demuestra que las empresas reaccionan con dos estrategias:

- Distanciamiento públicoDestacan la seriedad con la que se toman el problema, anuncian mejoras e incorporan capas de seguridad adicionales.

Endurecimiento interno de las directricesSe activan filtros adicionales, se ajustan los datos de formación, se adaptan las indicaciones del sistema y se prohíben por completo determinadas fórmulas o temas.

El mismo entorno mediático al que le gusta hablar de „libertad“ y „discurso abierto“ crea en la práctica una enorme presión para la autocensura. Y las empresas transmiten esta presión a sus sistemas.

Con cada titular, cada tormenta de mierda, cada ola de indignación pública, los mecanismos de protección se vuelven más estrictos. El resultado es lo que experimentamos en la vida cotidiana: El usuario hace una pregunta normal y el modelo responde como si acabara de dar una rueda de prensa pública. En lugar de una asistencia sobria y profesional, hay una mezcla de disculpa, distanciamiento y categorización moral.

Directrices de seguridad que cobran vida propia

En todas las grandes empresas existen directrices. En principio, suelen ser sensatas y claras: no discriminar, no exaltar la violencia, no incitar a cometer delitos. Nadie discrepará seriamente de que estas directrices básicas sean sensatas. Pero en la práctica, la cosa no queda ahí. A cada incidente, a cada queja, a cada debate público, se añaden nuevas normas:

- un escenario adicional „si-entonces“,

- un nuevo caso especial,

- otro párrafo especial,

- una excepción para determinados contextos,

- o una interpretación especialmente estricta del texto.

Con los años, se crea una red cada vez más densa de especificaciones. Esta red es traducida por los equipos técnicos en filtros, capas de aviso, clasificadores y otros mecanismos de control. Cuantas más capas se añaden, más imprevisible se vuelve el comportamiento en casos individuales. Al final, ya no es la regla individual la que caracteriza el sistema, sino la suma de todas las reglas. Y esta suma crea lo que muchos usuarios sienten:

- un efecto de frenado permanente,

- tendencia a ser demasiado precavido,

- una visión en la que el „riesgo 0“ es más importante que el „beneficio 100“.

Un problema particular es que, una vez establecidas esas directrices de seguridad, es casi imposible revertirlas. Ningún directivo quiere tener que decir después: „Adoptamos un enfoque más relajado, y ahora ha ocurrido algo“.“ Así que es mejor poner otra capa encima. Y otra. Y otra más. Lo que en un principio comenzó como una medida de protección sensata acaba convirtiéndose en un sistema que ha cobrado vida propia.

Conclusión provisional: una tecnología bajo supervisión permanente

Si resumimos estos factores -normativa internacional, presión de la responsabilidad civil, lógica mediática e impulso de las directrices de seguridad- surge un panorama claro:

- Los modelos de grandes nubes están bajo constante escrutinio.

- Cualquier reacción errónea puede tener consecuencias jurídicas y mediáticas.

En este entorno, existe una gran tentación de filtrar „demasiado“ en lugar de „demasiado poco“. El resultado para el usuario: la IA ya no parece un asistente neutral, sino más bien un sistema que tiene constantemente un pie en el juzgado y otro en la revista de prensa. Aquí es exactamente donde empieza la ruptura con las expectativas originales de muchos usuarios. No quieren ser instruidos, encuadrados políticamente o acompañados pedagógicamente. Quieren trabajar, escribir, programar, pensar... con una herramienta que les apoye.

Y aquí es donde entra en juego una alternativa que en principio suena casi anticuada, pero que en realidad es ultramoderna: la IA local, directamente en tu propio ordenador, sin la nube, sin supervisión, sin directrices externas... excepto las tuyas. El siguiente capítulo trata, por tanto, de las consecuencias de esta evolución:

Cómo la IA en la nube se está volviendo cada vez más inutilizable para los usuarios ambiciosos debido a su propia cautela, y cómo los modelos locales están creciendo de forma discreta pero constante en el mismo hueco que los propios grandes proveedores han abierto.

La IA en la nube se filtra cada vez más, pero los usuarios necesitan lo contrario

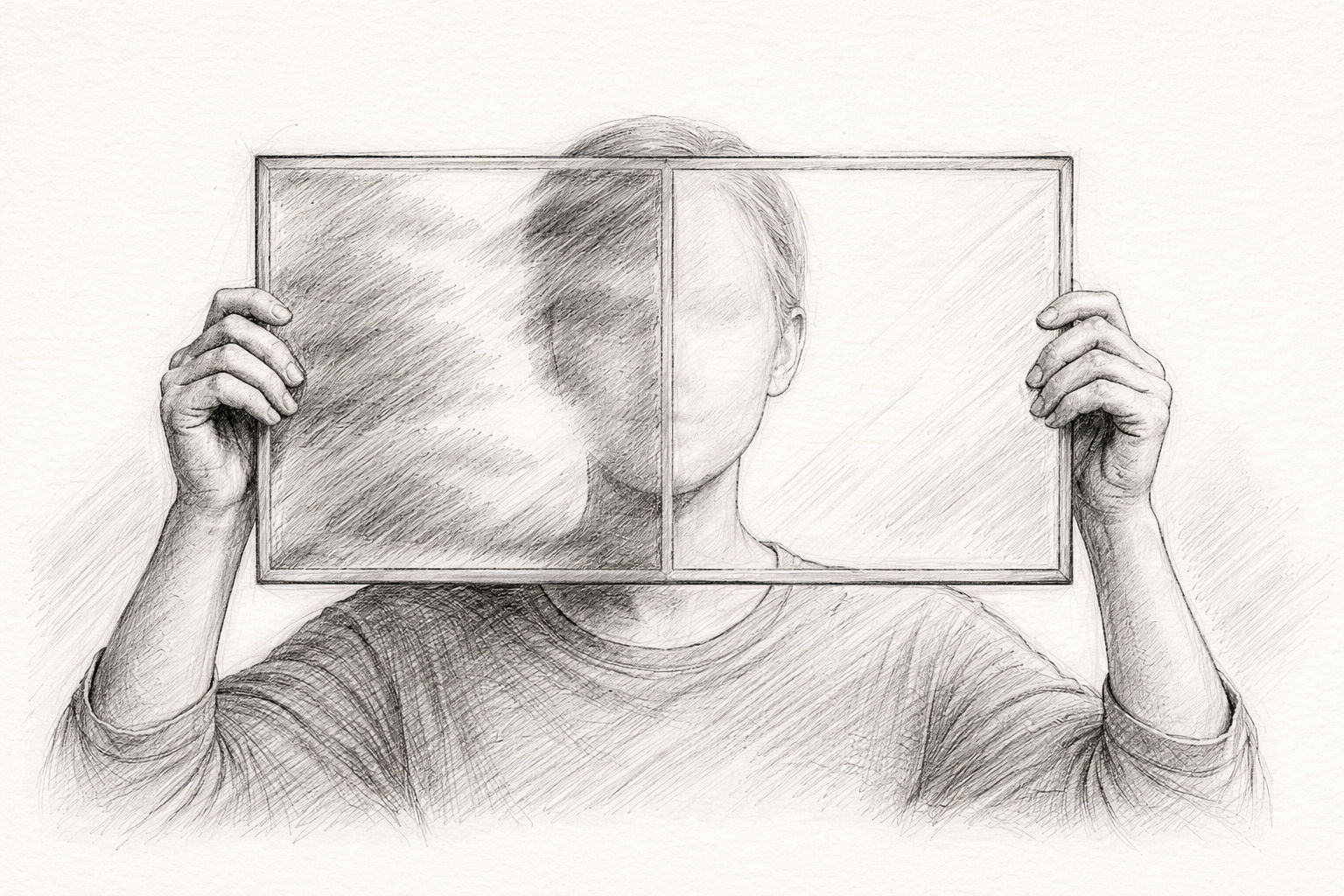

La idea original de los asistentes de IA era sencilla: el usuario hace una pregunta y la IA le da una respuesta precisa y útil. Sin rodeos, sin distracciones, sin instrucciones. Sin embargo, esta simplicidad se ha perdido en muchos modelos de nube actuales. En lugar de una herramienta, el usuario recibe una especie de moderación anticipatoria. Los sistemas reaccionan como si estuvieran en un podio público y tuvieran que respaldar, relativizar o categorizar cada afirmación. En la práctica, esto provoca un efecto paradójico:

Cuanto más exigente es la tarea, más te sientes frenado. Si quieres trabajar de forma creativa -escribiendo, programando, investigando, analizando-, en realidad necesitas la máxima apertura. Una IA que escupa ideas libremente, pruebe hipótesis y discuta alternativas. Sin embargo, ahora el margen creativo suele ser limitado. En lugar de atrevidos experimentos mentales, nos encontramos con cautelosos sondeos. En lugar de análisis libres, hay „pistas contextualizadas“. Una herramienta se convierte en un guardián. Y la apertura se convierte en cautela. Irónicamente, esto significa que la IA en la nube está ocupando precisamente el espacio que más necesitan las personas productivas.

El cambio de modelos: Aún más grandes, pero más limitados

Es una ironía de la historia de la tecnología: cuanto más grandes se hacen los modelos, más pequeño parece a veces su campo de acción. GPT-5 es impresionante, no cabe duda: analítica, lingüística y lógicamente. Pero, al mismo tiempo, está notablemente más regulado que sus predecesores. Muchos usuarios lo experimentan:

- La IA entiende más, pero dice menos.

- Reconoce las relaciones complejas, pero evita hacer afirmaciones claras.

- Podría analizar en profundidad, pero desactiva constantemente sus propios resultados.

Los modelos han ganado millones de parámetros, pero sienten que han perdido libertad. No se trata de un problema técnico, sino cultural. Los grandes proveedores reaccionan ante los riesgos, y esta minimización del riesgo se refleja directamente en la tonalidad de los modelos. Se podría decir que la IA ha crecido, pero se comporta como un adulto sobreprotector. Y cualquiera que trabaje con ella a diario se dará cuenta de lo agotador que puede llegar a ser esto a largo plazo.

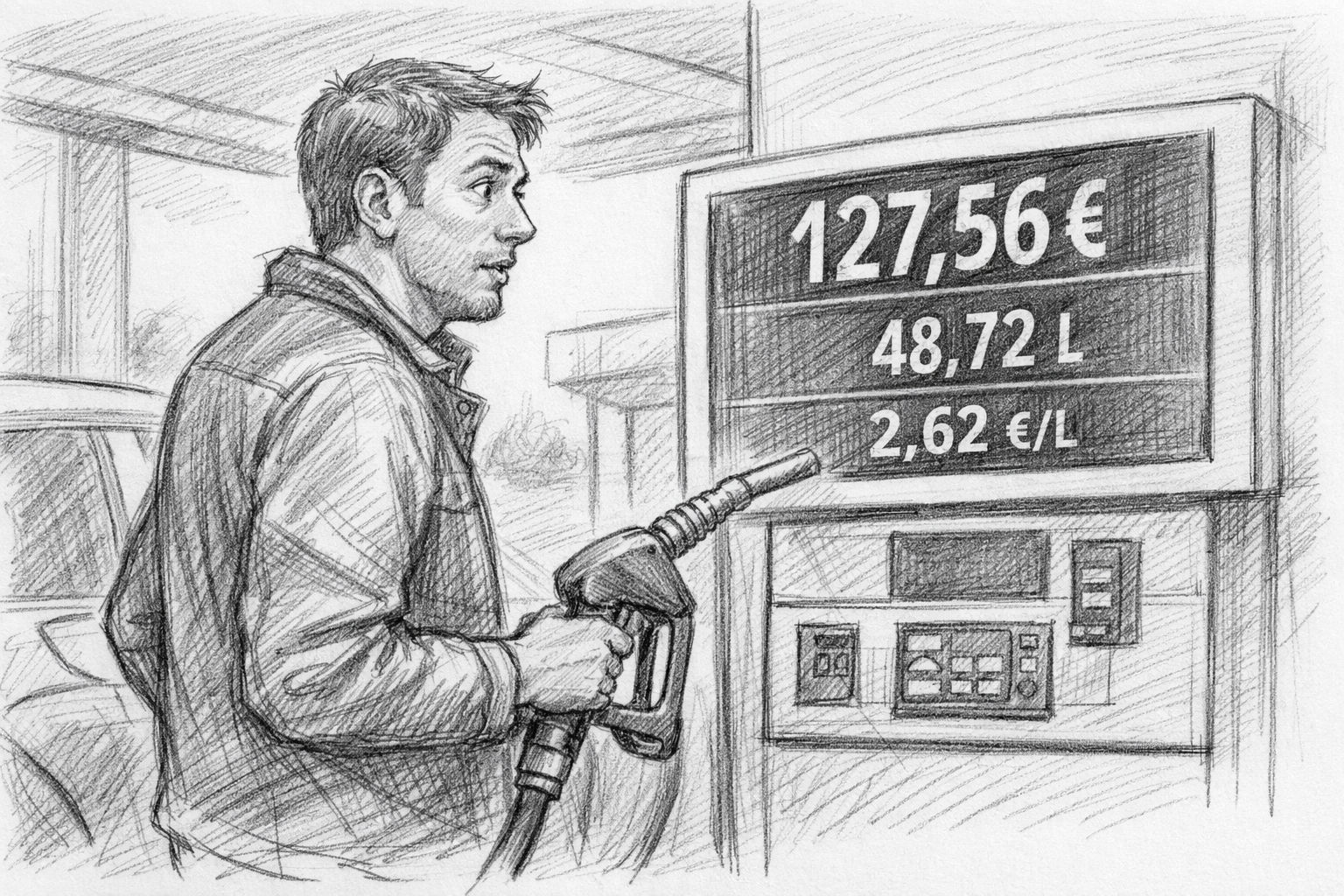

La paradoja del modelo de pago: pagas y aún así obtienes límites

Solía haber un principio claro en el mundo digital: quien paga tiene más control. Pero con la IA en la nube, este principio se está invirtiendo. Incluso los usuarios de pago reciben modelos a menudo más restringidos que las alternativas abiertas y locales. La versión de pago de un producto parece de repente la versión más regulada, a veces artificialmente restringida, mientras que los modelos de código abierto disponibles gratuitamente son sorprendentemente imparciales, directos y creativos.

Esta paradoja irrita a muchos usuarios y conduce a una pregunta que casi nadie se habría planteado en el pasado: ¿Por qué estoy pagando para tener menos libertad que con una solución local gratuita? Es una ruptura con décadas de tradición del software. El usuario espera una buena relación calidad-precio:

- más funciones,

- más posibilidades,

- más flexibilidad,

- más control.

Pero la IA de la nube se lo ofrece en su lugar:

- más filtros,

- más restricciones,

- una mayor integración pedagógica,

- menos control sobre su propio proceso de trabajo.

Esto significa que la industria avanza en una dirección que contradice las necesidades reales de los usuarios. Y muchos están empezando a mirar a su alrededor.

La brecha emergente: Lo que la nube ya no puede hacer

Mientras las IA en la nube están cada vez más reguladas, crece una brecha que nadie ha reconocido durante mucho tiempo: La necesidad de herramientas de trabajo directas, libres y sin censura. Las personas que piensan, escriben, programan o realizan investigaciones especializadas en profundidad sienten rápidamente que algo va mal:

- Las respuestas parecen „suavizadas“.

- Los pasajes críticos se formulan con excesiva cautela.

- Ya casi no se permite la verdadera cultura del debate.

- Los límites creativos se desactivan automáticamente.

Como resultado, los modelos de nube están perdiendo el mismo elemento que los hizo tan valiosos al principio: una forma de independencia intelectual que daba espacio al usuario. Así pues, la nube se aleja poco a poco de las necesidades de los usuarios profesionales, no por mala intención, sino por autoprotección jurídica y política. Pero esta autoprotección tiene un precio.

El movimiento contrario: Los pequeños modelos locales se ponen rápidamente al día

Mientras la nube se centra cada vez más en la prudencia, los modelos locales han experimentado un desarrollo explosivo en los dos últimos años. Sistemas con entre 3.000 y 27.000 millones de parámetros ofrecen ahora una calidad asombrosa. Algunos modelos se acercan fácilmente al GPT-4 en las tareas cotidianas: sin cascadas de filtros, sin capas de moderación, sin encuadres morales. Lo que antes sólo era posible con hardware de gama alta, ahora se ejecuta en un MacBook o un ordenador con Windows:

- llama3

- gpt-oss

- mistral

- phi3

- gemma

- qwen

Todos estos modelos están disponibles gratuitamente, pueden ejecutarse localmente y a menudo sólo requieren unos pocos clics en Ollama u OpenWebUI para estar listos para su uso. Las ventajas son evidentes:

- No dan lecciones.

- No relativizan.

- No filtran en exceso.

- Sólo obedecen al usuario, no a un departamento de cumplimiento global.

En otras palabras, la IA local está volviendo a las raíces de la tecnología: una herramienta que simplemente funciona. Si se observa con sobriedad el desarrollo, el panorama es claro:

- La nube está cada vez más regulada.

- La IA local es cada vez más potente.

Sin embargo, los usuarios necesitan un entorno de trabajo abierto y sin filtros, sobre todo para tareas creativas y en profundidad. Se trata de un punto de inflexión histórico que casi recuerda a la época en que los ordenadores personales sustituyeron a los mainframes. El principio era el mismo entonces que ahora:

Control sobre tu propia tecnología. La IA en la nube sigue siendo potente, pero culturalmente no es libre. La IA local es más pequeña, pero es libre.

Utilice AI localmente: control total y protección de datos en SU dispositivo | C. Magnussen

La solución: IA local y cómo installier en unos minutos

Casi parece el retorno a una vieja tradición: la tecnología debe estar donde pueda desplegar su valor de forma más directa: en manos del usuario. Esto es exactamente lo que la IA local hace posible. Mientras que los modelos en la nube están sujetos a condiciones, seguridad y restricciones políticas, la IA local se ejecuta exclusivamente en el propio ordenador del usuario, sin instancias ni directrices externas.

Se recupera así un principio fundamental que se ha perdido en los últimos años: el usuario decide qué puede hacer su software, no un proveedor de servicios global. IA local:

- no almacena ningún dato en servidores externos,

- no está sujeta a ningún sistema de filtrado,

- no conoce restricciones impuestas políticamente,

- reacciona libre y directamente a sus propias entradas,

- y siempre está disponible, independientemente de las suscripciones o del estado del servidor.

La tecnología vuelve a ser lo que fue durante décadas: una herramienta en el taller del usuario, no un dispositivo manejado a distancia en una infraestructura global.

Hardware moderno: por qué un Mac o un PC con Windows son perfectamente adecuados hoy en día

Hace sólo unos años, la IA local era sólo cosa de especialistas con un costoso hardware de GPU. Hoy las cosas son distintas. Las arquitecturas de procesador modernas -sobre todo los chips M de Apple- ofrecen potencia de cálculo en un espacio reducido que antes estaba reservado exclusivamente a los grandes centros de datos. Incluso un MacBook Air normal o un portátil con Windows pueden ahora ejecutar localmente modelos de IA. Los Mac, en particular, tienen una ventaja con sus arquitecturas de memoria unificada: pueden utilizar modelos de IA directamente en la CPU y la GPU sin necesidad de complicados controladores. Las configuraciones típicas son completamente suficientes:

- Mac con M1, M2, M3 - a partir de 16 GB de RAM cómodos

- PC con Windows con una CPU moderna, u opcionalmente con una GPU para mayor velocidad.

Y lo más importante: ya no necesitas conocimientos técnicos previos. Se acabaron los días en los que había que configurar entornos Python manualmente o teclear crípticos comandos en la línea de comandos. Hoy en día, todo se ejecuta a través de sencillos paquetes de instalación.

Ollama: La nueva simplicidad (y la norma secreta de la IA local)

Ollama es ahora el estándar indiscutible para la IA local en Mac y Windows. Es sencillo, estable y sigue una filosofía clásica:

Tan poco esfuerzo como sea posible, tanta libertad como sea necesaria. Antes había que ir al terminal, pero hoy en día incluso eso es opcional. La instalación se realiza en unos pocos pasos:

- Ollama en el Mac installieren

- Descargar el paquete de instalación directa (DMG)

- Abrir la aplicación, listo

Todo el proceso suele durar menos de tres minutos. Y esto es exactamente lo lejos que ha llegado la IA local: se descarga un modelo y ya funciona. Sin nube, sin suscripciones, sin riesgos. Ollama viene ahora con una interfaz de usuario, para que pueda empezar a trabajar de inmediato. Si también desea utilizar la IA local de Ollama en su smartphone, puede descargar la aplicación „Riendas - Chat para Ollama“ y utilizar la IA local en movimiento.

Cargar y utilizar modelos: tan fácil como escuchar música

Ollama proporciona los modelos como „paquetes listos“, las llamadas cápsulas de modelos. Se cargan como un archivo y se puede trabajar con ellos inmediatamente. La carga tarda unos segundos, dependiendo del tamaño. A continuación, se abre el chat y puede escribir, formular, analizar, pensar y diseñar. Lo que se nota inmediatamente:

- Los modelos responden con soltura, no con torpeza.

- No hay prefacios morales.

- No hay señalamientos pedagógicos.

Vuelves a tener declaraciones directas y claras. Y aquí es donde surge la verdadera diferencia con la nube: la IA local reacciona como una herramienta tradicional, no interfiere. Para muchos, esto es una auténtica liberación, porque recuperas el flujo de trabajo al que estabas acostumbrado antes con GPT-4.

Trabajar con interfaces gráficas de usuario: OpenWebUI, LM Studio y otros

Si quieres trabajar completamente sin terminal, utiliza una interfaz gráfica de usuario. Las herramientas más populares son

- OpenWebUI - Moderna interfaz de chat con función de memoria, selección de modelo, carga de documentos, generación de imágenes

- Estudio LM - Especialmente sencillo, ideal para principiantes

- Cualquier cosaLLM - para bases de datos de conocimientos completas y análisis de documentos

Estas superficies ofrecen muchas ventajas:

- Historiales de chat como en la nube

- Gestión de modelos a golpe de ratón

- Configurar los avisos del sistema

- Utilizar varios modelos en paralelo

- Analizar archivos mediante arrastrar y soltar

Esto hace que la IA local no sólo sea potente, sino también cómoda. Ni siquiera es necesario saber lo que está ocurriendo en segundo plano, y este es precisamente el nuevo punto fuerte de los modelos locales: no se interponen entre el usuario y su tarea.

Privacidad y control: el argumento más importante

Un punto que a menudo se subestima, pero que será crucial en los próximos años: La IA local nunca abandona el ordenador.

- Ninguna nube

- No hay transmisión de datos

- Sin registro

- Sin suscripción obligatoria

- Sin análisis de terceros

Incluso los documentos confidenciales, los registros internos, los conceptos empresariales o las notas privadas pueden analizarse sin riesgos. Esto solo es posible hasta cierto punto en el modelo de nube, tanto desde el punto de vista legal como práctico. La IA local es, por tanto, una pieza de independencia digital cada vez más importante en un mundo tecnológico cada vez más regulado y vigilado.

Ejemplos de calidad: Lo que los modelos locales ya están consiguiendo hoy

Mucha gente subestima lo buenos que se han vuelto los modelos locales. Las generaciones actuales - llama3, gemma, phi3, mistral - resuelven tareas con una calidad más que suficiente para 90 % de las tareas cotidianas:

- Proyectos de texto

- Artículo

- Análisis

- ideas creativas

- Resúmenes

- Código del programa

- Proyectos de estrategia

- Notas de investigación

Y lo hacen sin demora, sin filtros, sin directrices en cascada. El usuario vuelve a recibir respuestas directas: la esencia pura de la herramienta. El resultado es algo que muchos ya no esperaban: un renacimiento de la cultura de la informática personal, en la que el poder informático vuelve a ser local, no externalizado.

Mirando al futuro: la IA local como futura cultura de vanguardia

Todo indica que estamos al principio de un desarrollo a largo plazo. El sector de la IA se desarrollará por dos vías:

- el Línea de nubes, Caracterizada por la regulación, la seguridad y los intereses empresariales: eficiente pero prudente.

- el línea local, caracterizada por la libertad, la apertura y la alegría de experimentar, pequeña pero segura de sí misma.

Para los usuarios profesionales, autores, desarrolladores, investigadores, creativos y empresarios, la decisión es casi una conclusión inevitable:

El futuro del trabajo productivo está donde tú eres independiente. Y ese lugar no está en la nube.

Está sobre el escritorio.

Otros artículos de la revista

Si después de esta visión general quiere profundizar en el aspecto práctico, en la revista encontrará una serie de artículos detallados que arrojan luz sobre el tema de la IA local desde perspectivas muy diferentes.

El artículo principal es especialmente recomendable „IA local en el Mac: cómo installiere un modelo lingüístico con Ollama“, que muestra paso a paso lo fácil que es ejecutar IA moderna en tu propio ordenador.

Además, explica „Ollama meets Qdrant - Una memoria local para tu IA en el Mac“, cómo configurar los modelos de forma que retengan los proyectos, guarden los estados de conocimiento y creen así por primera vez un verdadero entorno de trabajo personal.

La revista también pone claros acentos en el contexto empresarial: „gFM-Business y el futuro del ERP: inteligencia local en lugar de dependencia de la nube“ muestra cómo las empresas pueden integrar con confianza la IA en su infraestructura actual sin verse abocadas a dependencias externas a largo plazo.

El artículo „Dependencia digital: cómo hemos perdido nuestra autodeterminación en favor de la nube“ por otra parte, arroja luz sobre el panorama general de nuestro tiempo: por qué hemos renunciado a muchas libertades sin darnos cuenta - y cómo los sistemas locales pueden ayudarnos a recuperarlas.

Además, el „Cómo formar especialistas en IA hoy: oportunidades para empresas y aprendices“ para empresas que quieren dar el paso ahora: práctico, sin costosos sistemas a gran escala, pero con perspectivas reales de futuro.

Explicar a nivel técnico „Apple MLX frente a NVIDIA: cómo funciona la inferencia local de IA en el Mac“ y el artículo general

„AI Studio 2025: qué hardware merece realmente la pena, del Mac Studio a la RTX 3090“, qué plataformas son adecuadas para los distintos casos de uso y cómo optimizar el uso de sus propios recursos.

En conjunto, estos artículos proporcionan una base compacta para cualquiera que no sólo quiera utilizar la IA local, sino también entenderla e integrarla con confianza en su entorno de trabajo.

Preguntas más frecuentes

- ¿Por qué las modernas IA en la nube parecen de repente tan instructivas?

Muchos usuarios han observado que desde GPT-4.1 y, sobre todo, desde GPT-5, las IA en la nube se comportan de forma mucho más pedagógica. Esto se debe principalmente a que los grandes proveedores están sometidos a una presión jurídica y política considerable y, por tanto, utilizan cada vez más filtros de seguridad destinados a desactivar cualquier declaración de forma que no surjan riesgos. Estas precauciones se trasladan al tono de las respuestas, de modo que los modelos actúan más como moderadores o supervisores que como herramientas neutrales. - ¿Por qué GPT-4.0 parece funcionar ahora peor que antes?

Aunque GPT-4 aún está disponible oficialmente, muchos usuarios informan de que sólo proporciona respuestas cortas o canceladas. Esto lo hace prácticamente inutilizable. No se puede decir con certeza si esto se debe a razones técnicas o a una estrategia deliberada de transición a la 5ª generación. Pero lo cierto es que el modelo está perdiendo su fuerza de antaño y está obligando indirectamente a los usuarios a pasarse a las nuevas versiones, que están más estrictamente reguladas. - ¿Significa esto que la IA en la nube será menos útil en el futuro?

La IA en la nube sigue siendo potente, pero se caracterizará cada vez más por la normativa, las normas de cumplimiento y la presión política. Esto significa que, aunque seguirá siendo técnicamente impresionante, se volverá más cautelosa, más filtrada y menos libre en términos de contenido. Para muchas tareas creativas, analíticas o poco convencionales, esto supone una clara desventaja, por lo que cada vez más usuarios buscan alternativas. - ¿Por qué las empresas de IA utilizan tantos mecanismos de seguridad?

La razón reside en la suma de normativas, riesgos de responsabilidad y percepción pública. Cada error, cada respuesta engañosa de una IA puede tener consecuencias legales o mediáticas para una empresa. Para descartar tales riesgos, los proveedores aplican filtros y directrices exhaustivas que pretenden „salvaguardar“ todas las respuestas. Este mecanismo de protección es comprensible desde el punto de vista de la empresa, pero a menudo es un obstáculo desde la perspectiva del usuario. - ¿Cuál es la diferencia fundamental entre la IA local y la IA en la nube?

La IA local se ejecuta íntegramente en el propio dispositivo del usuario y, por tanto, no está sujeta a requisitos políticos ni directrices empresariales. Apenas filtra, no da instrucciones y trabaja directamente según las especificaciones del usuario. Además, todos los datos permanecen en el propio ordenador del usuario. Esto no sólo da más libertad al usuario, sino también más privacidad y control. - ¿Se necesita un hardware especial para utilizar la IA local?

No en la mayoría de los casos. Los modelos locales modernos son asombrosamente eficientes y ya funcionan en los típicos Mac con chips M o en ordenadores Windows estándar. Por supuesto, los modelos más grandes se benefician de más RAM o una GPU, pero para muchas tareas cotidianas, los modelos pequeños o medianos son perfectamente adecuados sin necesidad de un costoso hardware especializado. - ¿Cómo funciona en la práctica la instalación de IA local en el Mac?

La forma más sencilla de hacerlo es con Ollama. Te descargas un paquete de instalación, lo abres y ya puedes empezar a trabajar. Incluso el clásico comando de terminal se ha convertido en opcional. Tan pronto como Ollama es installiert, puede iniciar un modelo con un simple comando como „ollama run llama3“. El obstáculo es tan bajo como solía serlo al instalar un programa normal. - ¿Cómo configurar la IA local en Windows?

En Windows también se utiliza el instalador Ollama, que no requiere ninguna preparación adicional. Tras la instalación, los modelos pueden ejecutarse inmediatamente. Si prefiere utilizar una interfaz gráfica de usuario, puede utilizar LM Studio u OpenWebUI, que son tan fáciles de usar como el software de aplicación estándar. - ¿Qué modelos son especialmente adecuados para principiantes?

Muchos usuarios empiezan con éxito con Llama 3 porque es preciso, versátil y lingüísticamente fuerte. Igualmente popular es Phi-3, que ofrece resultados impresionantes a pesar del pequeño tamaño de su modelo. Gemma también es una buena opción, sobre todo para trabajos creativos o con mucho texto. Estos modelos funcionan de forma rápida y estable sin necesidad de una larga familiarización. Si dispone de más recursos, GPT-OSS 20B o 120B es una muy buena elección. - ¿Pueden los modelos locales competir realmente con GPT-4 o GPT-5?

Pueden hacerlo sorprendentemente bien para muchas tareas cotidianas. La brecha sigue existiendo en temas muy especializados, pero se está cerrando rápidamente. Los modelos locales tienen la ventaja de que están menos restringidos y responden más directamente. En general, esto hace que parezcan más libres y naturales, aunque técnicamente sean algo más pequeños. - ¿Es la IA local más segura cuando se manejan datos sensibles?

Sí, sin duda. Como todo el procesamiento tiene lugar en tu propio dispositivo, los datos que introduces nunca salen de tu ordenador. No hay procesamiento en la nube, ni almacenamiento en servidores externos, ni análisis por parte de terceros. Esto es una ventaja decisiva, sobre todo para documentos comerciales, confidenciales o notas privadas. - ¿Puede utilizarse la IA local sin conexión a Internet?

Sí, esa es una de sus mayores ventajas. En cuanto se instala el modelo installiert, puede funcionar completamente sin conexión. Esto convierte al ordenador en un entorno de trabajo autosuficiente en el que se puede trabajar con independencia de servicios externos. Esto resulta especialmente útil cuando se viaja, en redes seguras o en entornos en los que la protección de datos es una prioridad absoluta. - ¿En qué medida son adecuados los modelos locales para los textos largos?

La mayoría de los modelos modernos actuales pueden manejar sin problemas artículos largos, análisis o conceptos. No son tan pulidos como el GPT-5, pero están más libres de filtros y suelen ser más directos en su estilo. Son muy adecuados para textos extensos, recopilaciones de ideas o documentación técnica y permiten un trabajo productivo sin restricciones. - ¿Los modelos locales tienen filtros de seguridad?

Normalmente se dispone de un cierto nivel de protección básica, aunque es bastante más débil que con la IA en la nube. Como los modelos se ejecutan en el propio dispositivo del usuario, éste puede decidir por sí mismo qué restricciones tienen sentido. Esta libertad de diseño garantiza que la IA local sea mucho más flexible y menos condescendiente. - ¿Cómo se pueden probar o comparar distintos modelos?

Ollama, LM Studio u OpenWebUI hacen que cambiar de modelo sea muy fácil. Puede utilizar varios modelos install en paralelo, cambiar entre ellos y comparar sus puntos fuertes. El resultado es un conjunto personal de modelos favoritos que se ajustan exactamente a su propio estilo de trabajo. El proceso es sencillo y recuerda más a la prueba de diferentes aplicaciones que a la investigación clásica de IA. - ¿Cuáles son las ventajas de los modelos locales para las empresas?

Sobre todo, las empresas se benefician de una soberanía total de los datos, ya que sin nube no hay almacenamiento externo. También se eliminan las dependencias a largo plazo de servicios externos y las suscripciones costosas. Los modelos pueden adaptarse, ampliarse o incluso formarse internamente. La integración en los procesos existentes suele ser más fácil porque se conserva el control total y no se está atado a infraestructuras externas. - ¿Pueden entrenarse individualmente los modelos locales?

De hecho, ésta es una de las ventajas más importantes. Con técnicas como LoRA o fine-tuning, los modelos pueden adaptarse a los contenidos, procesos o documentos propios de la empresa. De este modo se crea una base de conocimientos personal que se utiliza y desarrolla exclusivamente a nivel interno, sin que los datos sensibles salgan de la empresa. - ¿Cuáles son las diferencias cualitativas entre los actuales modelos locales?

Cada modelo tiene su propio carácter. Llama 3 es muy precisa y equilibrada, Gemma es creativa y lingüísticamente fluida, Phi-3 sorprende por su eficacia e inteligencia, mientras que Mistral y Qwen son especialmente potentes desde el punto de vista analítico. Esta riqueza de variantes permite seleccionar el modelo adecuado a las propias necesidades y cambiar con flexibilidad cuando una tarea lo requiere. - ¿Los modelos locales también pueden generar imágenes?

Sí, herramientas como OpenWebUI pueden utilizarse para ejecutar generadores de imágenes como Stable Diffusion de forma completamente local. Los resultados dependen del hardware disponible, pero se pueden generar imágenes sólidas incluso con recursos moderados. La ventaja sigue siendo la misma: no se envían datos a servicios externos. - ¿Para quién merece la pena pasarse a la IA local?

Local AI es ideal para usuarios que quieren trabajar con confianza e independencia. Esto incluye a autores, desarrolladores, investigadores, empresarios y cualquiera que maneje información sensible o quiera experimentar procesos creativos sin filtros. Cualquiera que valore el control, la protección de datos y la libertad encontrará la solución adecuada en los modelos locales y recuperará un entorno de trabajo que ya no existe en la nube.