Nog maar een paar jaar geleden was kunstmatige intelligentie een onderwerp voor onderzoeksinstellingen en grote bedrijven. Mensen spraken over neurale netwerken, deep learning en spraakherkenning - maar het speelde nauwelijks een rol in het dagelijks leven. Vandaag de dag is AI niet langer een onderwerp voor de toekomst, maar een realiteit: het schrijft teksten, creëert beelden, analyseert gegevens en bestuurt productieprocessen. Of het nu gaat om administratie, handel of industrie - het is nu overal te vinden.

Taalmodel

Artikelen over taalmodellen en hun mogelijke toepassingen. Deze sectie behandelt GPT, LLaMA, Mistral en andere LLM's - van de basis tot praktische toepassingen.

gFM-Business en de toekomst van ERP: lokale intelligentie in plaats van cloudafhankelijkheid

Al meer dan tien jaar staat de gFM-Business-software voor iets bijzonders in de Duitse ERP-markt: het is niet gebaseerd op een omslachtig, moeilijk te onderhouden systeem, maar op het lichtgewicht, aanpasbare en visueel gemodelleerde FileMaker-platform. Dit heeft veel voordelen: gFM-Business kan individueel worden uitgebreid, draait op Windows, macOS en iOS en kan worden aangepast door zowel ontwikkelaars als ambitieuze power users.

Met de komst van kunstmatige intelligentie (AI) - met name door zogenaamde taalmodellen zoals ChatGPT - ontstaan er nu nieuwe mogelijkheden die veel verder gaan dan traditionele automatisering. gFM-Business bereidt zich actief voor op deze toekomst: met als doel niet alleen gegevens te beheren, maar ook kennis te ontsluiten.

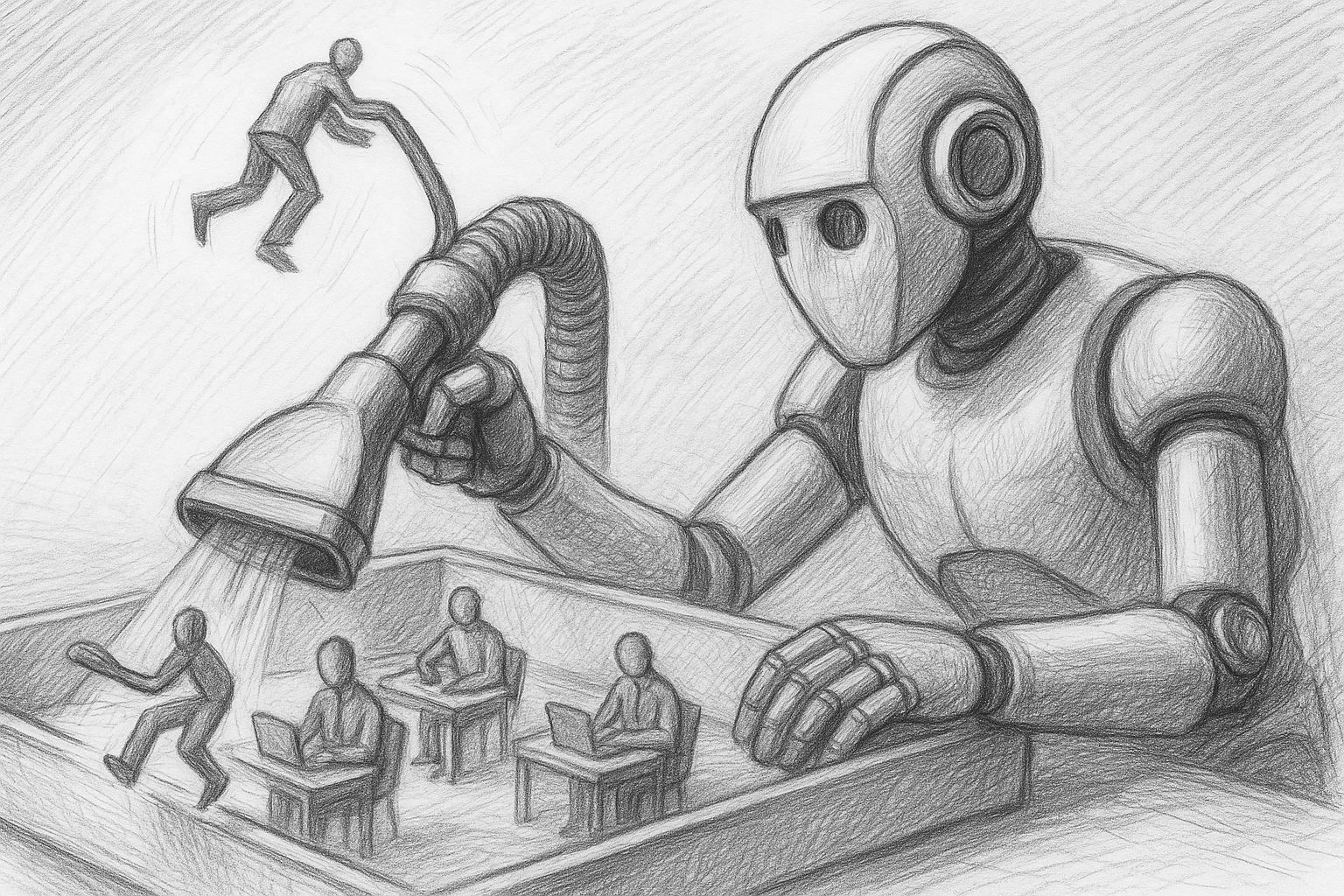

Kunstmatige intelligentie: welke banen staan op de tocht en hoe kunnen we ons nu wapenen?

Bijna geen enkele andere technologische verandering is zo snel ons dagelijks leven binnengeslopen als kunstmatige intelligentie. Wat gisteren nog werd beschouwd als een visionaire technologie van de toekomst, is nu al realiteit - of het nu gaat om sms'en, programmeren, diagnoses stellen, vertalen of zelfs het creëren van muziek, kunst of juridische stukken.

Integratie van MLX in FileMaker 2025: lokale AI als nieuwe standaard

Hoewel MLX oorspronkelijk werd gelanceerd als een experimenteel framework door Apple Research, heeft er de afgelopen maanden een stille maar belangrijke ontwikkeling plaatsgevonden: Met de release van FileMaker 2025 heeft Claris MLX stevig geïntegreerd in de server als een native AI-infrastructuur voor Apple Silicon. Dit betekent dat iedereen die met een Mac werkt en Apple Silicon gebruikt, MLX-modellen niet alleen lokaal kan uitvoeren, maar ze ook direct in FileMaker kan gebruiken - met native functies, zonder tussenlagen.

MLX op Apple Silicon als lokale AI in vergelijking met Ollama & Co.

In een tijd waarin gecentraliseerde AI-diensten zoals ChatGPT, Claude of Gemini de krantenkoppen domineren, hebben veel professionele gebruikers een groeiende behoefte aan een alternatief - een lokale, zelfcontroleerbare AI-infrastructuur. Vooral voor creatieve processen, gevoelige gegevens of terugkerende workflows is een lokale oplossing vaak de duurzamere en veiligere optie.

Iedereen die met een Mac werkt - vooral met Apple Silicon (M1, M2, M3 of M4) - kan nu verbazingwekkend krachtige tools vinden om hun eigen taalmodellen rechtstreeks op het apparaat uit te voeren. Centraal hierin staat een nieuwe, grotendeels onbekende component: MLX, een machine learning framework ontwikkeld door Apple dat de komende jaren waarschijnlijk een steeds centralere rol zal spelen in het AI-ecosysteem van het bedrijf.

Ollama ontmoet Qdrant: Een lokaal geheugen voor je AI op de Mac

Lokale AI met geheugen - zonder cloud, zonder abonnement, zonder omleidingen

In een vorige artikelen Ik heb uitgelegd hoe je Ollama configureert op de Mac install. Als je deze stap al hebt voltooid, heb je nu een krachtig lokaal taalmodel - zoals Mistral, LLaMA3 of een ander compatibel model dat via REST API kan worden aangesproken.

Het model "weet" echter alleen wat er in de huidige prompt staat. Het herinnert zich geen eerdere gesprekken. Wat ontbreekt is een herinnering.

Lokale AI op de Mac: Hoe installiere een taalmodel met Ollama

Lokale AI op de Mac is al lang praktisch - vooral op Apple-Silicon computers (M-serie). Met Ollama krijg je een slanke runtime-omgeving voor veel open source taalmodellen (bijv. Llama 3.1/3.2, Mistral, Gemma, Qwen). De huidige Ollama versie komt nu ook met een gebruiksvriendelijke app waarmee je met een muisklik een lokaal taalmodel op je Mac kunt instellen. In dit artikel vind je een pragmatische gids van installatie tot de eerste prompt - met praktische tips over waar het traditioneel vaak misgaat.