Ruim tien jaar geleden zag ik toevallig een lezing over de overgang van de informatiemaatschappij naar de kennismaatschappij. Veel klonk toen nog theoretisch, bijna academisch. Het ging over concepten als gegevenssoevereiniteit, eigendom van informatie en de vraag wie in de toekomst zal bepalen wat toegankelijk is - en wat niet. Vandaag, met een beetje afstand, lijkt deze lezing verrassend precies. Veel van wat toen als een ontwikkeling werd beschreven, is nu immers werkelijkheid geworden. Steeds meer gegevens zijn naar de cloud gemigreerd. Steeds meer informatie wordt niet langer opgeslagen op interne systemen, maar op externe infrastructuren. En steeds vaker bepaalt niet langer de gebruiker, maar een provider, een platform of een set regels wat er mogelijk is.

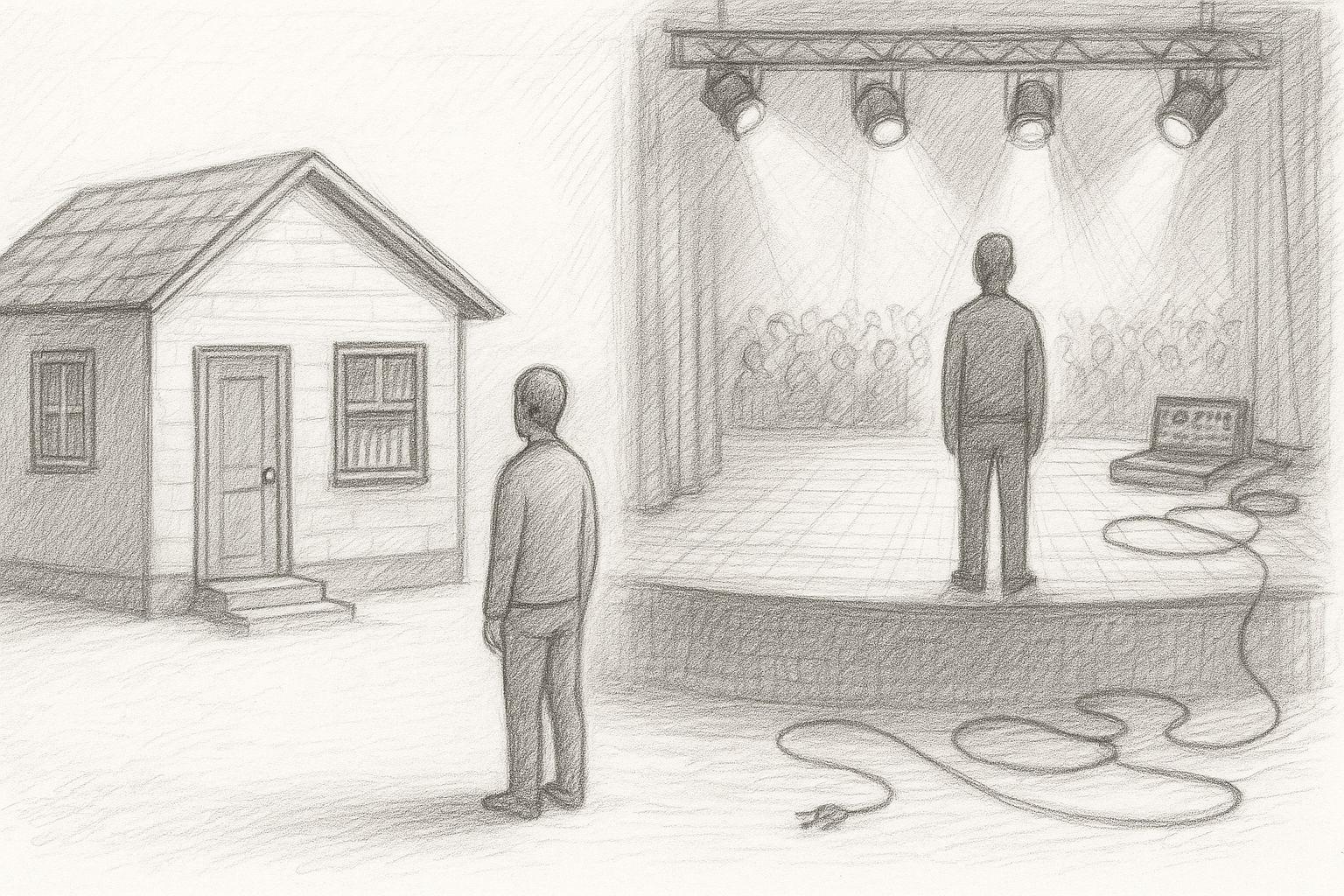

Om deze ontwikkeling te begrijpen, is het de moeite waard om een stap terug te doen. De informatiemaatschappij waarin velen van ons zijn opgegroeid was geen normale toestand. Het was een historische uitzondering.