Wie zich tegenwoordig bezighoudt met kunstmatige intelligentie, krijgt bijna onvermijdelijk te maken met een vreemd gevoel: constante rusteloosheid. Je bent nog maar net gewend aan de ene tool of de volgende tien duiken alweer op. Op YouTube volgt de ene video op de andere: „Deze AI-tool verandert alles“, „Je moet dit nu absoluut gebruiken“, „Zij die missen blijven achter“. En elke keer weerklinkt dezelfde boodschap: Je bent te laat. De anderen zijn verder. Je moet ze inhalen.

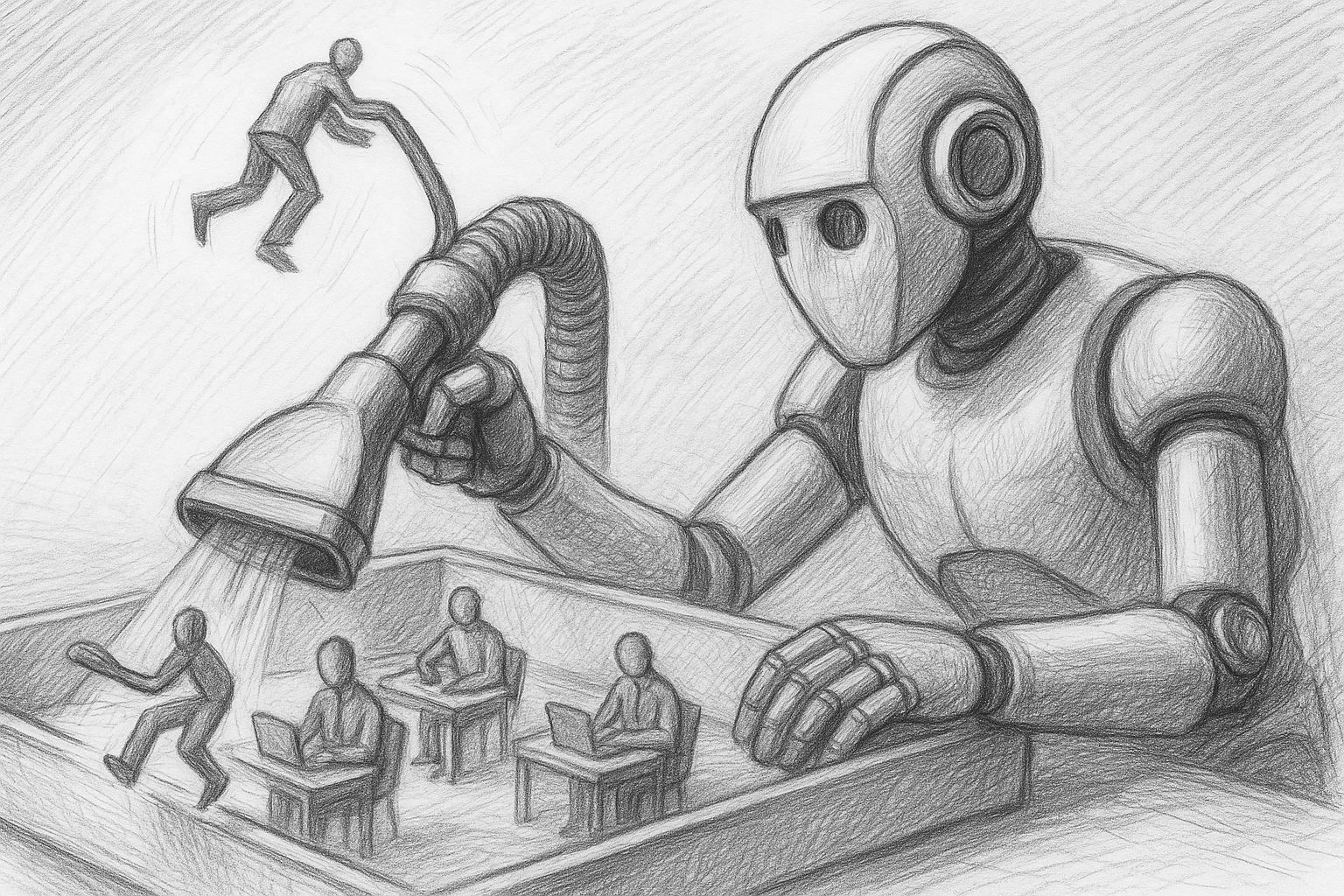

Dit treft niet alleen IT'ers. Ook zelfstandigen, creatieve professionals, ondernemers en gewone werknemers voelen de druk. Velen weten niet eens precies wat deze tools eigenlijk doen - maar ze hebben het gevoel dat ze iets zouden kunnen missen. En dat is precies wat stress veroorzaakt.